- 1Cesium.js基础使用(vue)

- 2网络工程实训_5交换机配置

- 3nginx快速入门,使用多种方式部署nginx(mac/windows/docker/docker-compose)_mac nginx

- 4总结:大模型技术栈---算法与原理

- 5python怎么做gui界面,python gui界面设计_gui练习-制作两个界面

- 6django + mssql + sqlserver2008_django+serversql源码

- 7git 本地改动了,不保留,直接拉取线上最新代码_git强制拉取最新代码覆盖原有代码的命令

- 8性能监控与报告:实时了解ReactFlow应用的性能指标

- 9【蓝桥杯】-刷题技巧-总结_蓝桥杯会员到期可以刷题吗

- 10python获取剪切板内容

Sora号称的世界模型到底是个啥?_sora把世界建模

赞

踩

最近一周,说起AI界的顶流,非Sora莫属。

一经问世,瞬间引爆热搜,话题热度扶摇直上,甚至登上了央视的报道。

这几天刷手机的时候也“不堪其扰”,每天映入眼帘的都是Sora。

咱就是说,能不能别再给我推在东京街头溜达的墨镜大姐啦?!

凭借逼真的视频生成能力,Sora让大家啧啧称奇的同时,也纷纷慨叹——现实,不存在了!

发布者OpenAI更是扬言:Sora能够深刻理解运动中的物理世界,堪称真正的“世界模型”。

但是,这一论调却引起了一位大佬的强烈反对。

一直以来都将“世界模型”作为重点研究方向的图灵奖获得者、Meta 首席科学家Yann LeCun(杨立昆), 多次在社交平台账号上“狂喷” Sora,表示 Sora 的生成式技术路线注定会失败。

这已经不是他第一次批判OpenAI的大模型了。

ChatGPT发布后半年,LeCun在2023年6月9日北京智源大会上的演讲中表示,大语言模型(LLM)充其量也仅仅相当于大脑控制语言中枢的韦尼克区(Wernicke)和布若卡氏区(Broca),然而,与规划和决策等更高级认知活动相关的功能位于大脑的前额叶。没有任何现实知识的大语言模型会犯各种低级错误,也做不好推理和规划。

LeCun说得很不客气,大体意思就是:你GPT再厉害,也就辅助写写文章写写代码,真遇到高级点的任务就得靠边站!

Sora发布后,他再次对其进行“狠批”:仅根据文字提示生成逼真的视频,并不代表模型理解了物理世界。LeCun 表示:“生成视频的过程与基于世界模型的因果预测完全不同”;2 月 19 日,他又一次发文驳斥道:通过生成像素来对世界进行建模是一种浪费,就像那些被广泛抛弃的“通过合成来分析”的想法一样,注定会失败。

一言以蔽之,LeCun坚信:当下主流的生成式大模型并不是未来,世界模型才是。

LeCun的愤怒完全可以理解,毕竟他的金主爸爸是Meta,和OpenAI是竞争对手……

很多被Sora惊艳到的吃瓜群众可能不知道,就在 Sora 发布当天,还有另外两款重磅产品推出:一是谷歌发布的支持 100 万 tokens 上下文的大模型 Gemini 1.5 Pro;二是 Meta 发布的“能够以人类的理解方式看世界”的视频联合嵌入预测架构 V-JEPA(Video Joint Embedding Predictive Architecture)。

但结果却是,风头全部被Sora抢了去,在话题热度上,留给谷歌与Meta的,只有落寞。

金主不同只是一个方面。另一个令LeCun愤怒的原因,我想,就是有不少人号称Sora是“世界模型”。

被竞争对手先行一步装X,还装到了自己潜心研究多年的专精领域上,能不气吗?

那么,在LeCun看来,他所力挺的世界模型,和大模型相比,到底好在哪?

世界模型是个啥

首先我们需要明确,LeCun所说的“世界模型”,到底是啥。

数十年来,学者们前仆后继地致力于让机器获得人类的智慧,然而,即便是当下最先进的AI,其学习能力和对世界的理解能力还是要远远弱于人类。

然而,要想训练一个AI在现实世界中学会自动驾驶,可没这么容易。

单单是明白见到沟应该躲避,AI就需要从人类专家那里获得海量监督数据,需要在虚拟环境中经历无数次的强化学习试验,还需要工程师设定若干条硬连接规则。

很难想象,一个人想学开车,需要观看上万条驾驶视频、坐在屏幕前模拟上万种路况、再去死记硬背上万条规则吧!

经历了这种洗礼的人,能不能顺利出驾校不好说,出院肯定是不顺利了

即便如此,目前自动驾驶的可靠性依然无法企及人类。

于是,LeCun想到:恐怕以大模型为主流的人工智能,努力方向就错了!

人比机器聪明的一点在于,人似乎可以通过观察以及少量的交互,就能习得大量关于世界如何运作的背景知识。这种知识日积月累,就形成了每个人头脑中的“常识”——我可以凭直觉得知,开车见到沟需要躲避,这就是常识。

LeCun提出,常识可以看作世界模型的集合,它可以告诉智能体什么是可能的、合理的,什么是不可能的、不合理的。有了这样的世界模型,人就可以通过很少的试验,便可以学习到新技能,可以预测自己行为的后果,可以推理、规划、探索和想象问题的新解决方案,还可以避免在面对未知情况时犯下危险的错误。

比如,人开车的时候,一旦见到沟,头脑中的世界模型就会告诉他:作为一个有常识的人,你应该知道,如果冲进去就会翻车,翻了车就会受伤甚至挂掉,所以你应该避开。

世界模型就是一种基于心智的对世界建立起来的理解,就好比在头脑中构建了一个高效的对于现实世界的模拟器,从而应对各种不确定性,做出各种预判。

在人工智能领域,所谓的世界模型,是指机器对世界运作方式的理解和内部表示,也可以理解为抽象概念和感受的集合。它能帮助 AI 理解、学习和控制环境中发生的事情。因此世界模型也可以看作 AI 的“心智”,是 AI 对自身和外部世界的认知和期望。

那么,人的大脑能否包含生存所必需的所有世界模型呢?

对此,LeCun假设:人类在其前额叶皮层的某个地方只有一个世界模型引擎。该世界模型引擎可针对手头的任务进行动态配置,可以跨任务地共享有关世界如何运作的所有知识。

简单来说,仅仅通过一个世界模型,我便能够懂得:

开车遇到沟要避开,骑车、走路遇到沟当然也要避开!

小水沟要避开,大海沟当然也要避开!

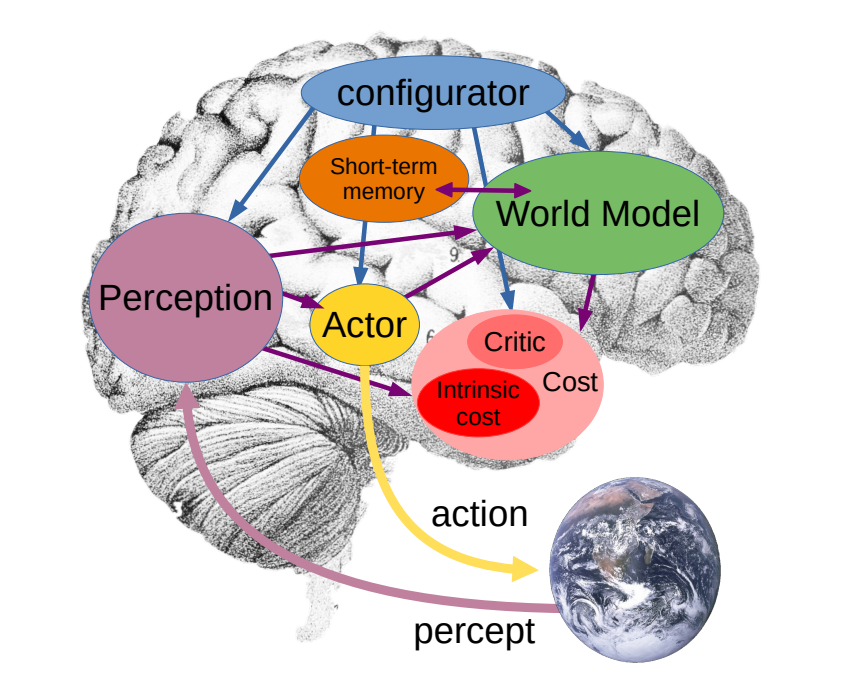

LeCun根据大脑运行机制,提出了一个端到端的仿生架构:

这个图包含了一个大脑+一个地球,通过人脑和世界的交互关系,来解释世界模型的构成。

顶层是配置器(Configurator),基于实际任务对其他模块进行配置和调整,可以看作一个控制中枢。(我是指挥部!)

左侧是感知器(Perception),接收信号并估计世界的当前状态。(报告指挥部,发现前方有沟!)

右上是世界模型(World Model),基于当前状态预测未来的世界状态,是系统中最复杂的部分。世界模型有两项职责:(1)估计感知器未提供的关于世界状态的缺失信息;(2)预测世界的合理未来状态。

世界模型可以预测世界的自然演化(半空中的物体会往下掉),

也可以预测由行为规划器(Actor,后文马上会提到该模块)提出的一系列动作所产生的未来世界状态(开车冲进沟里会翻车)。

需要注意的是,世界模型学习的是世界的抽象表示,保留下重要的细节,并忽略掉不重要的细节。然后,它在与任务水平相适应的抽象级别上提供预测。也就是说它能够学会的应该是“冲进沟里会翻车”,而不是“冲进了某一种特定的沟里会翻车”。

成本控制器(Cost)用来计算“不适感”(LeCun在论文里将其称作能量,这里为便于理解,就姑且称之为不适感或成本),作为调整模型参数的基准。所谓不适感,可以理解为智能体在身体和精神层面不希望经历的状况,例如身体疲劳、心理痛苦等。智能体的总体目标是采取行动从而保持不适感最小化。(掉进沟里的不适感肯定比不掉进去的不适感更高咯)

行为规划器(Actor,不是演员哦)根据不适感,探索最优的行为序列,以最小成本实现预期目标。(依我看,咱还是刹车吧……)

此外系统还需要一个短期记忆(Short-term memory),来存储世界过去、现在和未来的状态,和对应的成本信息。该模块可视为与脊椎动物的海马体具有相同的作用。

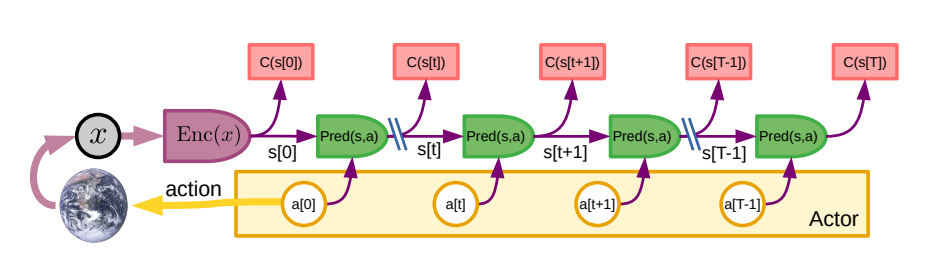

模型的具体运作方式可以参考这个感知-规划-行为循环模式(Perception-Planning-Action Cycle),其原理完全可以用上述人脑的世界模型引擎来解释。

其具体运作步骤如下:

别急,我来解(fan)释(yi)一下,其实就是把上面那个大脑图片的意思按运作流程重新梳理了一遍:

1、感知:感知器提取世界当前状态的表示,成本控制器计算并存储与该状态相关的直接成本。

2、动作提议:行为规划器提出一个初始动作序列,以反馈到世界模型进行评估。

3、模拟:世界模型预测一个或几个可能的世界状态表示序列,这些序列是由行为规划器提议的动作序列产生的。

4、评估:成本控制器从预测的状态序列估计总成本。

5、规划:行为规划器提出一个成本较低的新动作序列。这可以通过梯度下降或动态规划等方式来完成。完全优化可能需要迭代步骤 2-5。

6、行动:在一个低成本动作序列上收敛后,行为规划器将低成本序列中的第一个动作(或前几个动作)发送并执行。

7、记忆:在每一个动作之后,相关成本都存储在短期记忆中,以便后续训练。

可以看出,世界模型的内核,是希望真正理解这个世界,并按照成本最小化的逻辑,进行对未来的预测和行动规划。

假如这种基于世界模型的AI真的能够实现,那么它不仅可以为人类提供行动方案和规划参考,他自己也可以基于外部环境,做出完全独立自主的行为,这种自主行为具备了自主决策和自主行动能力的特征,可以视为AI具有了“自我意识”。

也许有朝一日,世界模型AI机器人问世,他仅需要通过简单的训练就能掌握开车时见到沟要避开,而不必再给他投喂成千上万的大沟、小沟、阴沟、马里亚纳海沟翻车视频了。

为啥LeCun觉得大模型不是未来,世界模型才是

LeCun对于OpenAI的大模型频频发起抨击,我们不禁要问,他究竟是看不惯大模型的哪一点了?

首先我们要明确,各大AI公司在明里暗里较劲儿的一个重要目标,就是在比谁能最先实现AGI(artificial general intelligence,通用人工智能,可以简单理解为,达到AGI水准的人工智能,能够如科幻作品所描述的那样,像人类一样思考、学习和执行各种各样的任务)。

实现AGI早已被OpenAI列入企业使命和核心价值观。LeCun那篇著名的介绍世界模型和JEPA架构的立场论文,其标题为《通往自主智能体之路》(A Path Towards Autonomous Machine Intelligence),其实也就是一条通往AGI之路。

而LeCun对OpenAI口诛笔伐,其最根本观点其实就是:生成式大模型并不是通往AGI的正确道路,世界模型才是。

再通俗一点说就是,大模型的“思考”方式根本不像人,世界模型才像!

站在LeCun的角度来看,大模型是“大而蠢”的。

“大”,是真的大。OpenAI一直以来走的是自回归生成式的路线(Auto-regressive models),遵循的是“大数据、大模型、大算力”的暴力美学。可以说,从 ChatGPT 到 Sora,都是这一思路的代表性产物。

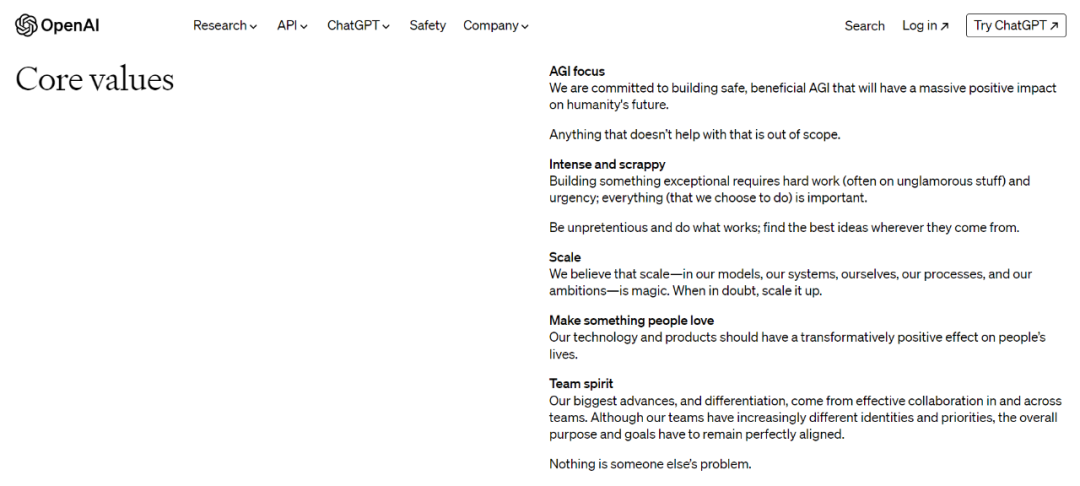

OpenAI甚至把“大”明晃晃地搬进了企业的核心价值观:我们相信规模……当有疑问时,就扩大规模。

Scale:

We believe that scale—in our models, our systems, ourselves, our processes, and our ambitions—is magic. When in doubt, scale it up.

熟悉的配方,熟悉的Scale it up。

正如相信的心就是你的魔法,那么Scale就是OpenAI解决模型、系统、自身、过程和目标抱负的魔法。不论有什么疑虑,先梭哈一把扩大规模再说,大力出奇迹,很符合大家对 GPT-4的刻板印象。

这说明,至少就目前来看,OpenAI 依然看好“规模定律”,单纯通过扩大规模依然可以收获很好的效果,因此,与其在举棋不定中浪费时间,不如心无旁骛(且壕无人性)地堆资源、堆参数。

正因如此,OpenAI不惜“通过生成像素来对世界进行建模”,而这正是LeCun所嗤之以鼻的。

“蠢”,是指大模型的思考方式目前依然不像人,或者说,与人相去甚远。

而反观世界模型,其追求的是像人脑一样真正地学习和理解这个世界,这注定了它并不会选择像大模型那样简单粗暴地堆砌资源。

因此LeCun认为,在实现AGI的道路上,大模型走的是一条邪路、歪路,世界模型才是正道。

尾声

自从GPT取得了巨大成功以来,众多照猫画虎的模仿者涌现,但锐意进取的创新者寥寥。

国内大批公司跟风鼓吹和加紧研发大模型,以至于在短短一年的时间里,生成式大模型俨然成为AI行业的“主流”。

但是,就在众人抢抓一切机遇压榨大模型的商业价值之时,这世上依然有一批如LeCun这样的人,他们没有放弃思考,没有随波逐流,而是敢于向主流提出质疑、提出挑战。

当前AI还仅仅处于一个起步阶段,这个行业需要的绝不是永远追随着主流的脚步、越来越趋向于同质化的大模型,而是需要更多崭新的思路和方法,更多勇敢的探索与尝试。

更何况,以GPT为代表的自回归大语言模型的局限和瓶颈已经有目共睹。不能仅仅因为这些模型在当下具备着令人惊叹的有效性和商业价值,就放弃了对其他路径的探索。

这个世界需要更多的LeCun。不论他的世界模型最终能否真正实现AGI,但他至少为解决规划和决策问题提供了一条切实可行的新道路。

我相信,这条路值得我们努力前行。