- 1Python 解码 Unicode 转义字符串

- 2奇富科技跻身国际AI学术顶级会议ICASSP 2024,AI智能感知能力迈入新纪元_icassp2024

- 3基于Java+SpringBoot+Vue前后端分离智能停车计费系统设计和实现_前后端分离停车场申请车位功能怎么写

- 4Docker file 搭建 Django镜像。-bash: django-admin: command not found,Invalid HTTP_HOST header:You may need_docker invalid host header

- 5程序员赚钱的六种方式:技术实力和市场分析能力是关键_稳定挣钱项目程序员

- 6特殊符号大全!_∴′

- 7Visual Studio 调试系列7 查看变量占用的内存(使用内存窗口)

- 8记录 | KMS工具激活Office报错 Error Code: 0x80080005_visio2019 激活 0x80080005

- 9win10系统激活遇到的问题_windows系统激活报错:错误 0xc004e028 在运行 microsoft windows

- 10如何理解三大微分中值定理

[AI绘图教程]stable-diffusion webui加载模型与插件. 实战AI绘画_stable-diffusion-webui模型

赞

踩

之前讲了stable diffusion webui搭建,这里主要介绍使用方法以及模型,扩展等.

模型下载

主要下载网址

- HuggingFace:Stable Diffusion、ControlNet的官方仓库。

- Civitai:里面多是Lora或其它NSFW等模型的仓库。

这里下载anythingV4的模型,在Huggingface网站中搜索,

下载后放在stable-diffusion-webui\models\Stable-diffusion中

其他的模型也类似.

NovelAI模型也类似,需要下载相关模型.可以在Huggingface上搜索,如果实在找不到可以后台私信我.接下来介绍一些比较有意思的模型以及有用的插件

NovelAI

官网NovelAI - The AI Storyteller可以自己在网站上尝试

如果是本地部署的话,下载模型即可,可以参考这个网站Stable Diffusion NovelAI模型下载 - openAI

但这个模型貌似是泄露出来的,不能在huggingface上直接下载到,所以可以自己在网上搜搜.

loraAI

首先需要下载一个基础模型,然后再下载你想要的lora模型.

一般的基础模型是chilloutmix,在下载好这个模型后可以自己选择喜欢的lora模型.

一般的基础模型是chilloutmix,在下载好这个模型后可以自己.选择喜欢的lora模型,下载后放到models/Lora中.

我这里使用chilloutmix_Ni作为基础模型,然后点击右边的show extra networks,可以看见下面的Lora模型,点击使用,再加上自己的prompt即可.

正向词

<lora:yaeMikoRealistic_yaemikoMixed:1>masterpiece,((8k, RAW photo, highest quality, masterpiece), High detail RAW color photo professional close-up photo, (realistic, photo realism:1. 37), (highest quality), (best shadow), (best illustration), ultra high resolution, physics-based rendering, cinematic lighting), 1girl, petite, (ulzzang-6500:0.7), yae miko \(fox\), yae miko \(cosplay\), yae miko, smile, thick lips, narrow waist, shiny skin, pink hair, face_focus, (from side), depth of field, (long hair), bare shoulders, detached sleeves, hair ornament, earrings, bare thighs, (sideboob:1.65), upper body, east asian architecture, covered nipples

- 1

反向词

bright lantern, brightness, (nipples:1.2), pussy, EasyNegative, (worst quality:2), (low quality:2), (normal quality:2), lowres, normal quality, ((monochrome)), ((grayscale)), skin spots, acnes, skin blemishes, age spot, glans,extra fingers, fewer fingers, strange fingers, bad hand, strange leg, strange thighs, ((between breasts)), (cleavage:1.5), bra,

- 1

感觉不到一分钟就出图了.我的GPU显存4G,GTX1650

怎么样,还不错吧

参考LORA模型使用教程及模型下载 Stable Diffusion WebUI - openAI

ControlNet

下载插件

可以直接在stable diffusion webui中下载扩展,扩展名字是sd-webui-controlnet

下载方式跟之前下载中文支持类似

同时推荐安装OpenPose Editor用于编辑人物姿势

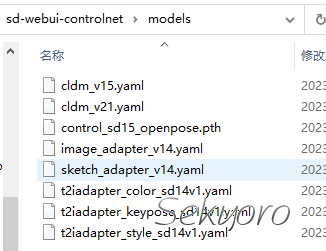

下载模型

网站lllyasviel/ControlNet at main (huggingface.co)

| 模型名称 | 模型描述 |

|---|---|

| control_sd15_canny.pth | 适用于给线稿上色,或将图片转化为线搞后重新上色,比较适合人物。 |

| control_sd15_depth.pth | 创造具有景深的中间图,建筑人物皆可使用。 Stability的模型64×64深度,ControlNet模型可生成512×512深度图。 |

| control_sd15_hed.pth | 提取的图像目标边界将保留更多细节,此模型适合重新着色和风格化。 |

| control_sd15_mlsd.pth | 该模型基本不能识别人物的,但非常适合建筑生成,根据底图或自行手绘的线稿去生成中间图,然后再生成图片。 |

| control_sd15_normal.pth | 根据底图生成类似法线贴图的中间图,并用此中间图生成建模效果图。 此方法适用于人物建模和建筑建模,但更适合人物建模。 |

| control_sd15_openpose.pth | 根据图片生成动作骨骼中间图,然后生成图片,使用真人图片是最合适的,因为模型库使用的真人素材。 |

| control_sd15_scribble.pth | 使用人类涂鸦控制SD。该模型使用边界边缘进行训练,具有非常强大的数据增强功能,以模拟类似于人类绘制的边界线。 |

| control_sd15_seg.pth | 使用语义分割来控制SD,协议是ADE20k。 现在您需要输入图像,然后一个名为Uniformer的模型将为您检测分割。 |

这里一个模型就是5.71G,由于磁盘空间有限,所以我这里选择其中一个即可.

注意模型需要放在controlnet扩展目录下的models中

使用

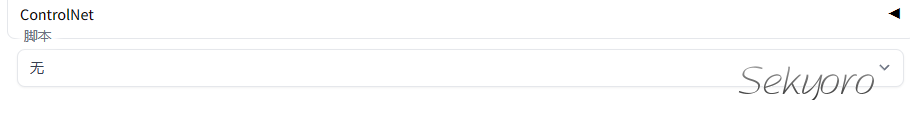

下载后刷新,界面会出现ControlNet

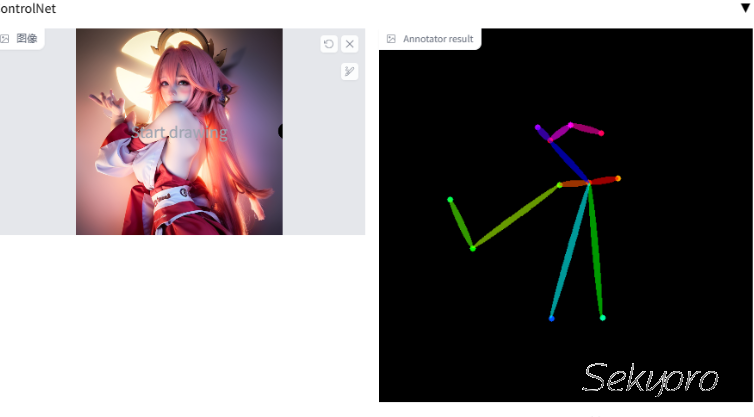

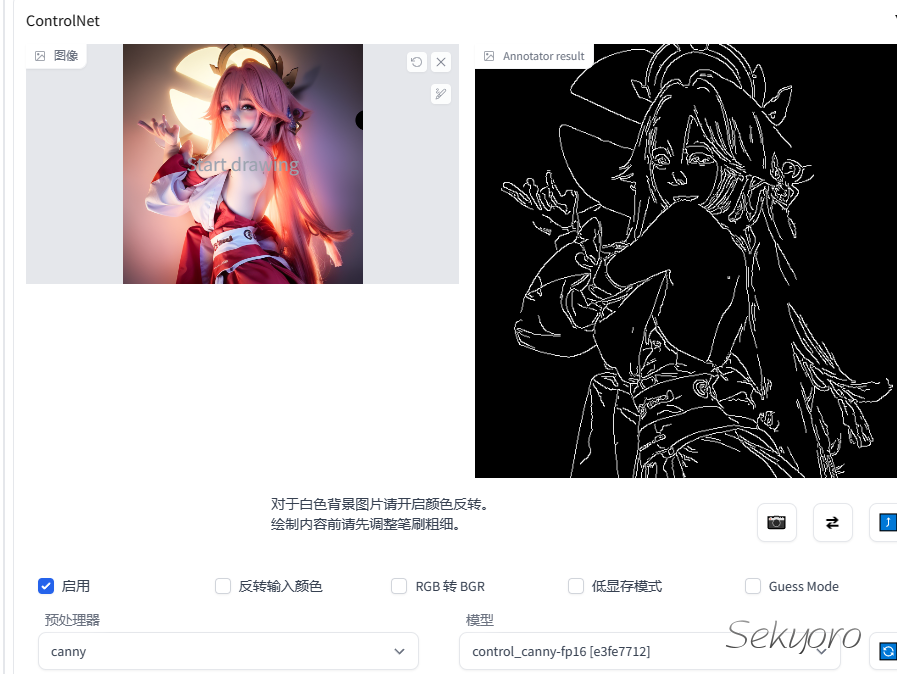

利用刚才的图像,将刚才的图像拖到ControlNet中,勾选启用,预处理器选择openpose,模型选择对应的control_openpose的模型,其他的可以不动.然后点击预览预处理结果.

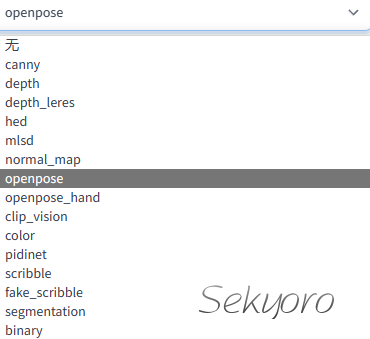

这样就得到对应的骨骼姿势了,输入不同的prompt,点击生成可以通过这个骨骼姿势得到其他图像.下载了的预处理器如下

| 预处理名称 | 对应模型 | 模型描述 |

|---|---|---|

| canny | control_canny | 边缘检测 |

| depth | control_depth | 深度检测 |

| hed | control_hed | 边缘检测但保留更多细节,适合重新着色和风格化。 |

| mlsd | control_mlsd | 线段识别,识别人物功能极差,非常适合建筑。 |

| normal_map | control_normal | 根据图片生成法线贴图,非常适合CG建模师。 |

| openpose | control_openpose | 提取人物骨骼姿势 |

| openpose_hand | control_openpose | 提取人物+手部骨骼姿势 |

| scribble | control_openpose | 提取黑白稿 |

| fake_scribble | control_scribble | 涂鸦风格提取(很强大的模型) |

| segmentation | control_seg | 语义分割 |

除了使用openpose还有其他模型可用,比如使用Canny提取线稿

还有使用Scribble模型涂鸦绘画等等.这里就不详细说了

插件下载

提示词补全

能在输入Tag时提供booru风格(如Danbooru)的TAG自动补全。因为有一些模型是基于这种TAG风格训练的(例如Waifu Diffusion),因此使用这些Tag能获得较为精确的效果。

git clone "https://github.com/DominikDoom/a1111-sd-webui-tagcomplete.git" extensions/tag-autocomplete

- 1

openpose editor

下载插件即可,可用于编辑ControlNet得到的骨骼图.

骨架人偶Posex

hnmr293/posex: Posex - Estimated Image Generator for Pose2Image (github.com)

使用方法

点击:选择身体

左拽:移动关节(选中关节点)或者旋转视角

右拽:移动整个身体(如果选中身体)或者移动视角

鼠标滚轮:放大缩小

手部模型

不定期更新,欢迎关注点赞.⭐️