人脸清晰化神器codeFormer图形界面包GUI

赞

踩

1. codeFormer介绍

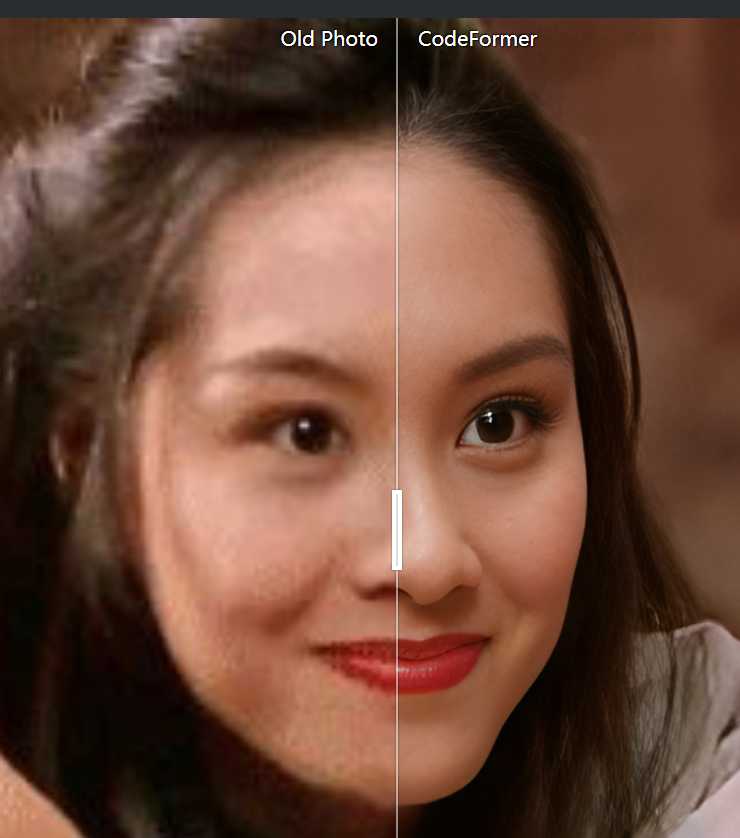

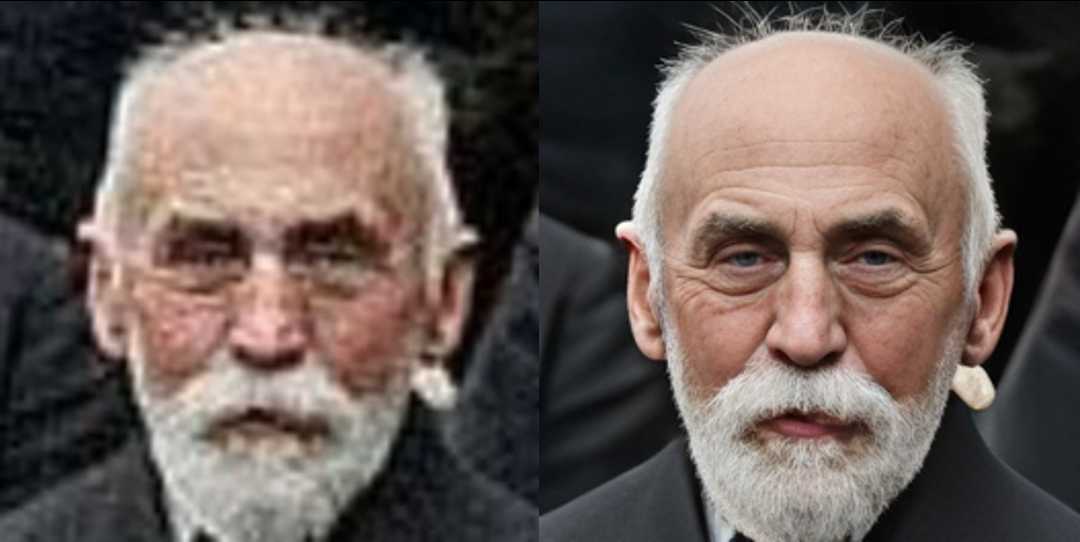

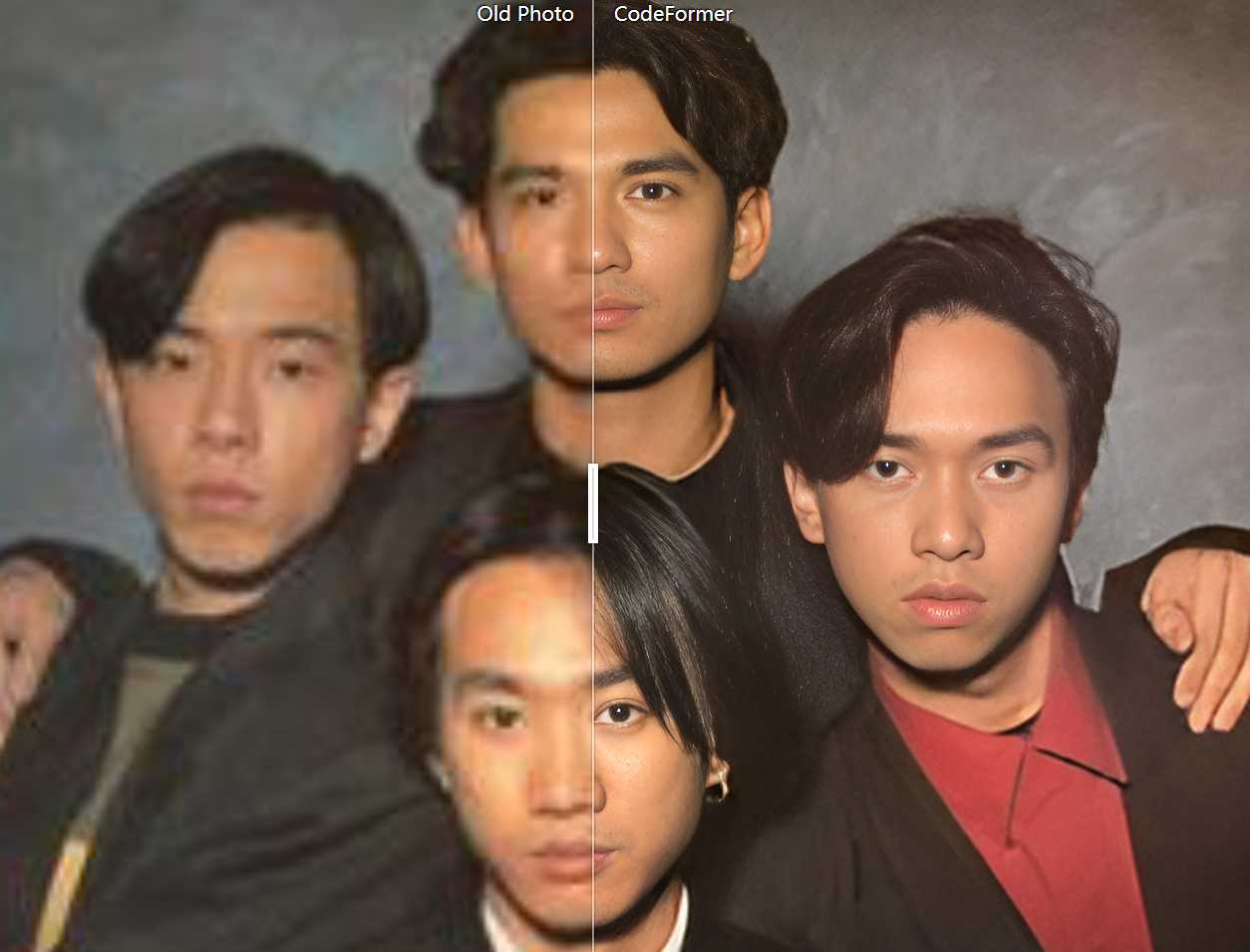

在NeurIPS 2022上,南洋理工大学-商汤科技联合研究中心S-Lab提出了一种基于VQGAN+Transformer的人脸复原模型CodeFormer,效果是真的强大,先展示下效果,用的官方案例效果图。

官方给出的代码见这里 传送门

2. 图形化界面一体包

由于源码对小白不友好,装环境难题直接阻拦大部分用户,为此我打包好了所需的python环境,做了一个图形GUI包,无需你本地安装python环境也可使用,下载链接放在文末

用法很简单

- 下载解压后,点击“启动程序.bat”,

- 然后你要处理的是图片还是视频,切换到对应选项卡

- 选择待处理的图片或者视频,以及结果保存位置

- 点击开始处理,程序开始自动运行

如果运行被360拦截,请关闭360。所有源代码均公开可见,在_internal文件夹里可查看,无需担心程序后门

我这个打包版本的功能,除了codeformer本身功能之外,还有以下功能:

1. 对deepfacelab切好的aligned强化,直接写入dfl已有信息,无需重新切脸,强化完可以直接用于训练

2. 关闭了codeformer里默认尺寸放大2倍的功能,改为默认1倍尺寸,保持dfl切好的图不会出现尺寸不匹配问题

3. 把强化aligned人脸图和强化整个图分开到2个标签页,分别对应alinged文件夹强化和merge文件夹强化,方便新手小白理解

3. 效果实测

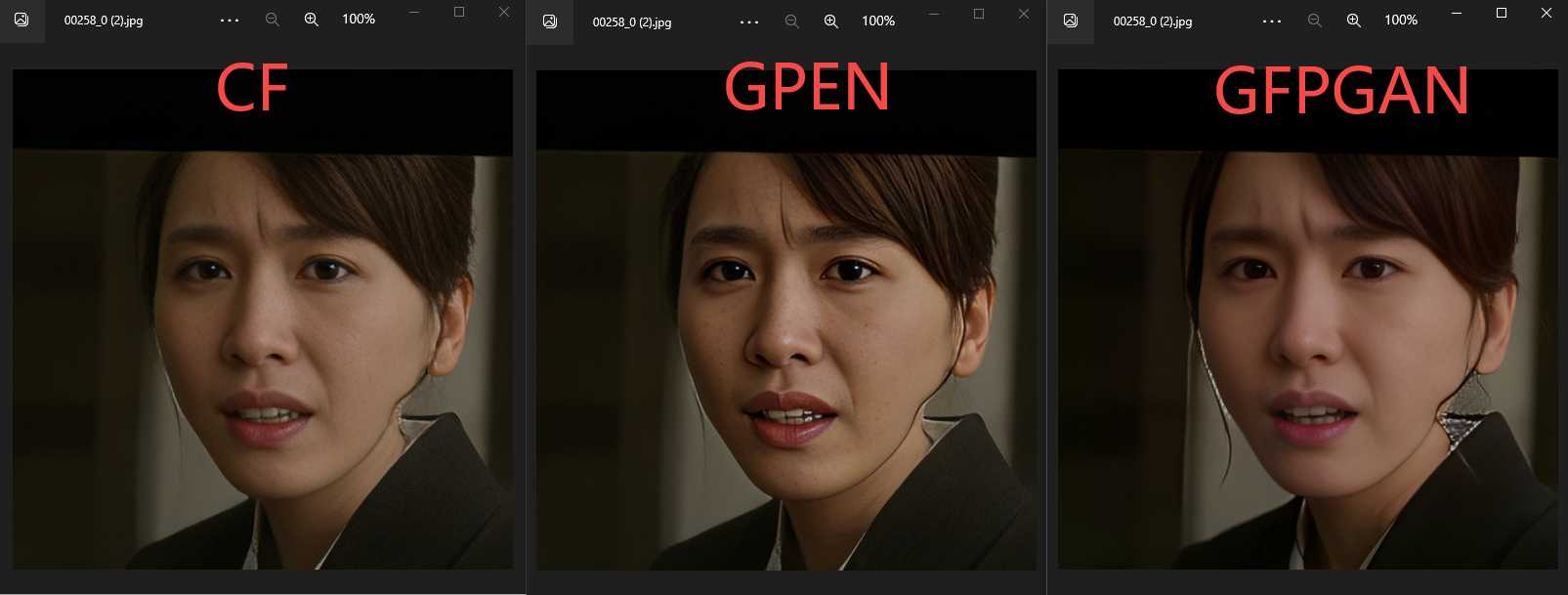

此处对比3种针对人脸的清晰化算法:codeFormer,GPEN,GFPGAN

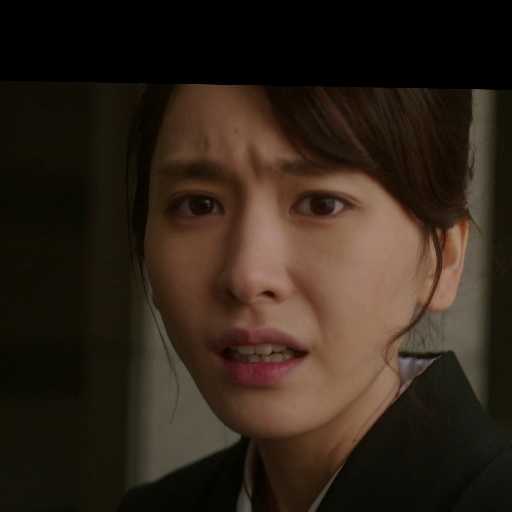

使用老婆新垣结衣的图做测试

先测试正面情况:

正面效果上,codeFormer(以下简称CF)效果最好,清晰又清爽,原人物的身份特征保留完好

GPEN其次,清晰,但会增加一种油腻感,会平白增加一些雀斑一样的东西,原人物的身份特征保留完好

GFPGAN最垃圾,人物的身份特征会受影响,都看不出这是新垣结衣了

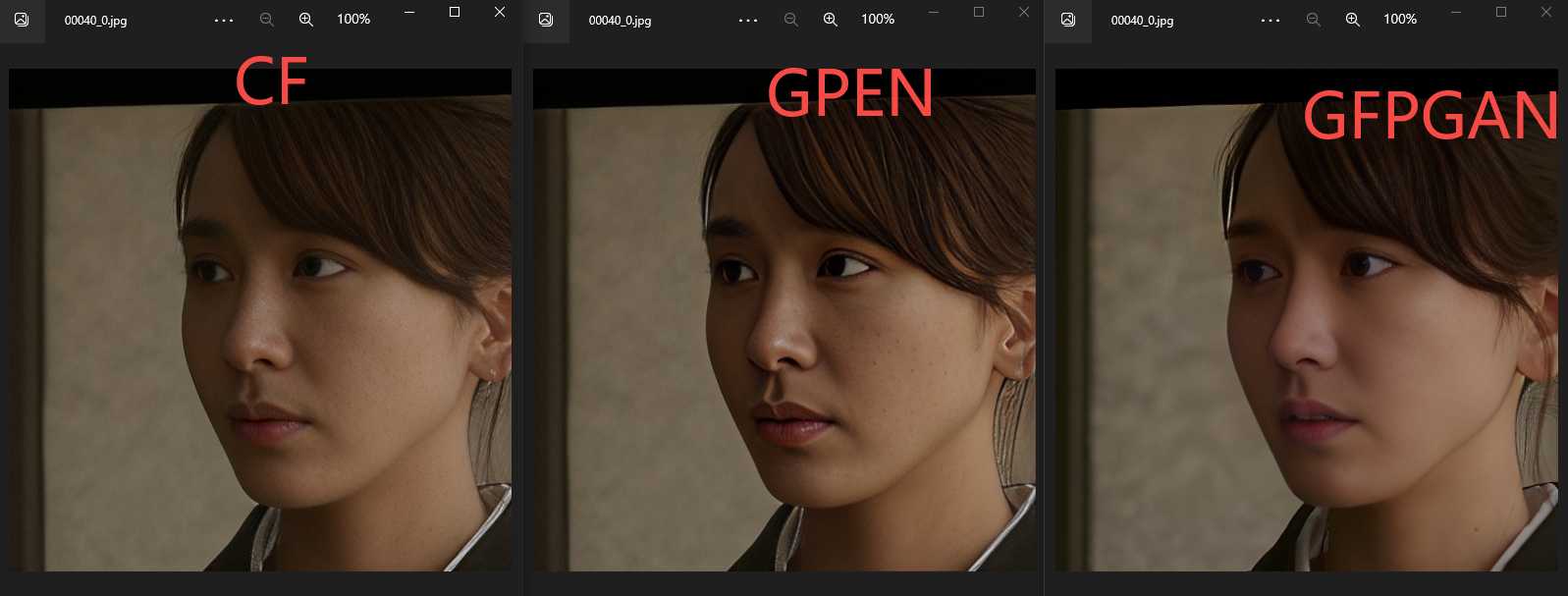

再测试小侧面情况

小侧面效果,

CF清爽自然,但眼神有变化

GPEN油腻,但眼神有变化

GFPGAN反而效果好一点

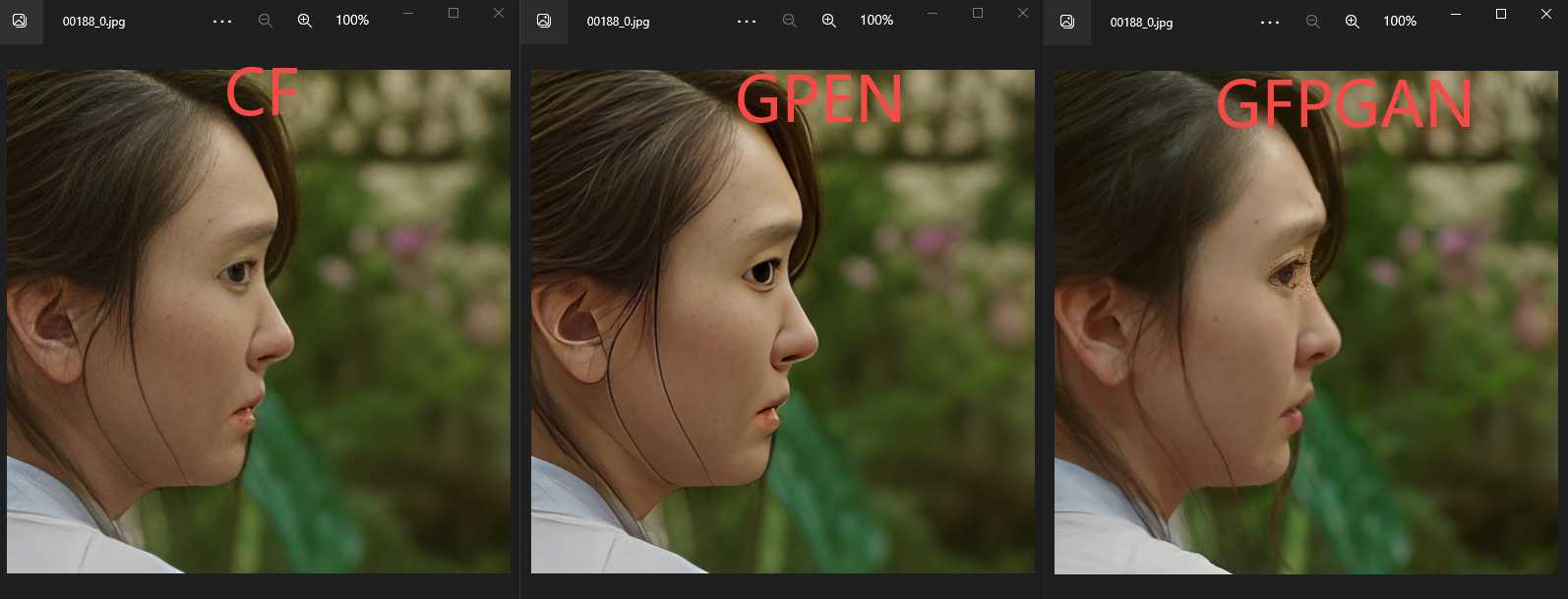

再测试大侧面情况

大侧面效果上,CF和GPEN都不太好,眼神跟鬼一样。GFPGAN更烂

codeFormer算法里有个w参数控制追求细节还是忠于原图,对比如下

这个没有好坏之分,看个人喜好了

下载链接

(已更新支持40系显卡)

链接:https://pan.baidu.com/s/1C48Fjanjki4-JupwoyKS6Q?pwd=1c2i

提取码:1c2i