热门标签

热门文章

- 1Linux内核系统架构介绍_linux是什么架构

- 2第61天-服务攻防-中间件安全&CVE 复现&K8s&Docker&Jetty&Websphere_cve-2021-28164

- 3使用PyQt实现XAMPP或phpStudy类似功能

- 4面向对象思想实现图书管理系统_现需要开发以“图书管理系统”,请采用第四章学习的面向对象方法进行设计,并提

- 5【计算机毕业设计】基于微信小程序的大学生心理测评系统_心理测试 小程序 设计

- 6机器学习面试题_高度相关关系可以用支持向量机吗

- 7内涵:YOLO系列解读(上)-----YOLOv1到YOLOv3梳理_2015年yolo

- 8React----中后台管理项目开发_中后台开发

- 9四、Flink使用广播状态和定时器实现word_join_count有效时间1分钟_flink 定时器

- 10北林计算机分数,2021北京林业大学录取分数线-北京林业大学分数线-2021北京林业大学录取查询网址...

当前位置: article > 正文

0922数据增广

作者:盐析白兔 | 2024-05-04 18:01:01

赞

踩

数据增广

数据增广(主要是关于图像增强)

- 大型数据集是成功应用深度神经网络的先决条件

- 图像增广在对训练图像进行一系列的随机变化之后,生成相似但不同的训练样本,从而扩大训练集的规模

- 大多数图像增广方法都具有一定的随机性

- 数据增广不仅仅局限于处理图片,还可以处理文本和语音

- 对于图片的处理方式包括:覆盖掉一些像素、对颜色进行变换、对亮度进行变换

在训练集中使用图像增广,随机改变训练样本可以减少模型对某些属性(如位置、颜色等)的依赖,尽可能地模拟现场部署时的场景,提高模型的泛化性能

如何进行数据增广

数据增强就是在已有的数据集上通过对数据的变换,使得数据具有多样性

- 对于语音数据来说,可以加入不同的背景噪音

- 对于图片数据来说,可以改变图片的形状,颜色等

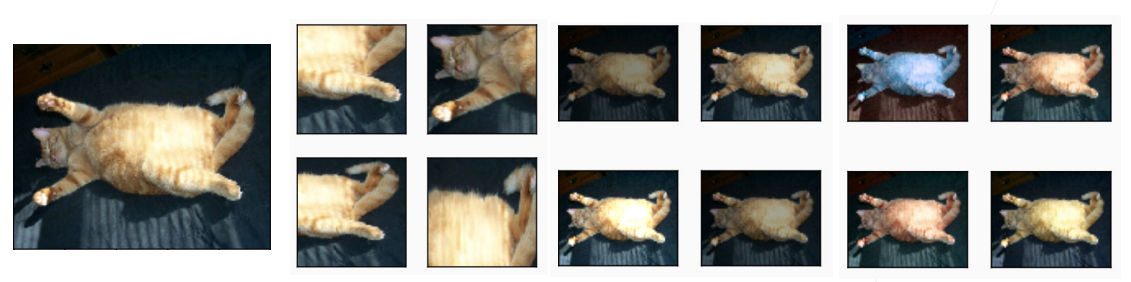

- 上图中右边两行小图是对图片进行数据增广之后的结果

- 第1、2列是对原图像进行部分截取之后的结果

- 第3、4列是对原图像的亮度进行变换之后的结果

- 第5、6列是对原图像的色温进行变换之后的结果

如何使用增广数据进行训练

一般来说,增广数据都是在线生成的,而不是先进行数据增广生成增广数据之后再保存下来

- 先从原始数据中读取图片,然后随机做数据增强(将不同的数据增强的方法随机地用来处理原始数据)生成增强数据,再将增强数据放入模型中进行训练

- 核心是:1、在线生成,2、数据增强的方法是随机的

数据增强可以看作是训练过程中的一个正则项

在测试的时候一般是不会进行图像增强的

常见的数据增强方法

翻转

图片的翻转包括左右翻转和上下翻转

- 左右翻转图像通常不会改变图像的类别(最早且最广泛使用的图像增广方法之一)

- 上下翻转并不是一定可行的,如上图最后一行图片所示,当对猫的图片进行翻转之后,猫的头就会朝向下面,建筑物的图片同理(上下翻转取决于数据集是否适合上下翻转

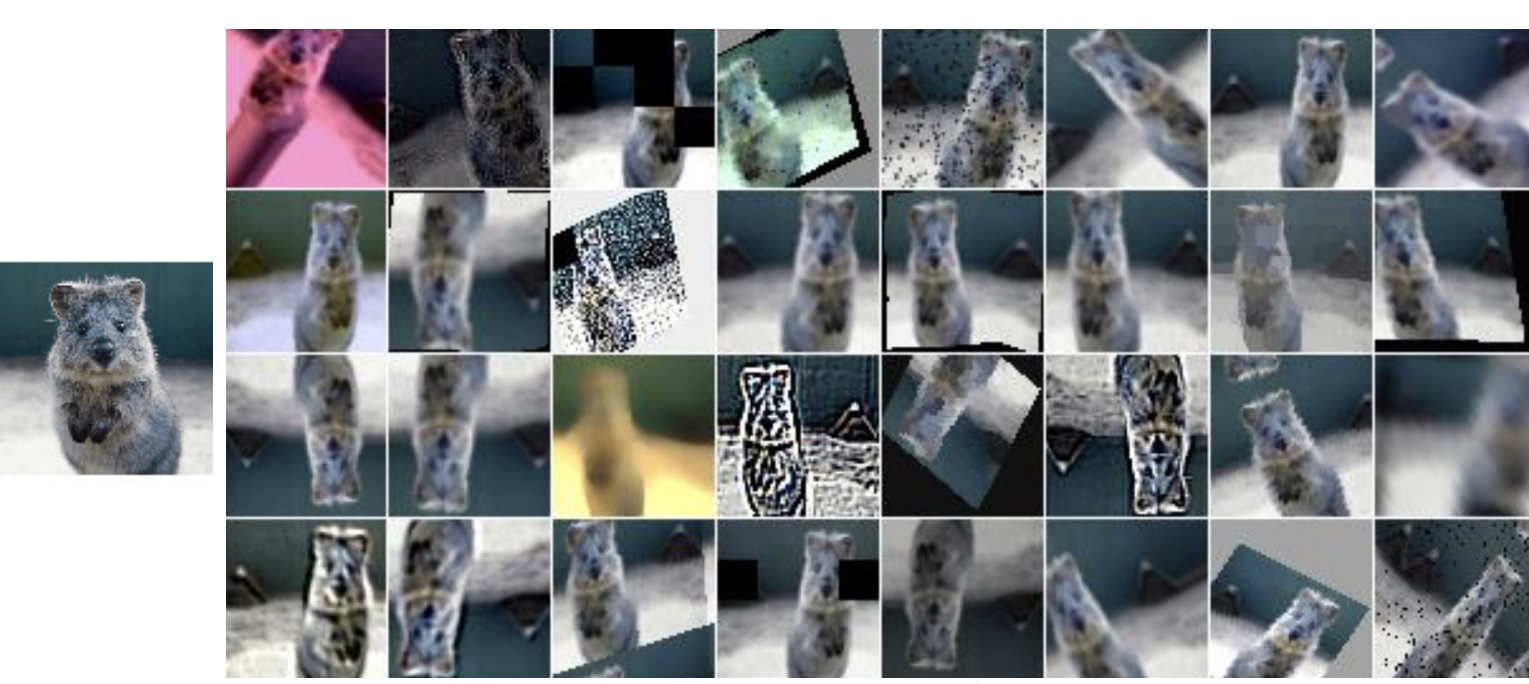

裁剪

切割一般是在图片中切割一块出来,然后将它变成固定的形状(之所以是固定的形状,是因为卷积神经网络的输入通常是固定的,一般是224*224)

- 通过对图像进行随机裁剪,使物体以不同的比例出现在图像的不同位置,从而降低模型对目标位置的敏感性

如何进行切割(随机性原理)

- 随机高宽比:比如在某一个区间(比如[3/4,4/3])之间随机取一个数来作为切割部分的高宽比

- 随机大小:比如在某一个区间(比如[8%,100%])之间随机取一个数来作为切割部分的大小(切割部分占原始图像的比例)

- 随机位置:给定截取部分的形状大小,然后在原始图像上面进行随机切割

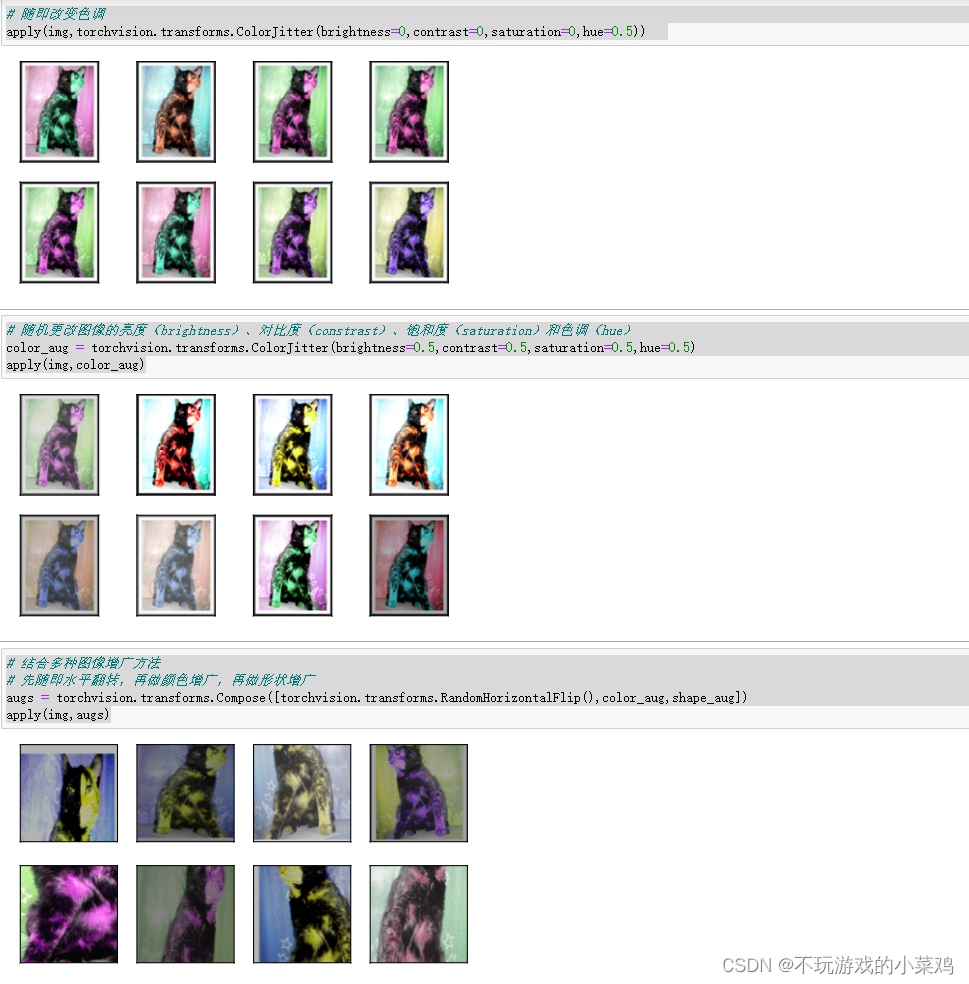

颜色

改变颜色中四个比较重要的指标

- 色调

- 饱和度

- 对比度

- 明亮度

一般说实在某一个区间(比如[0.5,1.5])上随机选定一个值,然后在该指标的当前值的基础之上进行增减

其他

imgaug(https://github.com/aleju/imgaug)中提供了几十种不同的图像增强的方法

- 高斯模糊

- 将图片中的某一块抹掉

- 对整个图片进行变形

- 锐化

- 等等

某一种数据增强的方法有用,很多时候是因为测试集中某些图片和原始图片通过这种数据增强的方式处理之后的效果类似

- 很多时候应该从结果向前推,通过对现场部署的情况或者测试集可能发生的变化进行分析,由此来反推所需要进行的数据增强

- 在实践中,通常结合多种图像增广方法

总结

- 数据增强通过变形数据来获取多样性从而使得模型泛化性能更好(基于现有的训练数据生成随机图像,以提高模型的泛化能力,本质上是希望通过对原始数据的变化来模拟现场部署或者是测试集中可能出现的情况)

- 常见的图片增强包括翻转、切割、变色

- 为了在预测过程中得到确切的结果,通常会只对训练样本进行图像增广,而在预测过程中不使用带随机操作的图像增广

- 在实践中,通常会组合使用多种图像增广方法

代码:

- %matplotlib inline

- import torch

- import torchvision

- from torch import nn

- from d2l import torch as d2l

-

- d2l.set_figsize()

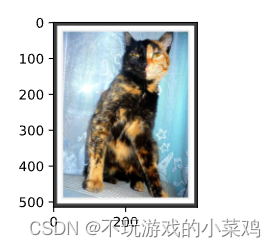

- img = d2l.Image.open('01_Data/02_cat.jpg') # 读取图片

- d2l.plt.imshow(img) # 显示图片

- def apply(img, aug, num_rows=2, num_cols=4, scale=1.5): # 传入aug图片增广方法

- Y = [aug(img) for _ in range(num_rows * num_cols)] # 用aug方法对图片作用八次

- d2l.show_images(Y, num_rows, num_cols, scale=scale) # 生成结果用num_cols行,num_cols列展示

-

- apply(img, torchvision.transforms.RandomHorizontalFlip()) # 水平随机翻转

-

- apply(img, torchvision.transforms.RandomVerticalFlip()) # 上下随机翻转

-

- # 随机剪裁,剪裁后的大小为(200,200)

- # (0.1,1)使得随即剪裁原始图片的10%到100%区域里的大小,ratio=(0.5,2)使得高宽比为2:1,下面是显示时显示的1:1

- shape_aug = torchvision.transforms.RandomResizedCrop((200,200),scale=(0.1,1),ratio=(0.5,2))

- apply(img,shape_aug)

- # 随即改变色调

- apply(img,torchvision.transforms.ColorJitter(brightness=0,contrast=0,saturation=0,hue=0.5))

-

- # 随机更改图像的亮度(brightness)、对比度(constrast)、饱和度(saturation)和色调(hue)

- color_aug = torchvision.transforms.ColorJitter(brightness=0.5,contrast=0.5,saturation=0.5,hue=0.5)

- apply(img,color_aug)

-

- # 结合多种图像增广方法

- # 先随即水平翻转,再做颜色增广,再做形状增广

- augs = torchvision.transforms.Compose([torchvision.transforms.RandomHorizontalFlip(),color_aug,shape_aug])

- apply(img,augs)

cifar-10-python.tar.gz 网盘链接:https://pan.baidu.com/s/1xpl1CqK2ZwJX_IBYTcnZNA 提取码:1111

- # 下载图片,并显示部分图片

- all_images = torchvision.datasets.CIFAR10(train=True, root='01_Data/03_CIFAR10', download=True)

- d2l.show_images([all_images[i][0] for i in range(32)], 4, 8, scale=0.8)

-

- # 只使用最简单的随机左右翻转

- train_augs = torchvision.transforms.Compose([

- torchvision.transforms.RandomHorizontalFlip(),

- torchvision.transforms.ToTensor()])

-

- test_augs = torchvision.transforms.Compose([

- torchvision.transforms.ToTensor()])

-

- # 定义一个辅助函数,以便于读取图像和应用图像增广

- def load_cifar10(is_train, augs, batch_size):

- dataset = torchvision.datasets.CIFAR10(root='01_Data/03_CIFAR10',train=is_train,

- transform=augs, download=True)

- dataloader = torch.utils.data.DataLoader(dataset,batch_size=batch_size,shuffle=is_train,

- num_workers = 0)

- return dataloader

-

- # 定义一个函数,使用多GPU模式进行训练和评估

- def train_batch_ch13(net, X, y, loss, trainer, devices):

- if isinstance(X, list):

- X = [x.to(devices[0]) for x in X] # 如果X是一个list,则把数据一个接一个都挪到devices[0]上

- else:

- X = X.to(devices[0]) # 如果X不是一个list,则把X挪到devices[0]上

- y = y.to(devices[0])

- net.train()

- trainer.zero_grad()

- pred = net(X)

- l = loss(pred, y)

- l.sum().backward()

- trainer.step()

- train_loss_sum = l.sum()

- train_acc_sum = d2l.accuracy(pred, y)

- return train_loss_sum, train_acc_sum

-

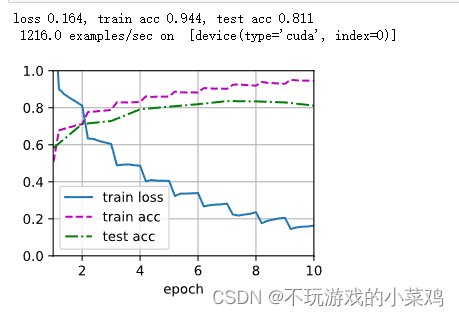

- def train_ch13(net, train_iter, test_iter, loss, trainer, num_epochs, devices=d2l.try_all_gpus()):

- timer, num_batches = d2l.Timer(), len(train_iter)

- animator = d2l.Animator(xlabel='epoch',xlim=[1,num_epochs],ylim=[0,1],

- legend=['train loss', 'train acc', 'test acc'])

- # nn.DataParallel使用多GPU

- net = nn.DataParallel(net, device_ids=devices).to(devices[0])

- for epoch in range(num_epochs):

- metric = d2l.Accumulator(4)

- for i, (features, labels) in enumerate(train_iter):

- timer.start()

- l, acc = train_batch_ch13(net,features,labels,loss,trainer,devices)

- metric.add(l,acc,labels.shape[0],labels.numel())

- timer.stop()

- if (i + 1) % (num_batches // 5) == 0 or i == num_batches -1:

- animator.add(

- epoch + (i + 1) / num_batches,

- (metric[0] / metric[2], metric[1] / metric[3], None))

- test_acc = d2l.evaluate_accuracy_gpu(net,test_iter)

- animator.add(epoch+1,(None,None,test_acc))

- print(f'loss {metric[0] / metric[2]:.3f}, train acc'

- f' {metric[1] / metric[3]:.3f}, test acc {test_acc:.3f}')

- print(f' {metric[2] * num_epochs / timer.sum():.1f} examples/sec on '

- f' {str(devices)}')

-

- # 定义train_with_data_aug函数,使用图像增广来训练模型

- batch_size, devices, net = 256, d2l.try_all_gpus(), d2l.resnet18(10,3)

-

- def init_weights(m):

- if type(m) in [nn.Linear, nn.Conv2d]:

- nn.init.xavier_uniform_(m.weight)

-

- net.apply(init_weights)

-

- def train_with_data_aug(train_augs, test_augs, net, lr=0.001):

- train_iter = load_cifar10(True, train_augs, batch_size)

- test_iter = load_cifar10(False, test_augs, batch_size)

- loss = nn.CrossEntropyLoss(reduction="none")

- # Adam优化器算是一个比较平滑的SGD,它对学习率调参不是很敏感

- trainer = torch.optim.Adam(net.parameters(),lr=lr)

- train_ch13(net, train_iter, test_iter, loss, trainer, 10, devices)

-

- train_with_data_aug(train_augs, test_augs, net)

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/盐析白兔/article/detail/535559

推荐阅读

相关标签