热门标签

热门文章

- 1Openlayers Style 样式演示 - 基础样式、标签文本(label)、标签背景和边框、渐变色等

- 2小米语音首席科学家与开源泰斗陆首群探讨新一代 Kaldi 与大模型

- 3计算机毕业设计 SSM共享充电宝管理系统(源码+论文)_共享充电宝数据库系统设计

- 4SpringBoot+Vue实现el-table表头筛选排序(附源码)_vue表头怎么做筛选功能

- 5在Ubuntu中安装pycharm的专业版且可以激活到2099年(保姆级教学,值得借鉴与信任)_pycharm ubuntu 版本

- 6软件工程物联网方向嵌入式系统复习笔记--嵌入式系统硬件平台

- 7LLM:检索增强生成(RAG)_ig检索增强

- 8三维点云的深度学习研究综述

- 9Android开发-CardView卡片View的详解,头条三面技术四面HR_androidx.cardview.widget.cardview

- 10Hibernate 分页的两种方式_hibernate 内存分页

当前位置: article > 正文

CNN-BIGRU、CNN-BILSTM、CNN-GRU、CNN-LSSVM、CNN-LSTM、CNN-SVM

作者:盐析白兔 | 2024-05-07 08:55:55

赞

踩

CNN-BIGRU、CNN-BILSTM、CNN-GRU、CNN-LSSVM、CNN-LSTM、CNN-SVM

BIGRU(双向门控循环单元)、BILSTM(双向长短期记忆)、GRU(门控循环单元)、LSSVM(最小二乘支持向量机)、LSTM(长短期记忆)和SVM(支持向量机)这些模型,并将它们与CNN结合使用时,我们可以从以下几个关键方面来对比它们的结果:

-

CNN-BIGRU与CNN-BILSTM:

- 共同点:两者都是结合了CNN和RNN(或其变种)的混合模型,旨在同时捕捉数据的空间(局部)和时间(全局)特征。CNN部分用于提取空间特征,而BIGRU和BILSTM则用于处理序列数据中的长期依赖关系。

- 差异:BIGRU和BILSTM的主要区别在于它们处理序列数据的方式。BIGRU通过两个独立的GRU层(一个前向和一个后向)来处理序列,然后将这两个层的输出合并以获取双向信息。而BILSTM则使用了LSTM单元,它具有额外的“门”机制(如输入门、遗忘门和输出门),能够更好地控制信息的流动。因此,BILSTM在处理具有复杂时间依赖性的数据时可能更具优势。

-

CNN-GRU与CNN-LSTM:

- 共同点:与上述模型类似,CNN-GRU和CNN-LSTM也是结合了CNN和RNN变种的混合模型。CNN部分用于特征提取,而GRU和LSTM则用于处理序列数据。

- 差异:GRU是LSTM的简化版本,它只有两个门(更新门和重置门),因此具有更少的参数和更快的训练速度。然而,LSTM由于其额外的门机制,可能在处理具有较长序列和复杂时间依赖性的数据时表现更好。

-

CNN-LSSVM:

- 特点:LSSVM是SVM的一个变种,它通过最小二乘损失函数来替代传统的SVM损失函数,从而简化了计算并提高了训练速度。CNN-LSSVM结合了CNN的特征提取能力和LSSVM的分类或回归能力,适用于需要快速训练和准确预测的任务。

-

CNN-SVM:

- 特点:CNN-SVM结合了CNN在图像处理和特征提取方面的优势以及SVM在分类和回归方面的强大能力。CNN可以从原始数据中提取出有意义的特征,然后这些特征被送入SVM进行分类或回归。这种方法在处理图像和视觉相关任务时特别有效。

对比这些模型的结果时,需要考虑以下几个因素:

- 数据特性:不同的数据集具有不同的特性(如序列长度、复杂性、噪声水平等),这些因素会影响不同模型的表现。

- 任务需求:是分类任务还是回归任务?是否需要处理长序列?这些因素也会影响模型的选择。

- 性能指标:包括准确率、召回率、F1分数、训练时间、模型大小等。不同的模型可能在不同的性能指标上表现出优势。

-

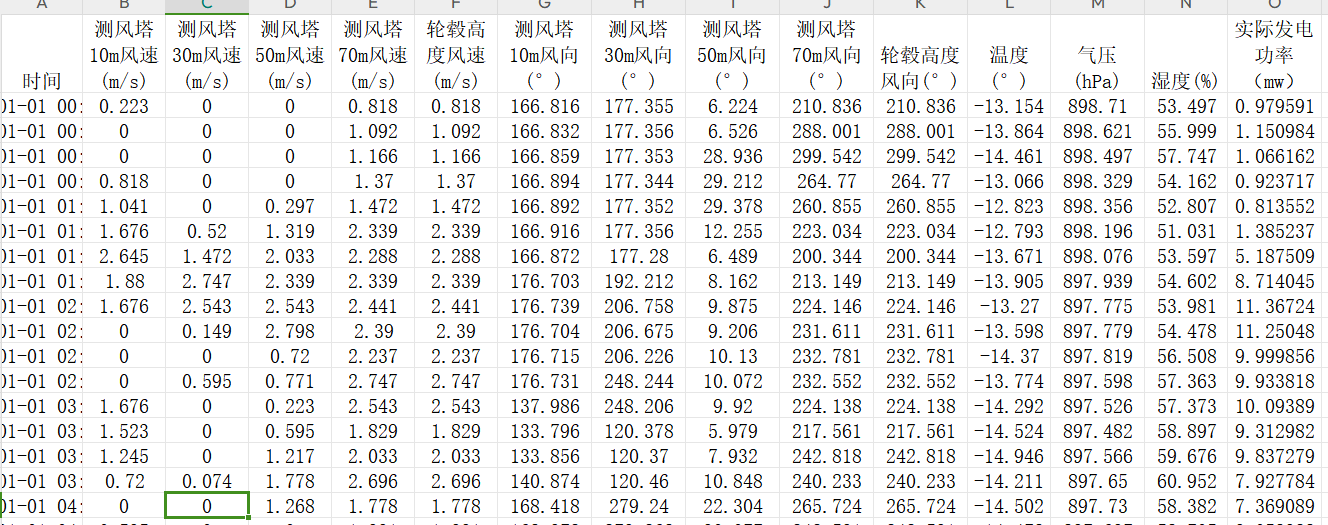

所采用数据集:

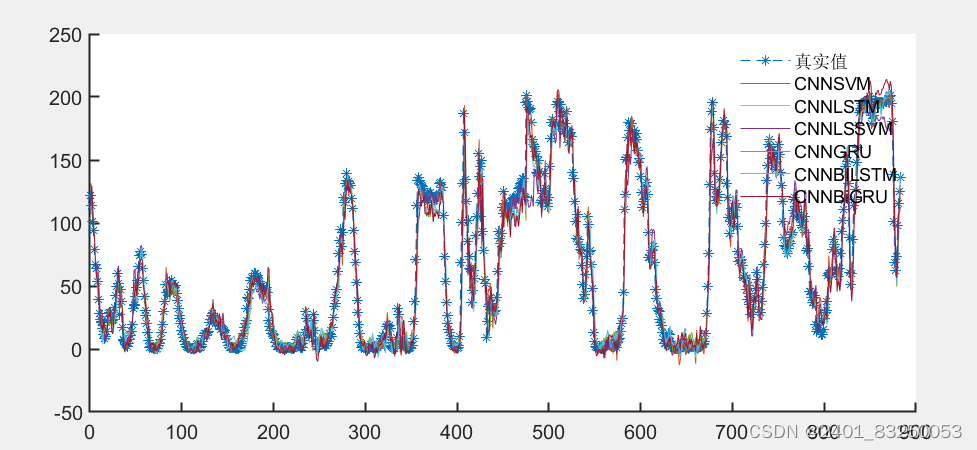

展示效果如下

-

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/盐析白兔/article/detail/548348

推荐阅读

相关标签