热门标签

热门文章

- 1项目中常用的 .env 文件原理源码分析_dify的.env文件

- 2【初阶数据结构】——单链表详解(C描述)_写出单链表数据元素类型为整数类型存储结构的c语言描述

- 3CMD设置代理 注册表设置IE代理_ie代理设置 cmd

- 4Windows系统安装Android SDK_android-sdk-windows

- 5关于从数据库读取来的数据,怎么引入Vue 组件_vue3数据库读取出来的地址怎么引入

- 6oracle 同一张表同时insert多条数据 mysql 同一张表同时insert多条数据

- 7李沐-动手学习深度学习v2_李沐动手学深度学习v2文字版

- 8Vue项目改index.html不生效的解决方法_vue2把访问index.html移到路径为public目录下

- 9八、SpringCloud-RabbitMQ + Spring AMQP 消息队列_rabbitmq 版本控制

- 10hadoop的50070端口不能访问网页的解决方法_hadoop01:50070

当前位置: article > 正文

使用llamafile 构建本地大模型运用

作者:盐析白兔 | 2024-05-19 22:18:49

赞

踩

llamafile

安装

https://github.com/Mozilla-Ocho/llamafile

下载

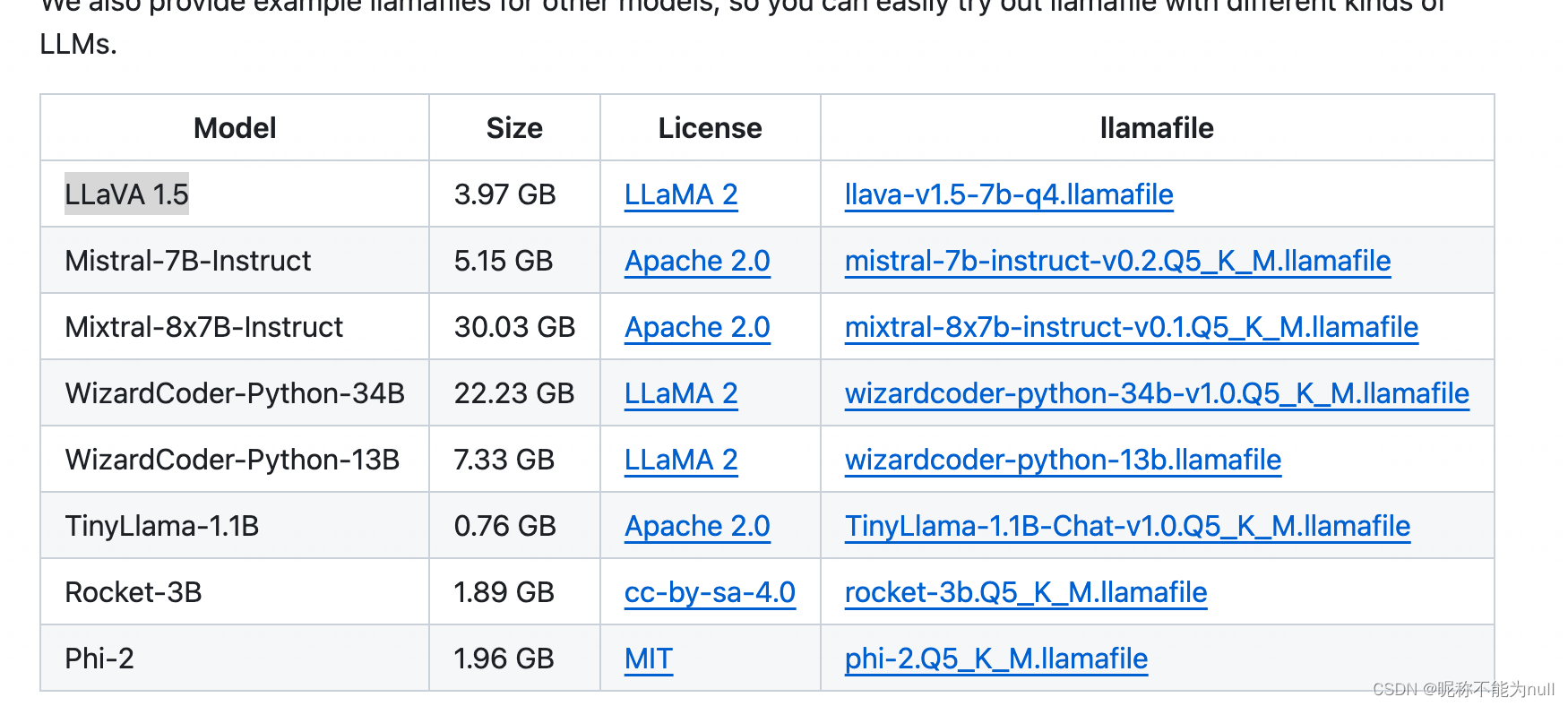

大模型文件,选择列表中任意一个

wget https://huggingface.co/jartine/llava-v1.5-7B-GGUF/resolve/main/llava-v1.5-7b-q4.llamafile?download=truehttps://github.com/Mozilla-Ocho/llamafile?tab=readme-ov-file#other-example-llamafiles

这里选择LLaVA 多模态的

使用

- chmod +x llava-v1.5-7b-q4.llamafile

- ./llava-v1.5-7b-q4.llamafile

-

- # --host xx.xx.xx.xx --port 8080

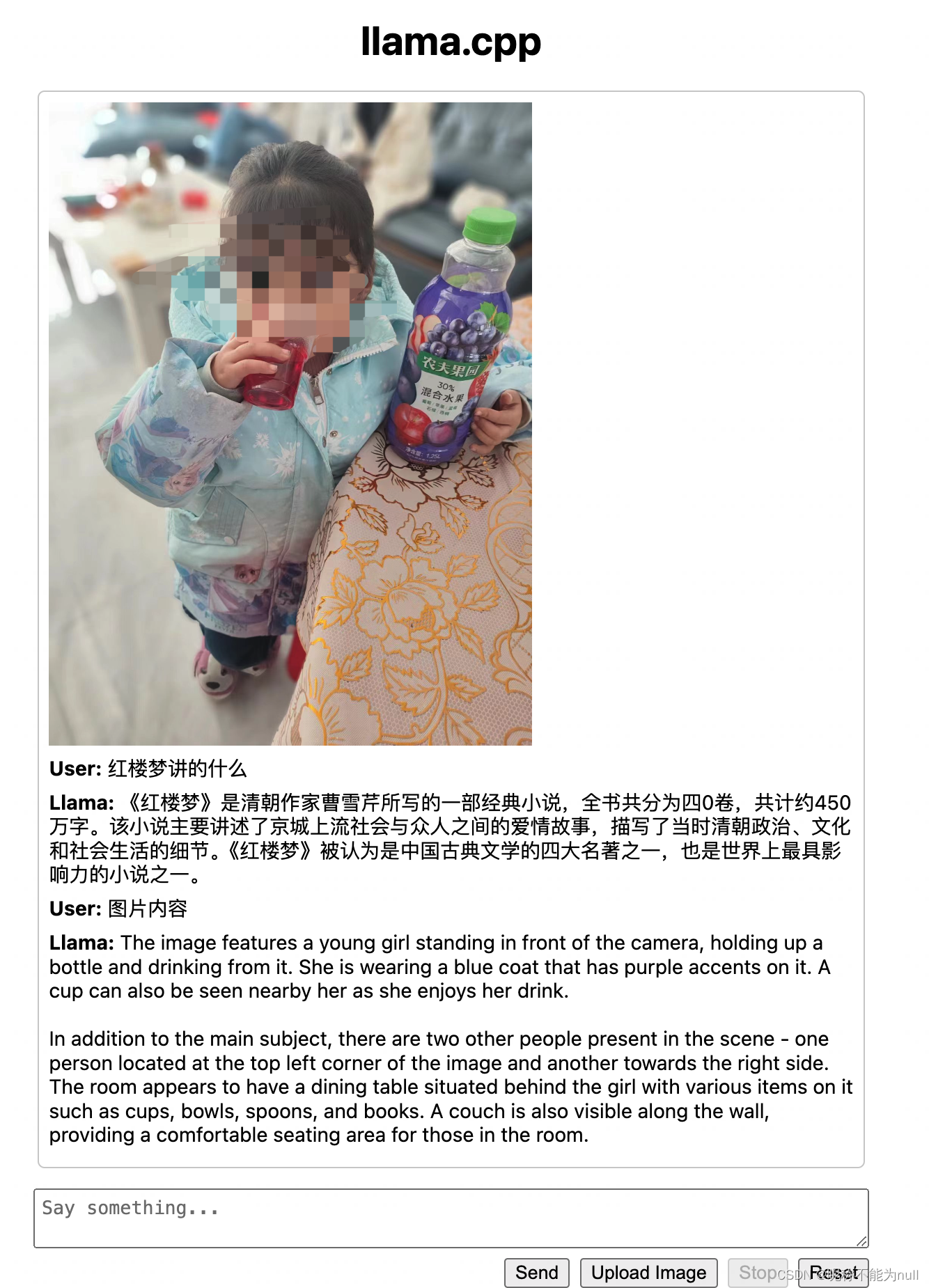

默认打开http://127.0.0.1:8080 即可开始对话

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/盐析白兔/article/detail/594885

推荐阅读

相关标签