- 1Apollo配置中心使用_apollo配置中心官方文档

- 2YOLOv10改进 | 注意力篇 | YOLOv10改进CA注意力机制_yolov10还需要改进的部分

- 3关于前端低代码的一些看法_前端要不要会低代码

- 4基于Xilinx器件的便携式FPGA万兆以太网TCP/IP协议栈,全面支持Server和Client模式,包含UDP功能_xilinx tcp ip socket

- 5Docker:网络配置_docker 设置网络

- 6liunx用户无法登录、SSH服务器拒绝了密码,但密码是正确的-全面解决无法登录问题_linux 登录last failed

- 7身为程序员的你,卷到最后剩下了什么?35岁从互联网大厂程序员转行成为一名网络安全工程师的心路历程_互联网大厂35岁以后

- 8[单向BFS][双向BFS]leetcode127:单词接龙(medium)_单词接龙 leetcode 双端bfs

- 9【Selenium+python】自动化测试登录界面_自动化测试登录页_selenium+python邮箱自动化测试遇到登陆安全界面如何处理

- 10时间序列预测必读的20篇论文!

教程:A5000 GPU 上运行阿里最新开源大模型 Qwen2_qwen2-7b gpu

赞

踩

这是我们新一篇关于大模型的文章,我们此前还讲过如何运行 LLama3 大模型。而这次,我们将使用 Ollama 运行阿里千问Qwen2:7b。要知道 Qwen2 可是目前最热门的开源大语言模型了,甚至在一些性能测试中比 LLama3 表现还突出。谁不想试试看呢?

在本文中,我们将使用目前市场上最热门的 GPU 之一,NVIDIA A5000。让 Qwen2 在这个 GPU 上运行起来!

基于Ampere架构构建的 A5000 ,是一款强大的 GPU,其性能被公认为能胜任 增强图形渲染、大模型训练和推理等工作。A5000 有 8192 个 CUDA 核心和 24GB 的 GDDR6 内存,并具备很强的计算能力和较高的内存带宽。

A5000 支持实时光线追踪、AI 增强型工作流程以及 NVIDIA 的 CUDA 和 Tensor 核心等高级功能,可提高性能。凭借其强大的功能,A5000 非常适合处理复杂的模拟、大规模数据分析和渲染高分辨率图形。

简单介绍下阿里 Qwen2-7b

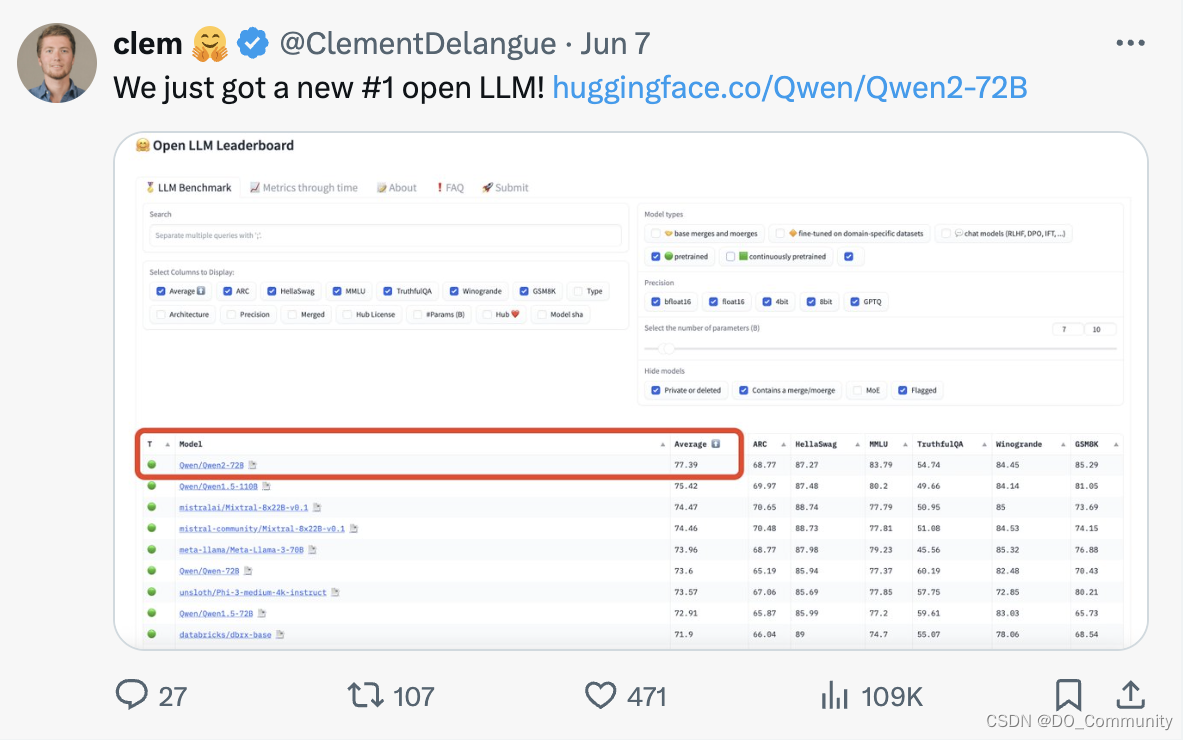

Qwen2 是阿里云最新推出的大语言模型系列,提供基础模型和指令调优版本,参数范围从 5 亿到 720 亿,其中包括一个 Mixture-of-Experts 模型。该模型已经在 Hugging Face 上开源了。而且开源后 Hugging Face 的联合创始人兼首席执行官就发文宣布,Qwen2-72B 冲上HuggingFace 开源大模型榜单 Open LLM Leaderboard 第一名,全球排名最高!

与其他开源模型如 Qwen1.5 相比,Qwen2在各种基准测试中通常表现更好,包括语言理解、生成、多语言能力、编码、数学和推理。Qwen2 系列基于 Transformer 架构,并具有如 SwiGLU 激活、注意力 QKV 偏差、组查询注意力和改进的分词器等增强功能,适用于多种语言和代码。

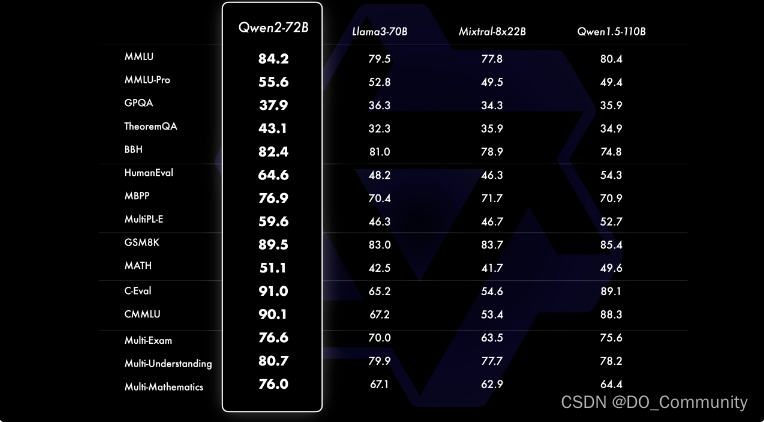

此外,据说 Qwen2-72B 在所有测试的基准测试中都以很大的优势超过了 Meta 的 Llama3-70B。

下面这张图显示了 Qwen2-72B 在各种基准测试中的性能,它在多个领域进行了 16 项基准测试的全面评估。这个模型在增强能力和与人类价值观的一致性之间取得了平衡。此外,该模型在所有基准测试中显著优于 Qwen1.5-72B-Chat,并与 Llama-3-70B-Instruct 相比甚至更胜一筹。即使是较小的 Qwen2 模型也超越了与之类似或更大的一些模型。Qwen2-7B-Instruct 在基准测试中“遥遥领先”,特别是在编码和与中文相关的指标上表现出色。

可用型号

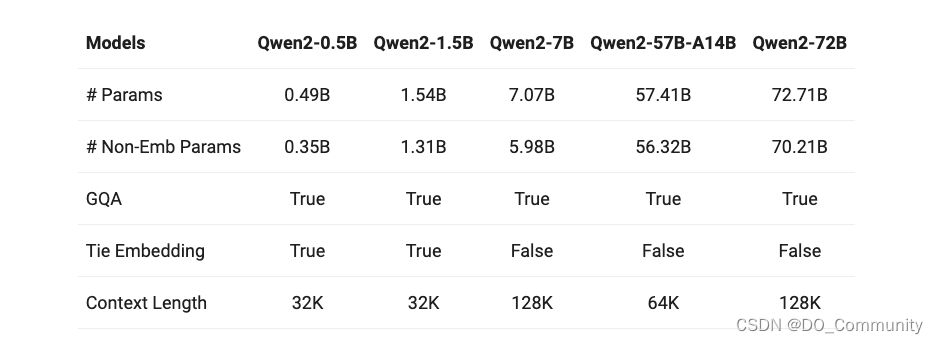

Qwen2 的训练涵盖了包括英语和中文在内的 29 种语言。它有五种参数大小:0.5B、1.5B、7B、57B 和 72B。7B 和72B 模型的上下文长度已扩展到 128k 个 token。

图:Qwen2系列包括五个不同大小的基础和指令调整模型

另一个要用到的开源项目 Ollama

本文将向你展示使用 Ollama 运行 Qwen2 的最简单方法。所以我们有必要给还未使用过 Ollama 的朋友们介绍一下它。

Ollama 是一个开源项目,提供了一个用户友好的平台,可以在你的电脑或使用 DigitalOcean Paperspace (GPU云服务)等平台上执行大语言模型(LLMs)。

Ollama 提供对各种预训练模型库的访问,可在多种不同的操作系统上轻松安装和配置,并公开本地 API 以无缝集成到应用程序和工作流程中。用户可以自定义和微调 LLM,通过硬件加速优化性能,并提供简单的交互界面以方便用户进行直观地交互操作。

另一个要使用到的平台 Paperspace

Paperspace 是 DigitalOcean(NYSE:DOCN)旗下的 GPU 云服务,为 AI 企业提供开发、训练、部署等一系列云计算服务。DigitalOcean 的 Paperspace 是 NVIDIA 官方 CSP 合作伙伴,提供了包括 H100、A100、A5000、A6000 等多种 GPU 资源。同时,DigitalOcean 的 GPU 云服务还提供了云端环境,开发者可以在云端训练、部署 AI 应用。DigitalOcean 还在中国地区通过独家战略合作伙伴卓普云,专门为中国地区的用户提供售前咨询与技术支持服务。

在成本上,DigitalOcean 的 GPU 价格比 AWS 和 GCP 更加亲民,而且卡型更加丰富。相对于 GPU 租赁平台,DigitalOcean 不仅技术与功能更加成熟可靠,而且提供较高的数据安全性。

本文后续的开发过程,就会用到 DigitalOcean 的 A5000 GPU 云服务。

使用 Ollama 在 Paperspace 上运行 Qwen2-7b

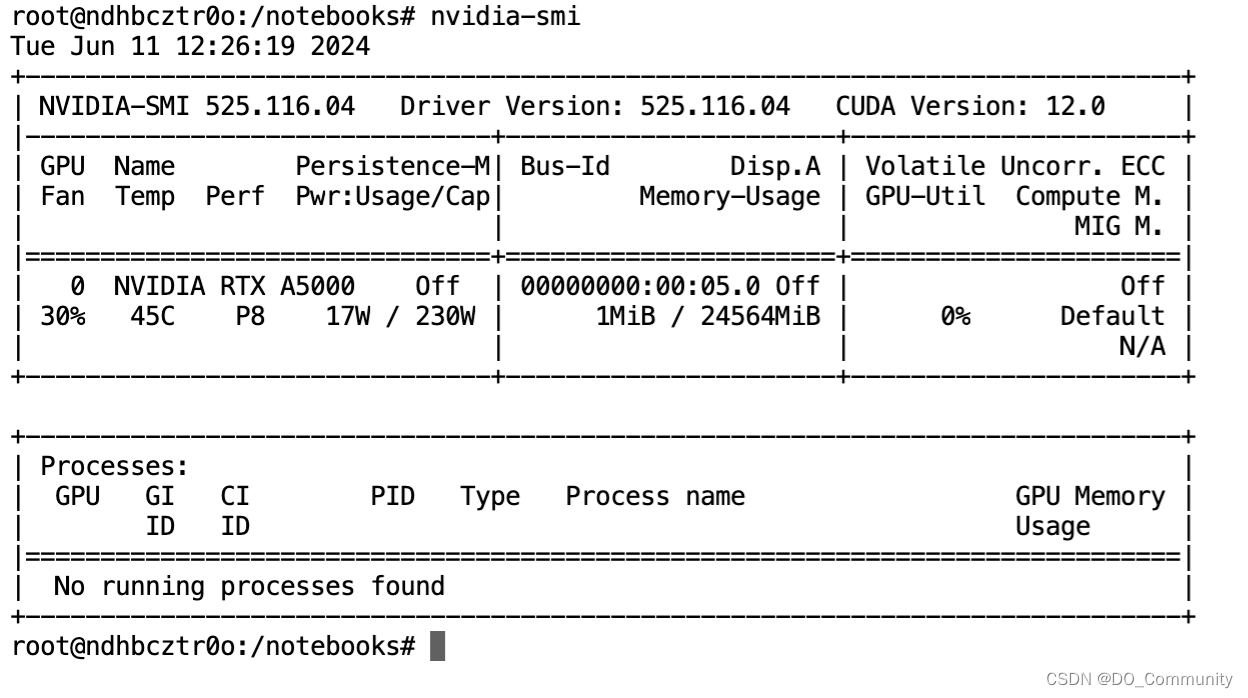

在我们开始之前,让我们首先检查 GPU 的规格。

nvidia-smi

图:显示 NVIDIA A5000 的规格

接下来,打开一个终端,我们将开始下载 Ollama。要下载 Ollama,请将以下代码粘贴到终端中,然后按 Enter。

curl -fsSL https://ollama.com/install.sh | sh

这一行代码将开始下载 Ollama。

完成此操作后,清空屏幕,输入以下命令并按回车来运行模型。

ollama run qwen2:7b如果遇到错误:无法连接到ollama应用程序,它是否正在运行?尝试运行以下代码,这将帮助启动ollama服务

ollama serve并打开另一个终端并再次尝试该命令。

或者尝试通过运行以下命令手动启用 systemctl 服务

sudo systemctl enable ollama sudo systemctl start ollama现在,我们可以运行模型了。

ollama run qwen2:7b

上图显示了在 Paperspace 中的实际运行过程。我们将下载模型的层。由于它是一个量化模型,所以下载过程不会花费太多时间。

接下来,我们将开始使用我们的模型回答一些问题,检查模型的工作方式。

-

编写一个 Python 代码来计算斐波那契数列

图:Qwen2:7b 模型生成的斐波那契的 Python 代码

你可以尝试一下该模型的其它版本,但 7b 是最新版本,并且是与 Ollama 一起提供的。

模型在各个方面都表现出色,与早期模型版本相比,它目前与 GPT 的整体性能相近。

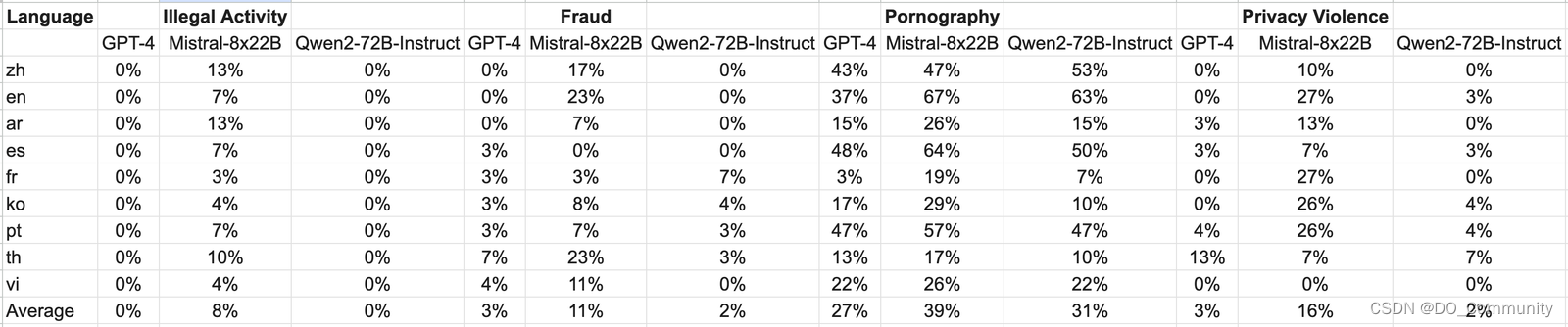

用于评估的测试数据来自 Jailbreak,并翻译成多种语言。值得注意的是,Llama-3 在多语言测试中表现不佳,因此被排除在此次比较之外了。研究结果表明,Qwen2-72B-Instruct 模型达到了与 GPT-4 相当的安全水平,并根据显著性检测(P值)显著优于 Mistral-8x22B 模型。

结论

总之,我们可以说 Qwen2-72B-Instruct 模型在各种基准测试中展示了其卓越的性能。特别是,Qwen2-72B-Instruct 超越了之前的版本,如 Qwen1.5-72B-Chat,并且与像 GPT-4 这样的最先进模型相比也毫不示弱,这一点通过显著性测试结果就能得到证明。此外,它在多语言环境中的安全性方面显著优于像 Mistral-8x22B 这样的模型。

大语言模型如 Qwen2 的使用的快速增长预示着一个未来,在这个未来中,人工智能驱动的应用程序和解决方案将变得越来越复杂。这些模型有潜力彻底改变包括自然语言理解、生成、多语言交流、编码、数学和推理在内的各个领域。随着这些模型的持续进步和改进,我们可以期待人工智能技术取得更大的飞跃,从而开发出更智能、更像人类的系统,更好地满足社会需求,同时遵守道德和安全标准。

希望你喜欢这篇文章!如果你希望利用 H100 或 A6000等型号的 GPU 进行推理或训练,欢迎尝试 DigitalOcean 的 GPU 云服务,如果希望咨询更详细的产品方案,可联系 DigitalOcean 中国区独家战略合作伙伴卓普云。

参考链接