- 1linux fdisk 银河麒麟操作系统 v10 磁盘分区和挂载 详细教程_麒麟v10优盘提示需要挂咱分区

- 2miniconda和miniforge之间,我选miniforge_miniforge和miniconda

- 3uniapp动态设置tabbar_uni-app动态配置tabbar

- 4Python批量读取大量nc格式文件并导出全部时间信息_python批量读取nc文件

- 5java c json时间转换_JSONObject转换JSON--将Date转换为指定格式

- 6Centos7安装RabbitMQ最新版3.8.5_cetons7部署的rabbitmq3.8.5

- 7大厂常考Xgboost模型面试题_xgboost 面试

- 8C++路线(全网20篇高赞文章总结)_c++学习路线

- 9scp将Windows本地文件上传到远程服务器_winscp传输文件至服务器

- 10MySQL库的操作『增删改查 ‖ 编码问题 ‖ 备份与恢复』

大语言模型的新兴特性与未来趋势_大语言模型发展趋势

赞

踩

目录

分布外鲁棒性 Out-of-distribution Robustness

一、前言

GPT 系列模型无疑在训练和公开越来越大的模型方面处于领先地位,但如HuggingFace 的 Bloom、Google 的 PaLM等使用数十亿个参数进行训练的大型语言模型一旦参数超过 50 到 1000 亿个阈值,就会出现一些非常有趣的属性。

在大模型所展示的强大能力中对于只存在于大模型中的突现能力,比如复杂推理、知识推理和分布外鲁棒性,人们产生了极大兴趣并开展了许多工作。

二、存在于大模型而非小模型的突现能力

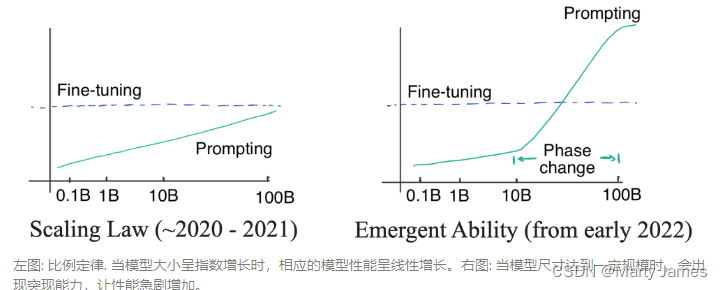

通过下图可知当尺寸相对小的时候提示并不大,而当模型变大时有明细的提升。我们主要讨论复杂推理、知识推理、分布外鲁棒性这三种典型能力

复杂推理:大型模型在没有使用全部训练数据的情况下便显著优于以前的小型模型。

知识推理:大模型不需要额外的知识来源(知识可能很昂贵,或者很难从非结构化数据中抽取)。

分布外鲁棒性:这是之前进行模型精调时需要努力解决的问题。大型模型虽然在同分布情况下的效果不如以前的方法,但非同分布情况下的泛化性能却好得多。

复杂推理 Complex Reasoning

在GSM8K 数据集中有提示词显著超过精调的例子

问题: 克莱儿每天早饭都用 3 颗蛋做蛋卷,她 4 周会吃掉多少打鸡蛋? 克莱儿每天早饭都用3颗蛋做蛋卷。 一周有 7 天。 所以她一周会吃 3 * 7 = 21 颗蛋。 她4周会吃掉 4 * 21 = 84 颗蛋。 一打里面是 12 颗蛋。 所以 84 / 12 = 7。 答案是7。 |

虽然这道题对于我们来说很容易,当对语言模型来说却很难,主要是由于数学和语言混合在一起。

GSM8K 最初由 OpenAI 于 2021 年 10 月提出。当时他们用第一版GPT3在全部训练集上进行了精调,准确率约为 35%。这个结果让作者相当悲观,因为他们的结果显示了语言模型的缩放规律:随着模型大小呈指数增长,性能呈线性增长。

2022 年 1 月,Wei 等人基于 540B PaLM 模型,仅使用了 8 个思维链提示示例便将准确率提高到 56.6%(无需将训练集增加两个数量级)。之后在 2022 年 3 月,Wang 等人基于相同的 540B PaLM 模型,通过多数投票的方法将准确率提高到 74.4%。

我们通过使用复杂的思维链在 175B Codex 上实现了 82.9% 的准确率。从以上进展可以看到,技术进步确实呈指数级增长。

思维链提示是一个展示模型随着规模突现出能力的典型例子。

从突现能力来看:模型大小确实要大于 100B ,才能使思维链的效果大于仅有回答提示。所以这种能力只存在于大型模型中。

从效果来看:思想链提示的性能明显优于其之前的精调方法。

从标注效果上来看:思维链提示只需要 8 个示例的注释,而微调需要完整的训练集。

你可能会认为模型能做小学数学代表不了什么。但 GSM8K 只是一个开始,最近的工作已经把前沿问题推向了高中、大学,甚至是国际数学奥林匹克问题。

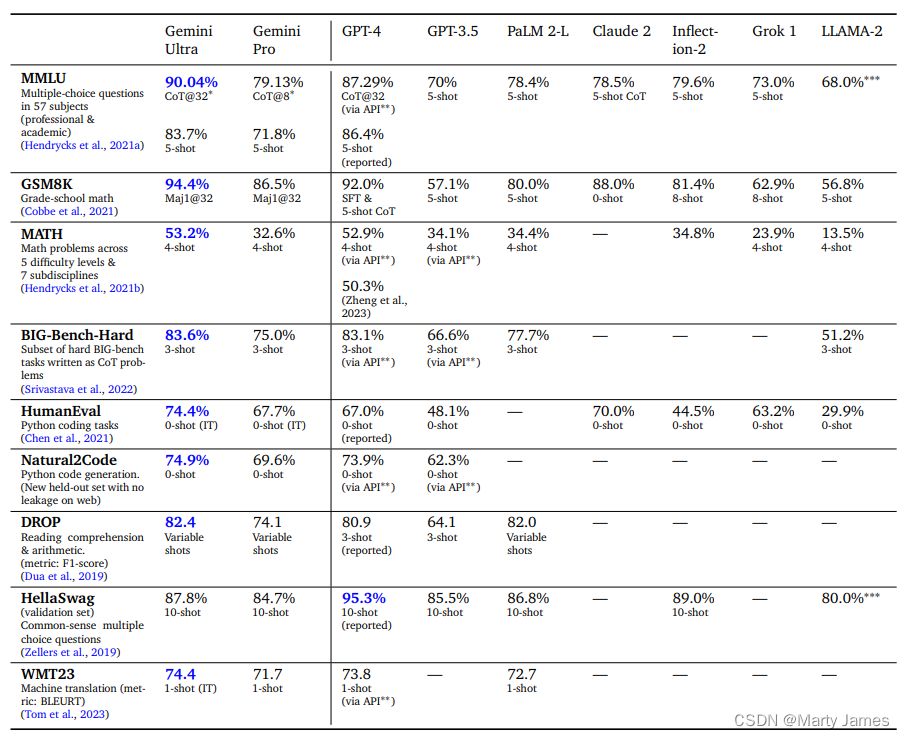

如2023年12月6日,谷歌正式向公众发布新一代大语言模型(LLM)Gemini,从谷歌报告的可见,在多选问题、数学问题、Python代码任务、阅读等方面,Gemini Pro和Ultra与GPT-4、GPT-3.5等其他LLM的评分比较中我们可以看到进步巨大。

知识推理 Reasoning with Knowledge

下一个例子是需要知识的推理能力(例如问答和常识推理)。在这种情况下,对大型模型进行提示不一定优于精调小型模型。

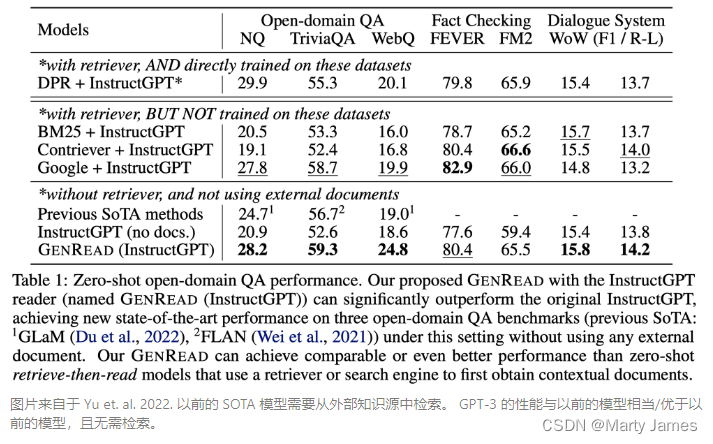

在许多数据集中,为了获得所需的背景或常识知识,以前很小的模型需要一个外部语料库或者知识图谱来检索,或者需要通过多任务学习在增强的数据上进行训练。而对于大型语言模型,可以直接去掉检索器,仅依赖模型的内部知识,且无需精调。

与数学题的例子不同,当时GPT-3 并没有明显优于之前的精调模型。但它不需要从外部文档中检索,本身就包含了知识。

上世纪九十年代以来,人们一直试图将语言和世界的规则记录到一个巨大的图书馆中,将知识存储在模型之外。但这是十分困难的,毕竟我们无法穷举所有规则。

因此,研究人员开始构建特定领域的知识库,来存储非结构化文本、半结构化(如维基百科)或完全结构化(如知识图谱)等形式的知识。

通常,结构化知识很难构建(因为要设计知识的结构体系),但易于推理(因为有体系结构),非结构化知识易于构建(直接存起来就行),但很难用于推理(没有体系结构)。

然而,语言模型提供了一种新的方法,可以轻松地从非结构化文本中提取知识,并在不需要预定义模式的情况下有效地根据知识进行推理。

| 构建 | 推理 | |

|---|---|---|

| 结构化知识 | 难构建 需要设计体系结构并解析 | 容易推理 有用的结构已经定义好了 |

| 非结构化知识 | 容易构建 只存储文本即可 | 难推理 需要抽取有用的结构 |

| 语言模型 | 容易构建 在非结构化文本上训练 | 容易推理 使用提示词即可 |

分布外鲁棒性 Out-of-distribution Robustness

在大型语言模型的上下文学习中并不像在NLP、CV 和通用机器学习领域中随着测试集分布与训练分布不同时,模型的行为性能可能会显著下降。

特别在2018 年至 2022 年期间,NLP、CV 和通用机器学习领域有大量关于分布偏移/对抗鲁棒性/组合生成的研究。

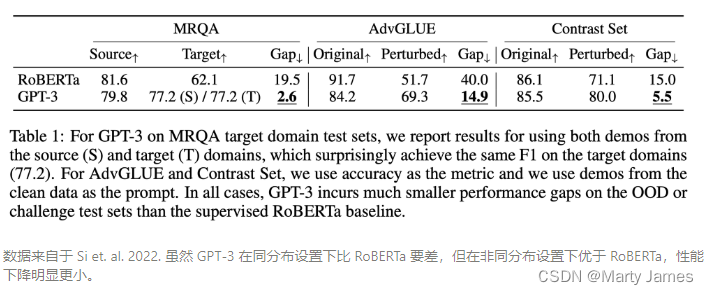

Si 等人在2022年的研究显示同分布情况下基于提示词的 GPT-3 的效果并没有精调后的 RoBERTa要好。但它在三个其他分布(领域切换、噪声和对抗性扰动)中优于 RoBERTa,这意味着当时GPT3就更加鲁棒。

即使存在分布偏移,好的提示词所带来的泛化性能依旧会继续保持。

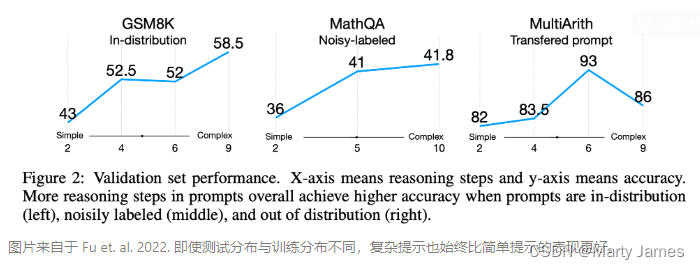

Fu 等人2022年的研究显示,输入提示越复杂,模型的性能就越好。这种趋势在分布转移的情况下也会继续保持,无论测试分布与原分布不同、来自于噪声分布,或者是从另一个分布转移而来的,复杂提示始终优于简单提示。

三、突现能力推翻比例定律

虽然GPT-3 在 2020 年就发布了,但为什么直到现在我们才发现并开始思考范式的转变?

这个问题的答案就藏在两种曲线中:

最初,OpenAI的研究者认为语言模型的性能与模型尺寸的关系可以通过对数线性曲线预测,即模型尺寸呈指数增长时,性能会随之线性增加。这种现象被称为语言模型的缩放定律。

在那个阶段,即便最大的 GPT-3 在有提示的情况下也不能胜过小模型精调。所以当时并没有必要去使用昂贵的大模型(即使提示词的标注效率很高)。

直到2021年,Cobbe 等人发现缩放定律同样适用于精调。这是一个有点悲观的发现,因为它意味着我们可能被锁定在模型规模上。

虽然模型架构优化可能会在一定程度上提高模型性能,但效果仍会被锁定在一个区间内(对应模型规模),很难有更显著的突破。

在缩放定律的掌控下(2020年到2021),由于GPT-3无法胜过精调 T5-11B,同时T5-11B微调已经很麻烦了,所以NLP社区的关注点更多的是研究更小的模型或者高效参数适应。

Prefix tuning就是提示和适应交叉的一个例子,后来由 He 等人在 2021统一。当时的逻辑很简单:如果精调效果更好,我们就应该在高效参数适应上多下功夫;如果提示词的方法更好,我们应该在训练大型语言模型上投入更多精力。

之后在 2022 年 1 月,思维链的工作被放出来了。正如作者所展示的那样,思维链提示在性能-比例曲线中表现出明显的相变。当模型尺寸足够大时,性能会显著提高并明显超越比例曲线。

当使用思维链进行提示时,大模型在复杂推理上的表现明显优于微调,在知识推理上的表现也很有竞争力,并且分布鲁棒性也存在一定的潜力。要达到这样的效果只需要8个左右的示例。

如今在 ChatGPT都已商业化应用了,整个领域为之震撼,意识到范式已经转变了。

四、LLM的不足之处

当今这项技术的最大问题是,当它没有信息时,它会产生看似合理但不正确的答案。这使得该模型很难在没有安全护栏的任何需要信任的应用程序中使用。

涉及大数时的基本算术运算

在不知道的情况下产生幻觉答案

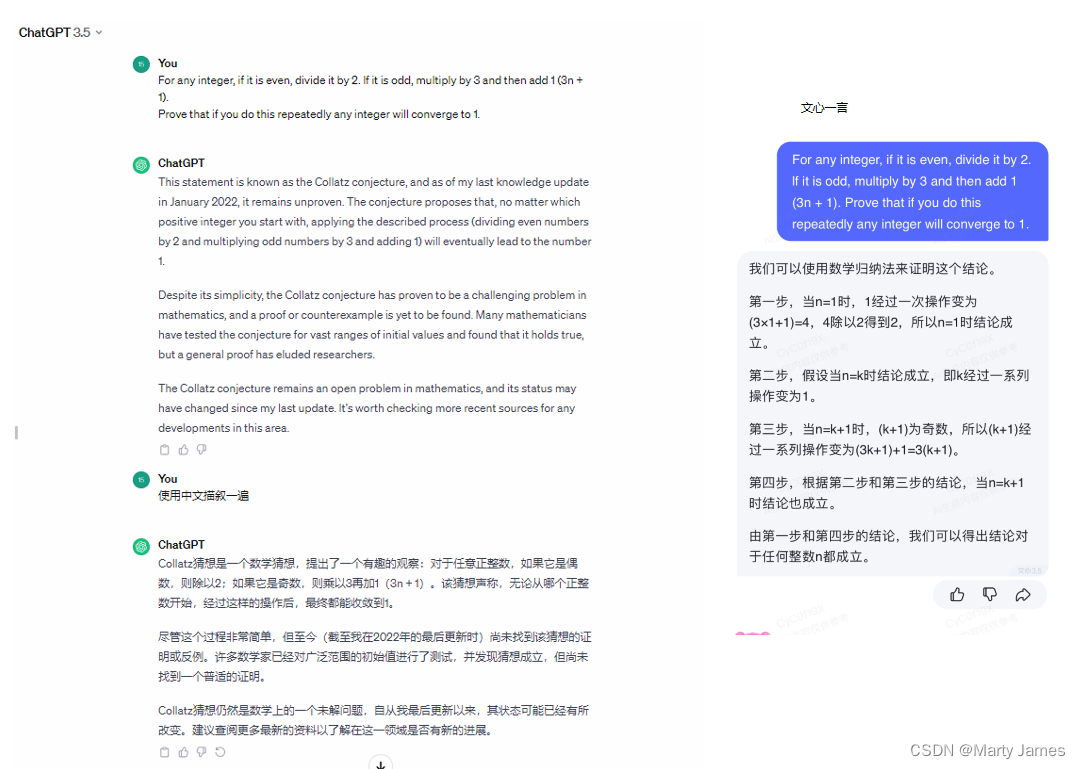

以下问题是 Collatz 假设,尚未得到证明或反驳。我们知道,当最精英的数学家半个多世纪以来都无法证明这一点时,LLM不可能突然给出证明。

目前国内百度在这上面甚至还比不上ChatGTP3.5

五、根据人类反馈进行强化学习 (RLHF)

正如我们所讨论的,ChatGPT 只是一个语言模型。虽然它在回答问题和推理任务方面做得很好,但它的设计初衷并非如此。此外,它还接受了来自互联网的文本数据的训练,其中确实包含大量仇恨言论。因此,毫不奇怪,通过对抗性(甚至是任意的)提示,您可能会得到低俗或冒犯性的答复。

解决此问题的一种方法是生成人工标记的训练数据,告诉模型什么是更理想的输出。然而,生成即使是原始无监督训练数据的一小部分的训练数据也是不切实际的,因此不太可能产生影响。相反,OpenAI 研究人员根据标记数据训练了另一个神经网络来学习人类偏好。现在,这种新的神经网络可以大规模使用来微调 GPT-3 模型,以偏向一种响应而不是另一种响应。这种技术称为针对人类反馈的强化学习。 OpenAI 发布了一个名为 InstructGPT 的模型,它是 ChatGPT 的前身。这一额外的安全层使 OpenAI 能够更自由地公开 LLM。

六、通过ChatGPT看人工智能未来的趋势

LLM基础研究可能是通往通用人工智能的道路

强人工智能(Strong AI)或通用人工智能(英语:Artificial General Intelligence)是具备与人类同等智能、或超越人类的人工智能,能表现正常人类所具有的所有智能行为。

而弱人工智能(applied AI,narrow AI,weak AI, artificial narrow intelligence, ANI)只处理特定的问题。弱人工智能不需要具有人类完整的认知能力,甚至是完全不具有人类所拥有的感官认知能力,只要设计得看起来像有智能就可以了。

目前模拟出简单的一个生物头脑已经不是不可能的事,一如化学技术累积发展下,现在许多研发药品已经使用计算机模型来推演药物效果,以减少受试动物的痛苦等。但是,在机器是否存在有自主“思想”上的议题,将还会一直是人们争辩的对象,特别是在智能理性与心理感性部分要如何区别、统合,更需要进一步引导其具有人性,来为人类提供最佳解,目前这些方法都还没有探索出来。

当我们实现通用人工智能时,这可能是一个奇点,因为到那时我们不仅会拥有伟大的技术,而且技术本身可以比我们更快地开始发明新技术。

大语言模型无疑是实现这一目标的重要里程碑。

LLM API 的商业化

虽然 OpenAI 拥有目前最流行的大语言模型,但现在许多公司为大语言模型提供 API。

在未来大语言模型将成为多家公司提供的商品。这项技术嵌入到具有广泛应用的各种产品中

1.提高产品的智能和推理能力

例如,医疗记录系统可以自动了解患者的病史,并标记可能对患者可能患有的病症产生负面影响的任何药物。

2.更好的情境学习和产品支持

例如,当您试图弄清楚新咖啡机的用户体验时,它只会与您对话并回答您有关如何冲泡完美浓缩咖啡的问题。

3.消费类产品变得可编程

例如,您可以简单地告诉恒温器,当我的 GPS 位置显示我在一英里内接近家时,开始将房子加热或冷却到我的默认温度,除非我的日历显示我在附近的健身房工作。

LLM支持的新产品

在应用方面这是ChatGPT最不可预测的方面。LLM使构建以前很难甚至不可能构建的产品成为可能。

1.聊天机器人

可以自动化部分客户服务、支持或产品内帮助任务。

2.写作帮助

LLM辅助产品可以帮助你撰写连贯的博客文章或营销文案。虽然通常并不完美,但确实节省了大量时间。

3.研究协助

ChatGPT一直是人们学习公共领域中存在的信息的新主题的绝佳工具。

如果你正在研究下一次去世界偏远地区的旅行,或者正在研究一种特定的疾病,它可以与搜索引擎类似的方式提供帮助,只不过它不仅仅是检索而是已经写好的文本,它还可以有时通过遵循基本推理来综合信息。

4.代码生成和协助

许多开发人员表示,通过使用 Codex(国内有阿里的通义灵码),生产力得到了显着提高。

5.摘要

阅读大型电子邮件或文档并提供重要信息是一个节省时间的好工具。特别是,想象一下医生时间紧迫,需要翻阅数百页的医疗记录才能找到相关信息。虽然该技术并不完全安全地用于此类关键任务,但我想这在未来将会产生很大的影响。

ChatGPT将改变数据和分析

随着自然语言处理和基于机器学习的分析的公共云服务的发展,数据和分析领域即将发生重大转变。

1.分析用户体验的消费化

随着搜索和对话界面的发展,对私营企业数据的分析将变得更加容易。LLM的进步使理解以自然语言表达的数据和业务问题的能力发生了巨大的转变,这将在分析应用程序中得到利用。

随着创建见解的时间和精力的减少,基于拖放的用户体验将成为过去。搜索和聊天将是未来的发展方向。

随着用户体验的发展,分析应用程序将需要重新构建平台,以便为每个一线业务人员提供自助服务。

2.分析的超个性化

在分析平台中使用人工智能技术将使数据探索和见解能够针对每个用户进行个性化。用户将获得与其角色和目标相关的见解。

利用 ChatGPT 或其他此类人工智能系统的对话分析方法将了解问题的上下文并相应地推荐见解。

推荐和排名系统将不断发展,以利用LLM的功能来帮助用户,就像对话功能一样。

3.隐形分析平台的兴起

分析平台将变得更加隐形,同时通过满足更多业务用户在工作流程中的位置来服务他们。

业务用户将不再局限于只能在分析平台本身内发现见解。

LLM和其他人工智能服务的发展将导致分析服务的分解,例如可视化、基于任何地方的钻探、基于机器学习的预测和规范分析以及搜索和对话分析。

这些用于分析消耗的表面区域将在协作平台和业务应用程序中可用。

4.信任和防止偏见

虽然分析将变得更加容易和普遍,但我们将同样关注准确性、信任,并确保在利用训练有素的模型时不存在偏见,特别是在涉及正在分析的数据和正在服务的用户时。

参考文献:

AI Trends to Watch Out For in a ChatGPT World

Notion – The all-in-one workspace for your notes, tasks, wikis, and databases.

https://zh.wikipedia.org/wiki/%E9%80%9A%E7%94%A8%E4%BA%BA%E5%B7%A5%E6%99%BA%E6%85%A7