热门标签

热门文章

- 1Presto 中 lookUp Join的实现_presto getoutputcalls

- 2html读取csv文件,javaScript读取.csv文件或.xlsx文件

- 3《童虎学习笔记》9分钟学会mysqldump备份及恢复

- 4Word中插入MATLAB矢量图_word插matlab矢量图

- 5Qt | 标准、复选、单选、工具、命令按钮大全

- 6Yolov8工业缺陷检测:基于铝片表面的缺陷检测算法,VanillaBlock和MobileViTAttention助力检测,实现暴力涨点 |2023最新成果,创新度很强_yolov8缺陷检测

- 7NLP(10)--TFIDF优劣势及其应用Demo

- 8Java后台+PDF.js 实现pdf分页加载的后端实现_js pdf自动分页

- 9Path had bad ownership/permissions

- 102022年各国程序员薪资排名!

当前位置: article > 正文

【Python_005】利用jieba及wordcloud生成词频及词云图_wordcloud jieba

作者:知新_RL | 2024-05-19 05:43:03

赞

踩

wordcloud jieba

词云图在数据分析中是比较常见的可视化操作,尤其在做定性分析时,通过词云图展示对某件产品或某个现象讨论最热的词,直观又好看

词频

生成词云图之前首先要确定各个词的词频,从而知道每个词的热门程度及后续在词云中不同大小的展示(词频即每个词出现的频率)

如何计算词频呢?

下面就需要介绍一个第三方库:jieba (没错,就是你想的那个结巴。。。

jieba库:做最好的 Python 中文分词组件

Github官方文档

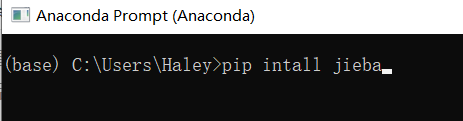

安装jieba

我用的是anaconda,比较方便。

直接打开anaconda promot, 输入 pip install jieba 就可

验证一下是否安装成功:

打开pycharm -> File -> Setting -> Project Interpreter

在列表中看到jieba库就说明安装成功了,如图:

jieba 切词

共有三种模式:

- 搜索引擎模式

- 全模式

- 精确模式

个人认为三种模式中精确模式最好用,最适合用来文本分析。

用我大《三体》来举个例子嘎嘎嘎

import jieba

str = '斩尽杀绝,这是对一个文明的最高重视'

'''

精确模式效果在一般情况下 效果最好

jieba.cut() 生成 generator,需要for loop 返回里面的每一个词

jieba.lcut() 生成list

'''

seg_list_search = jieba.cut_for_search(str) # 搜索引擎模式

seg_list1 = jieba.cut(str, cut_all = True) #全模式

seg_list2 = jieba.cut(str, cut_all = False) #精确模式, 默认为精确, cut_all=False 可缺省

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/知新_RL/article/detail/591696

推荐阅读

相关标签