热门标签

热门文章

- 1互联网35岁会被清退,这可能是2023年最大的谎言

- 2AP Autosar平台设计 13 更新和配置管理 Update and Config Management_ap autosar的ucm master和ucm

- 3Llama 3 五一超级课堂中实践llama3的部署,微调,量化优化部署学习总结:第二部分基于自我认知数据,使用XTuner 微调 Llama3-8b模型_llama3 微调 量化

- 4Git学习之添加远程仓库

- 5maven中如何忽略单元测试中的错误继续构建工程_-dmaven.test.failure.ignore=true

- 6网络编程基础(四)

- 7【正点原子Linux连载】 第四十章 Linux网络驱动实验 摘自【正点原子】ATK-DLRK3568嵌入式Linux驱动开发指南_yt8531c datasheet

- 8德人合科技-天锐绿盾 |-solidworks、cad、UG、proe/creo、CATIA、Cimatron、Marstercam、3DSMAX图纸加密

- 9关于 Appium 运行时报错:ValueError: Timeout value connect was <object object at 0x000001FE483C4170>的解决办法。_pip install appium-python-client报错

- 10网络防御-内容安全_深度数据包检测

当前位置: article > 正文

Langchain-chatchat本地部署_langchain-chatchat 本地 部署

作者:知新_RL | 2024-06-04 12:15:15

赞

踩

langchain-chatchat 本地 部署

前言

LangChain是一个用于开发由语言模型支持的应用程序的框架。它使应用程序能够:

-

具有上下文感知能力:将语言模型连接到上下文源(提示说明、一些镜头示例、响应的内容等)

-

Reason:依靠语言模型进行推理(关于如何根据提供的上下文回答、采取什么操作等)

LangChain-Chatchat(原 Langchain-ChatGLM)

基于ChatGLM等大语言模型与Langchain等应用框架实现,开源、可离线部署的搜索增强生成(RAG)大模型知识库项目。

本文介绍记录本地构建LangChain-Chatchat应用。

1.创建langchain虚拟环境

conda create -n langchain python==3.8.13

- 1

2.拉取代码仓库

git clone https://github.com/chatchat-space/Langchain-Chatchat.git

- 1

3.进入代码仓库目录,安装所需依赖

pip install -r requirements.txt

pip install -r requirements_api.txt

pip install -r requirements_webui.txt

- 1

- 2

- 3

4.首先将项目所需的模型下载至本地,通常是开源LLM 与 Embedding 模型可以从HuggingFace下载。

使用LLM模型THUDM/ChatGLM3-6B与Embedding模型BAAI/bge-large-zh为例:

5.初始化知识库和配置文件

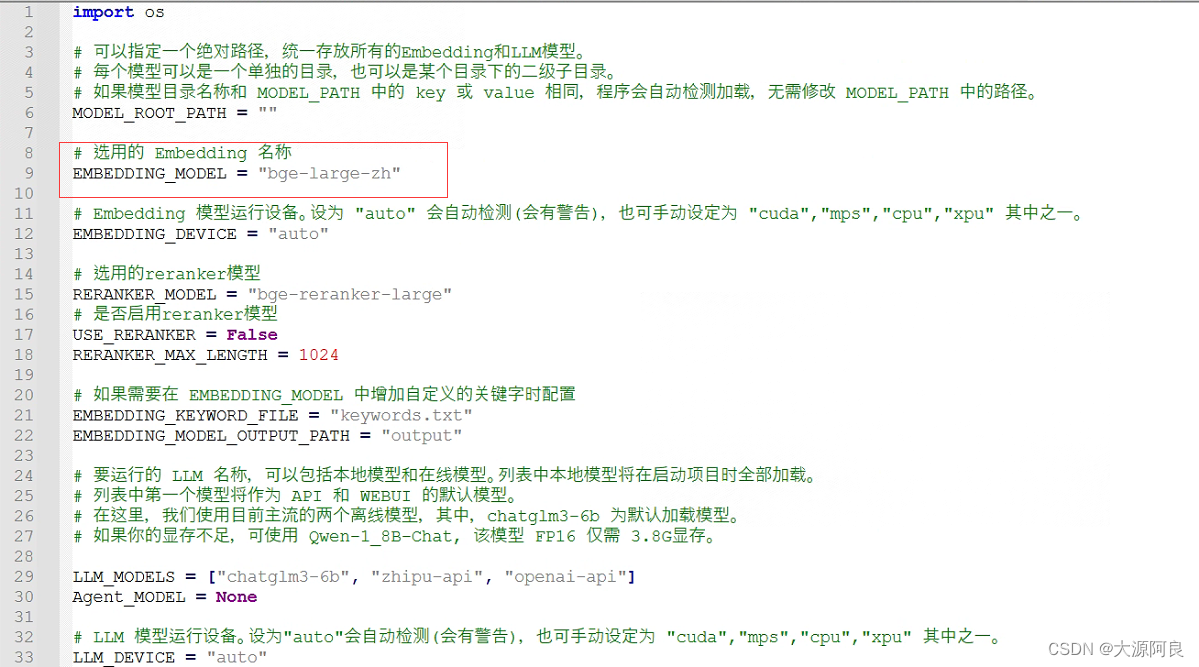

使用了本地模型需要更改configs/model.config文件相应绝对路径:

python copy_config_example.py

python init_database.py --recreate-vs

- 1

- 2

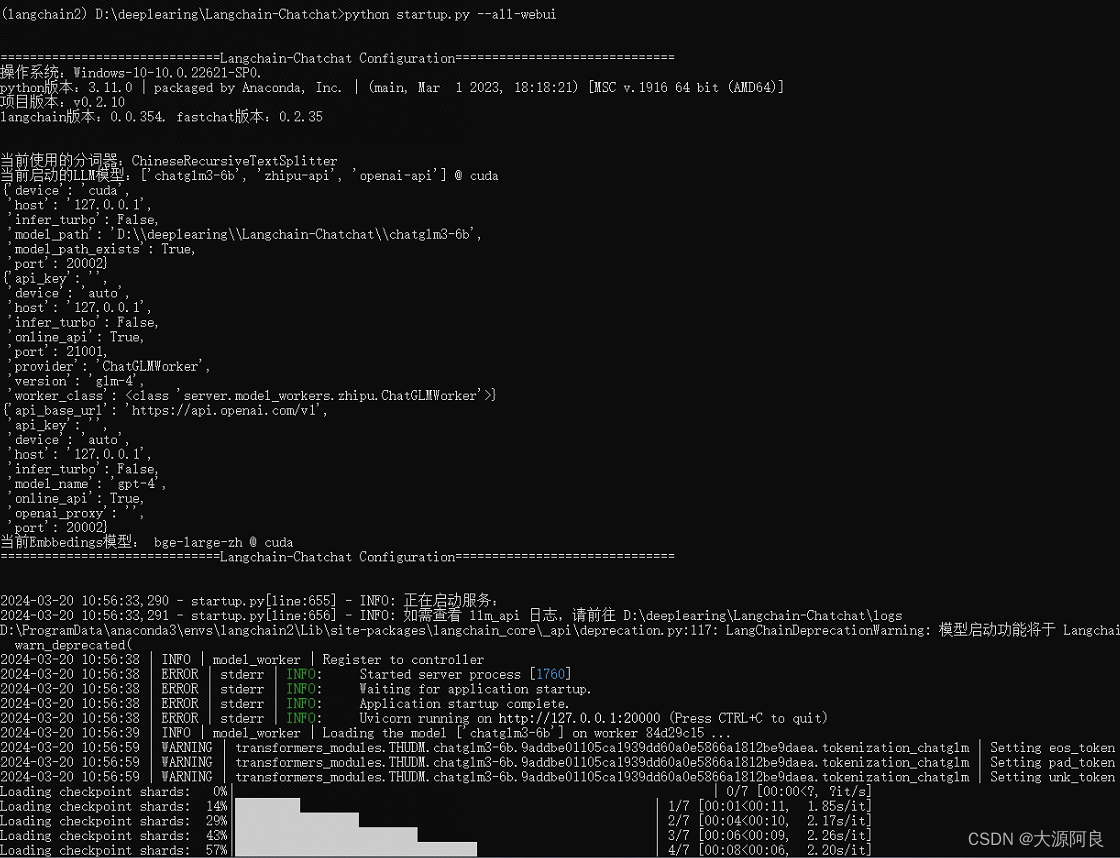

6.按照以下命令启动项目

(注意启动前关闭科学上网工具)

python startup.py -a

- 1

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/知新_RL/article/detail/671807

推荐阅读

相关标签