- 1Facebook如何引流独立站,有哪些策略?

- 2粉丝投稿,分享自己的哔哩哔哩四面总结,以及个人总结的一些面试真题。_b站4面

- 3什么是VRRP?_vrrp是什么

- 4在 VS Code 中使用版本控制_vscode merge changes

- 5主流开源 BI 产品对比---------2020开源BI工具都有哪些,哪个好用_开源bi有哪些

- 6R语言中使用colSums函数对矩阵或数据框的列进行求和

- 7基于模板匹配的手写字体数字识别-含Matlab代码_基于模板的手写数字识别

- 8postman 测试接口报错401_postman 401

- 9ubuntu+docker+pycharm环境深度学习远程炼丹使用教程_pycharm使用docker ubuntu配置python环境

- 10头歌python实训通关四——循环结构_头歌课程怎么样算通关

【xinference】(8):在autodl上,使用xinference部署qwen1.5大模型,速度特别快,同时还支持函数调用,测试成功!

赞

踩

1,关于xinference

https://www.bilibili.com/video/BV14x421U74t/

【xinference】(8):在autodl上,使用xinference部署qwen1.5大模型,速度特别快,同时还支持函数调用,测试成功!

Xorbits Inference (Xinference) 是一个开源平台,用于简化各种 AI 模型的运行和集成。借助 Xinference,您可以使用任何开源 LLM、嵌入模型和多模态模型在云端或本地环境中运行推理,并创建强大的 AI 应用。

Xorbits Inference(Xinference)是一个性能强大且功能全面的分布式推理框架。可用于大语言模型(LLM),语音识别模型,多模态模型等各种模型的推理。通过 Xorbits Inference,你可以轻松地一键部署你自己的模型或内置的前沿开源模型。无论你是研究者,开发者,或是数据科学家,都可以通过 Xorbits Inference 与最前沿的 AI 模型,发掘更多可能。

官方网站:

https://inference.readthedocs.io/zh-cn/latest/index.html

启动Xinference服务

https://gitee.com/fly-llm/xinference-run-llm

项目地址:

https://github.com/xorbitsai/inference

2,安装qwen 1.5 大模型

发现代码已经支持啦:

https://github.com/xorbitsai/inference/pull/1161

{

"model_format": "awq",

"model_size_in_billions": "0_5",

"quantizations": [

"Int4"

],

"model_id": "Qwen/Qwen1.5-0.5B-Chat-AWQ"

},

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

然后就可以查看全部支持的模型进行启动

2024-04-02 22:51:48,866 xinference.model.llm.llm_family 1358 INFO Caching from Modelscope: qwen/Qwen1.5-0.5B-Chat-AWQ

2024-04-02 22:51:48,982 - modelscope - INFO - PyTorch version 2.1.2+cu121 Found.

2024-04-02 22:51:48,984 - modelscope - INFO - Loading ast index from /root/autodl-tmp/modelscope/ast_indexer

2024-04-02 22:51:49,301 - modelscope - INFO - Loading done! Current index file version is 1.13.3, with md5 2ce72687914bb920fc5ddbea16bddaae and a total number of 972 components indexed

Downloading: 100%|████████████████████████████████████████████████████████████████████████████████████████| 839/839 [00:00<00:00, 287kB/s]

Downloading: 100%|█████████████████████████████████████████████████████████████████████████████████████| 52.0/52.0 [00:00<00:00, 39.5kB/s]

Downloading: 100%|████████████████████████████████████████████████████████████████████████████████████████| 205/205 [00:00<00:00, 158kB/s]

Downloading: 100%|████████████████████████████████████████████████████████████████████████████████████| 7.11k/7.11k [00:00<00:00, 255kB/s]

Downloading: 100%|███████████████████████████████████████████████████████████████████████████████████| 1.59M/1.59M [00:00<00:00, 6.58MB/s]

Downloading: 0%| | 0.00/747M [00:00<?, ?B/s]

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

可以进行下载,说明模型已经支持了:

curl -X 'POST' 'http://0.0.0.0:9997/v1/chat/completions' \

-H 'Content-Type: application/json' \

-d '{

"model": "qwen-chat",

"messages": [

{

"role": "user",

"content": "北京景点"

}

],

"max_tokens": 512,

"temperature": 0.7

}'

{"id":"chatc043f510-f100-11ee-b0dc-0242ac110004","object":"chat.completion","created":1712069603,"model":"qwen1.5-chat","choices":[{"index":0,"message":{"role":"assistant","content":"北京是中国的首都,拥有众多的文化遗产和风景名胜。以下是一些热门的北京景点:\n\n1. 故宫:故宫是中国明清两代的宫殿,被誉为“皇家的后宫”。这里有大量的宫殿、文物和艺术品,是了解中国古代建筑艺术的最好地方。\n\n2. 二里头:二里头是北京的一条历史悠久的街道,有许多保存完好的古建筑和商店。这里的建筑风格独特,充满了历史韵味。\n\n3. 颐和园:颐和园是清朝皇家园林的瑰宝,也是世界文化遗产。这里有大量古建筑和园林艺术,是了解中国古代园林艺术的好地方。\n\n4. 淮河风光:北京的淮河风光是北京市的标志之一,也是中国最美的风景之一。这里有众多的河流风光,是骑行和步行的好地方。\n\n5. 颐和园荷花:颐和园的荷花是皇家园林的代表,也是中国最美的风景之一。这里有众多的荷花,是观赏荷花的好地方。\n\n6. 人民英雄纪念碑:人民英雄纪念碑是北京的标志性建筑,是展示中国历史和人民英雄的重要场所。\n\n7. 北京动物园:北京动物园是世界上最大的动物保护基地,也是北京的一道亮丽的风景线。这里有众多的动物,是了解动物保护的重要场所。\n\n以上是一些在北京的主要景点,还有许多其他的景点等待游客探索。"},"finish_reason":"stop"}],"usage":{"prompt_tokens":21,"completion_tokens":288,"total_tokens":309}}

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

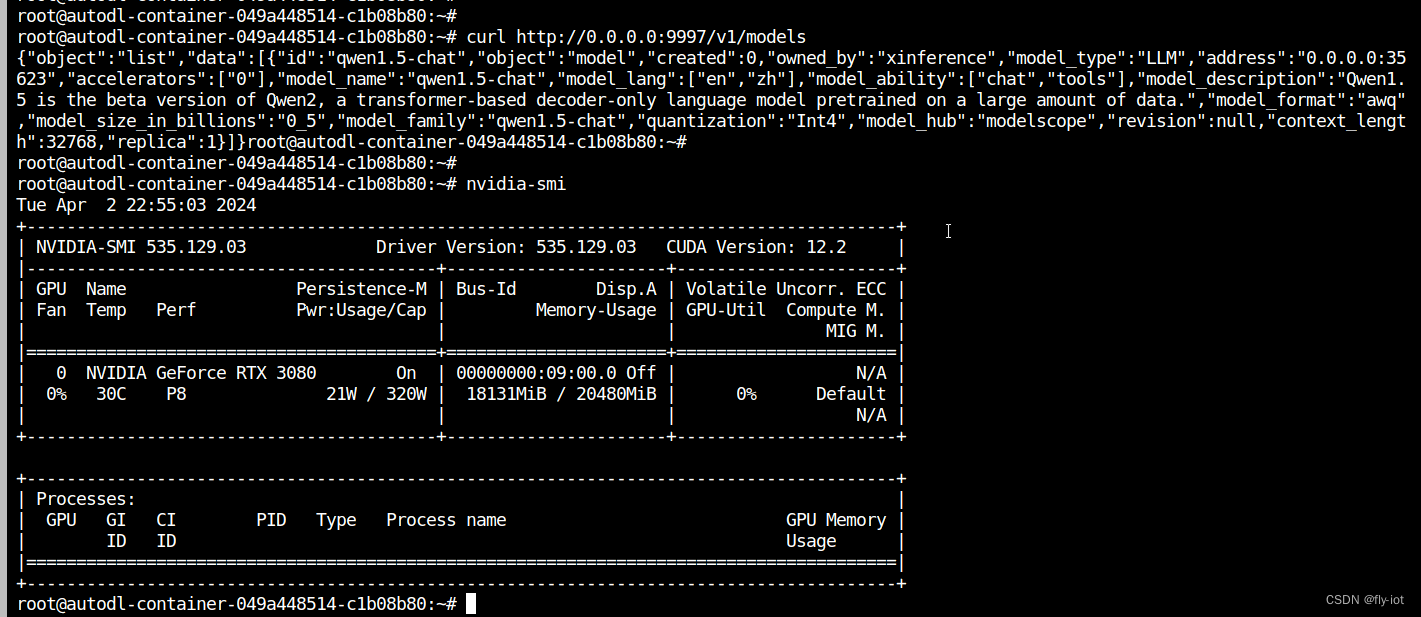

测试接口正常

速度特别快。瞬间返回:

3,还支持函数调用!

# encoding:utf-8

import openai

import json

client = openai.OpenAI(

base_url="http://127.0.0.1:9997/v1",

)

messages = [

{"role": "system", "content": "你是一个有用的助手。不要对要函数调用的值做出假设。"},

{"role": "user", "content": "北京 现在的天气怎么样?"}

]

tools = [

{

"type": "function",

"function": {

"name": "get_current_weather",

"description": "获取当前天气",

"parameters": {

"type": "object",

"properties": {

"location": {

"type": "string",

"description": "城市,例如北京",

},

"format": {

"type": "string",

"enum": ["celsius", "fahrenheit"],

"description": "使用的温度单位。从所在的城市进行推断。",

},

},

"required": ["location", "format"],

},

},

}

]

chat_completion = client.chat.completions.create(

model="qwen1.5-chat",

messages=messages,

tools=tools,

temperature=0.7

)

func_name = chat_completion.choices[0].message.tool_calls[0].function.name

print('func_name', func_name)

func_args = chat_completion.choices[0].message.tool_calls[0].function.arguments

func_args_dict = json.loads(func_args)

print('func_args', func_args_dict['location'])

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

返回 北京。

4,运行qwen1.5 的gguif 版本报错

没有运行成功:

https://inference.readthedocs.io/zh-cn/latest/models/builtin/llm/qwen1.5-chat.html

xinference launch --model-name qwen1.5-chat --size-in-billions 0_5 --model-format ggufv2 --quantization q2_k

Launch model name: qwen1.5-chat with kwargs: {}

Traceback (most recent call last):

File "/root/miniconda3/bin/xinference", line 8, in <module>

sys.exit(cli())

File "/root/miniconda3/lib/python3.10/site-packages/click/core.py", line 1157, in __call__

return self.main(*args, **kwargs)

File "/root/miniconda3/lib/python3.10/site-packages/click/core.py", line 1078, in main

rv = self.invoke(ctx)

File "/root/miniconda3/lib/python3.10/site-packages/click/core.py", line 1688, in invoke

return _process_result(sub_ctx.command.invoke(sub_ctx))

File "/root/miniconda3/lib/python3.10/site-packages/click/core.py", line 1434, in invoke

return ctx.invoke(self.callback, **ctx.params)

File "/root/miniconda3/lib/python3.10/site-packages/click/core.py", line 783, in invoke

return __callback(*args, **kwargs)

File "/root/miniconda3/lib/python3.10/site-packages/click/decorators.py", line 33, in new_func

return f(get_current_context(), *args, **kwargs)

File "/root/miniconda3/lib/python3.10/site-packages/xinference/deploy/cmdline.py", line 746, in model_launch

model_uid = client.launch_model(

File "/root/miniconda3/lib/python3.10/site-packages/xinference/client/restful/restful_client.py", line 873, in launch_model

raise RuntimeError(

RuntimeError: Failed to launch model, detail: [address=0.0.0.0:26349, pid=1449] No available slot found for the model

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23