- 1【走进Linux的世界】Linux---基本指令(2)

- 2揭秘MQTT:为何它是物联网的首选协议?

- 3【SpringCloud】Eureka基于Ribbon负载均衡的调用链路流程分析

- 4【HarmonyOS】鸿蒙操作系统架构

- 5OpenHarmony/HarmonyOS三方库使用指导

- 6【腾讯云 HAI域探秘】StableDiffusionWebUI一小时搞定100张设计图

- 7带你了解软件测试是做什么的_软件测试是干什么的

- 8IM通信技术快速入门:短轮询、长轮询、SSE、WebSocket

- 9【Python/网络安全】 Git漏洞之Githack工具基本安装及使用详析

- 10已解决org.springframework.beans.factory.UnsatisfiedDependencyException org.springframework.beans.factor

卷积神经网络(卷积层,激活函数Relu,池化层,计算公式及API解释)_池化层计算公式

赞

踩

1. 卷积神经网络 (卷积层,激活函数,池化层,全连接层)

(1) 把神经网络的隐藏层分为卷积层和池化层(又叫下采样层)

· 卷积层 : 通过在原始图像上平移来提取特征

· 池化层 : 通过特征后稀疏参数来减少学习的参数,降低网络的复杂度。

2. 卷积层:(定义过滤器)

(1)大小 (观察窗口)、一般都是奇数(1*1、3*3、5*5)

(2)步长(窗口移动的步长),每次移动的像素大小,一般为一个像素

移动的步长太大,导致移动越过图片大小:

· 不越过,直接停止观察

· 就直接越过,越过之后,进行零填充,填充零的大小根据越过的大小进行填充

(3)带着权重 , 如果大小为3*3,即有9个权重

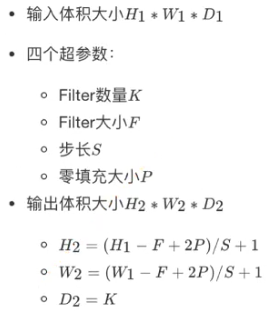

(4) 计算公式:

(5) 卷积网络的API:

input : 即:你输入了【多少张图片,图片的长,图片的宽,图片的通道数】,注意形状是4-D

filter: 过滤器,【过滤器的长,过滤器的宽,过滤器的输入通道,过滤器的输出通道】

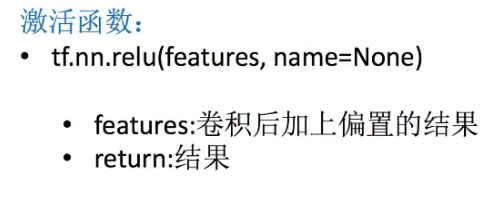

3.新的激活函数-Relu (f(x) = max(0,u))

(1) 增加激活函数: 增加网络的非线性分割能力

(2) 为什么不使用sigmoid等其他的激活函数,而采用Relu

· 在反向传播求误差梯度时间,计算量相对大

· 对于深层网络,sigmoid函数反向传播时,很容易就会出现梯度爆炸的情况。

(3) 把卷积后的值输入到激活函数里面。

4. 池化层 (池化Pooling计算)

(1)池化层主要的作用是特征提取(即删掉一些特征),通过去掉Feature Map(特征图)中不重要的样本,进一步减少参数数量

(2) 池化层的计算, 按照2*2,2的步长,取出最大的值

(3) 池化层计算的API

5. 全连接层 (Full Connected 层)

前面的卷积和池化相当于做特征工程,后面的全连接层相当于做特征加权。

最后的全连接层在整个卷积神经网络中起到 “分类器” 的作用。