热门标签

热门文章

- 1kali linux解决:docker-compose:未找到命令_kali中没有docker命令

- 2基于Arduino框架下开发STM32F103C8T6系统板注意事项_arduino stm32f103c8t6

- 3Advanced Checkpoint Gaia CLI Commands (Tips and Tricks)

- 45G网络(接入网+承载网+核心网)_基站、核心网、接入网

- 5再谈过时且脆弱的TCP长肥管道三宗罪!_iperf cwnd

- 6预测丨2023年软件测试职业发展趋势,附晋升路线_测试人员技术广度和深度谁更适用2023年

- 7大数据开发:Spark数据抽象RDD入门_soarkrdd编程入口

- 8深入探索GDB:Linux下强大的调试神器

- 9安装与配置:Python数据分析开发环境搭建

- 10Installed Build Tools revision 31.0.0 is corrupted. Remove and install again using the SDK Manager.

当前位置: article > 正文

知识图谱构建实战_知识图谱实战

作者:知新_RL | 2024-06-24 22:50:56

赞

踩

知识图谱实战

知识图谱实践的系统工程观念##

- 知识图谱实践是一种典型的大规模知识工程,也是典型的系统工程,在实践过程中应该坚持工程观和系统观;

- 工程观

- 利用数学和科学原理提出有效解决方案解决实际问题的观念。

- 基础的自然科学以认识世界为基本使命,而工程学科旨在改造世界。

- 知识图谱作为一类大规模知识工程,其当下的重要使命在于解决各行业智能化升级转型过程中涌现的一系列问题;

- 工程观势必要求实践者具备优化问题的求解思路;

- 工程中的大部分问题是受资源约束的最优化问题,任何知识图谱所能投入的资源总是有限的,然而实际问题的解决又是迫切的,因此工程实践往往需要利用有限资源提出最优化方案。

- 知识工程的研究与实践不同,行走在知之前,当下技术又加速发展的趋势,但理论速度仍然保持原有速度,技术的快速发展反过来要求理论总结必须提速。

- 系统观

- 系统观认为现实世界中的大部分复杂系统是由相互作用,相互依赖的若干部分组合而成的具有特定功能的有机整体。

- 知识图谱组件众多、涉及要素多样、人机协作复杂;

- 知识图谱作为系统化整体并不是若干组件简单整合,而是复杂策略指引下的有机组合;

- 知识图谱是动态的开放的系统,**随着环境的变化,应用需求与数据都会发生变化,**从而要求知识图谱系统做出相应的调整。

- 当下的大数据知识工程是以知识的规模化表示与应用为核心标志的,自动化知识获取势必要求降低对专家的依赖。

- 大规模的互联网应用催生了知识图谱这样的知识表示,知识图谱通过将二元语义关联(三元组)作为其知识表示的核心,具备了简单、普适及适合从数据中高度自动化获取等优点,但表达能力较弱。

领域知识图谱框架构建

- 从已有的百科类知识资源中抽取实体和关系信息(实体属性),形成结构化的数据资源;

- 结构化文本: 置信度高、规模小、缺乏个性化的属性信息;

- 半结构化文本: 置信度较高,规模较大,个性化信息,形式多样,含有噪声

- 非结构化文本:置信度低,复杂多样,规模大,包含大量的信息。

- 基本思路

- 框架构建: 调研现有框架,完成目标框架的人工构建;数据来源(百度百科,互动百科,豆瓣)

- 半结构化文本中的知识抽取:利用网页的结构信息抽取实体属性名与属性值;

- 非结构化文本中抽取: 自动构建标注器,从纯文本中抽取实体属性值;

- 体系复用:网络百科主要包含实体相关的知识,在构建知识体系时主要参考了如下现有的相关资源: Schema.org; 百度百科分类体系;互动百科分类体系;

- Schema.org

- 提供了一系列的html语义标签,使用这些标签标注网页可以帮助搜索引擎更好的识别这些网页;

- 共有576个类别,758个属性,但其中有很多网页行为有关的类别和和属性。

- 百度百科分类体系

- 每个上层分类包括几个子分类,每个子分类都“继承”父分类的属性,同时有一些自有的属性。

- 百度百科共包含11个大分类:娱乐、科学、自然、文化、地理、生活、社会、人物、经济、体育、历史;

- 互动百科分类体系

- 包括13个大类

半结构化文本中的知识抽取

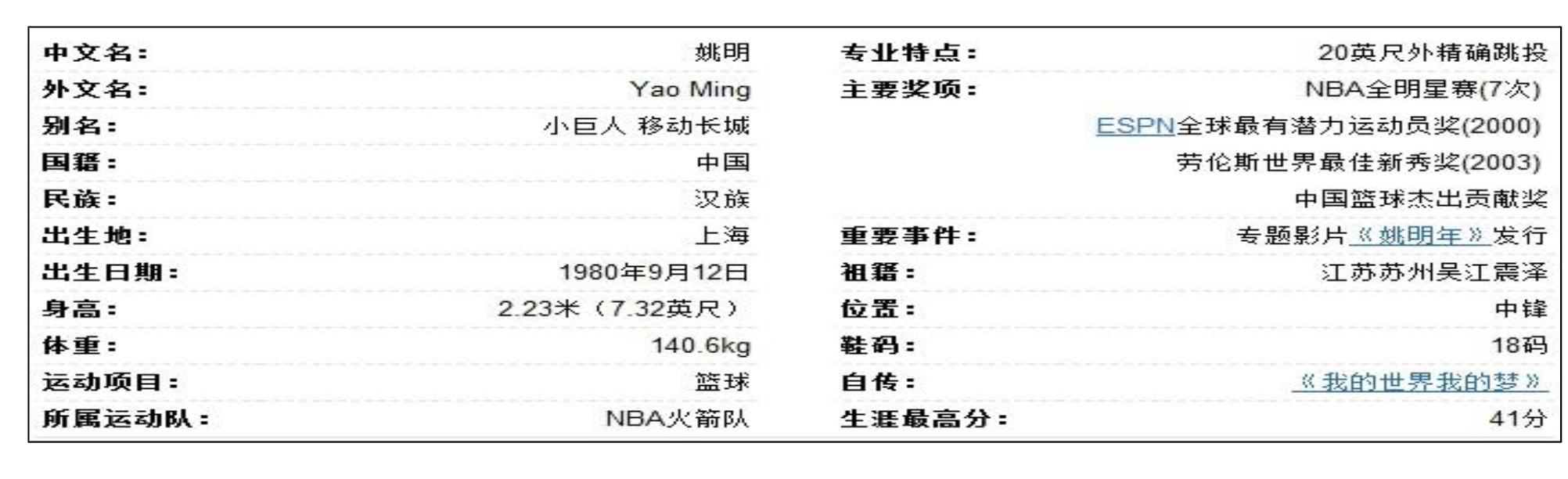

- 从百科普通条目半结构化网页中抽取实体属姓名及实体属性值;

- 从百科文本中定位半结构化信息块;

- 抽取模块的学习

- 属性名,属性值抽取

- 块定位基本思想

- 具有相同模式的实体关系属性名总是连续出现。

- 假设只要“xxx:”的结构连续出现,就可认定该区域为半结构化信息块;

- 关键问题在于属性名称的确定

- 利用结构化信息中的属性名进行定位

- 仅仅依靠已有的属性名进行块定位,召回率低

- 基本框架

- 首先利用结构化信息识别半结构化块;

- 然后在识别的块中学习属性模版并抽取属性;

- 对模版和属性名进行排序,获得高质量的模版和属性名;

- 利用高质量的模版和属性名进行定位和抽取。

- 启发式规则

- 半结构信息块中必须出现infobox中的属性名;

- 半结构化信息块中属性名必须是不同的;

- 半结构化信息块中模式是重复出现的。

- 模版学习

- 属性名之前的第一个html tag与属性名之间为前缀;

- 属性名后第一个字符为分隔符

- Ranker(置信度估计)-网站级知识获取

- 对于所抽取的Wrapper与属性名进行排序

- 高质量的属性名所产生的模板质量更高

- 高质量的网页所产生的模板质量更高

- 高质量的模板所抽取的属性名质量越高,所在的网页的质量也越高

- 构建一个Graph,利用Random Walking进行排序

- 单个页面内的实体属性抽取

- 利用网站级的知识在页面中定位半结构化信息块

- 抽取属性名和属性值

- 确定实体1

- 大多数情况下条目名称作为实体1

- 但是有很多并列结构(团体组合)

非结构化文本中的知识抽取

- 难点:如何获取抽取的目标属性,来源于infobox; 如何获取训练语料,用以训练抽取器,info box回标;

- 数据预处理,回标产生训练数据,训练属性抽取模型,后处理。

- 数据预处理模块

- **百科文本分割:**为后续处理方便,我们将一个百科页面分为“百科名片、infobox、正文文本、开放分类”四个部分,并分别存储,得到的部分去除了词条统计、编辑者、广告等信息;

- **内容清扫:**去Html Tag、图片,提取Plain Text;去除article的结构化和半结构化部分;句子分割:按照标点符号进行分割。

- 挑选训练数据:根据百度百科的“开放分类”将不同的页面分类,然后对各分类训练模型。

• 例如:在对“人物”分类挑选训练数据时,将百度百科中“开放分类”中包含“人物”,并且含有infobox的页面挑选出来。 - 问题:容易引入噪声,从而造成训练语料标注不准确

• 例如:电影明星的条目也会被标注为“电影”的开放分类标签,与真正表示电影的条目混合。如果在这种情况下进行回标产生语料语料,势必会产生错误。 - 解决方案:采用KNN分类进行筛选得到高质量的分类页面

• 针对人物类别挑选训练数据时,将百度百科的“开放分类”中包含“人物”并且包含infobox的页面挑选出来

• 初选完成后,统计infobox属性名的频率并计算属性名在此类中的权重

• 挑选权重较大的属性名向量作为此类的中心

• 最后再对包含infobox的页面提取出属性名向量,计算其到每个类的距离进行KNN分类

- 文档分类器:计算文档所属分类,确定所抽取实体目标属性

- 训练:

• 用最大熵算法训练分类器

• 训练语料为KNN筛选后的“高质量百科文档”

• 特征为词袋子

- 实体属性回标:产生供训练模型所用的训练语料

- 回标采用的规则:InfoBox中属性值处理

如果信息框中某条属性的属性值较长并且含有标点符号,首先需要对属性值根据标点符号进行分割

句子必须包含百科Title及Infobox中的属性值(并限定距离) - Infobox中的“属性-值”回标时,如果有多个句子匹配时根据距离排序,取Top5

- 基于CRFs的实体属性值抽取

- 目标:对确定类别的文档中每个含有实体一的句子,在其中抽取实体属性值,确定目标词或短语的边界

- 训练: 用回标所得的结果训练CRFs,不同文档类别分开训练,每个属性一个CRF;对于百科信息框中的每个属性,对其分配S、B、M、E、N五个标签。

- 特征: 词性、词形、上下文特征;一元、二元组合

- 句子分类器

- 目标:**对抽出实体属性值的句子,用分类器判别这个句子抽出了这个属性是否正确**(该句子是否包含了该属性信息)

- 训练

➢ 用回标所得的结果(标注了实体一、实体二的句子)训练

➢ 不同文档类别分开训练,每个属性一个分类器

➢ 使用最大熵分类器 - 特征: 词袋子,CRF所标注的实体1和实体2之间的距离;

- 后处理

- **多属性问题:**在一篇文档中,针对单个属性,可能抽取出不同的属性值;有些属性需要多个属性值(职业、成就)

- **解决方法:**统计每个属性为单值属性还是多值属性,确定每个属性最多可以有几个属性值;对于通过句子分类器筛选的三元组,根据置信度进行排序,对于每个属性,保留句子分类器所得概率最高的若干个属性值,汇总去重

- 回标规则对于性能的影响

-

两条规则(Case Study)

➢ TopN规则(回标后选取实体1与实体2最近的N个句子)

• Top1 vs. Top5

➢ 最近邻规则(当一个句子中出现多个实体1与多个实体2,则取最近邻的实体1和实体2)

-

存在问题

-

实体消歧

不同来源的实体可能名称不一样,无法直接对应;

例如:如百度百科中具有以“李娜”作为条目名称的实体有多个,它们分别表示着网球运动员李娜、女演员李娜、教授李娜等等。

解决方法:网络百科中,每个实体由条目名称(标题)、标签、属性三部分组成。

对于名称相同的条目,通过计算两个实体在标签和属性两个方面的相似度来计算两个实体间的相似度。

具体方法:

• 标签计算:将百度百科实体标签集合中的每个元素到候选互动百科实体的标签集合中,寻找最相似的对应标签,并记录相似度。这里的相似度计算采用编辑距离计算方法。

• 属性名计算:先进行属性名的匹配,映射到相同属性名下的属性,算作属性名匹配,并进一步进行属性值的匹配,利用编辑距离计算匹配好的属性名下属性值间的相似度,记录相似度值。

• 综合计算: 将标签计算中得到的相似度与属性计算中得到的相似度线性加权,结果作为两个实体匹配的相似度。

知识图谱众包构建

- 原因:目前知识图谱主要是以基于数据驱动的方法来构建的,即机器利用自然语言处理等方法自动从大规模文本中抽取知识,这种方法克服了完全依靠人工专家构建知识库所带来的高昂成本,使知识图谱的规模呈几何级增长。然而,在当前阶段,知识的获取仍然需要人力介入,这主要有以下三个原因:

- 人机混合智能仍然是当前人工智能发展的主要形态,大部分人工智能过程仍然需要来自专家的经验与知识,大部分机器学习算法仍然显著依赖于人工标注的样本;人机混合智能既是当前人工智能技术发展的局限所致,也是人工智能技术发展的可控性要求的结果。

- 知识是人类认知世界的结果,知识的对错其责任主体还是人自身:通过自动化方法获取知识产生错误在所难免。由于人工智能、模式识别、自然语言处理等技术的限制,以及网络文档不规范、噪声数据多等条件的制约,知识图谱构建的每一个重要步骤(如实体识别、关系抽取和知识融合等)都不可能用自动化的手段完全、准确地完成,而在这些中间步骤中产生的误差经过累加会导致知识图谱将错误的知识也吸纳进来;由机器自动抽取的任何知识,其最终的验证者还应该是人,而且只有人才能对知识的对错负责,我们没有办法对机器追责。

- 数据只是人类知识的有限载体,通过数据驱动的自动化获取方法只能获取知识的有限子集,人类对知识的补充不可或缺;人类的知识是十分庞大的,我们口口相传、通过书籍记载或数字化记录的知识只是人类知识总体中相当有限的子集。

- 众包可以介入知识图谱的三个阶段

- 元知识创建阶段

主要实现元知识的搭建(基本的认知框架)

基本的知识体系涉及深层次语义理解,难以从大数据中自动规划得到,各类知识获取模型所用到的特征和规则也需要由人制定,这部分工作主要由专家完成。 - 知识获取阶段

主要利用众包实现数据标注,再将这些标注数据作为训练数据,进而构建知识获取模型(包括实体识别、关系抽取、知识融合等各种经典模型),通过这些模型从文本或数据中自动抽取知识; - 知识精化阶段

在完成自动化知识抽取后,需要通过众包手段来验证知识, 纠错补漏

- 知识型众包基本概念

- 众包(crowdsourcing)是一种新型的外包模式,将一群松散的任务发包(Requester),和任务完成者联系起来,实现任务发包,匹配,完成和付款等一系列工作。

- 与传统外包模式不同的是,众包所联系的群体是一群松散的无组织人群,而传统承接外包任务的对象是一个相对固定的组织。相对于传统外包,众包在经费开销、时间与灵活性等方面表现更佳。

- 互联网2.0使得人们交互、支付和组织的便捷性大大提高,众包因此也得到了推广,目前已经有不少比较成功的众包平台。比如,滴滴出行和Uber 通过自己的互联网约车平台实现了司乘需求的匹配。其他的一些020平台(如美团外卖、达达物流等)也都采用众包的方式完成了发包方与工人的匹配。可以说,众包已经成为现代服务业的一种重要组织方式。

- 劳动型众包声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/知新_RL/article/detail/754238

推荐阅读

相关标签

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。