- 1基于Python的车牌识别系统实现_车牌识别python

- 2Xinlinx 7系列FPGA概览

- 3电商平台母婴用品数据分析_国际母婴电商销售数据

- 4【大模型】 Qwen2 来了,27 种语言支持,上下文长度支持最高达到 128K tokens

- 5微信小程序 改变radio的默认大小_radio 默认占的空间大

- 6js相关面试题--仔细观看--一块学习--不懂得评论区说下,我来解释_js通过id对比两个集合,给id相同的一个集合中增加属性,不用双层map处理

- 7利用Excel分析链家二手房数据_二手房数据图表怎么做

- 8这可能是全网最详细的Android车载OS资料整理_android automotive os

- 9深度学习中图像分割性能的度量指标总结_像素精度pa

- 10SCI论文公式快捷获取_快速提取论文公式

计算机视觉面试题整理_计算机视觉考试题

赞

踩

1、介绍目标检测网络yolo系列以及ssd系列的原理,yolo对小目标检测不好的原因,除了缩小anchor外还可以如何改善?

- Yolo目标检测:YOLO是一种实时目标检测算法,其核心思想是将目标检测问题归为一个回归问题,直接从输入图像中预测目标的类别和位置,YOLO的主要特点有①单次前向传播(one-stage):YOLO只需一次前向传播来完成整个目标检测任务,而不需要复杂的多次处理。②分割网格:输入图像被分割成固定数量的网格单元,每个网格单元负责预测其中包含的物体的位置和类别。③多尺度预测:YOLO使用多尺度锚框来处理不同尺寸和长宽比的物体,这有助于提高检测性能。④损失函数:YOLO使用多部分损失函数来衡量分类误差和定位误差,同时鼓励模型预测物体的边界框,以准确地定位物体。⑤实时性能:YOLO因其单次前向传播和高效的设计而在实时目标检测任务中表现出色。

- SSD(Single Shot MultiBox Detector):与YOLO不同,SSD采用一种多层次的特征提取方法,以便处理不同尺寸的物体。①多层次特征提取:SSD使用多个卷积层来提取图像的特征,并在不同层次上进行目标检测。②锚框:SSD使用锚框来预测不同尺寸和长宽比的物体,每个锚框都与特定的位置和尺寸相关联,模型根据这些锚框来预测物体的位置和类别。③损失函数:类似于YOLO,SSD使用多部分损失函数来衡量分类误差和定位误差,以优化模型的性能。④效率:SSD在速度和准确性之间取得了很好的平衡,虽然它可能不如某些YOLO版本那么快,但在检测精度上表现出现。

- YOLO对小目标检测不好的原因:因为其设计初衷是为了检测相对较大的目标。可以采用的方法有:①增加输入图像的分辨率通常有助于提高小目标的检测性能。②YOLO可以通过在不同尺度下进行目标检测来改善小目标的检测性能。③使用特征金字塔可以改善小目标检测。④引入注意力机制可以帮助网络更关注小目标④使用数据增强技术,如随机裁剪、缩放、旋转等,可以生成更多的小目标样本,以帮助网络学习如何识别和定位小目标。⑤设置更小更稠密的anchor。⑥卷积神经网络设计时尽量度采用步长为1,尽可能保留多的目标特征。

2、样本中正负样本不平衡,如何解决?

- 使用类平衡交叉熵损失函数

- 对小样本做数据增广

- 重采样(过采样,增加少数类样本数量;欠采样,减少多数类样本数量)

- 权重调整,修改损失函数,赋予不同类别样本不同权重。

3、简单介绍下支持向量机SVM的原理。

支持向量机是一种二分类分类模型,其基本模型定义为特征空间上的间隔最大的线性分类器,其学习策略便是间隔最大化,最终可转化为一个凸二次规划问题的求解。

4、哪些机器学习算法不需要做归一化处理?

- 需要归一化的模型:基于距离计算的模型:KNN、通过梯度下降求解的模型(线性回归、逻辑回归、支持向量机、神经网络)

- 树形模型不需要归一化,因为它们不关心变量的值,而是关心变量的分布和变量之间的条件概率。如决策树、随机森林。

5、为什么树形结构不需要归一化?

因为数值缩放不影响分裂点位置,对树模型的结构不造成影响。按照特征值进行排序的,排序的顺序不变,那么所属的分支以及分裂点就不会有不同。而且树模型不能进行梯度下降,因为构建树模型(回归树)寻找最优点时是通过寻找最优分裂点完成的,因此树模型是阶跃的,阶跃点是不可导的,并且求导没意义,也就不需要归一化。

6、在k-means或KNN,我们常用欧氏距离来计算最近的邻居之间的距离,有时也用曼哈顿距离,请对比下这两种距离的差别。

- 欧式距离:是最常见的距离度量方法,也被称为直线距离。它计算两点之间的距离,就像你在二维平面上使用的直线距离一样。欧氏距离考虑了各维度上的差异性,因此更适用于各维度特征的尺度相似的情况。

- 曼哈顿距离:是沿着坐标轴的垂直线段的长度之和,因此也被称为城市街区距离。它计算两点之间的距离,就像你在城市中行走沿街道走的距离一样。曼哈顿距离更适合于考虑了各维度特征的尺度不同的情况,因为它在各维度上是独立计算的。

-

总结比较:①欧氏距离通常在各维度上的尺度相似时表现较好,因为它考虑了各维度之间的差异性。②曼哈顿距离更适合在各维度上的尺度不同或者数据呈现明显的块状分布时,因为它不考虑各维度之间的差异,而只计算了坐标轴上的距离。③选择哪种距离度量方法通常取决于问题的性质和数据的特征。在某些情况下,你甚至可以尝试使用其他自定义的距离度量方法,以便更好地捕捉数据之间的相似性或差异性。

7、CNN在图像上表现好的原因

直接将图像数据作为输入,不仅无需人工对图像进行预处理和额外的特征抽取等复杂操作,而且以其特有的细粒度特征提取方式,使得对图像的处理达到了几近人力的水平。

8、参数和计算量的计算

卷积输入为W x H x C,卷积核K x K x N, 输出W1 x H1 x C1.

- 计算量:W1 x H1 x C1 x K x K x C

- 参数:C1 x K x K x C

9、调参、修改模型的经验

- 数据层面:获得更多的数据、数据扩增或生成、对数据进行归一化或标准化,重新进行特征选择。

- 算法层面:对算法进行抽样调查。选取性能最好的算法,然后通过进一步的调参和数据准备来提升重采样方法。可以先在小数据集上完成模型选择和参数调优,然后再将最终的方法扩展到全部数据集上。

- 调参:①诊断,在每个周期,评估模型在训练集和验证集上的表现,并作出图表;②权重初始化,尝试不同是初始化方法,考察是否有一种方法在其他情况不变的情况下效果更优;③学习率:尝试随周期递减的学习率或增加动量项;④激活函数:尝试常见的激活函数,并且重缩放你的数据以满足激活函数的边界;⑤Batchsize和周期。尝试不同的批次batchsize和周期数,batchsize大小会决定最后的梯度。以及更新权重的频度。⑥正则化:尝试不同的正则化方式,权重衰减(Weight decay) 去惩罚大的权重、激活约束(Activation constraint) 去惩罚大的激活值、分别在输入, 隐藏层和输出层中试验 dropout 方法或者使用L1、L2正则化。⑦优化算法和损失函数:尝试不同的优化算法(SGD、ADAM、RMSprop、、、)。要被优化的损失函数与你要解决的问题高度相关,也得适当调整。⑧早停,一旦训练过程中共出现验证集性能下降,你可以停止训练和学习,是避免模型在训练数据上过拟合的正则化方式。

- 通过嵌套模型提高性能:通过组合多个“足够好”的模型来得到优秀的预测能力,而不是通过组合多个高度调参的(脆弱)的模型。

10、简述Inception v1-v4的区别和改进。

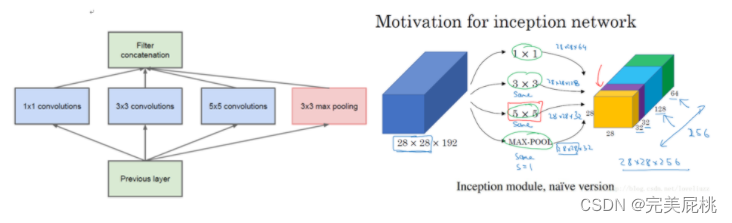

- v1:①采用不同大小的卷积核意味着不同大小的感受野,最后拼接意味着不同尺寸特征的融合;②将CNN种常用的卷积(1x1,3x3,5x5)、池化操作(3x3)堆叠在一起(卷积、池化后的尺寸相同,将通道相加)一方面增加了网络的宽度,另一方面也增加了网络对尺寸的适应性;③为了减少计算量,增加了1x1卷积。

- v2:①卷积分解,将单个5x5的卷积层用2个连续的3x3的卷积层组成的小网络来代替,在保持感受野范围的同时又减少了参数量,也加深了网络。②提出了著名的Batch Normalization (BN) 方法,BN会对每一个mini-batch数据的内部进行标准化,使输出规范到N(0,1)的正态分布,加快了网络的训练速度,增大了学习率③BN在某种意义上起到了正则化的左右,所以可以减少或者取消dropout,简化网络结构。v2在训练达到v1准确率时快了14倍,最后收敛的准确率也比v1高。

- v3:①考虑了nx1卷积核,将一个较大的二维卷积拆成两个较小的一维卷积(7x7拆成了7x1和1x7,3x3拆成了1x3和3x1),一方面节约了大量参数,加速运算并减轻了过拟合),同时网络深度进一步增加,增加了网络的非线性。②优化了Inception Module的结构

- v4:采用残差结构(Residual Connection)来改进v3结构

11、Inception v1中的inception结构怎么设计的?

- 采用不同大小的卷积核意味着不同大小的感受野,最后拼接意味着不同尺度特征的融合。

- 该结构将CNN中常用的卷积(1x1,3x3,5x5)、池化操作(3x3)堆叠在一起(卷积、池化后的尺寸相同,将通道相加),一方面增加了网络的宽度,另一方面也增加了网络对尺度的适应性。

- 然而上面这个Inception原始版本,所有的卷积核都在上一层的所有输出上来做,而那个5x5的卷积核所需的计算量就太大了,约需要1.2亿次计算量,造成了特征图的厚度很大。

- 为了避免这种情况,在3x3前、5x5前、max pooling后分别加上了1x1的卷积核,以起到了降低特征图厚度的作用,这也就形成了Inception v1的网络结构,如下图所示:

12、Inception为什么使用1x1卷积核?

- 1x1卷积的主要目的是为了减少维度,还用于修正线性激活(relu),比如上一层的输出为100x100x128,经过具有256个通道的5x5卷积层之后 (stride=1,pad=2),输出数据为100x100x256,其中卷积层参数为128x5x5x256=819200。而假如上一层输出数据输出先经过具有32个通道的1x1卷积层,再经过具有256个输出的5x5卷积层,那么输出数据仍为100x100x256,但卷积参数量已经减少为128x1x1x32 + 32x5x5x256= 204800,大约减少了四倍。

- 加深了网络的层次,同时增强了网络的非线性。

13、CNN网络的演变

- LeNet:2个卷积+3个全连接,最早用于数字识别。

- AlexNet:12年ImageNet冠军,5个卷积3个全连接,多个小卷积代替单一大卷积,使用使用ReLU激活函数,解决梯度小数问题;引入dropout避免模型过拟合;最大池化。

- ZF-Net:13年ImageNet冠军,只用了一块 GPU 的稠密连接结构;将AlexNet第一层卷积核由11变成7,步长由4变为2。

- VGG-Nets:14年ImageNet分类第二名,更深的网络,卷积层使用更小的filter尺寸和间隔;多个小卷积让网络有更多的非线性,更少的参数。

- GoogLeNet:14年ImageNet分类第一名。引入Inception模块,采用不同大小的卷积核意味着不同大小的感受野,最后拼接意味着不同尺度特征的融合;采用了平均池化代替全连接层,避免梯度消失,网络额外增加了2个辅助的softmax用于向前传导梯度。

- ResNet:引入残差单元,简化学习目标和难度,加快训练速度,模型加深时,不会产生退化问题;能够有效解决训练过程中梯度消失和梯度爆炸问题。

- DenseNet:密集连接;加强特征传播,鼓励特征复用,极大的减少了参数量。

14、介绍CNN,每个层及作用

- CNN的特征检测层通过训练数据进行学习,在使用CNNC时,避免了显式的特征提取,而隐式地从训练数据中进行学习,由于同一特征映射面上的神经元权值相同,所以网络可以并行学习,这也是卷积网络相对于神经元彼此相连网络的一大优势。卷积神经网络以其局部权值共享的特殊结构在语音识别和图像处理方面有着独特的优越性。权值共享降低了网络的复杂性,特别是多维输入向量的图像可以直接输入网络这一特点避免了特征提取和分类过程中数据重建的复杂度。

- 卷积网络主要由卷积层、激活函数、池化层、全连接层组成。①卷积层:使用卷积核进行特征提取和特征映射;②激活函数(Activation):由于卷积也是一种线性运算,因此需要增加非线性映射;③池化层(Pool):对输入的特征图进行压缩,一方面使特征图变小,简化网络计算复杂度;一方面进行特征压缩,提取主要特征;④全连接层(FC):连接所有的特征,将输出值送给分类器。(先休息咯 再更