热门标签

热门文章

- 1python面向对象版学生管理系统_学生信息管理系统python面向对象封装

- 2[MAC] 编译安装和测试《魔兽世界》模拟服务端 TrinityCore

- 3Python deepFM推荐系统,推荐算法,deepFM源码实战,deepFM代码模板

- 4CrossOver V2021.20汉化补丁Mac安装Windows免费软件_crossout中文补丁

- 5GPT-4的新玩法:智能应用探索之路_gpt4用于编程选哪个功能

- 6springMVC/boot的Echart图表数据展示_springmvc引入echarts5.3

- 7爬虫实战5:爬取百度图片_爬虫实现可视化爬取百度图片案例

- 8caioj1035:递归5( n皇后问题)_输入格式: 一个整数 n。 输出格式: 每行输出一种方案,每种方案顺序输出皇后所在的

- 910大最常用的iptables规则_dports ssh

- 102024年蚂蚁金服面经(Java岗、交叉面、P6+、已入职,面试技巧训练_蚂蚁金服java面试

当前位置: article > 正文

Windows 安装 Xinference_xinference windows

作者:知新_RL | 2024-07-10 22:10:41

赞

踩

xinference windows

0. 引言

Xorbits Inference(Xinference)是一个性能强大且功能全面的分布式推理框架。可用于大语言模型(LLM),语音识别模型,多模态模型等各种模型的推理。通过 Xorbits Inference,你可以轻松地一键部署你自己的模型或内置的前沿开源模型。无论你是研究者,开发者,或是数据科学家,都可以通过 Xorbits Inference 与最前沿的 AI 模型,发掘更多可能。

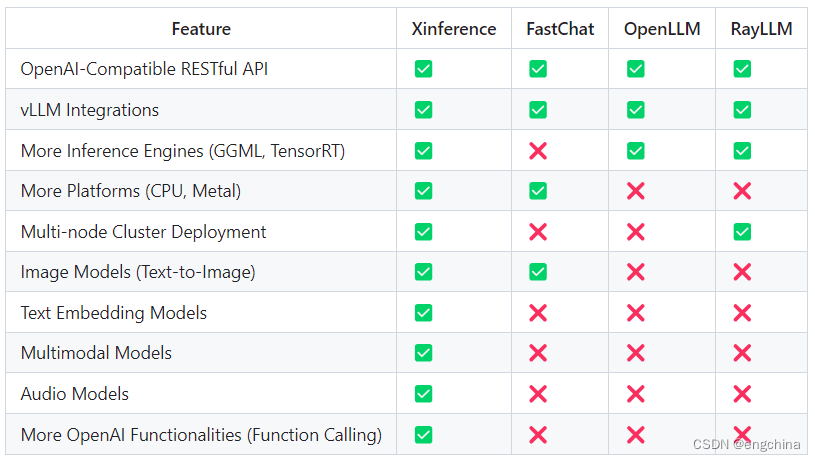

为什么选择 Xinference?

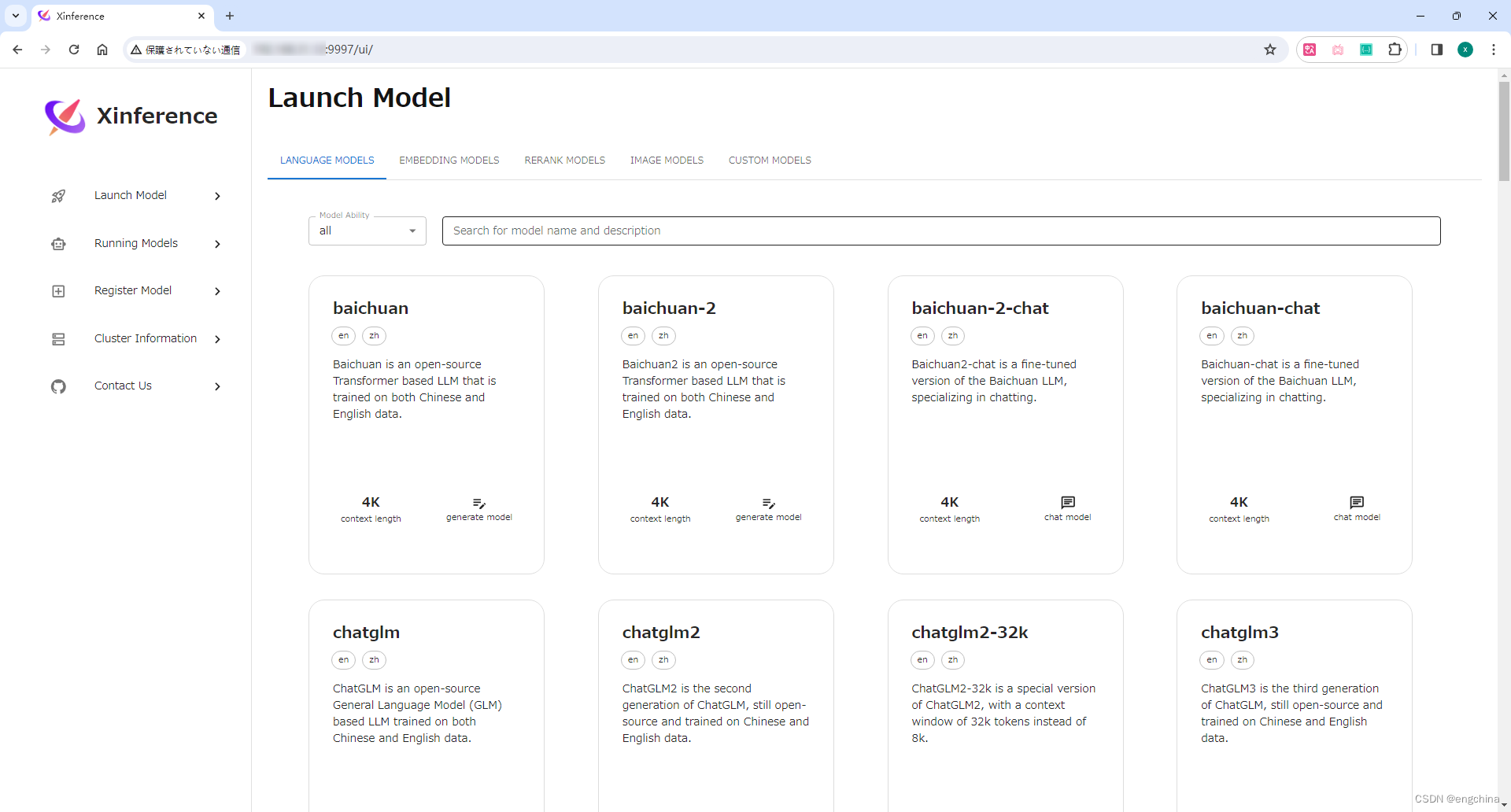

启动后的画面,

1. 创建虚拟环境

conda create -n xinference python=3.10 -y

conda activate xinference

- 1

- 2

2. 安装 pytorch

conda install pytorch==2.0.1 torchvision==0.15.2 torchaudio==2.0.2 pytorch-cuda=11.8 -c pytorch -c nvidia

- 1

3. 安装 llama_cpp_python

pip install https://github.com/abetlen/llama-cpp-python/releases/download/v0.2.55/llama_cpp_python-0.2.55-cp310-cp310-win_amd64.whl

- 1

refer: https://github.com/abetlen/llama-cpp-python

4. 安装 chatglm-cpp

pip install https://github.com/li-plus/chatglm.cpp/releases/download/v0.3.1/chatglm_cpp-0.3.1-cp310-cp310-win_amd64.whl

- 1

refer: https://github.com/li-plus/chatglm.cpp

5. 安装 Xinference

pip install "xinference[all]"

- 1

refer: https://github.com/xorbitsai/inference

6. 设置 model 路径

在我的电脑上设置环境变量,路径请根据各自环境修改。

XINFERENCE_HOME=F:\XinferenceCache

- 1

7. 启动 Xinference

xinference-local -H <your_ip>

- 1

选择一个 Model 运行,

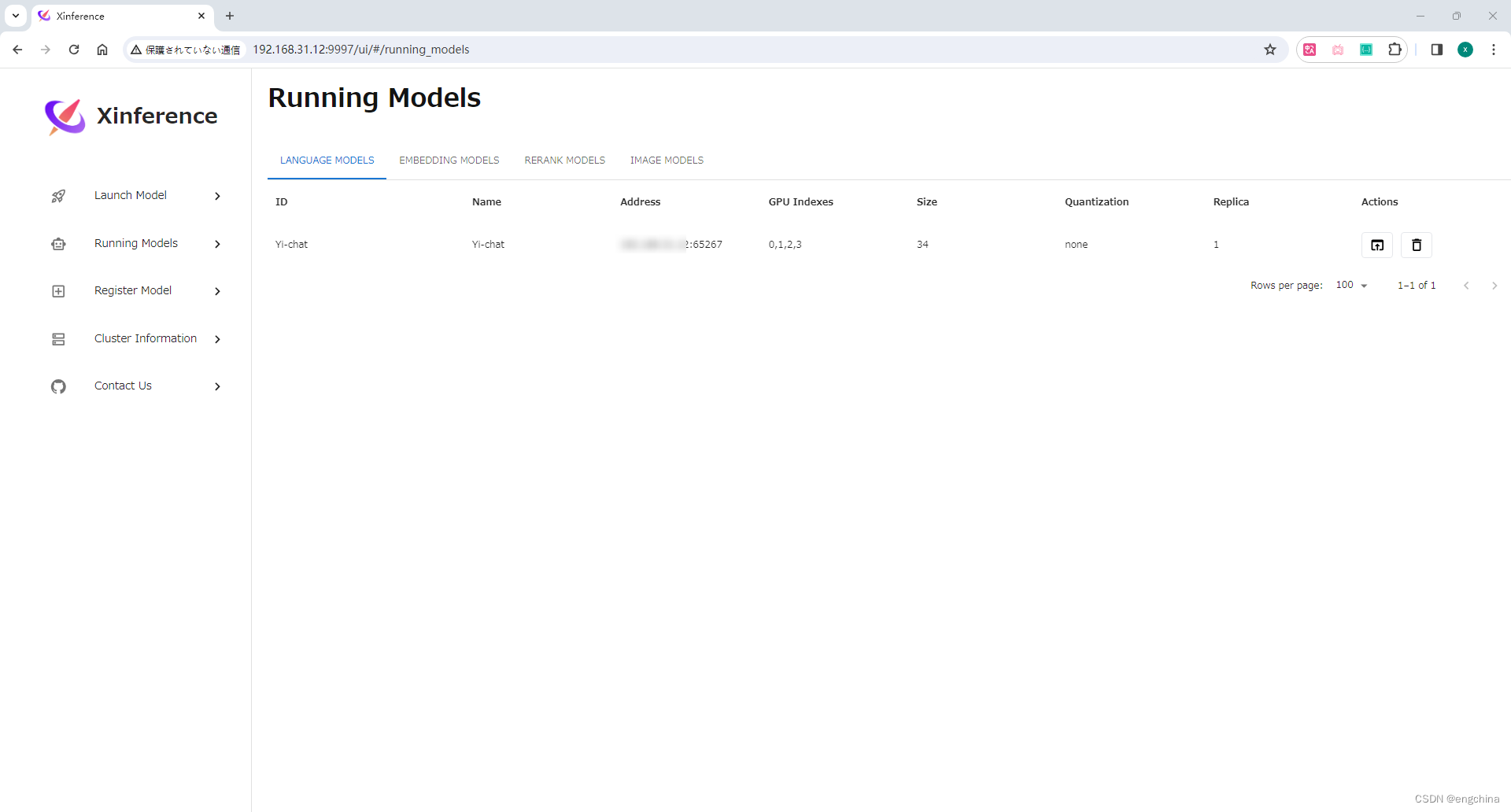

运行成功后,在 “Running Models” 页面可以查看,

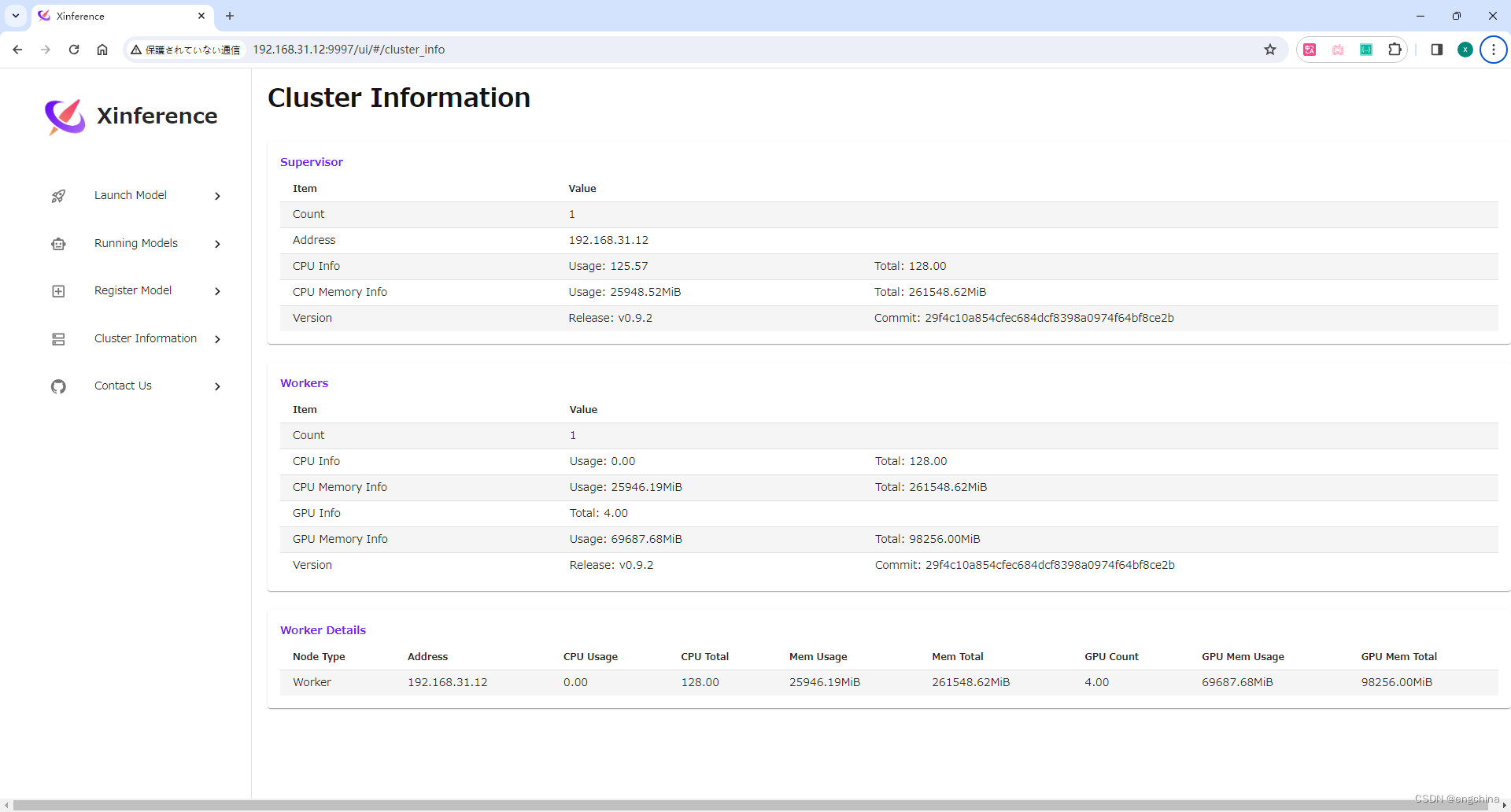

8. 查看 Cluster Information

点击 Cluster Information,

完结!

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/知新_RL/article/detail/807900

推荐阅读

相关标签