热门标签

当前位置: article > 正文

【本地部署大模型ChatGLM3-6B】_本地部署gptchatflgm 3-6b需要什么

作者:码创造者 | 2024-06-22 14:06:20

赞

踩

本地部署gptchatflgm 3-6b需要什么

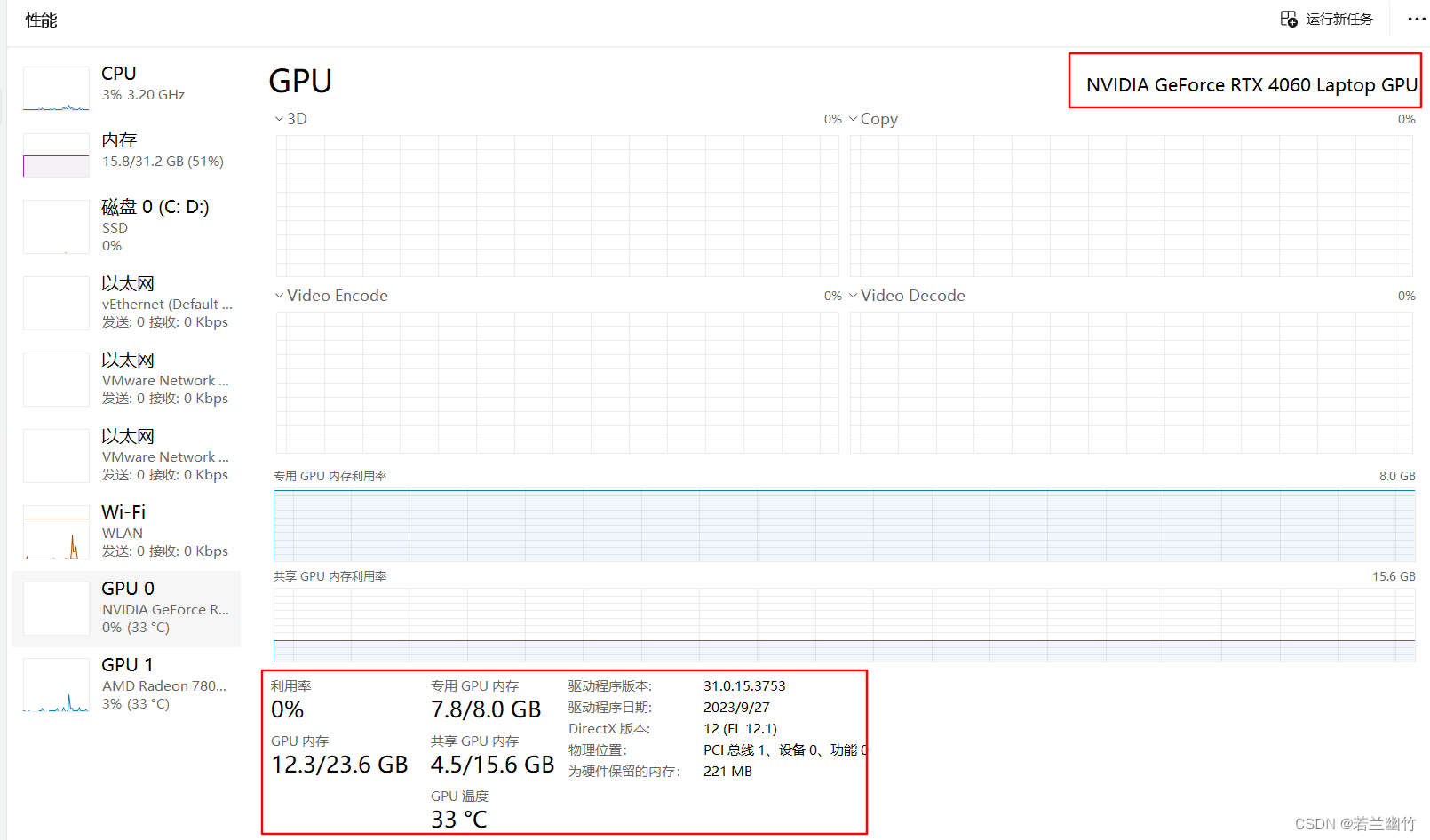

一、环境说明

电脑配置如下:

运行大模型主要看GPU,我这个8G的GPU跑这个ChatGLM3-6B有点紧张了。

注意:

一个模型6b = 6144亿参数

如果一个参数为int 4,那么 1b = 2个参数

如果一个参数为FP16, 那么 1b = 0.5个参数

因此,6b模型在fp16的情况下至少需要13288亿字节~ 13.3g左右的存储方案。

二、部署大模型

-

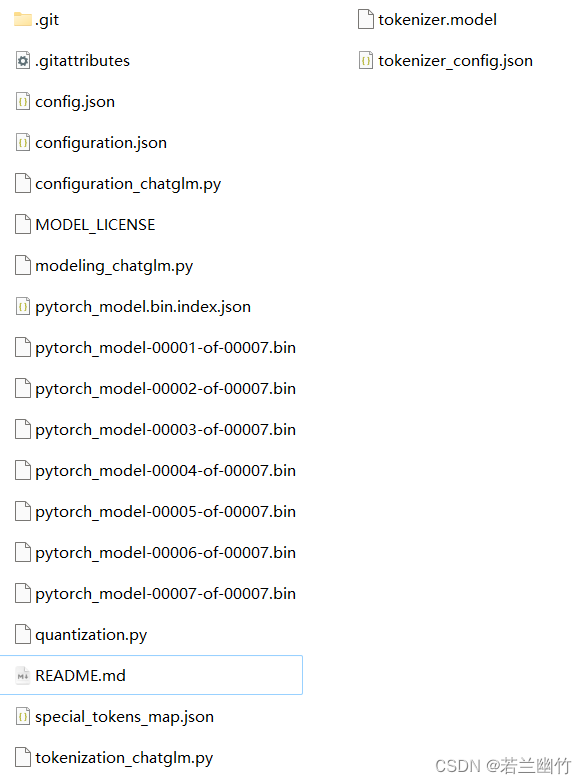

下载大模型文件

建议采用git的方式下载到本地,如没有git,则先在本地电脑上安装git。

git下载地址:git lfs install git clone https://www.modelscope.cn/ZhipuAI/chatglm3-6b.git- 1

- 2

下载的过程比较漫长,请耐心等待。

如果网络慢或者无法下载,请科学上网,然后重新下载。

下载好后,如下图所示:

整个文件夹大小大概34G左右。 -

下载cuda安装包并安装

选择对应版本的cuda,然后直接双击安装即可。

点击进入cuda官网 -

安装Python或者Anaconda,确保有jupyter notebook环境

我安装的Python,然后配置jupyter环境。想省事的话,直接下载Anaconda安装。PS C:\Users\suben> python -V Python <- 1

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/码创造者/article/detail/746722

推荐阅读

相关标签