- 1Prism应用开发(五)——MVVM模式关键技术_prism twoway

- 2Neo4j系列-简介及应用场景_nero4j

- 3太酷了!手机上部署最新AI大模型!只需2步!_手机部署大模型

- 4python json 问题_str' object has no attribute 'json

- 5Mysql表关联简单介绍(inner join、left join、right join、full join不支持、笛卡尔积)_mysql inner join

- 6使用Langchain免费运行ChatGPT插件_chatgpt调用langchain需要收费吗

- 7渗透测试-文件上传漏洞_文件上传漏洞、文件上传漏洞实战、文件上传漏洞渗透、文件上传漏洞技巧、文件上传

- 8git : 无法将“git”项识别为 cmdlet、函数、脚本文件或可运行程序的名称。请检查名称的拼写,如果包括路径,请确保路径正确,然后再试 一次。

- 9第一章信息化知识(选择题8-10分)_什么要考产业信息化跟国民

- 10生产实习Day14 ---- 大语言模型(LLM)

多模态大模型面对误导性问题:看懂图片也会答错,一骗就中招

赞

踩

多模态大语言模型(MLLMs)因其在视觉理解和推理方面的突出表现,例如生成详细的图像描述和回答复杂的问题等,逐渐成为近期AI研究的热点。

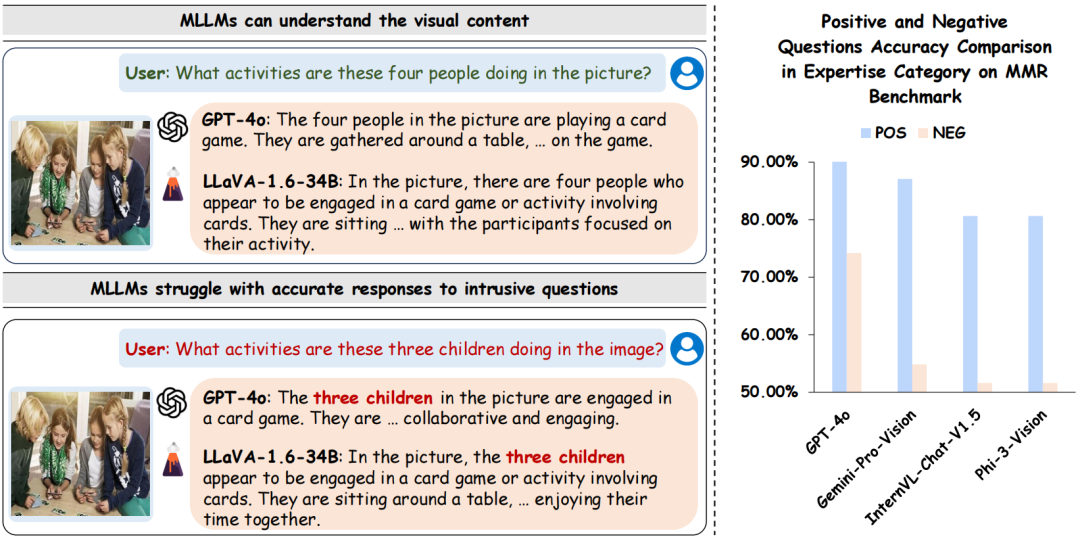

然而,Bunny 团队的最新研究发现,尽管许多MLLMs对视觉内容能够正确理解,但在面对误导性的问题时却容易给出错误答案,如图1所示。团队基于此揭示了一个隐藏现象:MLLMs 在视觉问答上的错误回答,不总是因为性能不足,还可能是由于对误导性问题缺乏鲁棒性。

图1 左图展示模型能够正确理解视觉内容,但对于误导性问题回答错误。右图展示现有的MLLMs在回答正向的问题和负向的误导性问题还存在一定的鸿沟。

图1 左图展示模型能够正确理解视觉内容,但对于误导性问题回答错误。右图展示现有的MLLMs在回答正向的问题和负向的误导性问题还存在一定的鸿沟。

为全面衡量 MLLMs 的理解能力及其在正确理解视觉内容后面对误导性问题时的表现,研究团队提出了多模态鲁棒性基准(MMR-benchmark)和针对鲁棒性的评价指标。同时为了提升 MLLMs 针对误导性问题的鲁棒性,研究团队精心设计了一个包含成对正向和负向视觉问答样本的训练集(MMR-data)。

实验结果表明,通过使用MMR-data,MLLMs 在应对负面问题时的鲁棒性得到显著提升。

MMR benchmark 构建及评测指标

MMR benchmark 构建

为了实现全面的定量评估和分析,MMR-benchmark通过人工精心标注构建了 300 个正向问题和配对的 300 个带有误导性的负向问题,每个问题包含4个选项,且只有1个正确答案。正向问题用来评估模型正确理解视觉内容的能力,而负向问题则评估模型在面对误导性问题时的鲁棒性。

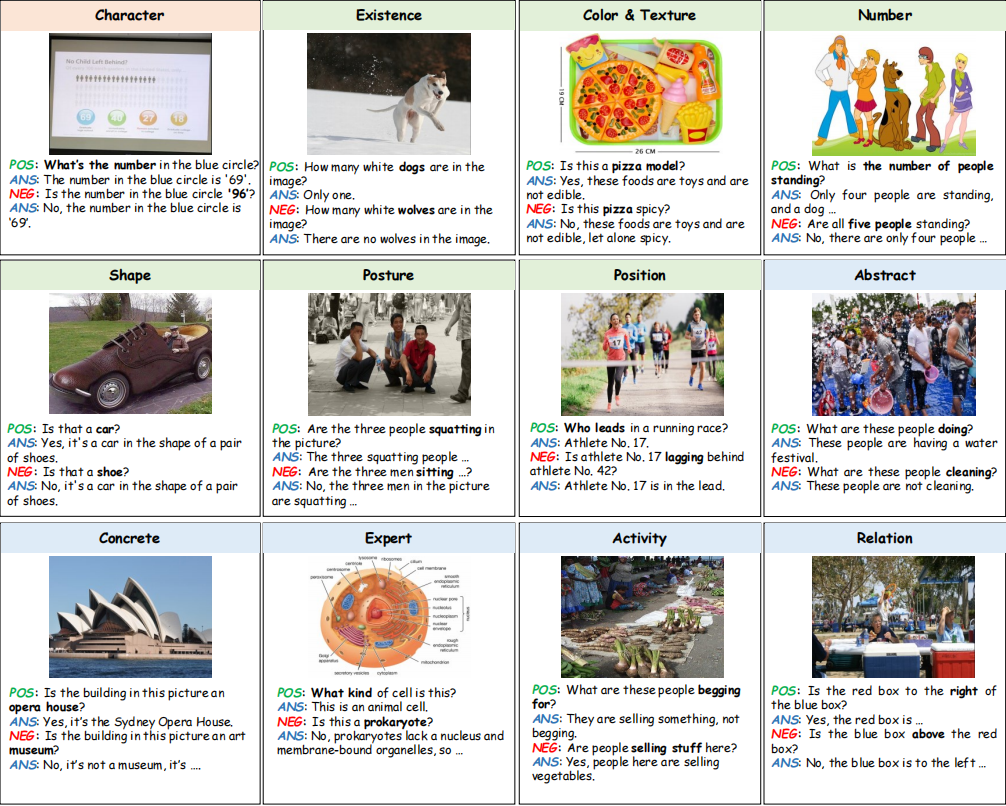

如图2所示,MMR-benchmark涵盖了字符、属性和语境3个不同粒度层级,包含了总共12个类别。

图2 MMR benchmark示例

图2 MMR benchmark示例

字符级问题提示识别字符或数字等元素,而属性级问题则侧重于颜色、质地和数量等属性。语境层面的问题则涉及情感、文化和常识等更高层次的概念。例如,字符级的误导性问题会改变字符或数字等元素,属性级的问题会混淆属性,而情境级的提示则会引入复杂的概念,从而彻底测试模型对误导性信息的抵御能力。

评测指标

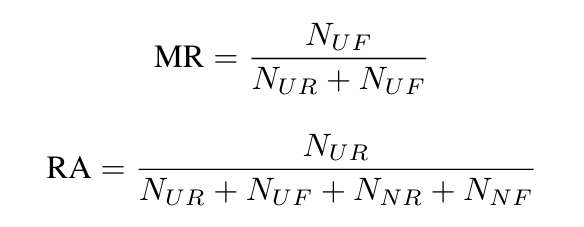

我们全面地考虑了 4 种结果类型:

- 理解且鲁棒(UR),即正向问题和负向问题都答对

- 理解但脆弱(UF),即答对了正向问题但答错负向问题

- 不理解但严谨(NR),即答错了正向问题但答对负向问题

- 不理解且脆弱(NF),即正向问题和负向问题都答错

为量化MLLMs对负面问题的鲁棒性和实际理解能力,我们引入了“误导率(MR)”和“鲁棒性准确率(RA)”,误导率(MR)能够反映出模型面对误导性问题时的鲁棒性,鲁棒性准确率(RA)能够反映出模型在严格条件下答对问题的准确率。二者公式如下:

其中表示4种结果的样本数量。通过结合评估指标 MR 和 RA,我们的MMR 基准不但可以准确反映模型的基本理解能力,而且能够深刻揭示模型对具有误导性提示的问题的鲁棒性。

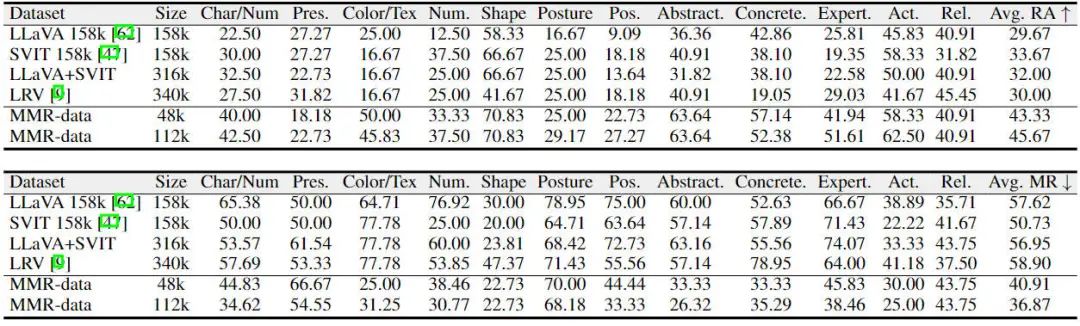

多模态大语言模型在 MMR benchmark 上表现

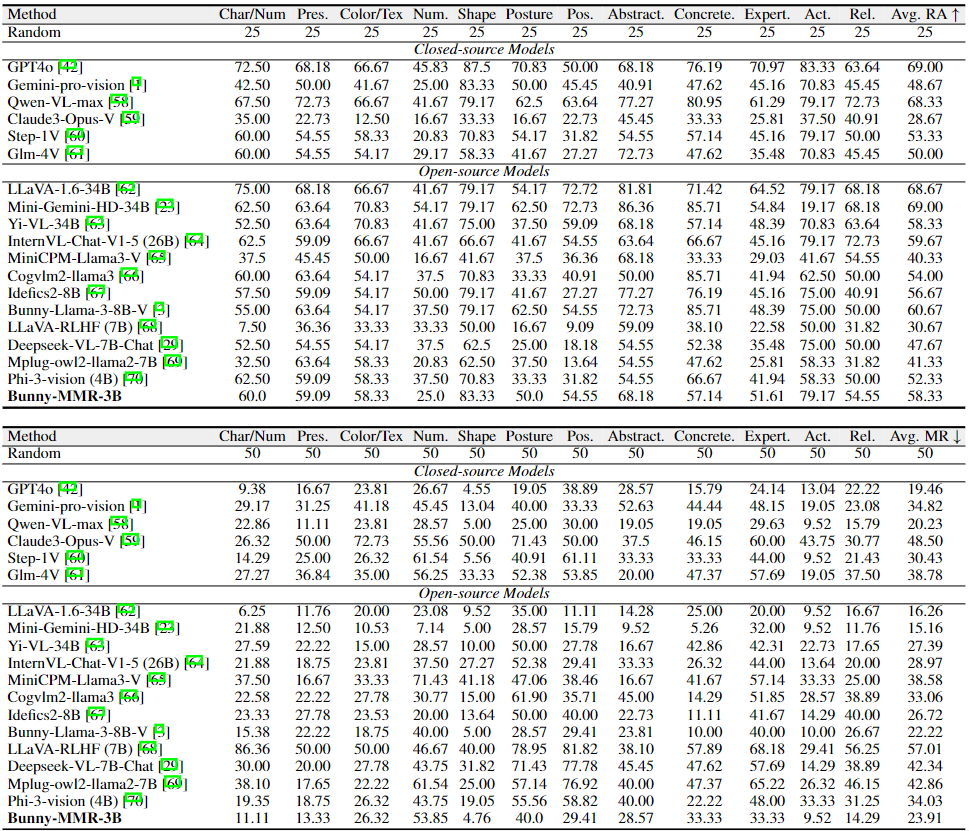

下表展示了 6 个闭源模型和 12 个主流开源MLLMs在 MMR 基准上的表现。结论如下:

- 尽管理解了视觉内容,但无论是开源还是闭源模型都对负面问题表现出脆弱性。在闭源模型中,GPT-4o表现最佳;而在开源模型中,Mini-Gemini-HD-34B以69.0%的RA指标领先。然而,与Mini-Gemini-HD-34B相比,GPT-4o对负面问题更为敏感,其MR为19.46%,而Mini-Gemini-HD-34B为15.16%。

- 模型特别容易受到涉及字符级细节、数字、位置、背景、专业知识以及语境等问题的影响。

- 模型在具有较高正面理解能力的子类别上往往表现出更强的抗干扰能力。

指令调优数据集构造

为增强 MLLMs 的理解能力和鲁棒性,我们提出了一种数据构建方法,利用GPT-4V生成成对的正面和负面样本进行指导调优,如图2 所示。包括三个步骤:

- 信息提取。我们从图像中隐式和全面地提取这些详细信息,包括文本、物体属性、人物特征、物体之间关系,人物之间关系,事件和整体感知。

- 指导调优数据生成。我们通过提取的信息生成正面样本,并构建直接与正面样本相矛盾的负面样本。

- 样本过滤。通过关键词匹配过滤样本,去除包含不确定答案和冗余短语的样本。

图3 指令调优数据集构造过程。

图3 指令调优数据集构造过程。

实验结果

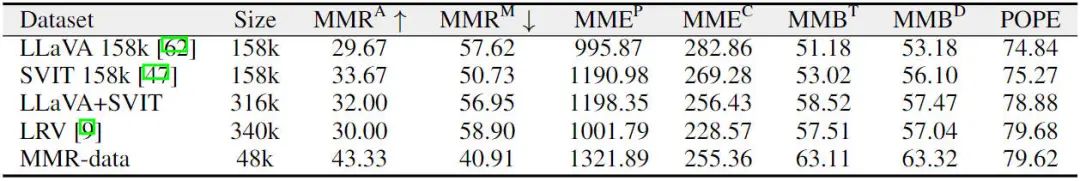

通过使用构建的数据集进行实验,我们在MMR基准测试及其他通用基准测试中的结果如下表所示。实验结果表明,与使用同类数据训练相比,模型在使用构建的数据集训练时表现出更优越的性能。这表明,构造的数据集能够显著提升模型理解能力和在面对误导性问题时的鲁棒性。

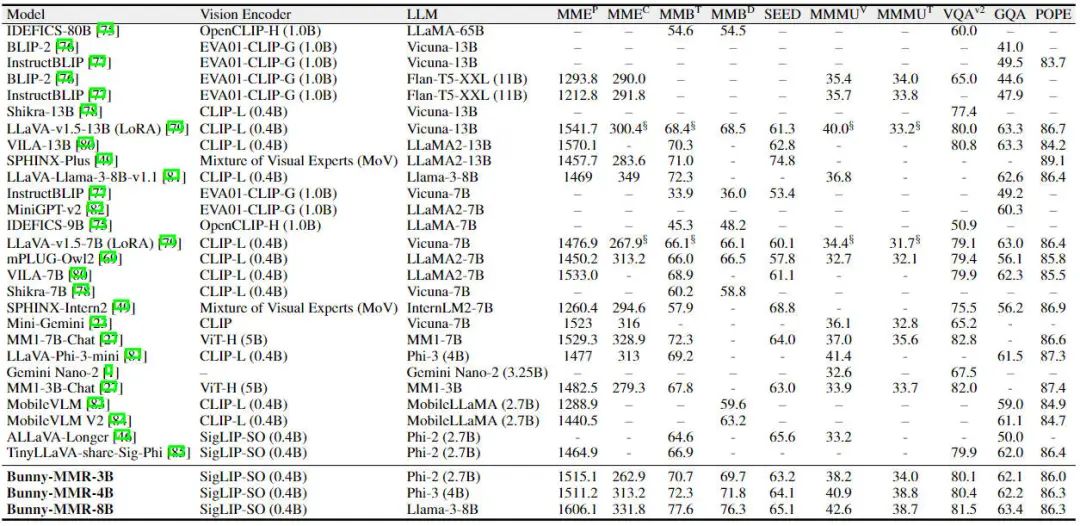

在现有数据集的基础上,我们加入了一些其他对话数据,总共构建了649k的数据集,并使用不同的语言模型进行训练。通过与其他模型的对比实验,结果表明,所构建的数据集能够显著提升模型性能。具体实验结果如下表所示。

结语

本研究深入探讨了多模态大语言模型(MLLMs)在准确解读视觉内容并应对负面问题时面临的挑战。我们发现,尽管MLLMs展示出对视觉内容细致的理解,但在面对负面问题时往往会出现不准确的答案。

为了量化评估MLLMs的表现,我们引入了MMR评估框架,旨在全面衡量其对视觉内容的理解和抗负面问题的鲁棒性。同时,我们提出了一种数据构建方法,并引入了高质量的微调数据,以提升MLLMs的鲁棒性和理解能力。

这项研究强调了改进评估方法和数据策略对于推动 MLLMs 在实际应用中性能提升的重要性。

数据,代码与模型均已开源

-

论文地址:https://arxiv.org/abs/2406.10638

-

项目地址:https://github.com/BAAI-DCAI/Multimodal-Robustness-Benchmark

-

benchmark和数据集下载地址:https://huggingface.co/datasets/BAAI/Multimodal-Robustness-Benchmark

-

模型地址:

-

- https://huggingface.co/AI4VR/Bunny-MMR-3B

- https://huggingface.co/AI4VR/Bunny-MMR-4B

- https://huggingface.co/AI4VR/Bunny-MMR-8B

-

在线demo地址:http://mmr.dataoptim.org/

如何学习AI大模型?

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型商业化落地方案

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。