- 1MySQL下载和自定义安装教程(8.0.34)_mysql8.0.34安装教程

- 2docker-compose 部署flink集群_docker-compose flink

- 3Spark--Spark编程基础和编程进阶知识总结(第三章和第四章)_spark基础实验和编程基础总结与分析

- 4Go 之 工具库 samber/lo_go 类似 lodash的

- 5数据结构与算法:查找_数据结构与算法 查找

- 6NLTK下载punkt、stopsword_nltk punkt

- 7PLC原理及PLC+FPGA(SOC)架构方案简介_plc fpga

- 8七个国内可用的人工智能,PC端与手机端皆可免费使用,提高你的工作效率_天工ai电脑版怎么下载

- 9分享web前端开发的一些面试经验(持续更新中……)_前端开发面试搞

- 10回头看,已过去6载

LVS负载均衡群集+NAT部署_云计算lvs集群

赞

踩

一、LVS负载均衡群集

1.群集的定义及作用

1)群集的定义

Cluster,集群(也称群集)由多台主机构成,但对外只表现为一一个整体,只提供一-个访问入口(域名或IP地址), 相当于一台大型计算机。

2)群集的作用

对于企业服务的的性能提升一般会有两种方式:

纵向扩展 : 对服务器的CPU 内存 硬盘 等硬件进行升级或者扩容来实现的 性能上限会有瓶颈,成本昂贵,收效比不高等问题

横向扩展 : 通过增加服务器主机数量来应该高并发的场景

3)群集的目的

- 提高性能:计算密集应用。如天气预报,核试验模拟。

- 降低成本:相对百万美元的超级计算机,价格便宜。

- 提高可扩展性:只要增加集群节点即可。

- 增强可靠性:多个节点完成相同功能,避免单点失败。

4) 企业级群集的类型

负载均衡(LB):提高应用系统的响应效率,处理更多的访问请求,减少延迟,提高并发和负载能力。 同时也是如今企业运用最多的群集类型。

高可用(HA): 提高应用系统的可靠性,减少服务中断时间,确保服务的连续性

高性能运算(HPC):将多台主机的硬件计算资源整合到一起实现分布式运用,比如 云计算

二、LVS负载均衡群集运用

1.LVS的相关解释

DS:Director Server。指的是前端负载均衡器。

RS:Real Server。节点服务器,后端真实的工作服务器。

VIP:向外部直接面向用户请求,作为用户请求的目标的IP地址。

DIP:Director Server IP,主要用于和内部主机通讯的IP地址。

RIP:Real Server IP,后端服务器的IP地址。

CIP:Client IP,访问客户端的IP地址。

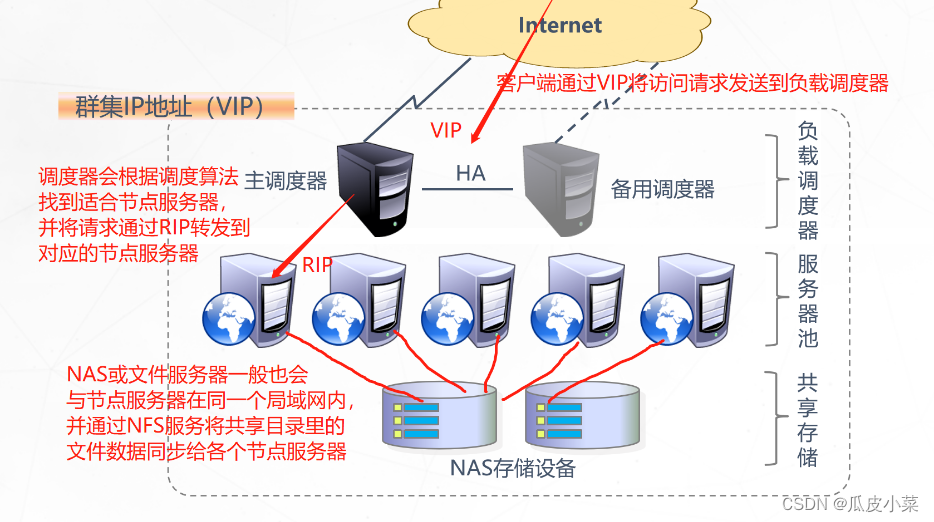

2.负载均衡群集架构

第一层:负载调度器 :通过VIP接收用户的请求,再通过调度算法确定要转发的节点服务器

访问整个群集系统的唯一入口,对外使用所有服务器共有的VIP地址,也称为群集 IP地址。通常会配置主、备两台调度器实现热备份,当主调度器失效以后能够平滑 替换至备用调度器,确保高可用性。

第二层:服务器池中的节点服务器 : 通过RIP接收调度器转发来的请求,并处理请求进行响应

群集所提供的应用服务、由服务器池承担,其中每个节点具有独立的RIP地址(真 实IP),只处理调度器分发过来的客户机请求。当某个节点暂时失效时,负载调度 器的容错机制会将其隔离,等待错误排除以后再重新纳入服务器池。

第三层:共享存储 :为各个节点服务器提供稳定、一致的文件存取服务,比如NAS+NFS,文件服务器+NFS,分布式对象存储等存储设备

为服务器池中的所有节点提供稳定、一致的文件存取服务,确保整个群集的统一性 共享存储可以使用NAS设备,或者提供NFS共享服务的专用服务器。(因为节点服务器的资源都是由NAS或NFS提供,所以NAS或NFS需要做主备、或分布式,从而实现高可用。)

3. LVS的基本原理

1.当用户向负载均衡器(Director Server)发起请求,调度器将请求发送至内核空间。

2.Prerouting链首先会接收到用户请求,判断目标IP确定是本机IP,将数据包发送到INPUT链。

3.IPVS是工作在INPUT链上的,当用户请求到达INPUT时,IPVS会将用户请求和自己已经定义好的集群服务进行对比,如果用户请求的就是定义的集群服务,那么此时IPVS会强行修改数据包里的目标IP地址及端口,并将新的数据包发送到POSTROUTING链。

4.POSTROUTING链接收数据包后发现目标IP地址刚好是自己的后端服务器,那么此时通过选路,将数据包最终发送到后端的服务器。

4.LVS负载均衡的三种模式

群集的负载调度技术有三种工作模式:地址转换(NAT模式) ,直接路由(DR模式),IP隧道(IP-TUN)。对于商用来说,最常用是NAT模式和DR模式。

1) NAT(地址转换)

缺点:调度器作为所有节点服务器的网关,既作客户端的访问入口,也作节点服务器响应的访问出口,也就意味着调度器将成为整个集群系统的瓶颈。

优点:由于再转发过程中做了地址转发,对于节点服务器的安全性比其它模式较好。

调度器至少要有2个网卡,一个承载VIP用于接收客户端的请求,另一个用于使用私有IP在同一个局域网中与节点服务器相互通信。

2) DR(直接路由)

特点: 调度器只负责接收客户端的请求,并根据调度算法转发给节点服务器;节点服务器在处理完请求后是直接响应返回给客户端,响应的数据包不经过调度器。DR模式要求调度器与后端服务器必须在同一个局域网内,VIP地址需要在调度器与后端所有的服务器间共享 。 性能比NAT模式高。调度器和节点服务器使用私有IP在同一个局域网中与节点服务器相互通信

3) TUN(IP隧道)

架构与DR相类似,但是节点服务器分散在互联网各个位置,都具有独立的公网IP,通过专用IP隧道与调度器相互通信

采用开放式的网络结构,负载调度器仅作为客户机的访问入口,各节点通过各自的Internet连接直接回应客户机,而不再经过负载调度器。承载的压力比NAT小。

服务器节点分散在互联网中的不同位置,具有独立的公网IP地址,通过专用IP隧道与负载调度器相互通信。

缺点:成本很高。

这种模式一般应用于特殊场景,比如将节点服务器分布在全国各地,防止被物理攻击(如地震、战争等),做灾备。

5.LVS的负载调度算法

1)固定调度算法:rr, wrr, dh,sh

rr:轮询算法(Round Robin)

- 将请求依次分配给不同的RS节点,即RS节点中均摊分配。适合于RS所有节点处理性能接近的情况。

- 将收到的访问请求安装顺序轮流分配给群集指定各节点(真实服务器),均等地对待每一台服务器,而不管服务器实际的连接数和系统负载。

wrr:加权轮询调度(Weighted Round Robin)

- 依据不同RS的权重值分配任务。权重值较高的RS将优先获得任务,并且分配到的连接数将比权值低的RS更多。相同权值的RS得到相同数目的连接数。

- 保证性能强的服务器承担更多的访问流量。

dh:目的地址哈希调度(destination hashing)

- 以目的地址为关键字查找一个静态hash表来获得所需RS。

sh:源地址哈希调度(source hashing)

- 以源地址为关键字查找--个静态hash表来获得需要的RS

2) 动态调度算法: wlc,lc,lblc

lc:最小连接数调度( Least Connections)

- ipvs表存储了所有活动的连接。LB会比较将连接请求发送到当前连接最少的RS。

- 根据真实服务器已建立的连接数进行分配,将收到的访问请求优先分配给连接数最少的节点。

wlc:加权最小连接数调度(Weighted Least Connections)

- 假设各台RS的权值依次为Wi,当前tcp连接数依次为Ti,依次取Ti/Wi为最小的RS作为下一个分配的RS。

- 在服务器节点的性能差异较大时,可以为真实服务器自动调整权重。

- 性能较高的节点将承担更大比例的活动连接负载。

lblc:基于地址的最小连接数调度(locality-based least-connection)

将来自同一个目的地址的请求分配给同一-台RS,此时这台服务器是尚未满负荷的。否则就将这个请求分配给连接数最小的RS,并以它作为下一次分配的首先考虑。

三、 LVS部署的工具和ip_vs通用模块

1. ipvsadm 工具选项说明

| ipvsadm的选项 | 作用 |

| -A | 添加虚拟服务器 |

| -D | 删除整个虚拟服务器 |

| -s | 指定负载调度算法(轮询:rr、加权轮询:wrr、最少连接:lc、加权最少连接:wlc) |

| -a | 表示添加真实服务器(节点服务器) |

| -d | 删除某一个节点 |

| -t | 指定 VIP地址及 TCP端口 |

| -r | 指定 RIP地址及 TCP端口 |

| -m | 表示使用 NAT群集模式 |

| -g | 表示使用 DR模式 |

| -i | 表示使用 TUN模式 |

| -w | 设置权重(权重为 0 时表示暂停节点) |

| -p 60 | 表示保持长连接60秒(默认关闭连接保持) |

| -l | 列表查看 LVS 虚拟服务器(默认为查看所有) |

| -n | 以数字形式显示地址、端口等信息,常与“-l”选项组合使用。ipvsadm -ln |

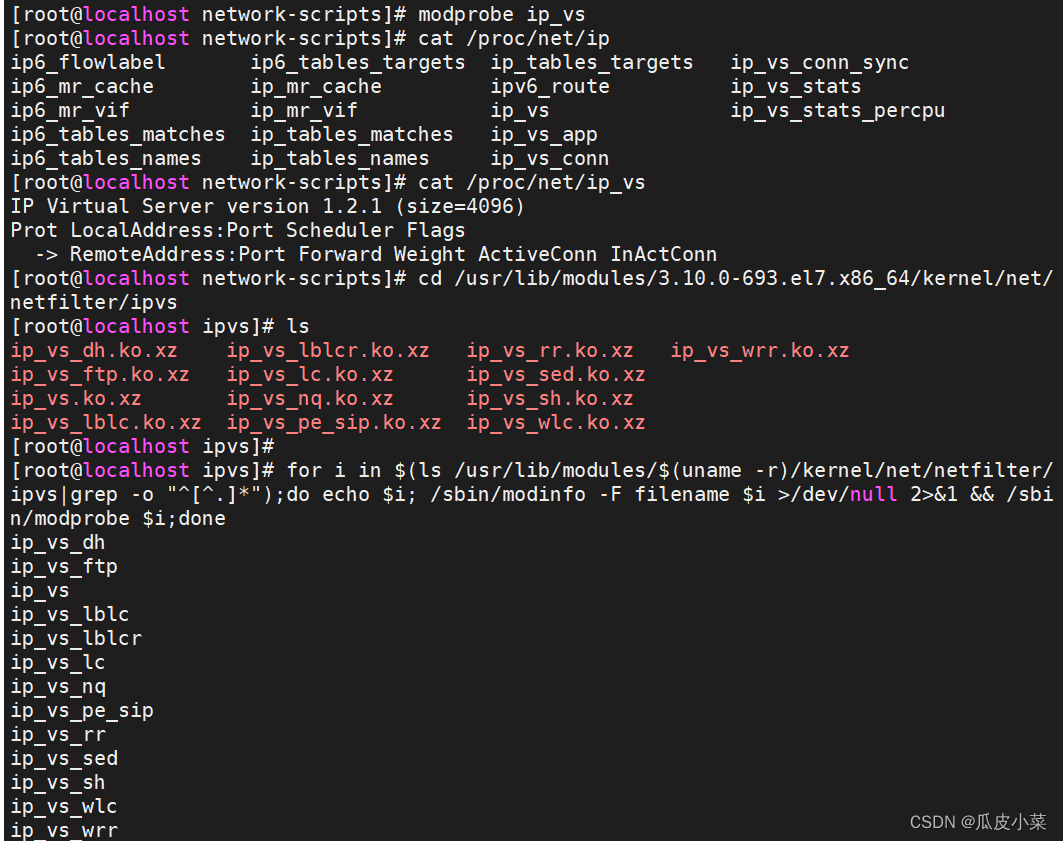

2. ip_vs通用模块

ls /usr/lib/modules/3.10.0-693.el7.x86_64/kernel/net/netfilter/ipvs

LVS现在已成为 Linux 内核的一部分,默认编译为 ip_vs 模块,必要时能够自动调动。

在CentOS 7 系统中,手动加载 ip_vs 模块的命令如下:

modprobe ip_vs //手动加载 ip_vs 模块

cat /proc/net/ip_vs //查看当前系统中ip_vs模块的版本信息

四、NAT模式 -LVS负载均衡群集部署

1.实验设备准备

需要五台虚拟机(一台web1服务器,一台web2服务器,一台负载均衡调度器,一台NFS共享存储机,一台外网客户机做测试作用)

各设备的IP设置如下:

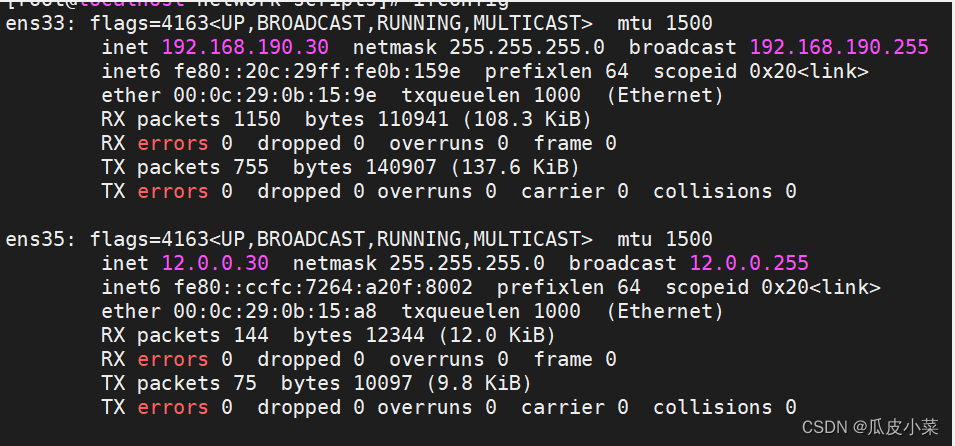

负载调度器:内网关 ens33:192.168.190.30,外网关 ens36:12.0.0.1

Web节点服务器1:192.168.190.40

Web节点服务器2:192.168.190.50

NFS服务器:192.168.190.60

客户端:12.0.0.12

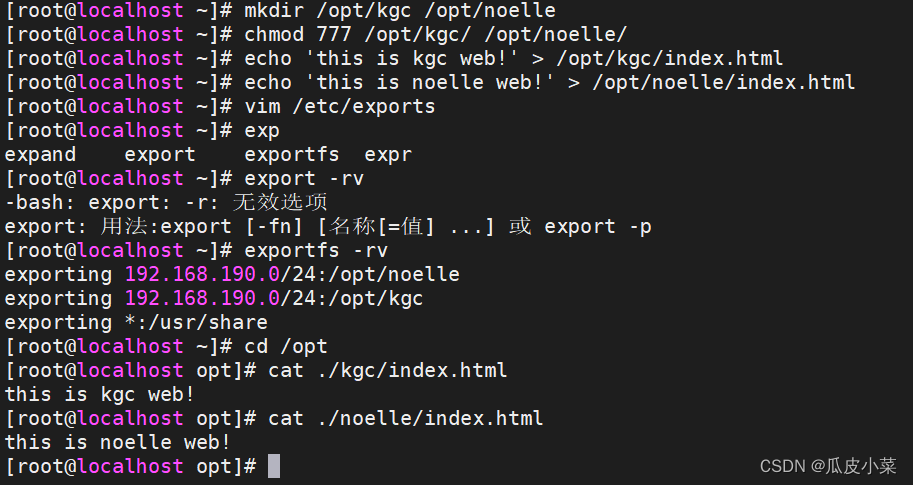

2.部署共享存储(NFS服务器:192.168.190.60)

- systemctl stop firewalld.service

- systemctl disable firewalld.service

- setenforce 0

-

- yum install nfs-utils rpcbind -y

- systemctl start rpcbind.service

- systemctl start nfs.service

-

- systemctl enable nfs.service

- systemctl enable rpcbind.service

-

- mkdir /opt/kgc /opt/noelle

- chmod 777 /opt/kgc /opt/noelle

- echo 'this is kgc web!' > /opt/kgc/index.html

- echo 'this is noelle web!' > /opt/noelle/index.html

-

- vim /etc/exports

- /usr/share *(ro,sync)

- /opt/web1 192.168.190.0/24(rw,sync)

- /opt/web2 192.168.190.0/24(rw,sync)

-

- --发布共享---

- exportfs -rv

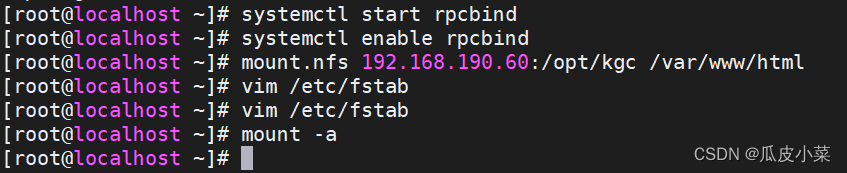

3.配置节点服务器(192.168.190.40、192.168.190.50)

1)两台web节点服务器相同的操作:

- systemctl stop firewalld.service

- systemctl disable firewalld.service

- setenforce 0

- vim /etc/selinux/config

- SELINUX=disabled

-

- yum install httpd -y

- systemctl start httpd.service

- systemctl enable httpd.service

-

- yum install nfs-utils rpcbind -y

- showmount -e 192.168.190.60

-

- systemctl start rpcbind

- systemctl enable rpcbind

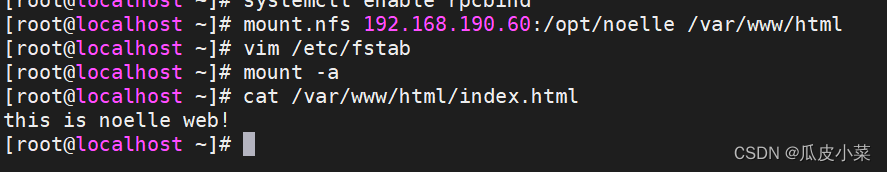

2) web1节点服务器的后续操作

- mount.nfs 192.168.190.60:/opt/kgc /var/www/html

-

- vim /etc/fstab

- 192.168.190.60:/opt/kgc /var/www/html nfs defaults,_netdev 0 0

- mount -a

3)web2节点服务器的后续操作:

- mount.nfs 192.168.190.60:/opt/web2 /var/www/html

- vim /etc/fstab

- 192.168.190.60:/opt/web2 /var/www/html nfs defaults,_netdev 0 0

-

-

- mount -a

4.配置负载调度器(内网关 ens33:192.168.190.30,外网关 ens35:12.0.0.30)

- systemctl stop firewalld.service

- systemctl disable firewalld.service

- setenforce 0

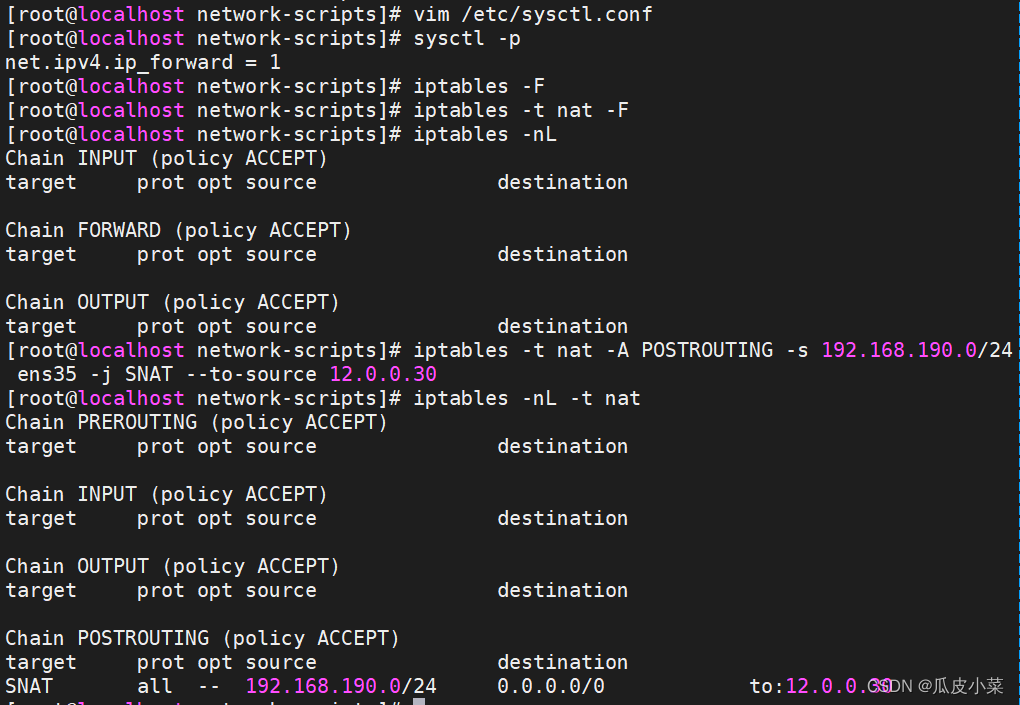

1)配置SNAT转发规则

1)配置SNAT转发规则

- vim /etc/sysctl.conf

- net.ipv4.ip_forward = 1

- 或 echo '1' > /proc/sys/net/ipv4/ip_forward

- sysctl -p

-

- iptables -t nat -F

- iptables -F

- iptables -t nat -A POSTROUTING -s 192.168.190.0/24 -o ens36 -j SNAT --to-source 12.0.0.1

2)加载LVS内核模块

- modprobe ip_vs #加载 ip_vs模块

- cat /proc/net/ip_vs #查看 ip_vs版本信息

-

- for i in $(ls /usr/lib/modules/$(uname -r)/kernel/net/netfilter/ipvs|grep -o "^[^.]*");do echo $i; /sbin/modinfo -F filename $i >/dev/null 2>&1 && /sbin/modprobe $i;done

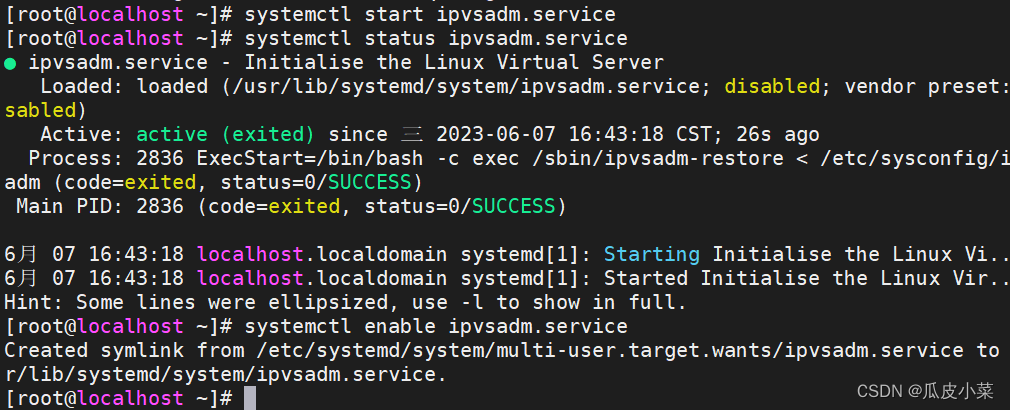

3)安装ipvsadm 管理工具

- yum -y install ipvsadm

-

- --启动服务前须保存负载分配策略---

- ipvsadm-save > /etc/sysconfig/ipvsadm

- 或者 ipvsadm --save > /etc/sysconfig/ipvsadm

-

- systemctl start ipvsadm.service

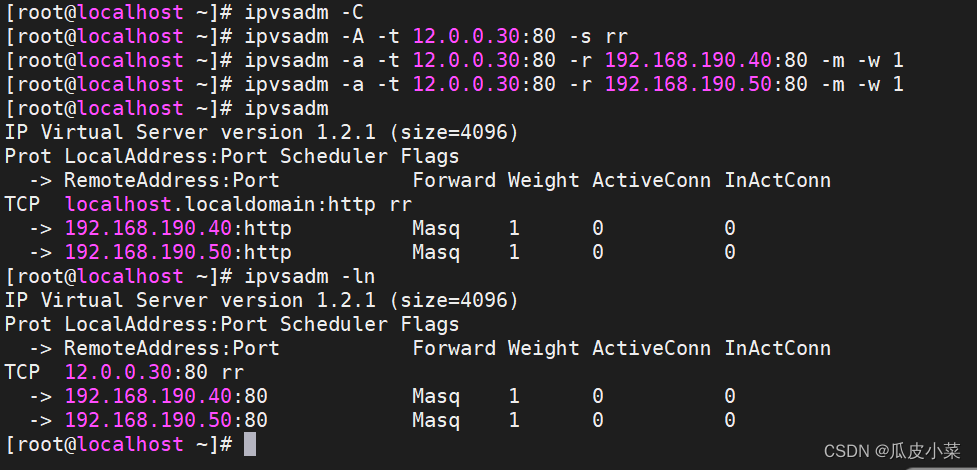

4)配置负载分配策略(NAT模式只要在服务器上配置,节点服务器不需要特殊配置)

- ipvsadm -C #清除原有策略

- ipvsadm -A -t 12.0.0.1:80 -s rr [-p 60]

- ipvsadm -a -t 12.0.0.1:80 -r 192.168.190.40:80 -m [-w 1]

- ipvsadm -a -t 12.0.0.1:80 -r 192.168.190.50:80 -m [-w 1]

- ipvsadm #启用策略

-

- ipvsadm -ln #查看节点状态,Masq代表 NAT模式

- ipvsadm-save > /opt/ipvsadm #保存策略

- ipvsadm-save > /etc/sysconfig/ipvsadm

- -------------------------------------------------------------------------------------------

5) 保存LVS的配置策略以及删除策略的方法

- ipvsadm-save > /opt/ipvsadm #保存策略

- ipvsadm-save > /etc/sysconfig/ipvsadm

- ----------------------------------------------------------------------------------------------------------

- ipvsadm -d -t 12.0.0.1:80 -r 192.168.190.40:80 #删除群集中某一节点服务器

- ipvsadm -D -t 12.0.0.1:80 #删除整个虚拟服务器

- systemctl stop ipvsadm #停止服务(清空策略)

- systemctl start ipvsadm #启动服务(根据/etc/sysconfig/ipvsadm重建配置)

- ipvsadm-restore < /opt/ipvsadm #恢复LVS 策略

5.客户机测试

在一台IP为12.0.0.12的客户机使用浏览器访问 http://12.0.0.30/ ,不断刷新浏览器测试负载均衡效果,刷新间隔需长点(或者关闭Web服务的连接保持)。