热门标签

热门文章

- 1AI绘画最强修脸插件还能控制表情哦!_ad修脸

- 2【开源鸿蒙】编译OpenHarmony轻量系统QEMU RISC-V版_openharmony qemu

- 3多旋翼无人机仿真 rotors_simulator 是如何悬停的(一)_msgmultidofjointtrajectoryfrompositionyaw

- 4auto cad破解_lockup.lsp

- 5网络层_路由器使用层次跟处理对象

- 6与 AI/ML 一起领导创新,减少技术债务,提高效率_ml系统的技术债都有什么

- 7ELK性能优化实战总结:java的list集合详解_java elk技术分享

- 8基于OpenCV的人脸检测软件(含Python源码+UI界面+图文详解)_人脸分析程序

- 9HTML parser_htmldocumentparser

- 10【Scopus稳定检索】第五届城市工程与管理科学国际会议(ICUEMS 2024)_icuems2024

当前位置: article > 正文

使用Ubuntu在本地部署ChatGLM3-6B的详细教程_ubtantu 部署chartglm

作者:码创造者 | 2024-08-12 05:53:28

赞

踩

ubtantu 部署chartglm

一:环境配置

1.python环境

python版本推荐3.10 - 3.11

transformers库版本推荐为4.36.2

torch推荐使用 2.0 及以上的版本,以获得最佳的推理性能

2.硬件环境

查看显卡配置:nvidia-smi

运行 Int4 版本的 ChatGLM3-6B的最低配置:

内存:>= 8GB

显存:>= 5GB(1060 6GB,2060 6GB)

二:下载 ChatGLM3-6B模型

1. 从 Hugging Face 官网下载模型。

使用这种方法,下载模型需要先安装Git LFS

git lfs install

git clone https://huggingface.co/THUDM/chatglm3-6b

如果访问不到Hugging Face的官网则可以使用镜像网站:

THUDM/chatglm3-6b · HF Mirror (hf-mirror.com)

2.从GitHub官网下载运行模型所需要的文件:

GitHub - THUDM/ChatGLM3: ChatGLM3 series: Open Bilingual Chat LLMs | 开源双语对话语言模型

三:运行ChatGLM3-6B模型

1.通过pycharm中命令行建立conda环境

conda create -n chatglm3-demo python=3.11

2.执行conda环境

conda activate chatglm3-demo

出现如下界面则成功:

![]()

3.下载模型所需要的依赖

pip install -r requirements.txt

4.本地运行模型:

1.加载本地模型文件,并量化

2.网页版界面启动

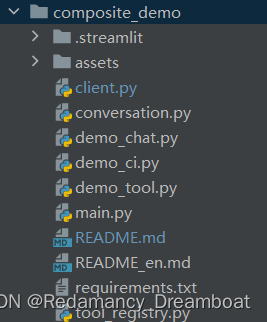

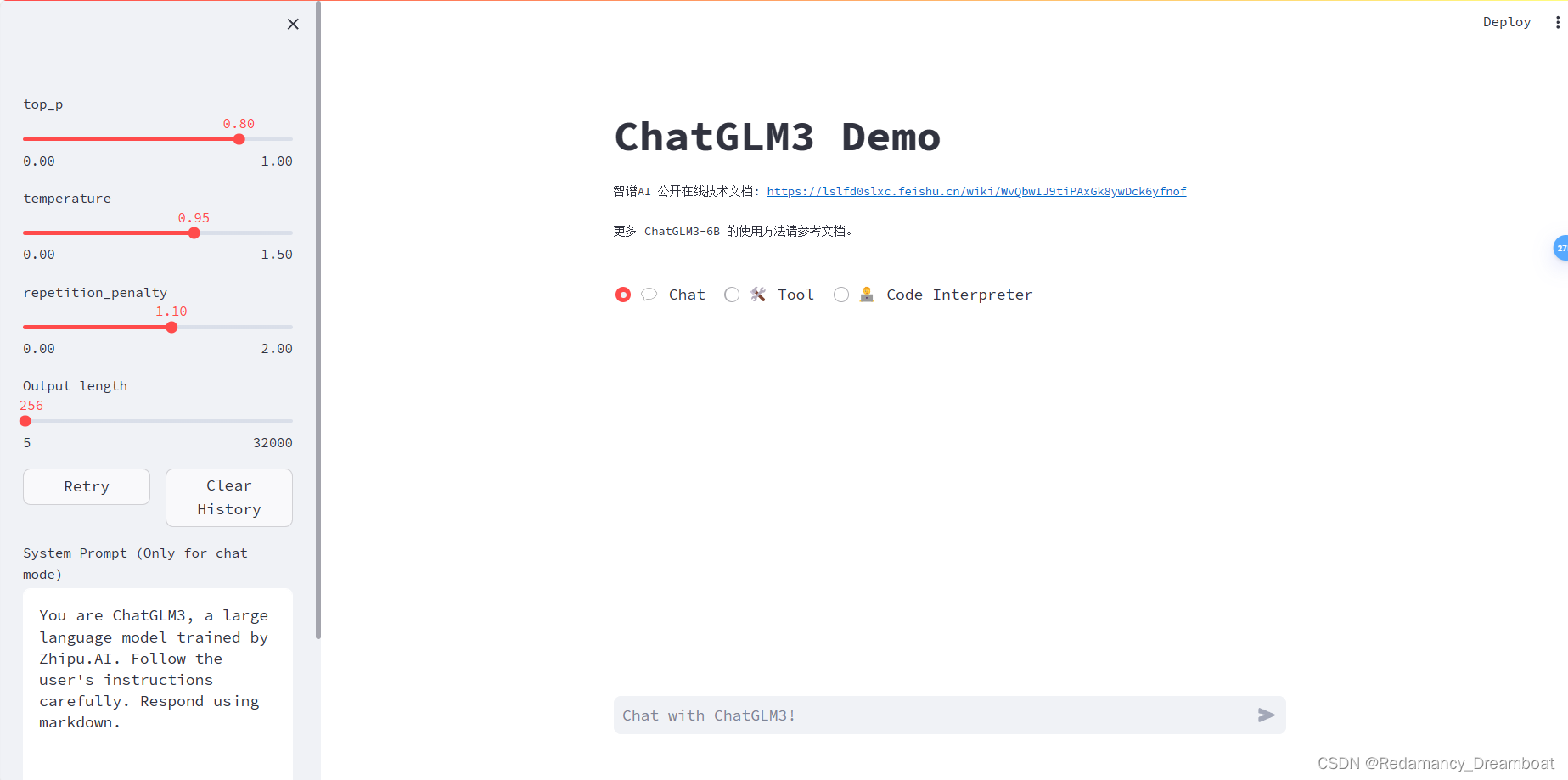

进入composite_demo模块,运行如下代码:streamlit run main.py

- cd composite_demo #进入模块

- streamlit run main.py # 启动网页版界面

网页版界面:

3.命令行模式启动

进入basic_demo模块,在命令行运行cli_demo.py文件启动命令行模式的ChatGLM3-6B模型,输入如下命令启动:

- cd basic_demo # 进入模块

- python cli_demo.py # 运行py文件

命令行界面:

这样使用ubuntu在本地部署ChatGLM3-6B模型就部署好啦

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/码创造者/article/detail/968001

推荐阅读

相关标签