热门标签

热门文章

- 1rabbitMQ是什么,为什么这么快_rabbitmq为什么快

- 2java基础之list 与set集合(ArrayList,LinkedList,HashSet,LinkedHashSet,TreeSet)_java存放list的集合

- 3git clone报错 过早结束问题解决方法_fatal: 远端意外挂断了

- 4基于Python爬虫北京景点数据可视化系统设计与实现(Django框架) 研究背景与意义、国内外研究现状_爬虫抓取北京旅游景点_旅游网站国内外研究现状

- 5OpenCV基础入门系列基本操作——壹_( 5分 ) 定义一个容量为256的float型数组,遍历图像的每个像素,并计算直方图,

- 6CCIG学术论坛|文档解析技术加速大模型训练与应用

- 7Android studio升级Giraffe | 2022.3.1 Patch 1踩坑_android studio 升级 2022.3.1注意

- 87款读文献的AI神器,可总结分析文件、读论文必备!_国内分析文档内容的ai

- 9Python3 No module named ‘_sqlite3‘错误解决方案_python3 no module named sqlite3

- 10香橙派 AIpro 评测与使用心得

当前位置: article > 正文

五种即插即用的视觉注意力模块

作者:秋刀鱼在做梦 | 2024-06-25 21:23:04

赞

踩

全局注意力模块

点击上方“小白学视觉”,选择加"星标"或“置顶”

重磅干货,第一时间送达关注获取更多计算机视觉与深度学习知识

详解SE、CA、ECA、GAM、CBAM 五种即插即用的视觉注意力模块

SE注意力模块

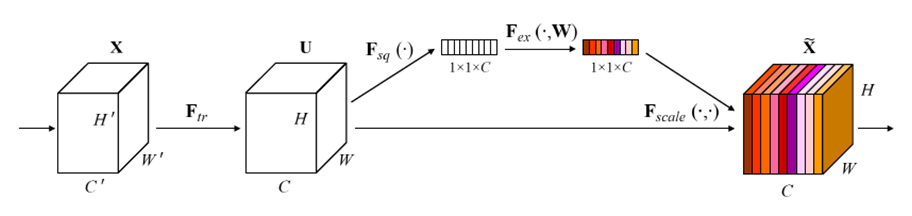

SE注意力模块的全称是Squeeze-and-Excitation block、其中Squeeze实现全局信息嵌入、Excitation实现自适应权重矫正,合起来就是SE注意力模块。

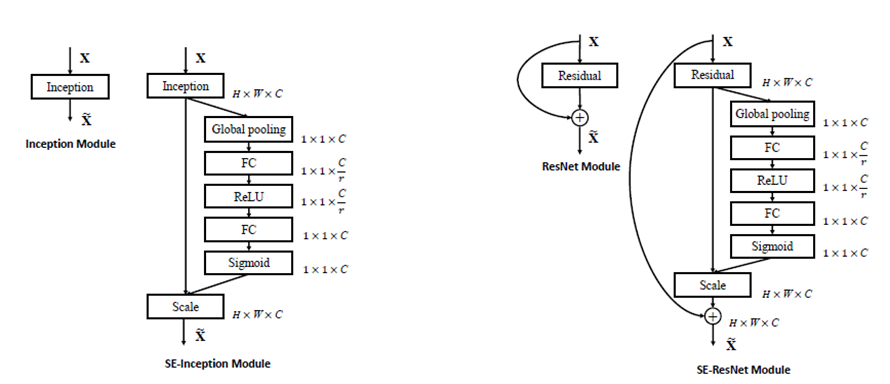

把SE注意力模块添加到Inception Module中与ResNet的残差Module中,实现SE注意力版本的Inception与ResNet模型

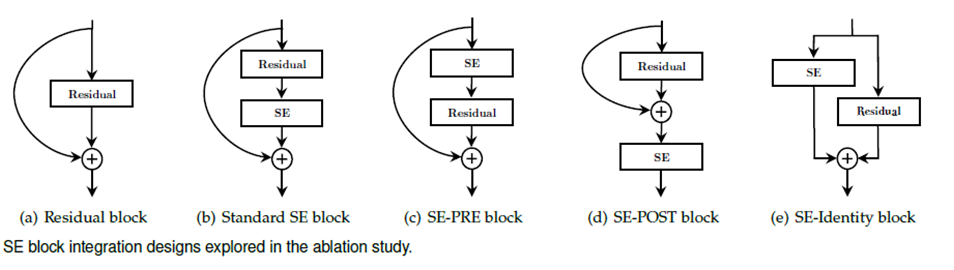

SE注意力模块集成残差的四种不同结构设计

CA注意力模块

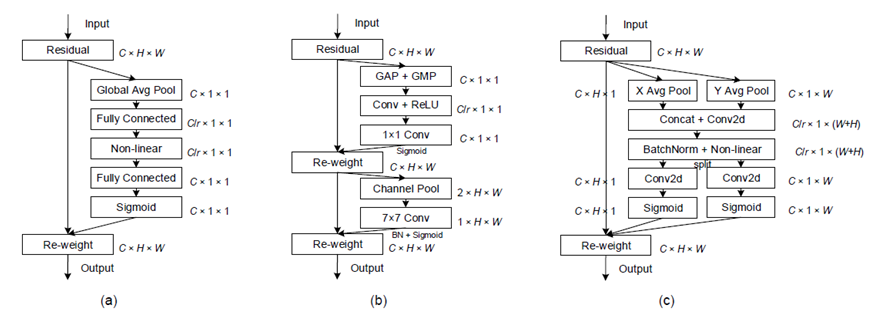

图中最右侧是CA注意力模块、左侧是SE注意力模块、中间是CBAM注意力模块、CA注意力通过坐标信息嵌入和坐标注意力生成两个步骤把通道关系和长程依赖关系精确编码。

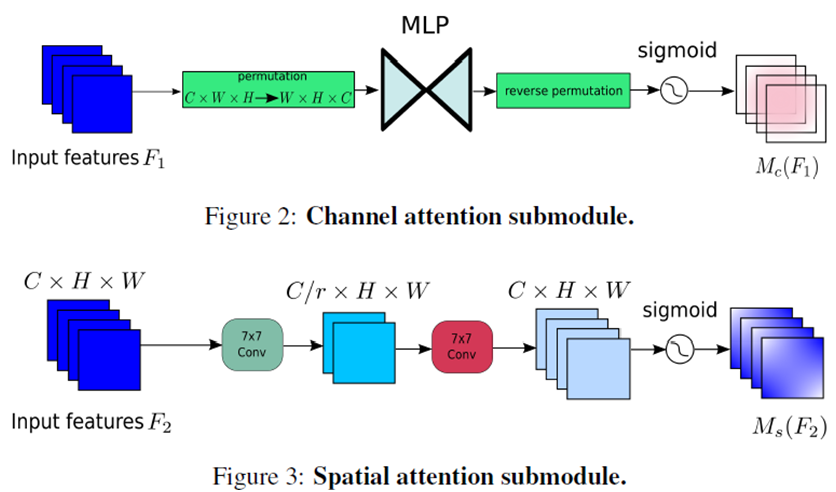

CBAM注意力模块

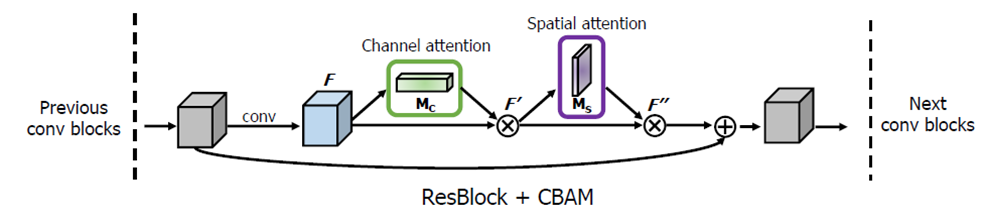

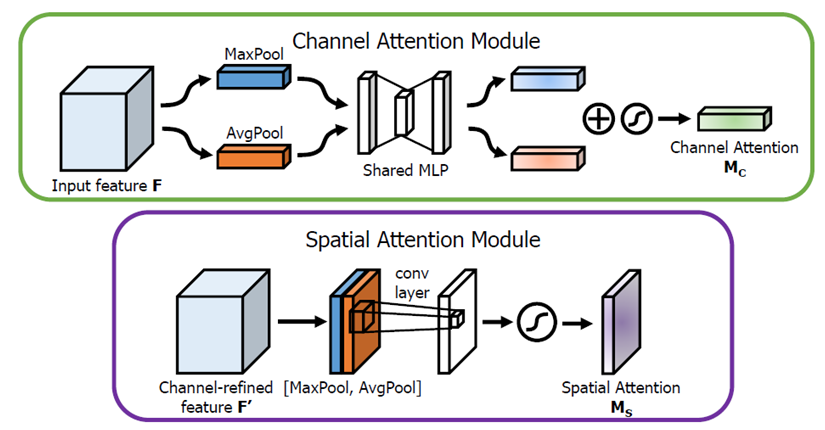

该图显示了如何把一个CBAM模块集成到到一个残差模块中,实现残差CBAM模块,CBAM是集成了通道注意力与空间注意力、通道和空间注意力模块生成首先是通过平均池化和最大池化分别生成通道与空间注意力的输入,然后通过MLP与7x7卷积输出通道子模块和空间子模块。

ECA注意力模块

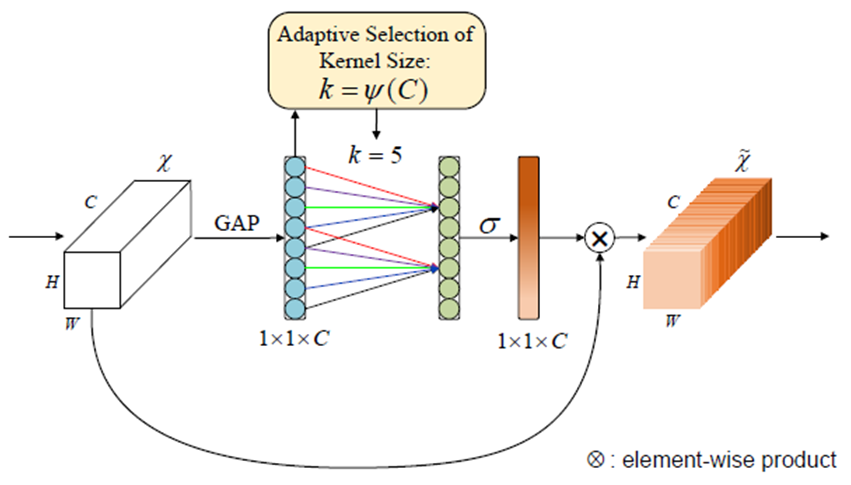

通过全局均值池化(GAP)获得的聚合通道特征,然后通过大小为k滤波器的快速1D卷积,然后重新构建一个维的卷积输出结果,乘以输入的每个通通道数据作为输出实现注意力机制为ECA。

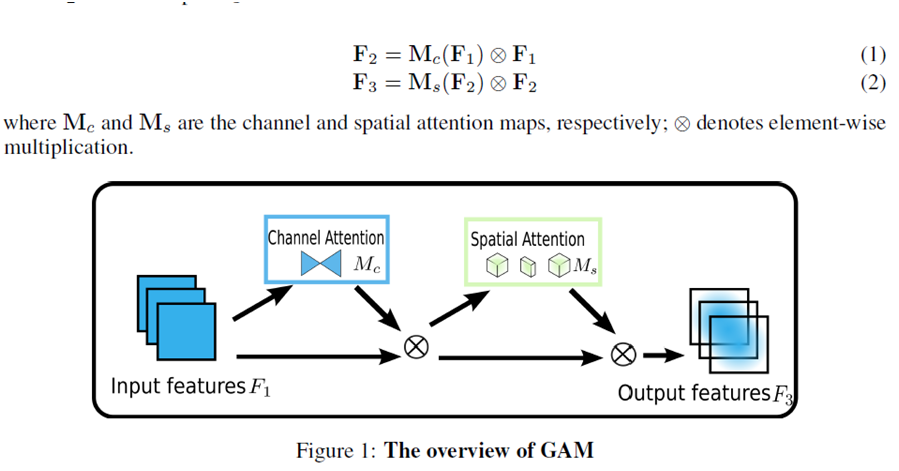

GAM注意力模块

全局注意力模块基于CBAM注意力模块集成上重新设计通道与空间两个子模块实现,其中通道注意力直接使用MLP实现、空间注意力通过两个7乘7的卷积实现,最终GAM注意力添加到ResNet网络的效果相比SE注意力、CBAM注意力有明显提升。

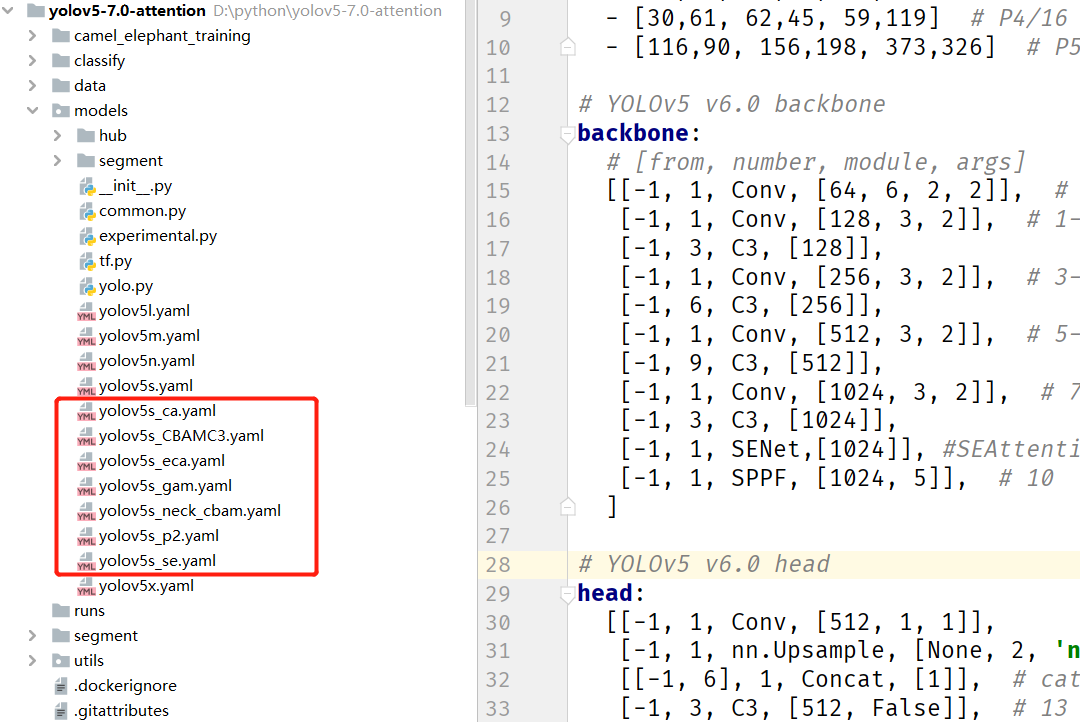

YOLOv5 7.0 注意力加持版本

- 下载1:OpenCV-Contrib扩展模块中文版教程

-

- 在「小白学视觉」公众号后台回复:扩展模块中文教程,即可下载全网第一份OpenCV扩展模块教程中文版,涵盖扩展模块安装、SFM算法、立体视觉、目标跟踪、生物视觉、超分辨率处理等二十多章内容。

-

-

- 下载2:Python视觉实战项目52讲

- 在「小白学视觉」公众号后台回复:Python视觉实战项目,即可下载包括图像分割、口罩检测、车道线检测、车辆计数、添加眼线、车牌识别、字符识别、情绪检测、文本内容提取、面部识别等31个视觉实战项目,助力快速学校计算机视觉。

-

-

- 下载3:OpenCV实战项目20讲

- 在「小白学视觉」公众号后台回复:OpenCV实战项目20讲,即可下载含有20个基于OpenCV实现20个实战项目,实现OpenCV学习进阶。

-

-

- 交流群

-

- 欢迎加入公众号读者群一起和同行交流,目前有SLAM、三维视觉、传感器、自动驾驶、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三 + 上海交大 + 视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/秋刀鱼在做梦/article/detail/757404

推荐阅读

相关标签