热门标签

热门文章

- 1Python学习笔记31:进阶篇(二十)pygame的使用之图形绘制_python生成的矩形和椭圆的图形

- 2Python爬虫案例解析:五个实用案例及代码示例(学习爬虫看这一篇文章就够了)_python抓取数据案例_爬虫案例题目

- 3C++并发编程(七)无锁数据结构_c++ 无锁编程

- 4当当网销售数据的爬取与可视化分析_针对当当网畅销书籍榜单前500的研究分析

- 5Flink sql-client save checkpoint 测试_flink sql client checkpoint

- 6as中项目导入as时遇到问题_on root project 'cas-server' of type org.gradle.ap

- 7如何学习python数据分析?_如何学习python进行数据分析

- 8SQLserver使用临时表代替游标遍历_sql 游标和临时表的区别

- 9使用OpenAI Agent构建查询引擎工具_ai agent 查询引擎

- 10探索 Rust-CPP:在 Rust 中直接嵌入 C++ 代码的创新方案

当前位置: article > 正文

flash attention的重点解读和CUDA编程实现-V2_flash attention v2cuda并行

作者:秋刀鱼在做梦 | 2024-07-13 00:06:30

赞

踩

flash attention v2cuda并行

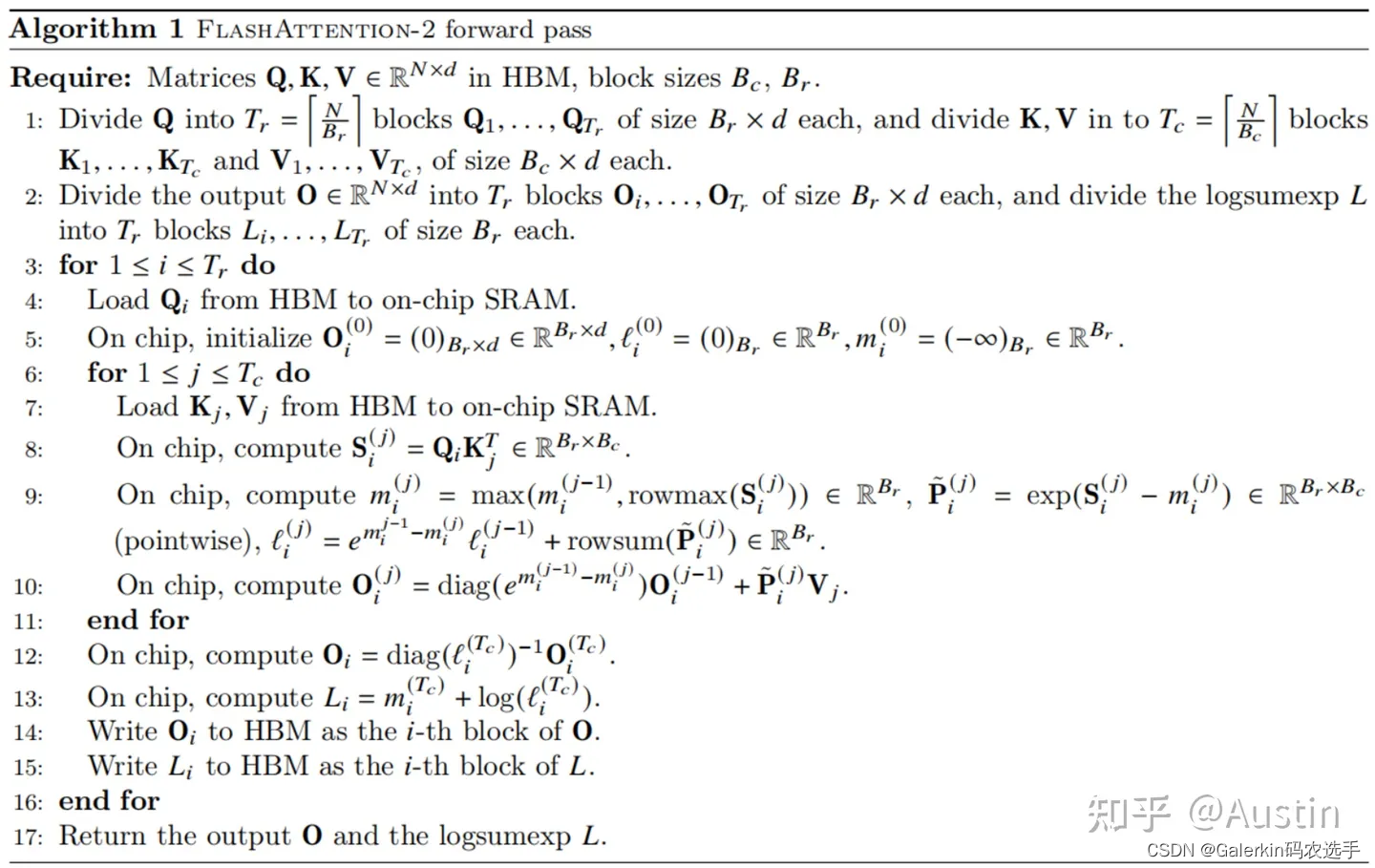

在上一篇博客添加链接描述我们介绍了flash attention的基本原理以及基本实现,然而有许多地方有无法解释的内容,这里本人尝试对flash attention做一个细致的解释,下面我们描述的都是如下图的flash attention V2。

flash attention的并行度

上面这个图片展示的是串行算法的思想,但是我们并行CUDA代码肯定是并行的,因此我们需要考虑上面这个算法的并行度从何而来。我们来看下面这个分块过程:

直接考虑输出矩阵 O i ∈ R B T × d O

推荐阅读

相关标签