AI表情神同步!LivePortrait安装配置,一键包,使用教程

赞

踩

快手在AI视频这领域还真有点东西,视频生成工具“可灵”让大家玩得不亦乐乎。

现在又开源了一款超好玩的表情同步(表情控制)项目。

一看这图片,就知道是小视频平台出的,充满了娱乐性。发布没几天就已经有8000+Star。

项目简介

LivePortrait 是一款由快手团队开发的高效肖像动画工具,通过隐式关键点框架,从静态图像生成动态视频。该工具可以让用户通过驱动视频生成逼真的面部表情和头部动作。这款工具不仅可以用于人脸动画,还能扩展到动物肖像,提供了广泛的应用场景。

该项目主页核心介绍其实就一句话“Bring portraits to life!” 可以理解为让“ 将肖像变得栩栩如生!”。

下面先简单说一下这个项目的特点,然后分享一下本地安装方法,最后是一件包和使用方法!

项目特点

表情神同步

这个项目的表情同步非常传神,这也是这个项目最大的特点。

嘴巴和眼神的同步,比较惊艳。

可以驱动图片和视频

可以用一段带有人物脸部表情的视频去驱动一张图片,同时也可以用视频驱动视频。

前者高效,只要你能拿到一张脸部照片,就可以让这张照片开口说话,做出各种表情。

后者高能,用视频驱动视频,会显得效果更加自然。

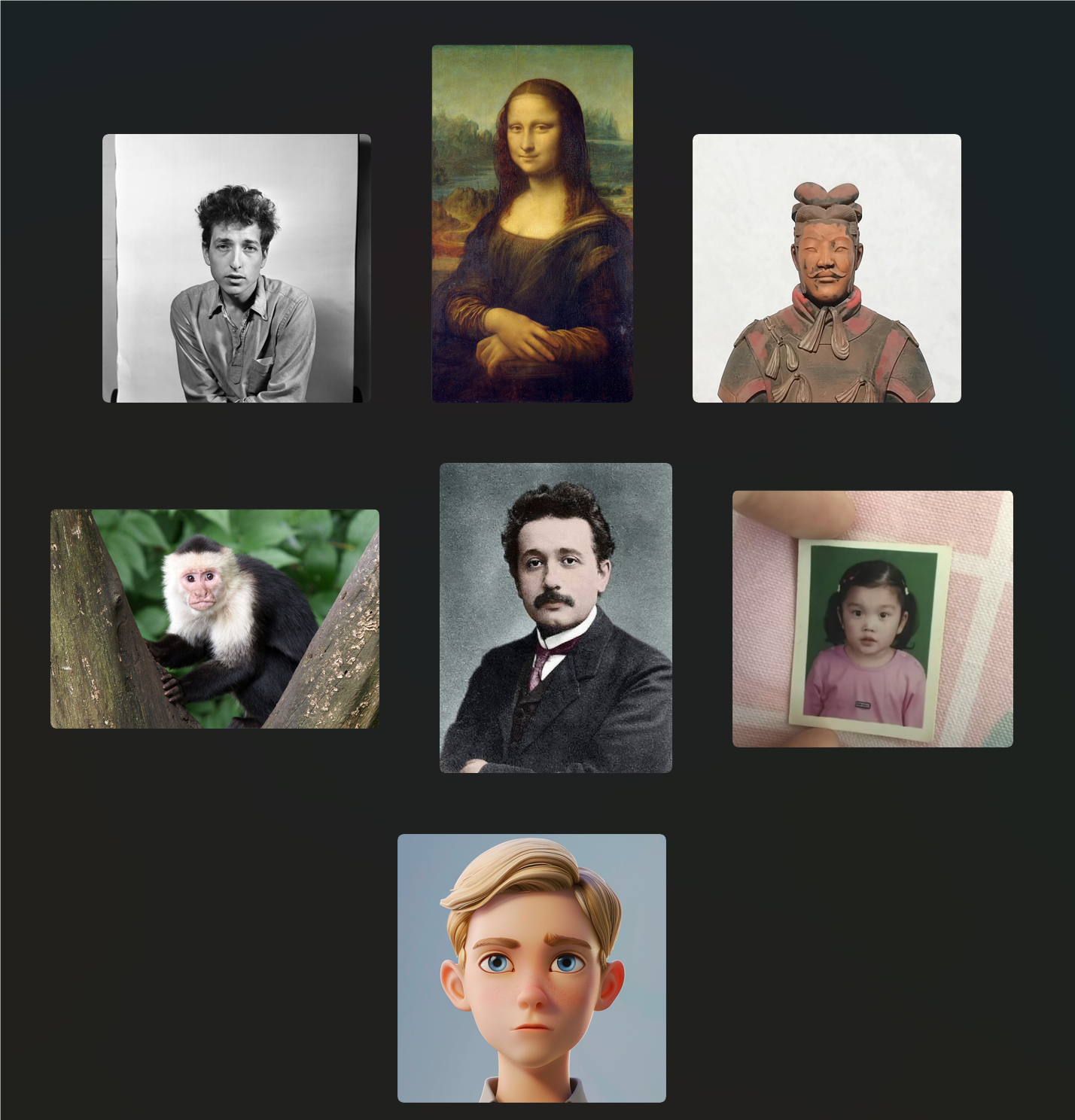

素材支持广泛

只要是带脸和五官的东西,基本都能玩。

“肖像”可以包括 真人照,动漫人物,名画中的人物,甚至是兵马俑和动物。

单独修改眼睛和嘴巴

除了视频生成之外,还可以“一键P图”。

就是那种一键闭眼一键睁眼。一键闭嘴一键张嘴那种。当然也可以,闭上眼张开嘴。有一定的可玩性。

电脑配置要求低

AI视频和AI绘画是非常消耗配置的项目,比如很多基于SDXL的AI绘画类项目,模型动不动就是10G+,显存需求动不动就是16G+甚至24G。但是这个项目好很多,预训练模型才600M+。模型小就意味着显存需求也很低!

安装配置比较简单

这个项目配置起来非常简单。只需要根据项目主页的命令一行一行复制、粘贴、运行即可。Windows下安装依赖无需踩坑,直接装就可以了。除了Windows之外也支持基于M系列的macOS系统。

本地安装

云端的都是别人的,本地的才是自己的。下面来说一说如何本地安装,如果看过我之前的安装配置的文章,这个项目的安装会非常简单。

先保证本地电脑已经具备如下软硬件:

- NVIDIA中高端显卡

- Windows11系统

- Python环境

- Git工具

外加,懂一点CMD命令。就可以立马开干了。

克隆代码

使用git命令克隆源代码。

- git clone https://github.com/KwaiVGI/LivePortrait

- cd LivePortrait

克隆源代码之后,使用cd命令,进入到项目文件夹。

创建虚拟环境

使用conda工具创建一个虚拟环境,做本地隔离。

-

- conda create -n LivePortrait python=3.10

- conda activate LivePortrait

创建一个名为LivePortrait的基于Python3.10的虚拟环境,并且激活这个虚拟环境。

安装依赖

Python环境创建之后之后,通过req依赖文件,一键安装依赖

- # 针对 Linux and Windows 用户

- pip install -r requirements.txt

-

- # 针对macOS M系列

- pip install -r requirements_macOS.txt

注意,Windows和Linux用户用上面的命令,使用requirements.txt里的依赖列表来安装。Macos的用户使用专属的macOS.txt文件来安装。

安装之前要保证网络通畅,或者设置好了pip镜像。

下载模型

经过上面的步骤,安装配置就已经完成了。接下来是要获取模型。

通过命令获取:

- #安装lfs,已经装过可以忽略

- git lfs install

-

- #下载模型

- git clone https://huggingface.co/KwaiVGI/LivePortrait temp_pretrained_weights

- mv temp_pretrained_weights/* pretrained_weights/

- rm -rf temp_pretrained_weights

这些命令会从huggingface上下载模型,并放置到pretrained_weights文件中,由于HF已经被嗝屁了,所以局域网用户可能不是太方便。

通过网盘获取:

项目主页给出了百度盘,谷歌盘,我也会整理好放在我的网盘,见文末。

模型的文件的目录结构如下:

- pretrained_weights

- ├── insightface

- │ └── models

- │ └── buffalo_l

- │ ├── 2d106det.onnx

- │ └── det_10g.onnx

- └── liveportrait

- ├── base_models

- │ ├── appearance_feature_extractor.pth

- │ ├── motion_extractor.pth

- │ ├── spade_generator.pth

- │ └── warping_module.pth

- ├── landmark.onnx

- └── retargeting_models

- └── stitching_retargeting_module.pth

模型并不是很大,网络好的话,下载起来很轻松。

快速运行推理

模型下载完成,并放置到指定路径之后,就可以运行了。

无界面运行:

- # Linux and Windows

- python inference.py

-

- # For macOS with Apple Silicon, Intel not supported, this maybe 20x slower than RTX 4090

- PYTORCH_ENABLE_MPS_FALLBACK=1 python inference.py

直接用Python运行推理文件,这样软件会自动找演示素材,自动合成视频。

这种方式适合开发者快速验证环境,但是使用起来不是很方便。所以推荐第二种运行式。

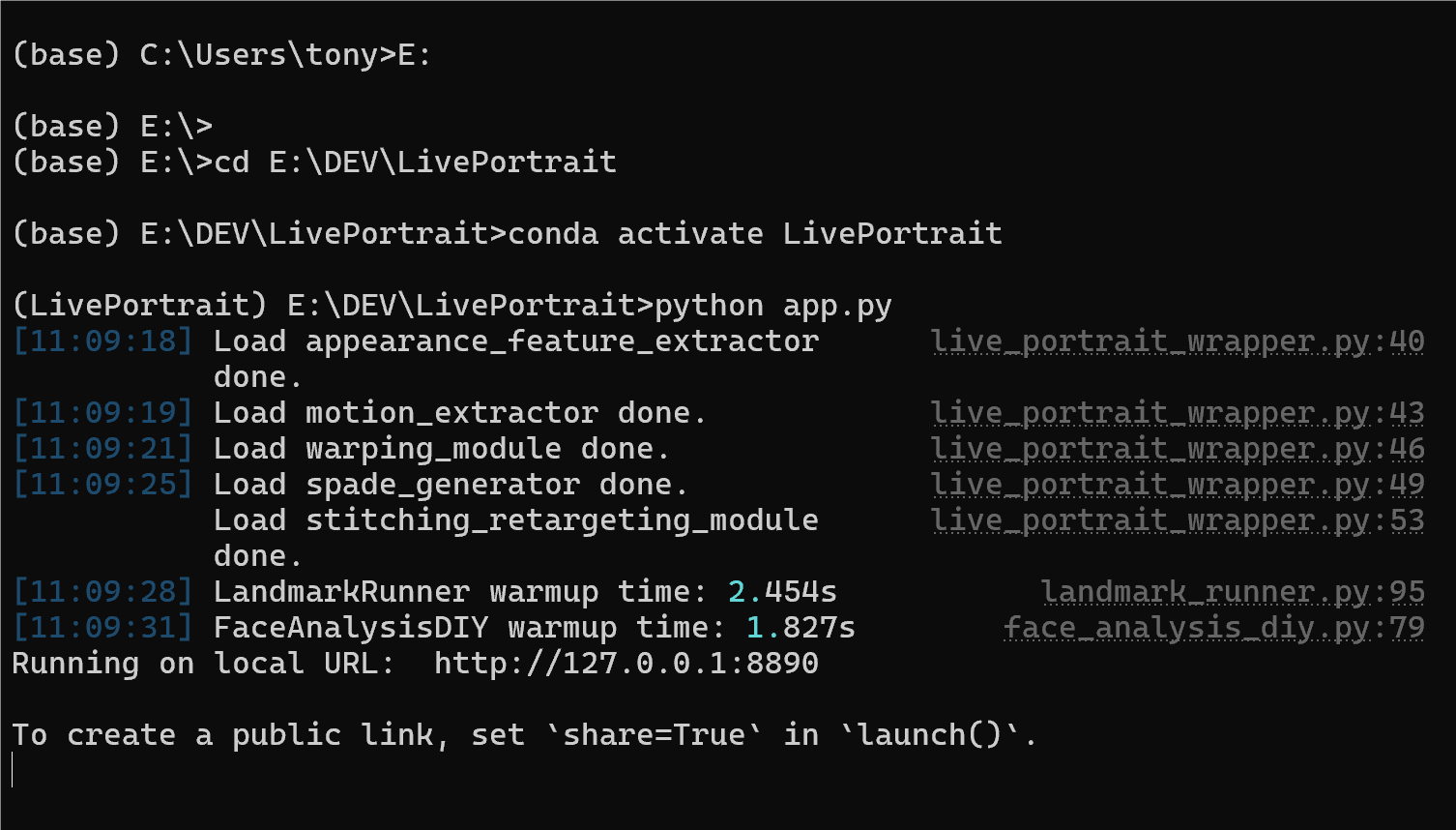

使用网页版:

- # For Linux and Windows users (and macOS with Intel??)

- python app.py

-

- # For macOS with Apple Silicon users, Intel not supported, this maybe 20x slower than RTX 4090

- PYTORCH_ENABLE_MPS_FALLBACK=1 python app.py

运行上述命令之后,就会使用基于Gradio的WEBUI了。

安装配置运行完成之后,下次要再次使用,输入如下命令即可。

切换到项目文件夹所在盘,比如E盘,

然后使用CD命令进入文件夹,

然后激活虚拟环境,

然后运行app.py。

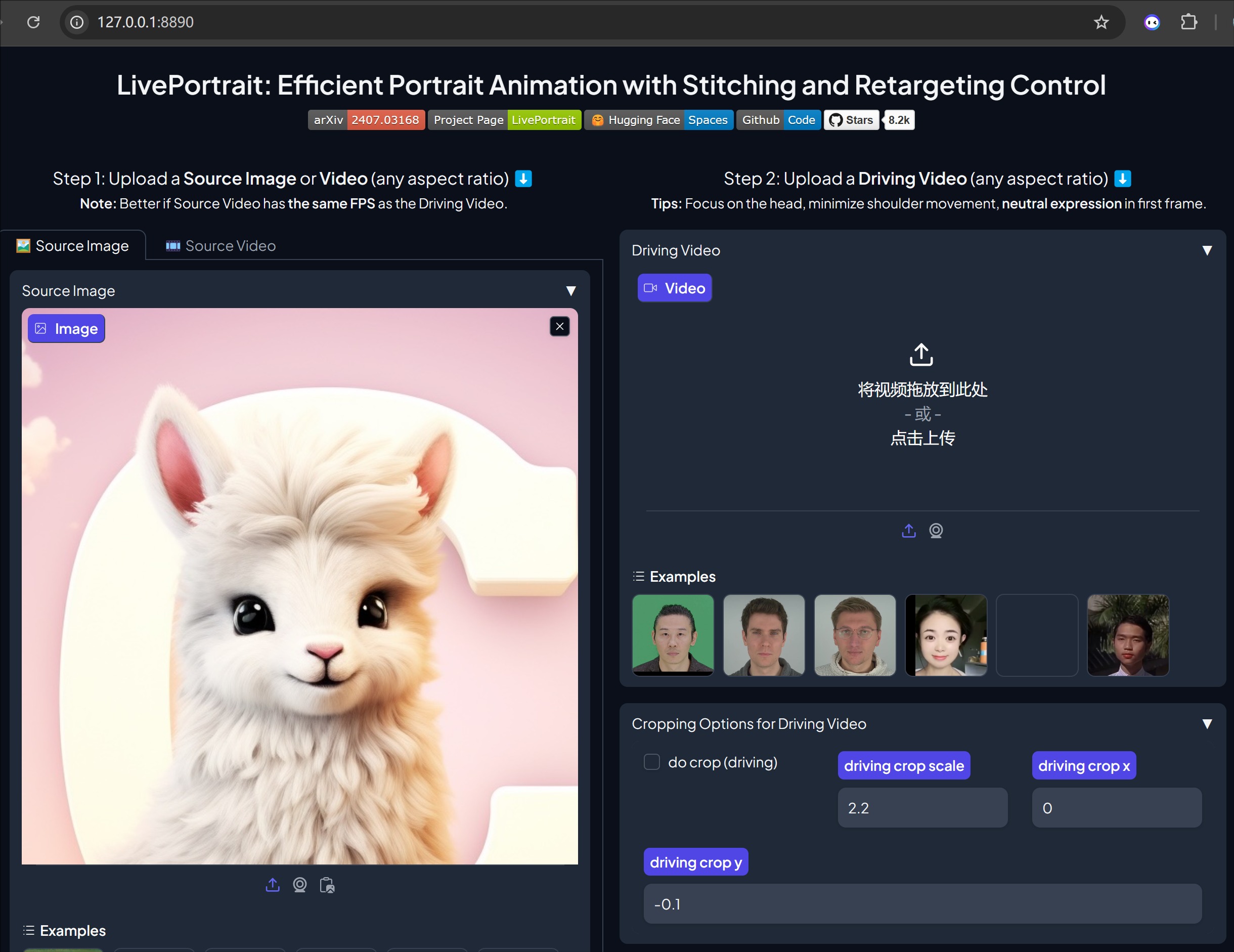

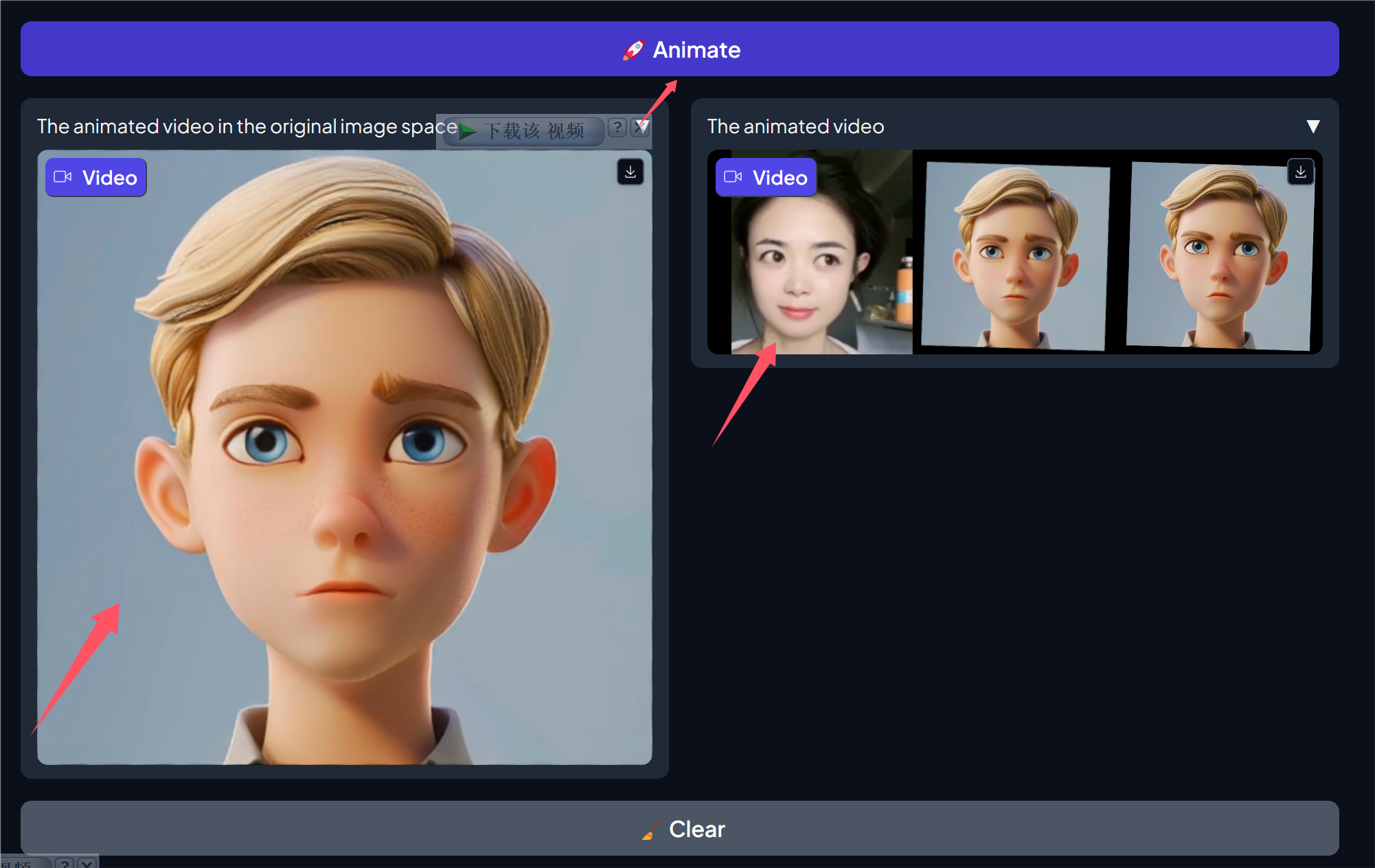

网页版使用说明

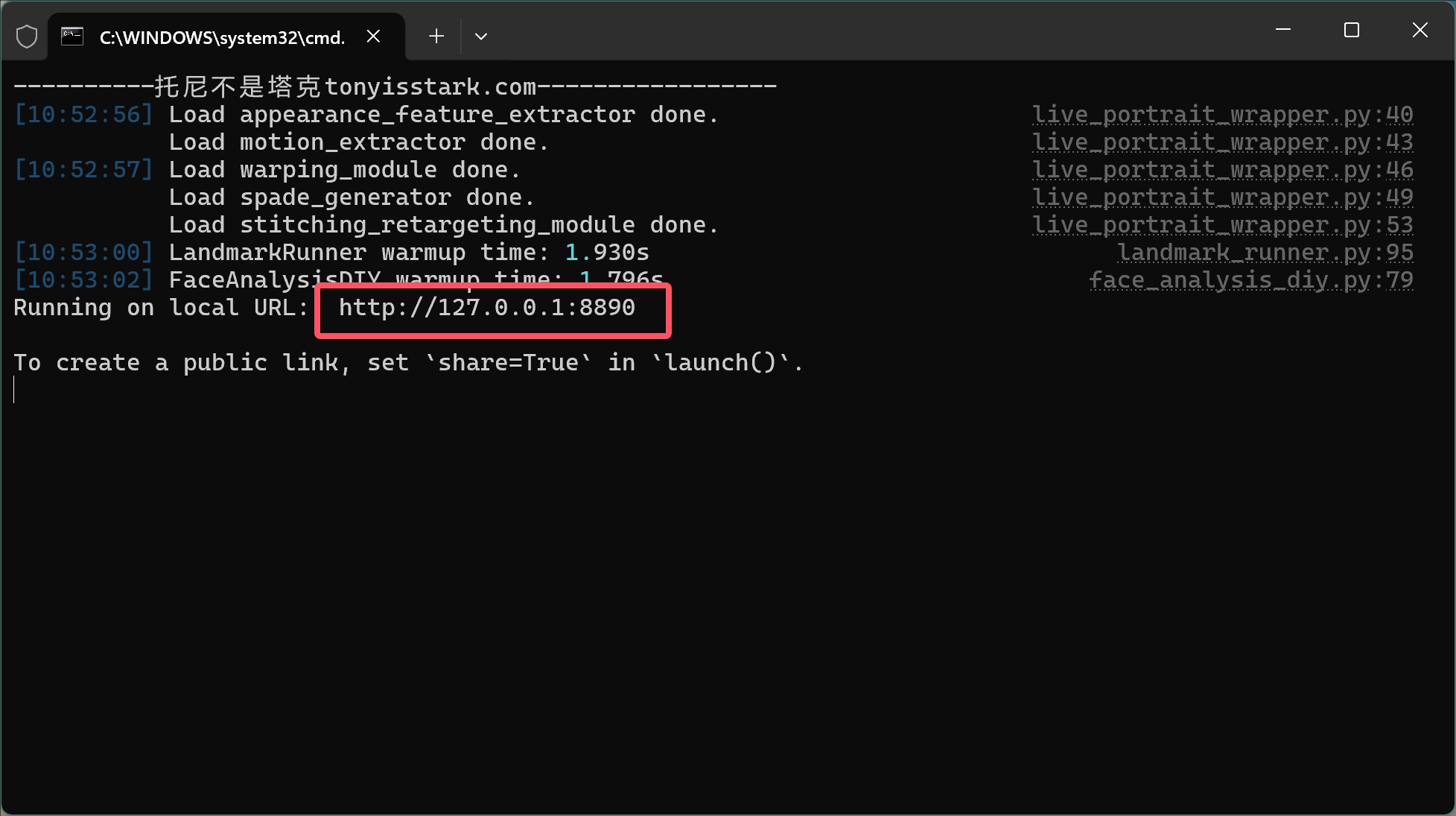

运行成之后,复制URL地址到浏览器打开,就可以看到界面了。

①左边上传源(Source)素材

②右边上传驱动(Driving Video)视频

③点击动画按钮(Animate)开始合成

这里的源素材,可以是图片,也可以是视频。而驱动视频自然自能是视频。界面上有一些参数,默认即可。

视频处理完成之后,就会显示在下面了。

左边是被驱动的图片,右边的是效果对比图。界面上只有三个头像的对比视频。

如果需要合成的最终视频,就是包含整个人物的完整视频,可以在文件夹中找到。

文件夹路径为:LivePortrait\animations

RTX3060上面,整个过程消耗了5.8G显存,125秒时间。

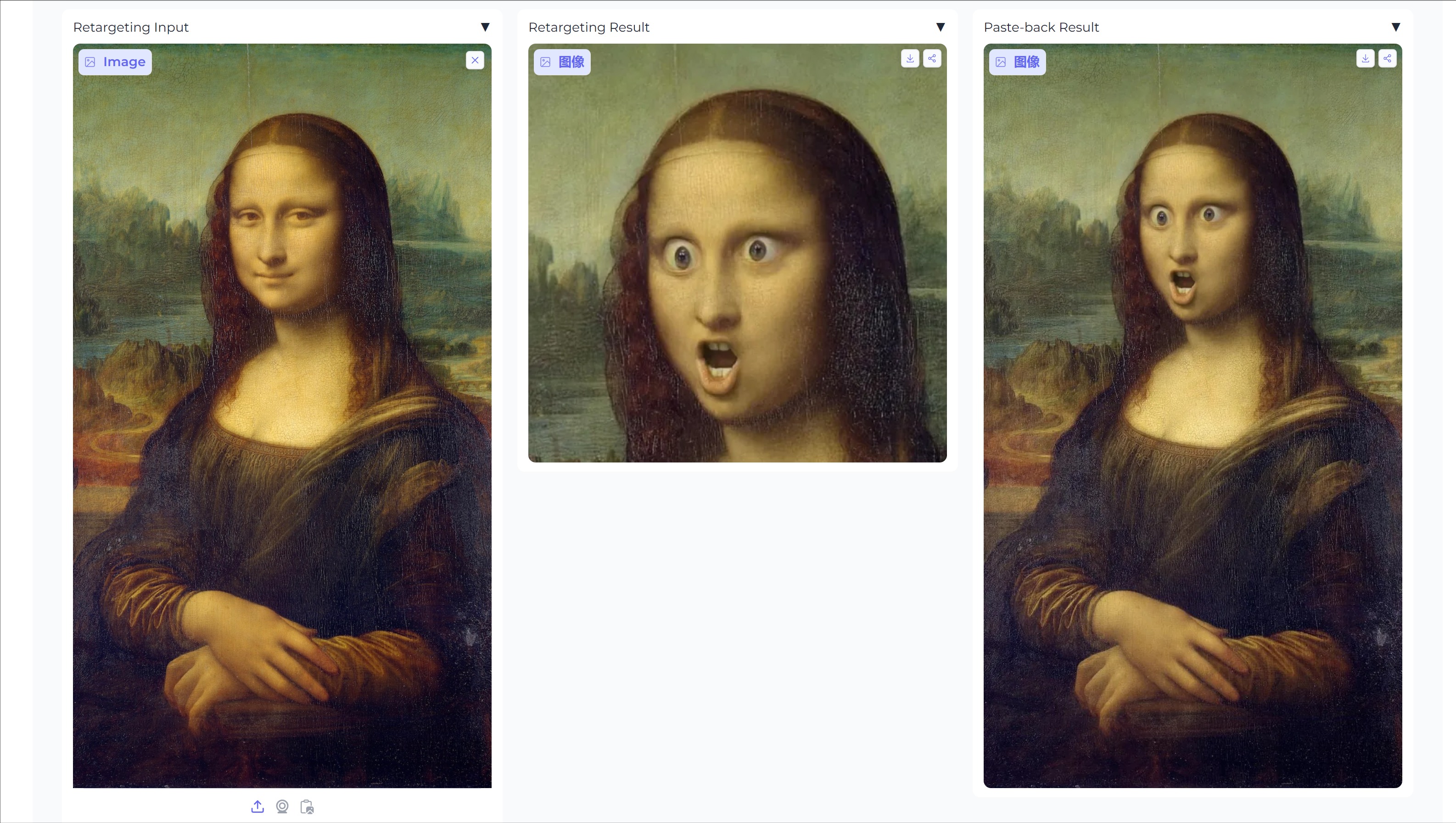

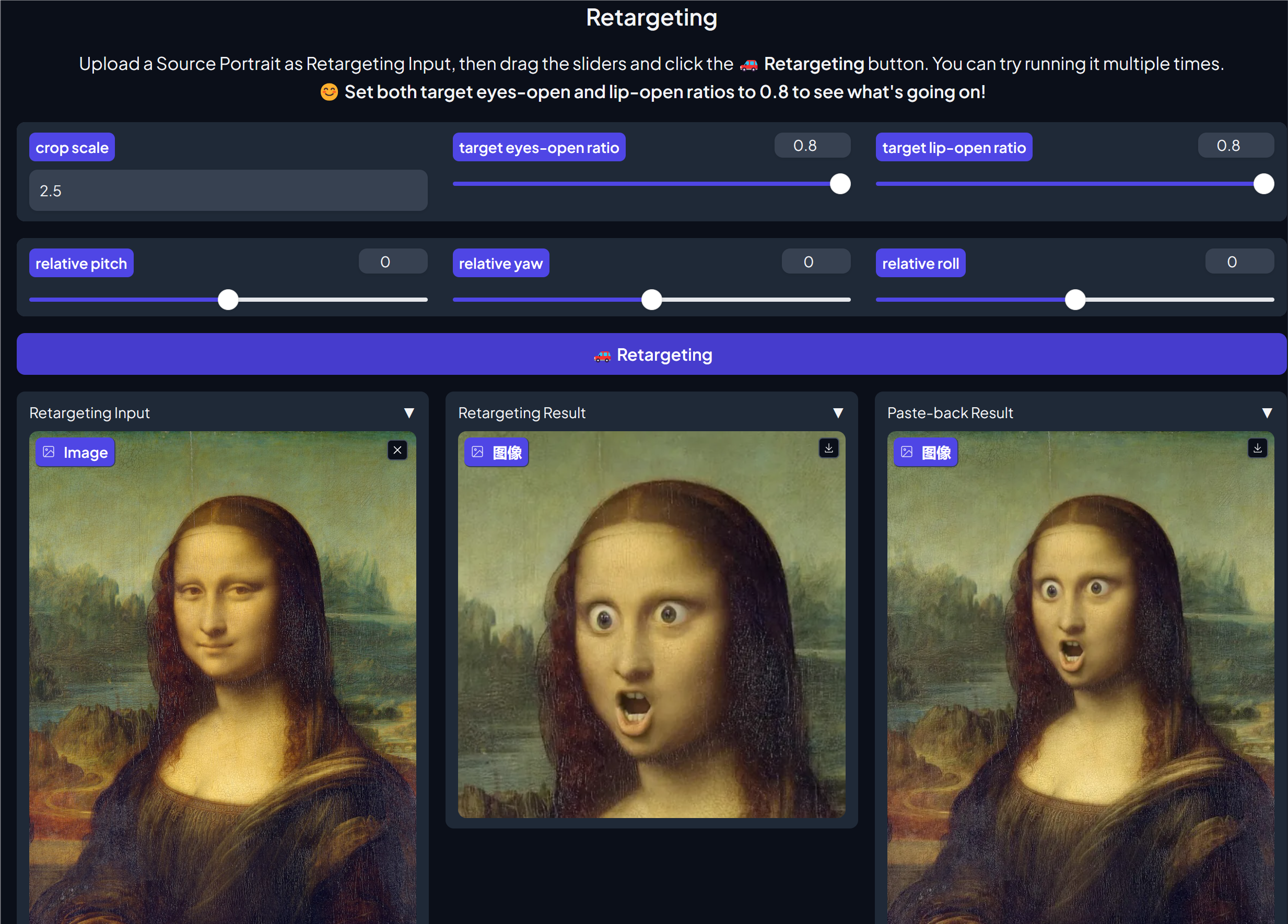

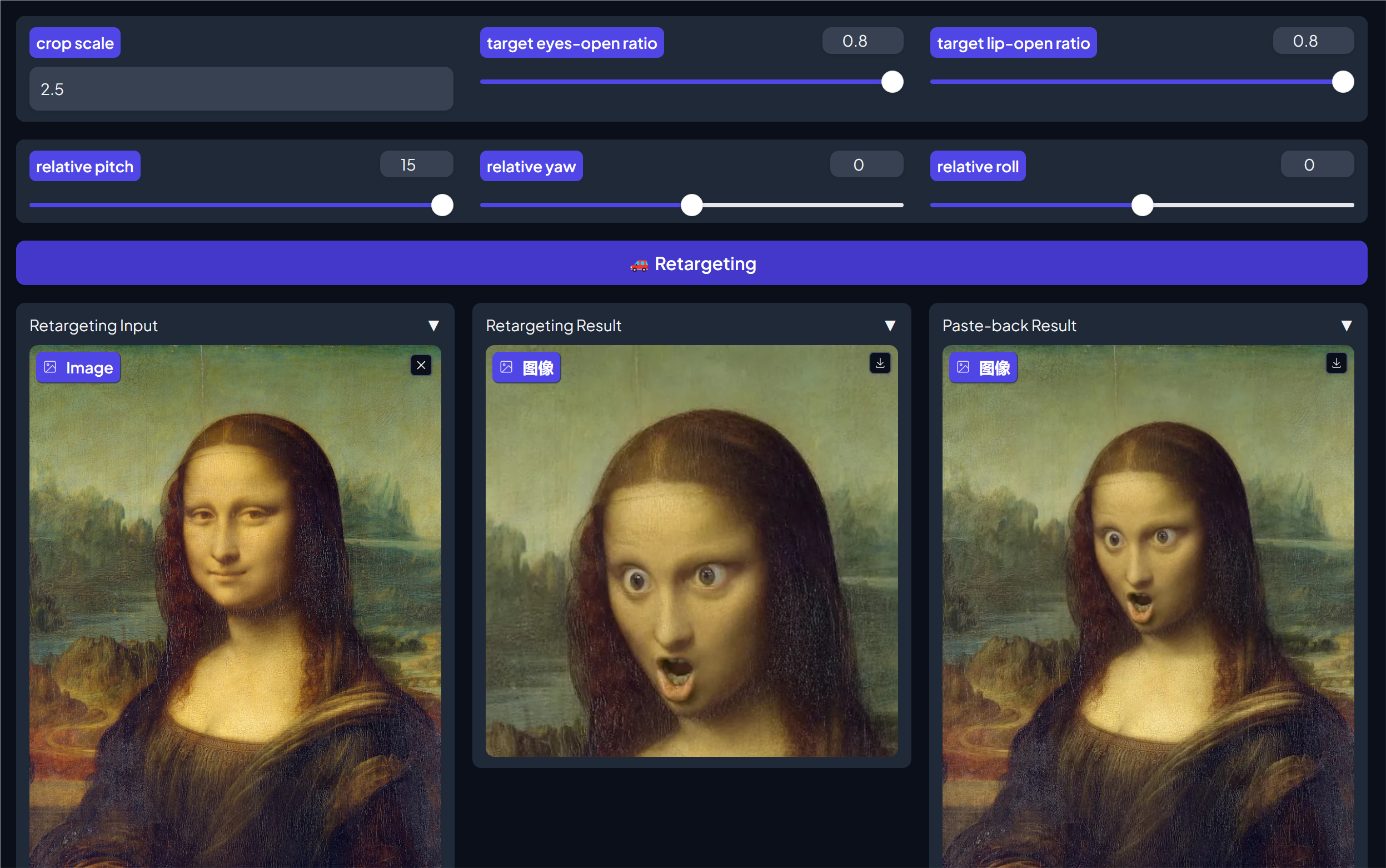

除了视频功能,还有一个改变图片表情的功能。

网页往下滚动,找到Retargeting功能。

通过调整target eyes-open ratio和target lip-open ratio这两参数,可以得到不同程度的表情。

0为闭合,0.8为张开,可以取一个极端值,或者中间值。

①左边的Retargeting Input里面选择或者上传一张图片。

②然后修改一下参数,比如把眼睛和嘴巴的参数设置为0.8。

③最后点击Retargeting运行

最后就可以获得一张传世名作《蒙娜丽莎的惊讶》了。

另外通过相对俯仰(Relative Pitch)、相对偏航(Relative Yaw)和相对翻滚(Relative Roll)等参数可以改变 人脸的朝向。

这么一来,蒙娜丽莎就惊掉下巴了。

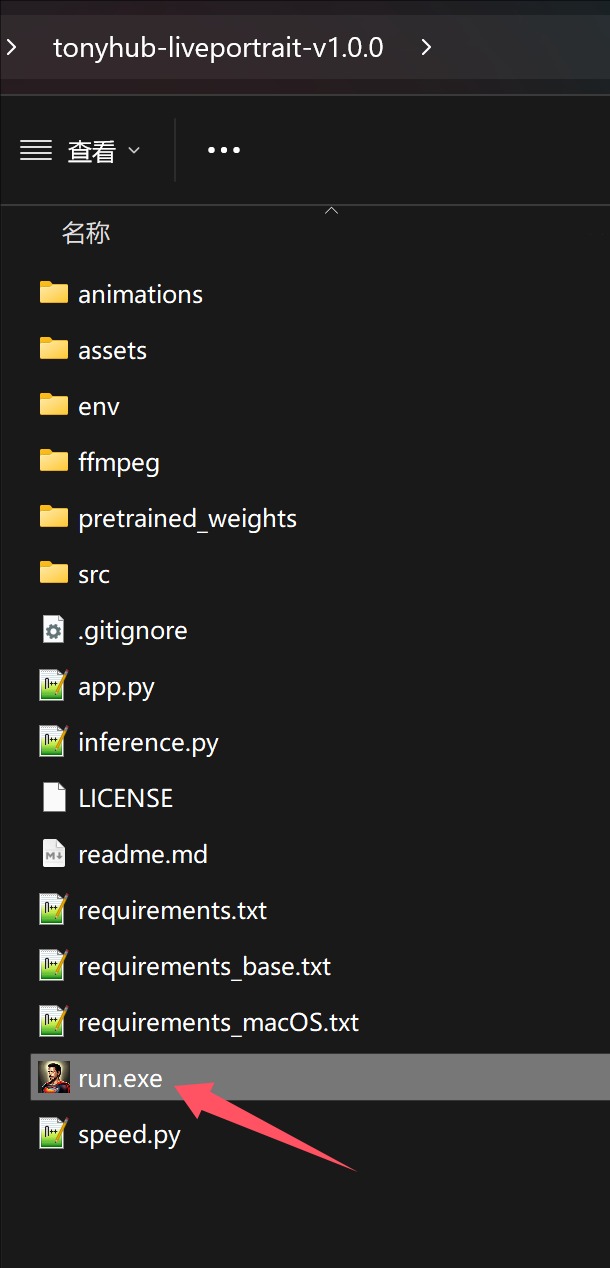

一键运行包

安装配置使用都说完了,最后简单说一下一键运行包。

一键运行包就是把上面的所有命令,模型,环境全部放在一起,省去了配置下载的过程。

只需要下载,解压,双击运行即可。

通过网盘可以下载到一个叫tonyhub-liveportrait-v1.0.0.7z的压缩包文件。

解压这个文件,在解压后的文件夹中找到run.exe。

双击exe文件启动软件。

看到Runing on local URL 表示启动成功,同时浏览器会自动打开,并显示表情同步生成的界面。然后根据上面操作来,就可以轻松制作一个表情同步的视频了。

这个项目是比较适合做搞笑短视频的,也可以用自己的表情嘴型去控制别人的表情和嘴型,配合上AI变声器,也是有非常大的可玩性。

给公众发送“LivePortrait”获取软件包!