热门标签

热门文章

- 1深入探索当下热门的开源AI大模型_处理图片最好的开源ai大模型

- 2锐捷交换机模拟环境搭建教程_锐捷模拟器

- 3Android Studio或IntelliJ IDEA使用经验_project iqiyi is using the following jdk location

- 4顺丰面试题(2018 顶级互联网公司面试题系列)

- 5《面试》游戏开发常用面试问题以及答案_unity lua与c#或c语言相互调用的底层实现原理是什么

- 6机器人工程师学习计划_凸优化大几学

- 7centos7中安装sql server_sendos7能装sqlserver吗

- 8windows电脑远程连接ubuntu20.04服务器,解决黑屏等一系列问题_ubuntu20.04远程桌面黑屏

- 9Hadoop应用案例分析_hadoop 案例

- 10Kinect系列1:(Windows环境配置)Python3+Pykinect2+KinectV2相机读取彩色图与深度图_kinect python

当前位置: article > 正文

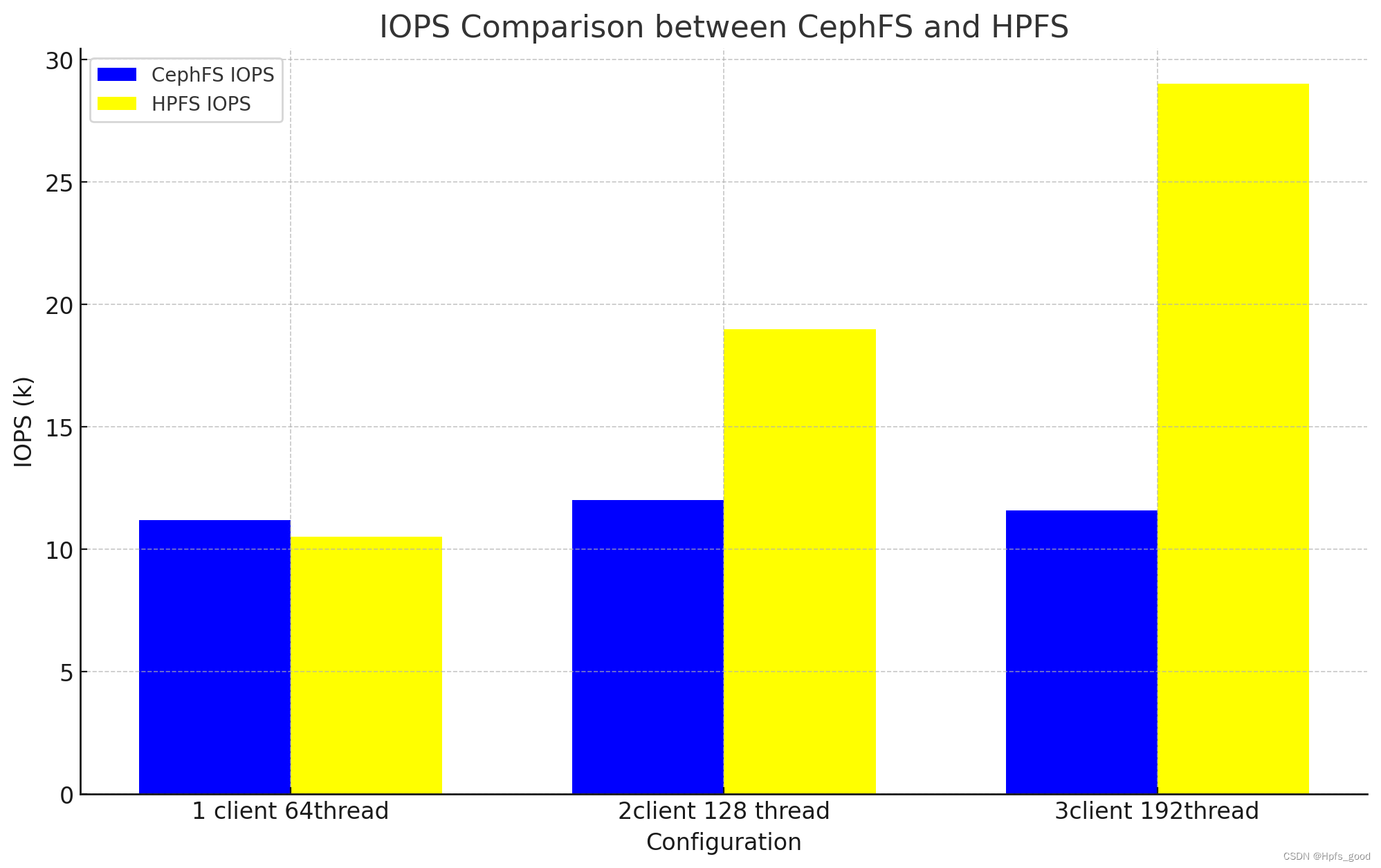

hpfs vs cephfs

作者:空白诗007 | 2024-07-14 02:14:42

赞

踩

hpfs

近几天我做了一个hpfs的性能测试,在同样环境下再部署 cephfs,做出来的性能对比,测试是case 是open 一个文件,write 4096字节,close,然后,open, read 4096字节,close 这样连续的操作操作,一共创建1亿个4096k大小的文件,分别多个线程并发操作,测出的iops,通过这个测试数据我们可以看到hpfs在这样规模下的性能会随着客户端的增加性能有线性的增长,这是因为单客户端的能力受到fuse能力瓶颈影响所致,如果是用hpfs的api接口,完全没有这个限制,可以直接把所有nvme 磁盘性能打满,而ceph由于受到mds的瓶颈所致,即使再增加客户端他的iops也无法再性能提成了,而hpfs可以通过扩展hpfs-srv的数量 继续扩展元数据的文件系统的iops的负载能力。

github url:

https://github.com/ptozys2/hpfs

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/空白诗007/article/detail/822710

推荐阅读

相关标签