- 1四款免费、易用的Docker漏洞扫描工具_开源镜像扫描工具

- 2idea代码快速提示工具——Fitten Code插件安装,比Copilot更快!_idea fitten code

- 3混淆技术研究笔记(二)yGuard入门

- 4Qt工具集成模型部署(ONNXRunTime+openvino)之环境配置篇_qt openvino

- 5冲刺清北华五人,都有哪些CS项目推荐?_清华大学 2024 年网络科学与网络空间研究院 夏令营出优营么

- 6华为OD机考题HJ26 字符串排序

- 7MyBatis(4)多表查询_mybatis多表查询

- 8文本的向量表示_请用向量表示以下3段文本

- 9在8×8格的国际象棋上摆放8个皇后,使其不能互相攻击,即任意两个皇后都不能处于同一行、同一列或同一斜线上,用Python编写程序,问有多少种摆法?并列举出所有摆法。_在8×8格的国际象棋棋盘上摆放8个皇后,使其不能互相攻击,即任意两个皇后都不能处

- 10短视频SEO矩阵系统源码部署及产品定制服务_短视频seo源码

利用AI Agent革新Text2SQL应用_ai text2sql

赞

踩

在自然语言处理(NLP)的疆域中,Text2SQL任务——即将自然语言转换为SQL查询语句——一直是研究的热点。随着大型语言模型(LLM)的兴起,Text2SQL的准确性和效率得到了显著提升。然而,面对复杂的查询需求,传统方法仍显不足。本文将探讨如何通过AI Agent优化LLM在Text2SQL任务上的应用,提升查询的准确性和用户体验。

2. Agent概念与关键组件

AI Agent在LLM(大型语言模型)的应用中扮演着至关重要的角色。Agent的设计灵感来源于人类或其他智能体的行为和决策过程,它通过模拟这些过程来执行复杂的任务。在Text2SQL任务中,Agent能够有效地将用户的自然语言查询转换为精确的SQL语句,从而提高数据库查询的效率和准确性。

2.1 Agent的核心功能

Agent的核心功能包括:

- 环境感知:Agent能够感知当前的环境状态,包括用户输入的查询需求和数据库的当前状态。

- 信息处理:Agent处理接收到的信息,理解用户的意图,并准备相应的响应。

- 策略制定:基于对环境的感知和信息的处理,Agent制定出执行任务的策略。

- 行动执行:Agent执行制定的策略,可能包括生成SQL语句、调用API或与用户进行交互。

- 反馈调整:Agent根据执行结果和用户反馈调整其策略和行为,以优化未来的查询性能。

2.2 Agent的关键组件

Agent的关键组件是其高效执行任务的基础:

- *Agent:作为系统的核心,Agent通常由一个或多个LLM提供支持,负责处理复杂的逻辑和决策。

- Tools:Agent可以调用的外部工具集,如搜索引擎、数据库接口、文件处理器等,以扩展其功能。

- Memory:Agent的Memory组件负责存储和检索对话历史和关键信息,确保在交互过程中信息的连贯性。

- Planning:Agent的Planning组件涉及任务分解、目标设定和反思改进,它使得Agent能够逐步解决复杂问题。

2.3 Planning组件的深入分析

Planning组件是Agent系统中最为复杂和关键的部分,它包括:

- 子目标和任务分解:Agent将用户的复杂查询分解为一系列更小、更易于管理的子目标。这种分解是通过“思维链”(Chain of Thought)或“思维树”(Tree of Thought)实现的,其中Agent探索多种可能的解决路径,并选择最合适的方案。

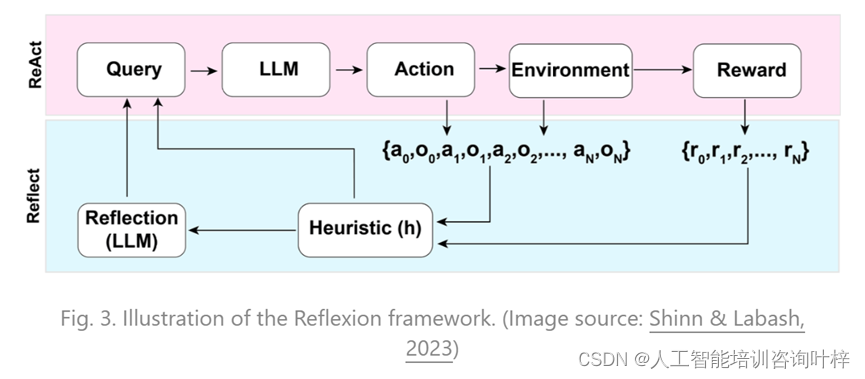

- 反思与改进:Agent在执行过程中会进行自我反思,评估已执行步骤的效果,并根据这些反思进行调整。这种能力通过“ReAct”(结合行动和推理)和“Reflection”(动态记忆和自我反思)框架实现。

2.4 Memory组件的作用

Memory组件对Agent的功能至关重要,它包括:

- 感觉Memory:作为Memory的最初级阶段,它处理原始输入的Embedding表示。

- 短期Memory:用于处理上下文信息,通常受限于Transformer模型的上下文窗口长度。

- 长期Memory:允许Agent在长时间跨度内保留和回溯信息,通常通过外部数据库实现。

2.5 Tools组件的多样性

Tools组件为Agent提供了丰富的外部资源,包括:

- API调用:Agent可以调用各种API,如天气服务、新闻源、数据库查询等。

- 计算能力:Agent可以利用外部计算资源来执行复杂的数学运算或逻辑推理。

- 信息检索:Agent可以访问互联网或内部网络,检索相关信息以辅助决策。

3. LangChain中的Agent模块

LangChain的Agent模块是实现复杂交互和任务自动化的核心。Agent模块通过结合LLM的语义理解和外部工具的功能性,使得系统能够执行更加复杂的任务。在Text2SQL的应用中,Agent模块可以帮助系统理解用户的查询意图,并生成准确的SQL语句。

3.2 Agent类型与功能

LangChain中定义了几种Agent类型,各具特色:

- Zero-shot ReAct:这种Agent能够在没有任何先前示例的情况下,通过推理和行动的结合来解决问题。它适用于需要一步到位解决问题的场景。

- Conversational:会话型Agent设计用于与用户进行交互,通过对话来澄清和细化查询要求。

- Plan-and-execute:这种Agent类型会预先规划一系列步骤,然后按顺序执行,适用于需要多步骤逻辑处理的任务。

3.3 Agent与工具的协同

Agent通过调用工具箱(ToolKit)中的各种工具来增强其功能性。这些工具可能包括:

- 搜索API:允许Agent访问互联网上的信息,以回答与当前事件相关的问题。

- 数据库接口:使Agent能够直接与数据库交互,执行SQL查询。

- 文件处理器:允许Agent读取和解析不同格式的文件,以提取有用信息。

3.4 Agent的工作流程

LangChain中的Agent遵循一个明确的工作流程:

- 接收输入:Agent从用户那里接收自然语言的查询。

- 内部处理:Agent使用LLM来解析查询,并确定需要执行的行动。

- 调用工具:根据需要,Agent调用适当的工具来辅助任务执行。

- 生成输出:Agent将处理结果转换为SQL语句或自然语言回答,并提供给用户。

3.5 ReAct模式的实现

ReAct模式是LangChain中Agent的一个关键特性,它结合了“思维(Thought)”、“行动(Action)”和“观察(Observation)”三个步骤:

- 思维:Agent思考当前任务需要采取的行动。

- 行动:Agent执行一个或多个行动,如调用搜索API或访问数据库。

- 观察:Agent观察行动的结果,并根据这些信息进行下一步的决策。

3.6 实际应用示例

考虑一个Text2SQL的应用场景,用户想要查询“上个月销售额最高的产品”。LangChain的Agent模块可以这样处理:

- 理解查询:Agent通过LLM理解“销售额最高”和“上个月”的含义。

- 规划SQL:Agent规划需要生成的SQL语句结构,确定需要查询的表和字段。

- 调用工具:Agent调用数据库接口工具,准备执行SQL查询。

- 执行查询:Agent在数据库上执行生成的SQL语句。

- 返回结果:Agent将查询结果以用户易于理解的格式返回。

4. Agent优化Text2SQL效果的实践

在Text2SQL任务中,AI Agent的应用可以显著提升将自然语言转换为SQL查询语句的准确性和效率。以下是利用AI Agent优化Text2SQL效果的具体实践方法。

4.1 现有问题的识别

在Text2SQL的应用实践中,经常遇到的问题包括但不限于:

- 理解偏差:直接由LLM生成的SQL可能无法准确反映用户的查询意图。

- 复杂逻辑处理:涉及多表连接、复杂条件筛选的查询难以生成。

- 上下文限制:LLM的上下文长度限制导致无法处理长查询或多轮交互。

4.2 Agent解决方案

Agent通过以下方式解决上述问题:

4.2.1 任务分解

Agent将复杂的Text2SQL任务分解为更小的子任务。例如,对于“找出连续两个月都下订单的客户”的查询,Agent可以将其分解为以下步骤:

- 确定时间范围:理解“连续两个月”的含义,并确定具体的时间范围。

- 识别相关表:在数据库架构中识别存储订单信息的相关表。

- 构建查询:根据确定的时间范围和相关表,构建初步的SQL查询。

- 逻辑细化:细化查询逻辑,确保能够正确识别“连续”的含义。

4.2.2 反思与改进

Agent在生成SQL的过程中,会进行自我反思,评估生成的查询是否能够准确反映用户的意图。如果发现偏差,Agent会根据反馈进行调整。例如:

- 生成初步SQL:Agent根据用户的查询意图生成初步的SQL语句。

- 执行查询:在沙盒环境中执行SQL语句,观察结果是否符合预期。

- 结果分析:如果结果不符合预期,Agent分析可能的原因,并调整生成的SQL。

4.2.3 ReAct模式的应用

ReAct模式结合了“思维链”和外部工具的使用,使得Agent能够逐步解决问题。例如:

- 思维:Agent思考用户查询的可能含义。

- 行动:Agent执行搜索或数据库查询以获取相关信息。

- 观察:Agent观察行动的结果,并根据这些信息进行下一步的决策。

4.2.4 Memory系统的利用

Agent利用Memory系统来存储和检索对话历史和关键信息,确保在交互过程中信息的连贯性。这在处理多轮交互的查询时尤为重要。

4.2.5 Tools的使用

Agent调用外部工具,如数据库接口,以执行SQL查询并获取结果。这些工具的使用增强了Agent的功能,使其能够处理更复杂的任务。

4.3 实施步骤

以下是利用Agent优化Text2SQL效果的具体实施步骤:

- 定义问题:明确用户的查询需求,并将其转换为Agent可以理解的格式。

- 初始化Agent:根据任务需求,选择合适的Agent类型,并为其配置必要的工具和Memory系统。

- 执行任务:Agent执行任务,包括理解查询、生成SQL、调用数据库接口等。

- 结果反馈:将Agent生成的SQL语句和查询结果反馈给用户,并根据用户反馈进行优化。

- 迭代优化:根据执行结果和用户反馈,不断迭代优化Agent的策略和行为。

4.4 效果评估

通过Agent优化Text2SQL效果的实践,可以显著提升查询的准确性和效率。Agent通过任务分解、反思改进、ReAct模式的应用、Memory系统的利用以及Tools的使用,能够更好地理解和执行复杂的查询需求。

5. 实例分析

5.1 理解查询意图

在Text2SQL任务中,理解用户的查询意图是至关重要的第一步。以“统计连续两个月都下订单的客户”为例,传统方法可能会直接生成一个简单的SQL查询,而没有深入理解“连续”这一条件的真正含义。Agent利用LLM的语义理解能力,能够准确识别出用户是想查询在任意连续两个月内都有订单的客户,而不是简单地查找在最近两个月内有订单的客户。

5.2 动态规划

理解了查询意图后,Agent将这一复杂查询分解为多个可管理的步骤,并为每个步骤规划相应的SQL操作。以下是Agent可能采取的动态规划步骤:

- 确定时间范围:Agent首先需要确定“连续两个月”的具体时间范围。这可能涉及对日历数据的查询或基于当前日期的逻辑计算。

- 识别相关表和字段:在数据库架构中,Agent识别出存储订单信息的相关表(如Orders表)和关键字段(如订单日期、客户ID)。

- 构建初步查询:Agent构建一个初步的SQL查询,该查询能够筛选出在特定两个月期间都有订单的客户。

- 逻辑细化:Agent进一步细化查询逻辑,确保能够准确识别“连续”这一条件。这可能涉及到使用分组(GROUP BY)、排序(ORDER BY)和窗口函数(如ROW_NUMBER)。

- 优化查询性能:考虑到查询性能,Agent会对SQL查询进行优化,避免全表扫描,利用索引和查询缓存。

5.3 交互式优化

在实际操作中,Agent与用户的交互是优化查询的关键环节。以下是Agent如何通过交互式优化来提升查询准确性的示例:

- 初步查询反馈:Agent将初步生成的SQL查询及其预期结果反馈给用户,询问是否符合其需求。

- 用户反馈收集:用户可以确认结果或提供更多信息,比如指定具体的月份或对“连续”这一概念进行澄清。

- 查询调整:基于用户的反馈,Agent调整SQL查询。如果用户指定了具体的月份,Agent会在查询中加入相应的条件。

- 迭代验证:Agent可能需要多次迭代,每次根据用户的反馈对查询进行微调,直到结果完全符合用户的需求。

- 结果确认:最终,当用户对查询结果表示满意时,Agent停止迭代,并将最终的SQL查询和结果展示给用户。

5.4 实施步骤

以下是Agent优化Text2SQL任务的实施步骤:

- 用户提出查询:用户向系统提出查询请求。

- Agent解析意图:Agent解析用户的查询意图,并确定关键信息点。

- 生成SQL草案:Agent生成一个初步的SQL查询草案。

- 执行初步查询:Agent在数据库中执行初步查询,并获取结果。

- 交互式反馈:Agent将初步查询结果呈现给用户,并收集反馈。

- 查询迭代优化:根据用户反馈,Agent迭代优化SQL查询。

- 性能调优:Agent对最终的SQL查询进行性能调优。

- 结果输出:Agent将最终的查询结果以用户友好的格式展示。

5.5 分析与讨论

通过上述实例分析,我们可以看到Agent在处理Text2SQL任务时展现出的优势:

- 深入理解:Agent能够深入理解用户的查询意图,而不仅仅停留在表面。

- 动态规划:Agent通过动态规划将复杂任务分解,使得问题变得更加可管理。

- 交互式优化:通过与用户的交互,Agent能够收集反馈并优化查询,直到结果完全符合用户需求。

同时,Agent在实际应用中面临的挑战包括:

- 上下文管理:在多轮交互中,Agent需要有效管理上下文信息,以维持对话的连贯性。

- 性能考虑:Agent需要在确保查询准确性的同时,也考虑查询的性能影响。

尽管Agent在优化Text2SQL任务上展现出巨大潜力,但仍面临技术挑战,如上下文长度限制、长期规划的复杂性等。未来的研究可以集中在提升Agent的上下文管理能力、增强复杂逻辑处理能力以及提高交互式优化的效率。此外,跨领域应用和多任务学习也将是未来研究的重要方向。

通过不断的技术迭代和优化,AI Agent有望在Text2SQL以及其他自然语言处理任务中发挥更大的作用,为用户提供更加智能化的服务。