- 1RK3588 & Android13 增加可读写分区_android 13新增分区

- 2esp32舵机机械臂_esp32 机器人控制

- 3BM25检索算法 python

- 4一道有意思的多线程面试题 C# 代码实现

- 5Python爬虫会遇到的难题,如何破解滑动验证码_爬虫遇到验证

- 6AI智能修复视频,垃圾画质也变高清 HD——牛小影_ai修复模糊视频

- 7什么是数据湖(Data Lake) ,以及什么是湖仓一体(Lakehouse)

- 8【机器视觉案例】(6) AI视觉,距离测量,自制AI小游戏,附python完整代码_from cvzone.handtrackingmodule import handdetector

- 9修改Android项目的minSdkVersion_minsdkversion怎么修改

- 10elasticsearch系列八:ES 集群管理(集群规划、集群搭建、集群管理)

2024最新私有化部署AI大模型,让每个人都有属于自己的AI助理_私有ai模型

赞

踩

让每个人都拥有一个属于自己的本地大模型

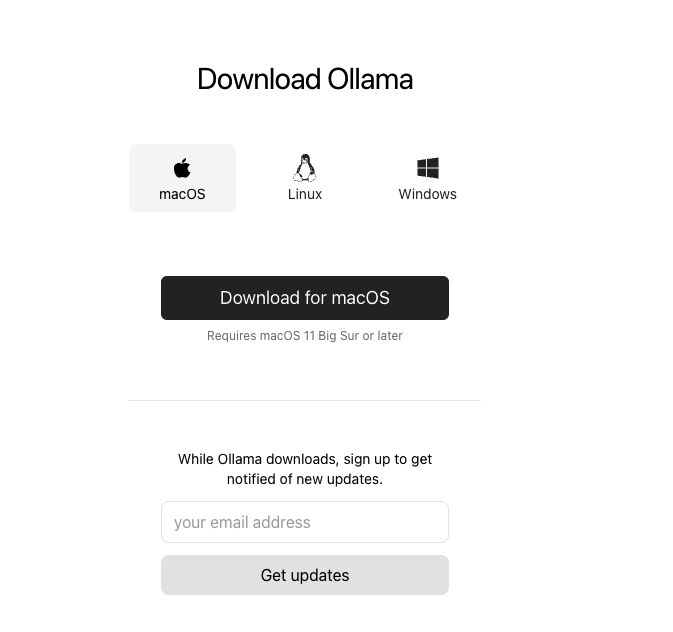

下载Ollama

下载地址

https://ollama.com/download

Ollama支持MacOS、Linux、Windows

解压

下载完成后,会得到一个Ollama-darwin.zip文件,解压后,以Mac为例是一个可运行文件:Ollama.app

使用步骤

-

双击解压后的可运行文件:

Ollama.app -

在Ollama官网上点击

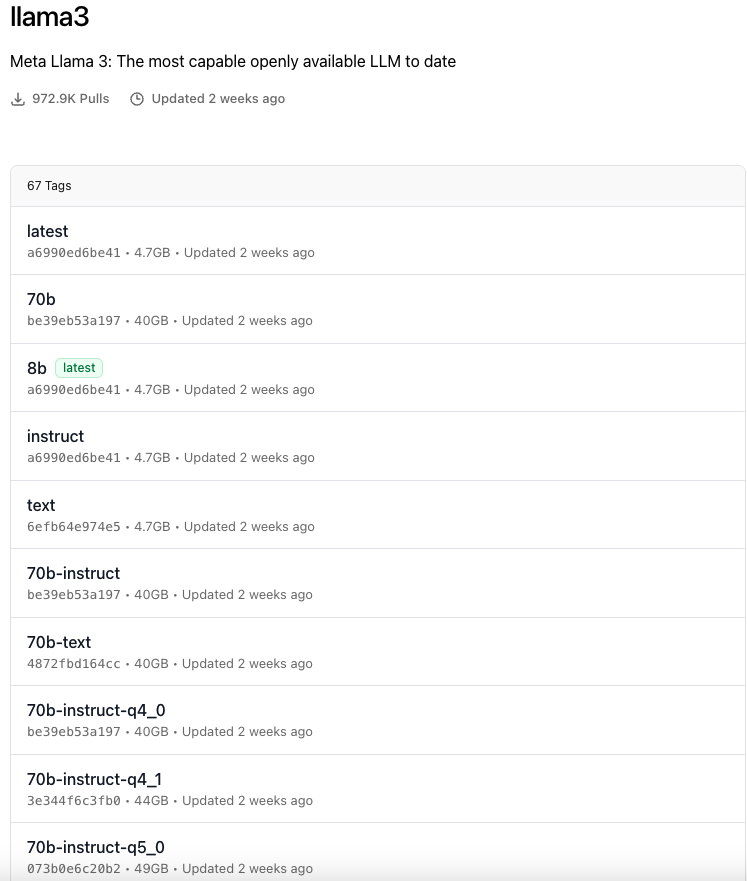

Models,可看见各种大模型的列表,我这里选择了llama3

-

打开终端,执行如下命令:

ollama run llama3 -

等待下载模型文件,llama3:8b大概4.7GB

-

完成后,会出现如下窗口说明安装成功

-

发送任意消息进行测试

使用聊天页面调用大模型

无论是使用命令还是调用大模型接口,用起来肯定是不方便,大模型肯定是要配合完美的页面来使用的。我推荐使用的是open-webui

gitHub地址

https://github.com/open-webui/open-webui

安装方式

推荐使用docker安装(可直接参考github中的文档)

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

使用

安装成功后,浏览器直接访问localhost:3000,注册一个账号,即可正常使用。

在UI页面中,可设置系统语言,支持中文

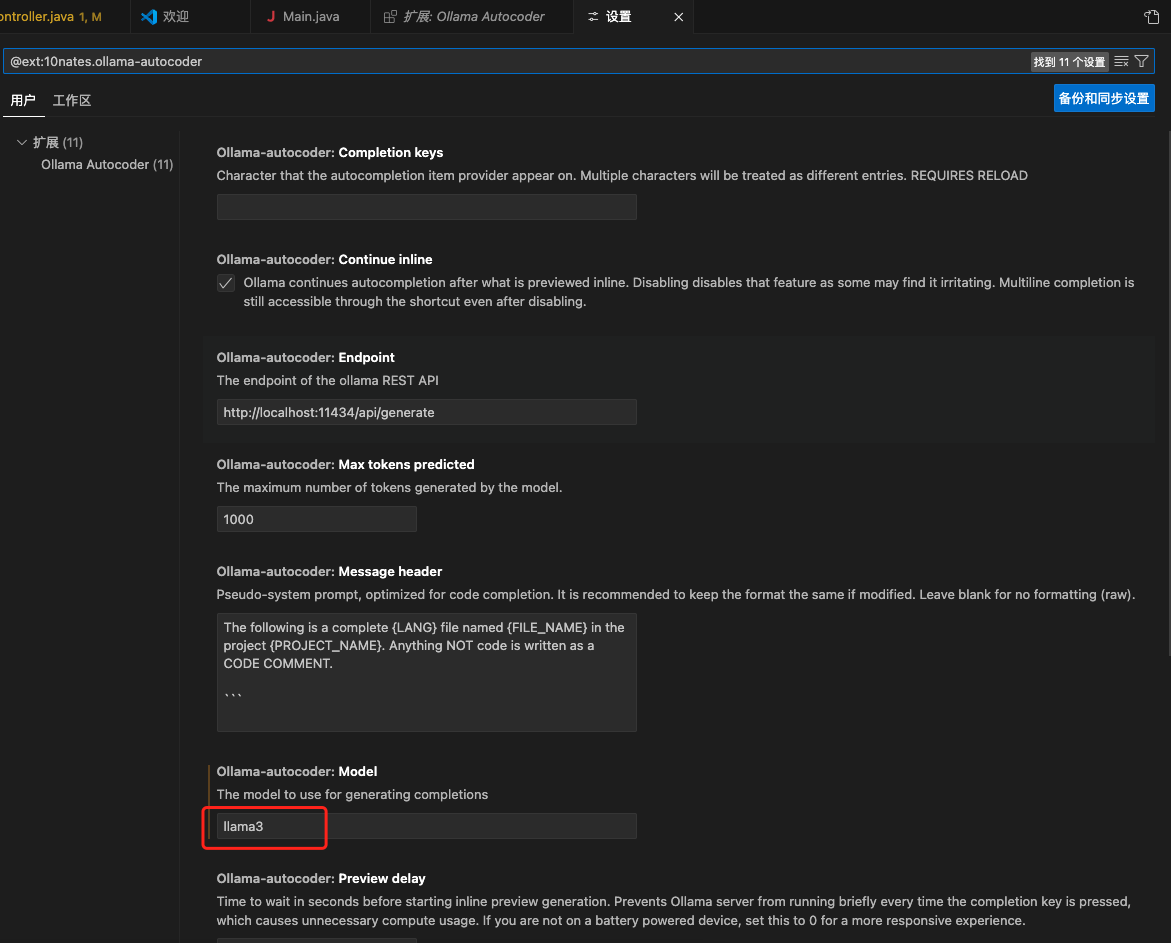

开发工具插件使用本地大模型

有很多插件都支持Ollama,拿VsCode开发工具来说,有一个插件叫Ollama Autocoder

在设置中,将模型手动改为:llama3

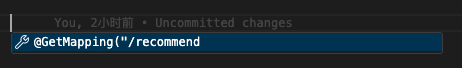

在VSCode中,按下空格即可有插件的提示:

按下Tab键,即可使用大模型的推理生成上下文代码。这里不重点介绍了,有很多优秀的插件做的都很好,这里着重演示使用本地大模型。