- 1[每日一题]22、Python中的三元表达式

- 2设计模式、Context、Toast_toast context

- 3深度分析 Apache Flink 窗口机制_flink 会话窗口 使用场景

- 4论文浅尝 | SpCQL: 一个自然语言转换Cypher的语义解析数据集

- 5SRE是新一代ITIL的革新者

- 6C++ 11 学习3:显示虚函数重载(override)

- 7arduino openmv 显示图像_openmv4形状识别

- 8【C++】一文理清override,overload,overwrite_c++ overwrite

- 9Drools使用dsl语言_drools如何使用字典

- 10【BUG】Gunicorn [CRITICAL] WORKER TIMEOUT (pid:41518)_gunicorn 超时时间

【NLP】盘点!大模型及发展趋势!

赞

踩

大型语言模型(LLMs)无疑是此次人工智能革命的核心,其构建于Transformer架构的坚实基础之上,并依据缩放定律(Scaling Law)不断进化。

简而言之,缩放定律揭示了一个关键原理:数据规模的扩大、参数数量的增加以及计算能力的提升,都将促使模型能力迈向新的高峰。正是通过预先训练海量的文本数据,LLMs展现了令人瞩目的对话与任务处理能力,成为了现代人工智能领域的璀璨明星。

可以感受到的是,在AI的浪潮中,大模型技术迭代太快了。往往上个大模型还没霸榜几天,下个大模型就又刷榜了,下面我们一起来看下有哪些经典大模型与其发展趋势。

GPT-4o

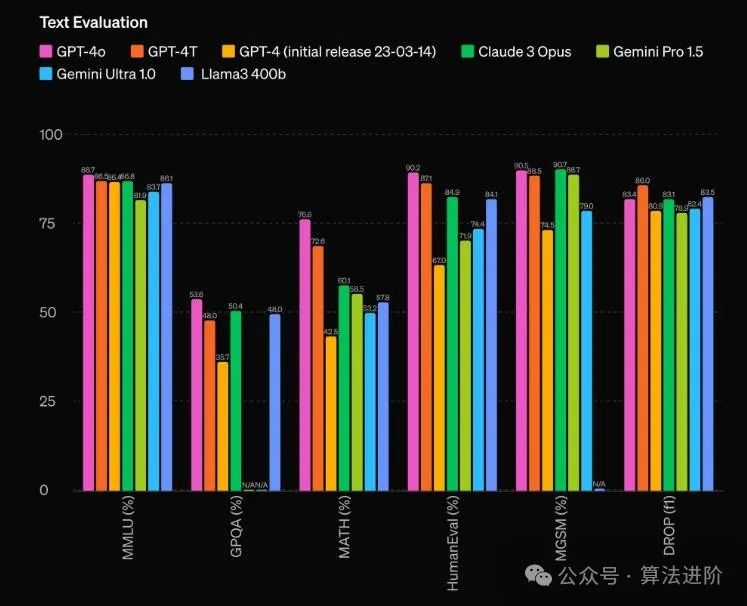

近期OpenAI隆重推出了免费的全新的旗舰模型——“GPT-4o”,核心亮点在于把AI工具的使用门槛降到了更低的程度。据详细介绍,GPT-4o模型显著提升了ChatGPT在处理多达50种不同语言方面的表现,具备实时对音频、视觉及文本进行推理的卓越能力,并在速度与质量方面均实现了显著优化。

性能方面,根据传统基准测试,GPT-4o在文本、推理和编码等方面实现了与GPT-4 Turbo级别相当的性能,同时在多语言、音频和视觉功能方面的表现分数也创下了新高。

GPT-4o:https://openai.com/index/hello-gpt-4o/

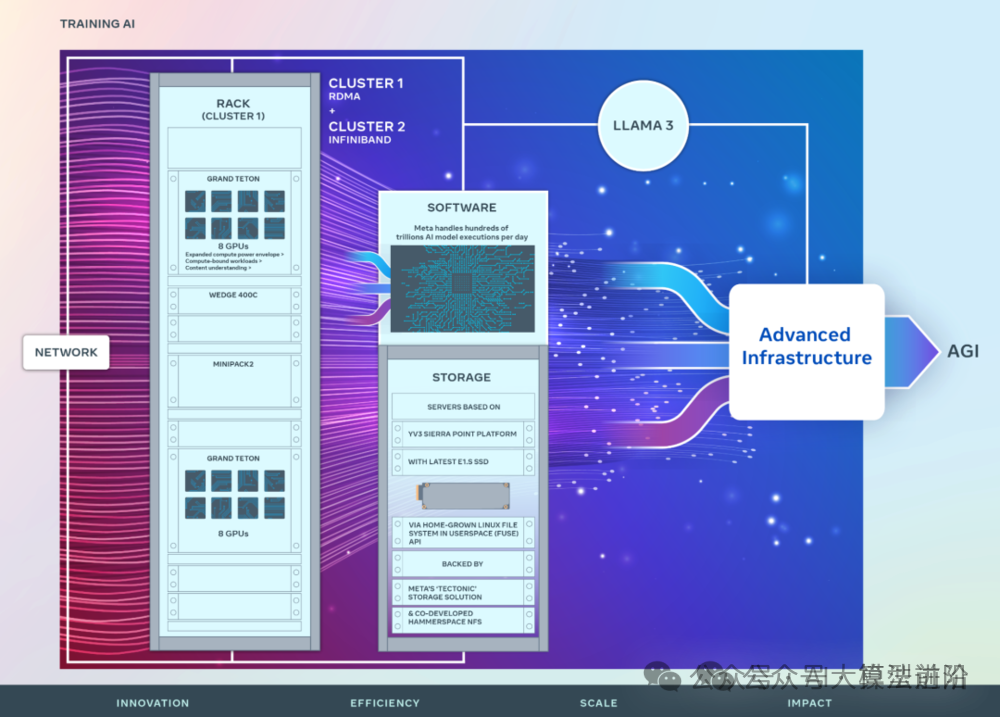

LLaMA 3

近期,Meta 重磅发布发布两款开源Llama 3 8B与Llama 3 70B模型,供外部开发者免费使用。Meta表示,Llama 3 8B和Llama 3 70B是目前同体量下,性能最好的开源模型。

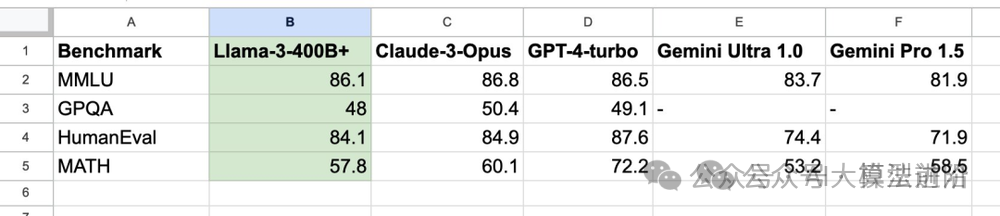

从其分享的基准测试可以看出,Llama 3 400B+ 的实力几乎媲美 Claude 超大杯以及 新版 GPT-4 Turbo,虽然仍有一定的差距,但足以证明其在顶尖大模型中占有一席之地。

模型下载链接:https://llama.meta.com/llama-downloads/

GitHub项目地址:https://github.com/meta-llama/llama3

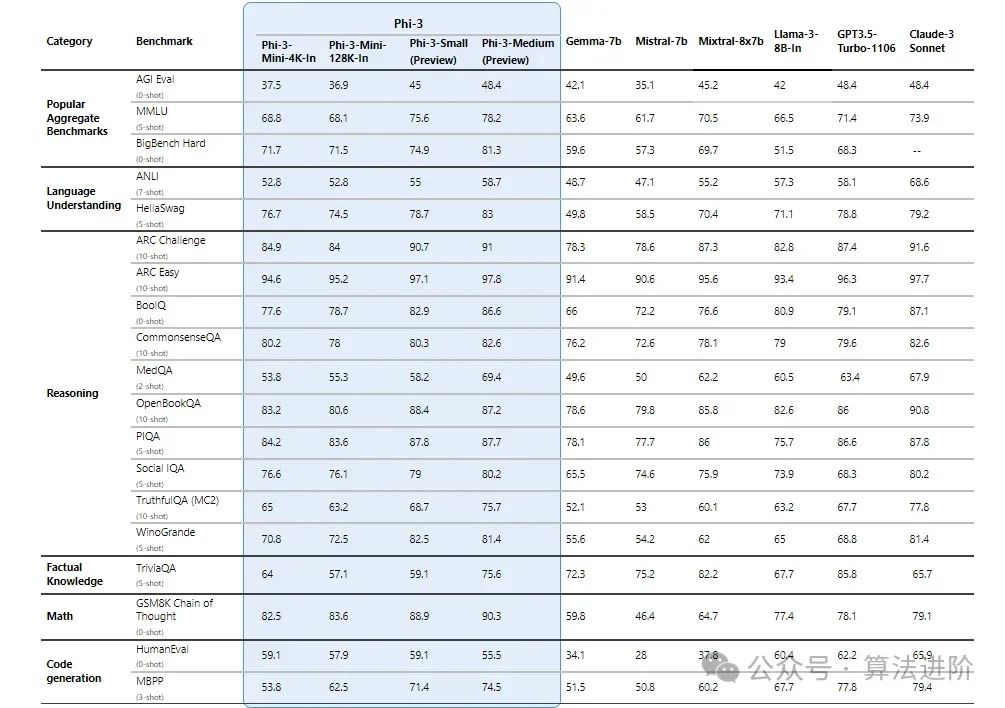

Phi-3

Phi 是由微软 AI 研究院最新开发的一个开源「小型语言模型」,可商用,卖点是小,需要的资源少。模型包括Phi-3-Mini、Phi-3-Small 和 Phi-3-Medium。其中,Phi-3-Mini 最小,只有 3.8B

的参数,但在重要的基准测试中的表现可与大型模型如 Mixtral 8x7B 和 GPT-3.5 媲美而更大的 Small 和 Medium ,在扩展的数据集的加持下就更牛逼了。

链接:https://huggingface.co/collections/microsoft/

零一万物

Yi系列模型是01.AI推出的下一代开源大型语言模型,旨在成为双语语言模型领域的佼佼者。该模型利用3T多语言语料库进行训练,具备出色的语言理解、常识推理和阅读理解等能力。

据2024年1月数据显示,Yi-34B-Chat模型在AlpacaEval排行榜上位列第二,仅次于GPT-4 Turbo,且优于其他LLM如GPT-4、Mixtral、Claude。此外,Yi-34B模型在Hugging Face Open LLM Leaderboard和C-Eval等各种基准测试中,均排名第一,超越所有现有开源模型,如Falcon-180B、Llama-70B、Claude。这些成绩使Yi系列模型成为全球最强大的LLM模型之一,展现出广阔的应用前景。

论文:https://arxiv.org/abs/2403.04652

链接:https://github.com/01-ai/Yi

大模型发展趋势

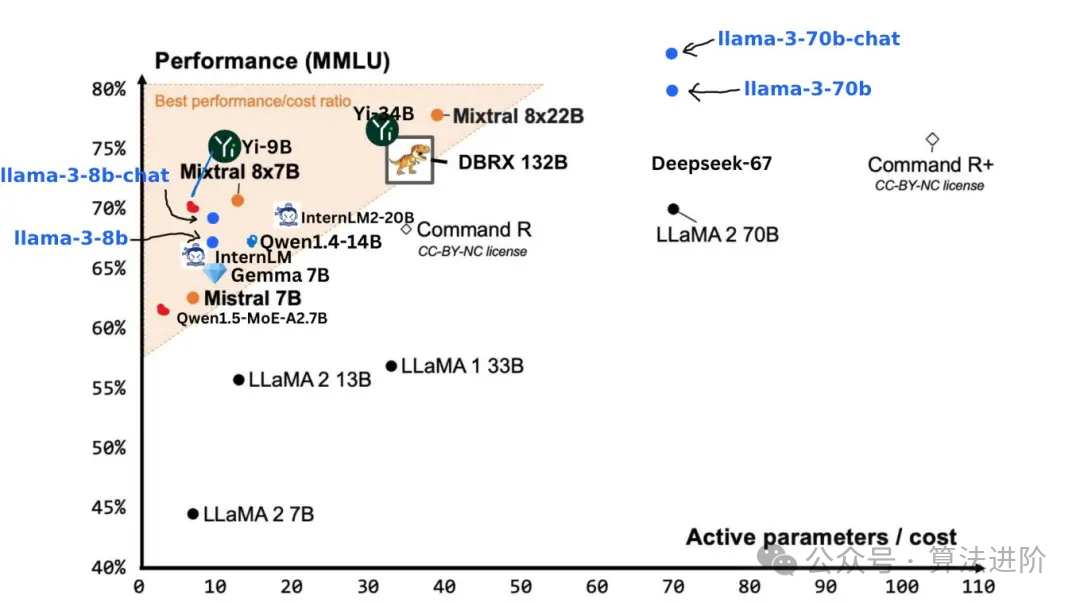

1、开源OR闭源?

IT行业的历史告诉我们,开源是软件领域里的一大潮流,它推动了应用生态的繁荣。但自从GPT3出现后,Open AI却选择了闭源,这使得开源大模型的发展似乎停滞在了GPT3.5的阶段。不过,业界还是有一些口碑不错的前沿开源大模型,比如Meta的LLaMA3、Mistral的Mistral 8x7B和零一万物的Yi-34B等。

虽然开源模式在构建生态方面很给力,但因为大模型算力和算法等方面的限制,它在大模型领域的发展还充满了不确定性。甚至有人担心,开源模型会逐渐落后。好在Llama 3的出现,给开源模型带来了一线希望。这场关于开源与闭源的辩论还在继续,咱们就拭目以待吧。

2、大规模 OR 小规模参数?

大模型基于Scaling Law(缩放定律)。简单的说,就是数据越多,参数越大,算力越强,模型最终的能力就越强。随着模型参数和预训练数据规模的增加,模型能力与任务效果不断改善,展示出了一些小规模模型所不具备的“涌现能力”。

随着大模型时代的逐步来临,以ChatGPT为代表的前沿大模型技术正逐步在经济、法律、社会等诸多领域展现其重要价值。与此同时,众多AI企业纷纷推出开源大模型,其规模正遵循扩展定律实现指数级增长。

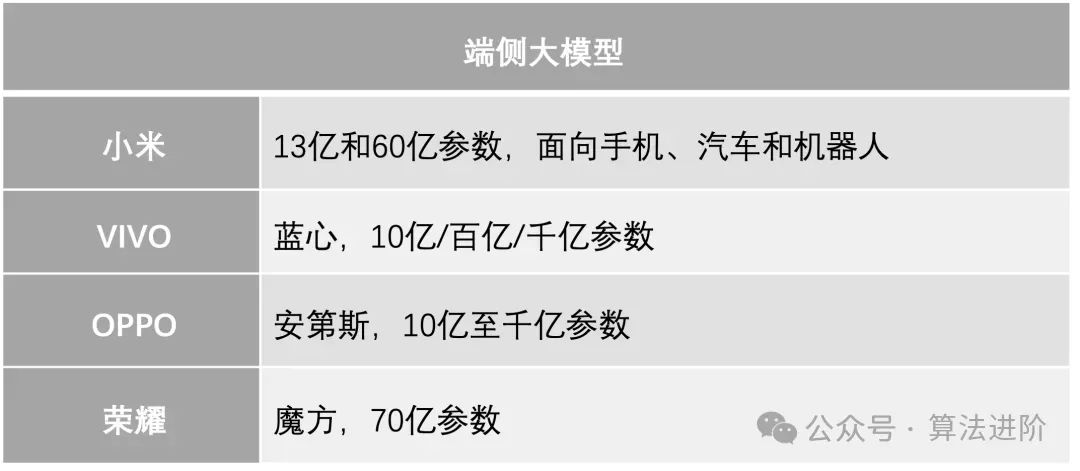

然而,一个不可忽视的趋势是,大模型的体积正在逐渐精简,使得私有化部署成为可能。这一需求显得尤为重要,特别是在对个人隐私保护要求极高的场景中。想象一下,一个能够深入了解你各类数据的AI机器人,在无需联网传输数据的情况下,直接在你的设备上运行并为你提供决策支持,这无疑大大增强了用户的信任。可以预见的是,手机端侧大模型将加剧和超级APP的入口之争。实践教程:手机上部署最新大模型全攻略

- 往期精彩回顾

-

-

-

-

- 适合初学者入门人工智能的路线及资料下载(图文+视频)机器学习入门系列下载机器学习及深度学习笔记等资料打印《统计学习方法》的代码复现专辑

交流群

欢迎加入机器学习爱好者微信群一起和同行交流,目前有机器学习交流群、博士群、博士申报交流、CV、NLP等微信群,请扫描下面的微信号加群,备注:”昵称-学校/公司-研究方向“,例如:”张小明-浙大-CV“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~(也可以加入机器学习交流qq群772479961)