- 1对话国内著名IE外壳浏览器Gosurf主创人-徐骞_ie浏览器壳

- 2学ps还是html,photoshop哪个版本好用?初学PS用哪个版本好?

- 32025腾讯笔试考什么?如何通过综合素质测评|附真题通关秘籍攻略_腾讯笔试腾讯综合素质测试题库

- 4在win10中,安装mingw-get-setup

- 5neo4j插件使用_neo4j apoc插件

- 65G NR QC-LDPC简介(一)_ldpc编码

- 7kotlin mysql数据库_android studio使用JDBC访问mysql数据库(Kotlin方法)

- 8「实战案例:使用 LSTM 进行单变量时间序列预测(附Python完整代码)_lstm实际应用案例

- 9spring boot 集成spark-streaming-kafka_springboot引入sparkstreaming

- 10文档丨Oracle 20c 概念手册

requests 发送一个 json 格式的 post 请求_requests post json

赞

踩

今天给一位同学解决post发送数据格式为json格式的请求,顺便确认一下问题归属。

背景:

用postman工具发送一个数据格式为json的请求,得到了服务器的响应。

用python的requests库写的请求,却报错了。没有得到该有的结果。

解决方法:

-

先确认自己的请求信息和函数使用正确。包括请求头、请求体和参数传递。

-

看服务端的日志,如果服务端的日志当中收到了这2个请求的请求数据,看日志中提示什么错误并比对一下2份请求数据的不同,顺便有需要找开开聊聊。

基于此,来说说requests中发送json格式的处理。

1、json数据格式的请求头

在post请求当中,json数据格式的请求,请求头常规为:Content-Type:application/json

2、requests库中 post请求的json参数

post请求方法:post(url,data=None,json=None,**kwargs)

python的requests的post请求中,有一个json参数。源码中对于此参数的说明如下:

一个json序列化的python对象。python中字典表达与json很相似。

在post请求中,对传进来的json值,会做如下处理:

1、会使用json模块中的dumps方法转成json数据。

2、会增加消息头中的content_type为application/json

所以,json参数不需要提前使用json模块的方法转成json字符串。

请注意,这里有坑:如果在传参时,提前转换成json字符串:requests.request("post",url,json=json.dumps(a),headers=headers)

在post请求中,还会再使用jsons模块转成json数据。那么此时的请求数据会在最外多了一层引号。

请求数据结果为:"{\"pwd\": \"1234567890\", \"mobilephone\": \"18611000001\"}"

而实际上我们要发送的数据是没有外层引号的,即:{\"pwd\": \"1234567890\", \"mobilephone\": \"18611000001\"}

源码如下:

3、示例代码(仅为用法示例。演示接口并不支持application/json格式):

importrequestsa={"mobilephone":"18611000001","pwd":"xxxxxxxxxxxx"}url="http://XXXXXXXX"#消息头指定headers={'Content-Type':'application/json;charset=UTF-8'}#发送post请求 json参数直接为一个字典数据。res=requests.request("post",url,json=a,headers=headers)print(res.status_code)print(res.text)打印发送出去的请求数据,请求的结果:

-

- sessions.py499行打印发送请求数据:请求头为:{'User-Agent':'python-requests/2.19.1','Accept-Encoding':'gzip, deflate','Content-Type':'application/json;charset=UTF-8','Content-Length':'51','Connection':'keep-alive','Accept':'*/*'}请求体为:b'{"pwd": "1234567890", "mobilephone": "18611000001"}'

-

- 200{"status":0,"code":"20103","data":null,"msg":"手机号不能为空"}

json 请求中固定键名顺序 & 消除键和值之间的空格

实际工作中遇到了以下2种情况。

-

服务端要求json字符串,键名的顺序固定

-

服务端对于接收到的json数据中,若key和value之间有空格,则解析不了。

第1种情况:服务端要求json字符串,键名的顺序固定

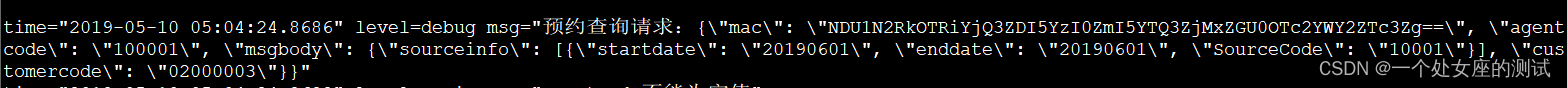

服务端在解析客户端请求时,要求收到的请求json数据中,键名的顺序要固定 。比如第一个键名必须是mac,第二个键名必须是agentCode等。

而我们使用requests发送请求数据时,我们是对字典进行json处理的,顺序并不是固定的。

处理方法:在给requests传参时,就给固定顺序的字典就好。

使用collections.OrderedDict。它是有序字典,记住了键值对的添加顺序。

请注意:如果初始化的时候同时传入多个参数,它们的顺序是随机的,不会按照位置顺序存储。

示例代码:

-

- importcollections

-

- content=collections.OrderedDict()content["mac"]="NDU1N2RkOTRiYjQ3ZDI5YzI0ZmI5YTQ3ZjMxZGU0OTc2YWY2ZTc3Zg=="content["agentcode"]="100001"content["msgbody"]={"customercode":"02000003","sourceinfo":[{"SourceCode":"10001","startdate":"20190601","enddate":"20190601"}]}

-

- print(content)

-

- #输出结果:按键名添加的顺序输出OrderedDict([('mac','NDU1N2RkOTRiYjQ3ZDI5YzI0ZmI5YTQ3ZjMxZGU0OTc2YWY2ZTc3Zg=='),('agentcode','100001'),('msgbody',{'sourceinfo':[{'SourceCode':'10001','startdate':'20190601','enddate':'20190601'}],'customercode':'02000003'})])

通过使用orderedDict处理之后,将content作为requests请求中json参数值。那么发给服务器端的数据,就是固定的键名顺序。

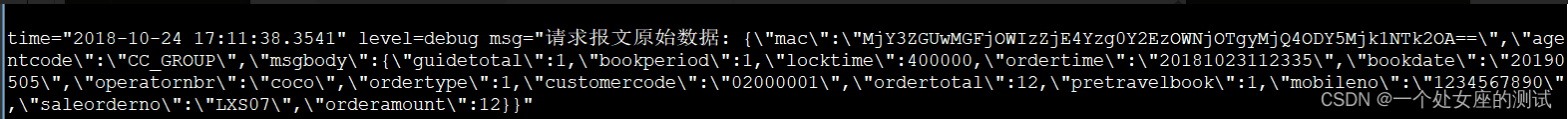

处理之后,服务器收到的请求数据:

第2种情况:服务端对于接收到的json数据中,若key和value之间有空格,则解析不了。

在解决了固定顺序键名问题之后,可能你还会遇到,后台开发大佬 跟你说:不行啊,你这键名和键值之间有空格,我们不支持解析。

这种情况下,要么你让开发改代码,要么你自己发送的请求中去掉空格。如果你说服不了开发改,那就只能自己处理啦。自己的处理的话,请继续往下看。

此乃空格:

首先,找原因。空格是怎么来的??

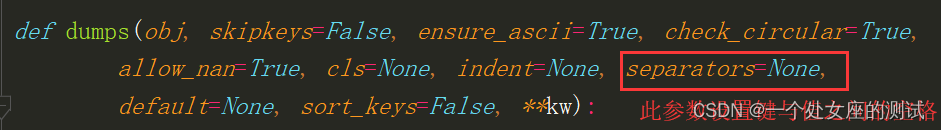

在requests库的源码当中,发送出去的请求数据,默认键名和键值之间都是带空格的。

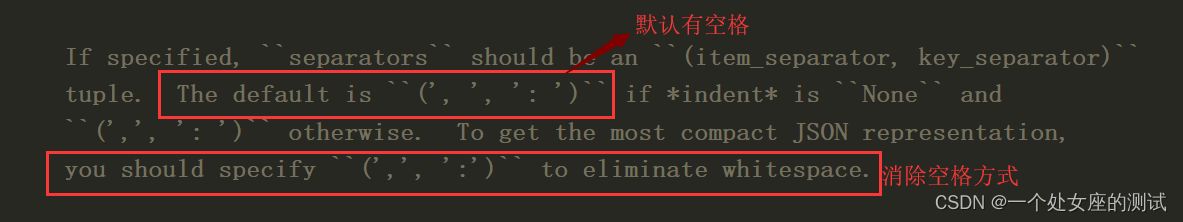

在源码当中,对传进来的json参数,使用json库的dumps函数转换成json对象,而dumps函数默认设置了键名和键值之间的留有一个空格。

所以,要消除键与值之间的空格,需要在requests的源码当中,将参数转换成json对象时,设置separators的值去掉空格。这样发往服务器的数据中键名和值之间就没有空格了。

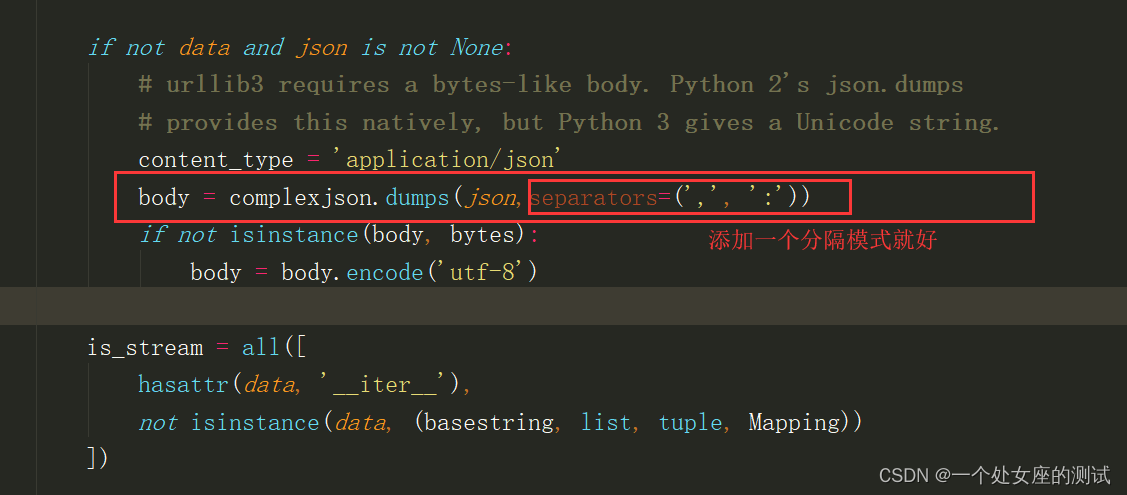

修改源码如下:

在requests源码的models.py文件中,找到prepare_body函数,修改如下图片中,红色框框中的内容:指定json中键名和键值之间无空格

修改完成之后,再次向服务器发送json数据格式的post请求,服务器收到的数据如下(可以看到键名和值之间没有空格了哦。。):

json 请求中中文乱码处理

最近收到一个问题:json格式请求数据中有中文,导致服务端签名失败。

问题详情:

一位同学在发送json格式的post请求时,请求数据中有中文内容:

{"inputCodes":["6932608700850"],"terminal":{"status":1,"channel":"D002","storeCode":"2107","passage":"D002","storeName":"重百超市黄泥塝店","identity":"","maxProductCount":5,"posId":"D002"}}

header={"client_id":"DataSync","sign":"46BA170CFC30C571358E59EDDA63B506","Content-Type":"application/json;charset=UTF-8"}

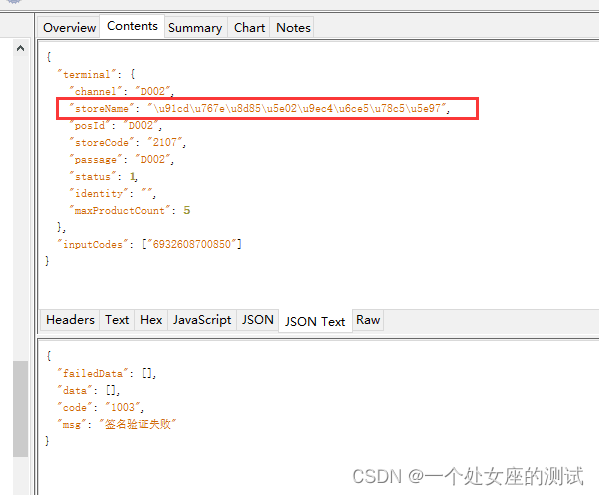

在使用requests库的post请求发送出去之后,服务端收到的不是中文,导致签名失败,数据如下:

{"terminal": {"status": 1, "channel": "D002", "identity": "", "passage": "D002", "maxProductCount": 5, "posId": "D002", "storeName": "\u91cd\u767e\u8d85\u5e02\u9ec4\u6ce5\u585d\u5e97", "storeCode": "2107"}, "inputCodes": ["6932608700850"]}

希望在服务端中收到的数据中,中文仍然是中文,因为有些服务端并没有此做处理。

解决方法:

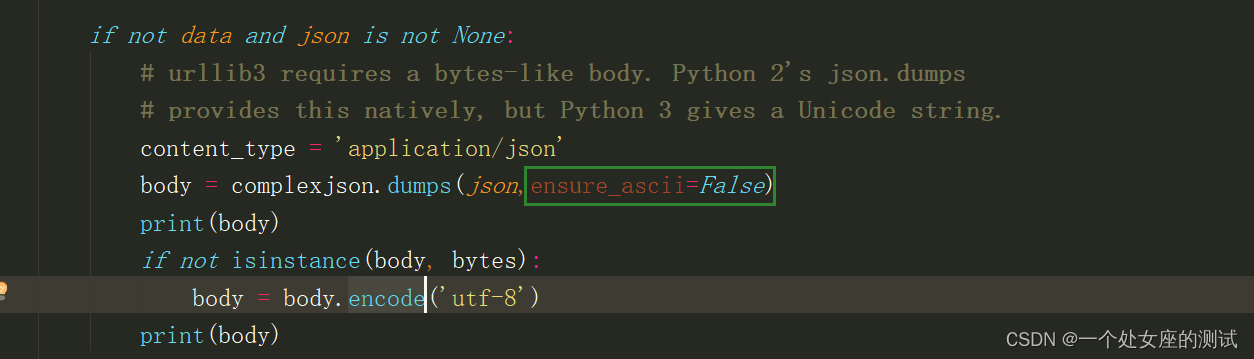

requests库中,在处理json格式的请求时调用的json.dumps方法参数ensure_ascii默认为True.表示序列化时对中文默认使用的ascii编码。

如果想要显示中文,则将此参数的值改为False即可。

源码修改:

在requests源码的models.py文件中,找到prepare_body函数。找到如下图中的代码,在comlexjson.dumps(json)里加个参数ensure_ascii=False.

保存源码的修改之后,再次运行,在服务器端就能看到中文啦。

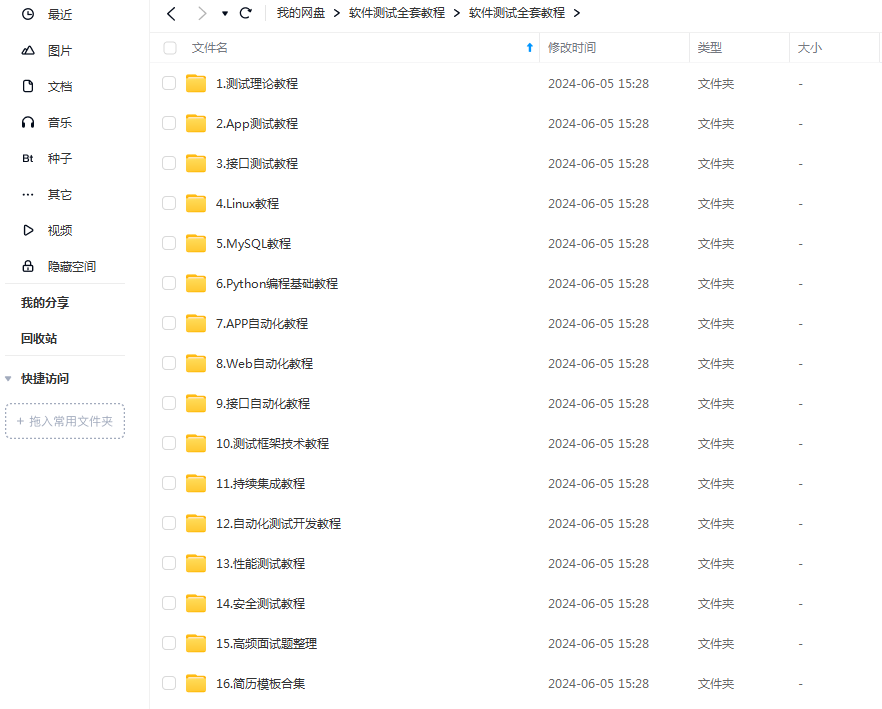

最后感谢每一个认真阅读我文章的人,礼尚往来总是要有的,虽然不是什么很值钱的东西,如果你用得到的话可以直接拿走:

这些资料,对于【软件测试】的朋友来说应该是最全面最完整的备战仓库,这个仓库也陪伴上万个测试工程师们走过最艰难的路程,希望也能帮助到你!