- 1网络安全简答题

- 2社交媒体数据治理:Facebook的隐私与透明度

- 3脉冲神经网络-基于IAF神经元的手写数字识别_脉冲神经网络 可视化

- 4用 Python 轻松实现机器学习_python做machine learning

- 5怎样用Excel搜索表格内的内容?_excel表格怎么查找内容

- 6机器学习-周志华-课后习题答案-决策树_试选择 4 个 uci 数据集,对上述 3 种算法所产生的未剪枝、预剪枝、后剪枝决策树进

- 7kibana 查询ES 的一些语法_kibana查询es基本语法

- 8解密目前主流的机器人导航方法

- 9LSTM神经网络详解

- 10复试专业前沿问题问答合集7-2——神经网络与强化学习_复试问及卷积神经网络

【论文阅读】NeurIPS 2022 || Boosting the Transferability of Adversarial Attackswith Reverse Adversarial P

赞

踩

-

论文/Paper: http://arxiv.org/pdf/2210.05968

-

代码/Code: https://github.com/sclbd/transfer_attack_rap

目录

Abstract

深度神经网络(dnn)已被证明容易受到对抗样本的影响,对抗样本可以通过注入难以察觉的扰动来产生错误的预测。在这项工作中,我们研究了对抗样本的可迁移性,这是重要的,因为它对模型架构或参数通常未知的现实世界应用的威胁。许多现有的研究表明,对抗样例可能会过度拟合生成它们的替代模型,从而限制了其针对不同目标模型的迁移攻击性能。为了减轻替代模型的过拟合,我们提出了一种新的攻击方法,称为反向对抗扰动(RAP)。具体而言,我们主张在优化过程的每一步注入最坏情况扰动(即反向对抗扰动),而不是最小化单个对抗点的损失,来寻找位于统一的低损失值区域的对抗样本。将RAP对抗攻击问题表述为最小-最大双级优化问题。通过将RAP集成到攻击的迭代过程中,我们的方法可以找到对决策边界变化不敏感的更稳定的对抗样本,从而减轻了替代模型的过拟合。综合实验比较表明,RAP可以显著提高对抗迁移能力。此外,RAP可以与许多现有的黑盒攻击技术自然结合,进一步提高可迁移性。在攻击真实世界的图像识别系统(即Google Cloud Vision API)时,我们比较其他方法获得了22%的目标攻击性能提升。

Introduction

PGD攻击的目标是寻找攻击损失最小的对抗点x PGD,而不考虑x PGD周围邻域的攻击损失。由于深度模型的高度非凸性,当x pgd处于急剧的局部极小值时,MS模型参数的微小变化都会导致攻击损失的大幅增加,使得x pgd无法攻击被扰动的模型。为了缓解过拟合和提高可迁移性,已经提出了许多技术,包括输入变换[6,48]、梯度校准[14]、特征级攻击[17]和生成模型[30]等。

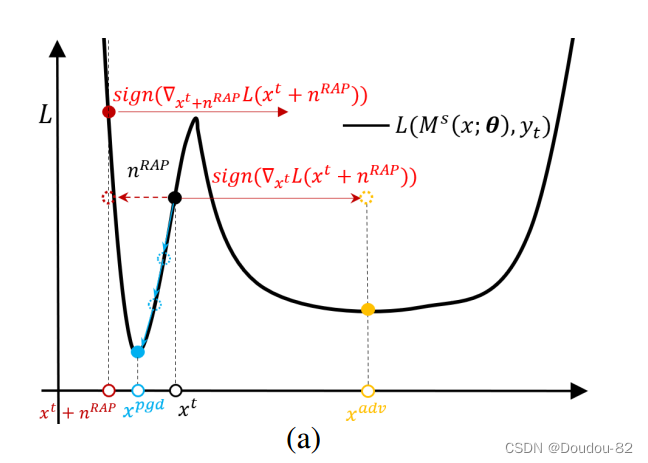

在这项工作中,我们从对抗样本的平坦度的角度研究了对抗性可迁移性。我们发现位于平坦局部最小值处的对抗样例比位于尖锐局部最小值处的对抗样例更具可迁移性,并提出了一种寻找位于平坦局部最小值处的对抗样例的新算法。我们鼓励x adv不仅具有低攻击损失,而且位于局部平坦区域,即x adv周围的局部邻域内的点也应该具有低损失值。图1 (b)说明了尖锐局部最小值和平面局部最小值之间的区别。当MS模型参数发生轻微变化时,攻击损失随局部平坦最小值的变化小于局部尖锐最小值的变化。因此,平面局部最小值对决策边界的变化不太敏感。为了实现这一目标,我们提出了一个最小-最大双级优化问题。内部最大化的目的是在当前对抗样本周围的局部区域内找到最坏情况扰动(即攻击损失最大的扰动,这就是为什么我们称之为反向对抗扰动),可以通过投影梯度上升算法求解。然后,外部最小化将更新对抗样本以找到一个新的点,并添加提供的反向扰动,从而导致更低的攻击损失。图1 (a)展示了优化过程。对于第t次迭代和x t, RAP首先在x t的邻域内找到攻击损失最大的点x t + n RAP。然后用最小化攻击损失w.r.t. x t + n rap计算的梯度更新x t。与直接采用x t处的梯度相比,RAP可以帮助摆脱尖锐的局部极小值,而追求相对平坦的局部极小值。

RAP可以与许多现有的黑盒攻击技术自然结合,进一步提高可迁移性。

Methodology

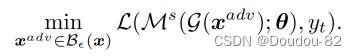

为了减少对MS的过拟合,我们建议寻找位于平坦局部区域的xadv。这意味着我们鼓励不仅x adv本身具有低损失值,而且x adv附近的点也具有类似的低损失值。为此,我们提出在对抗样本x adv周围的局部邻域内最小化最大损失值。内部最大化损失通过扰动x adv来实现,使攻击损失最大化,由投影梯度上升算法求解,称为反向对抗扰动(RAP)。

![]()

外部最小化x adv可以用一步投影梯度下降法来确定

![]()

上述式子对应的是目标攻击,将损失函数L、yt分别用- L、y代替即可轻松得到相应的非目标公式。

RAP-LS

初步实验中,我们发现RAP需要更多的迭代来收敛,并且与基线攻击方法相比,在初始迭代期间性能略低。

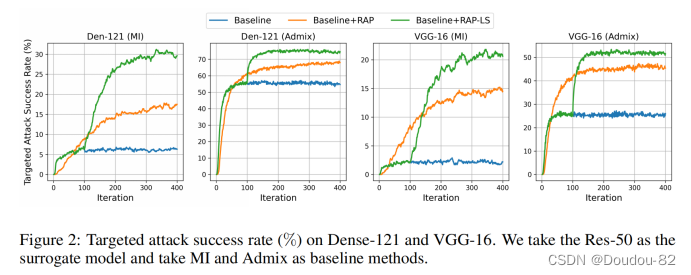

可以观察到,使用RAP的方法(见橙色曲线)迅速超越了其基线方法(见蓝色曲线),并且最终在迭代次数更多的情况下获得了更高的成功率,这验证了RAP对增强对抗可迁移性的作用。然而,也观察到RAP在早期的性能略低于其基线方法。可能的原因是早期攻击对替代模型的攻击性能非常弱。在这种情况下,通过解决最小-最大问题来追求更好的可迁移攻击可能是浪费。较好的策略可能是在前期只解决最小化问题(1),快速达到对抗攻击性能相对较高的区域,然后启动RAP,同时进一步提高攻击性能和可迁移性。我们将该策略记为RAP with late-start (RAP- ls),其效果得到图2结果(见绿色曲线)的初步支持,并将在后续实验中进行广泛评价。

(1)

(1)