- 1手把手教你学Python之常见运算符_python 中判断两个数相除为整数和小数

- 2用STM32自制APM四轴飞行器_stm32f103rct6无人机飞控

- 3【免费题库】华为OD机试 - 单词重量(Java & JS & Python & C & C++)

- 4网络安全渗透测试工具AWVS14.6.2的安装与使用(激活)_awvs生成报告

- 5pycharm使用Anaconda中的虚拟环境【我的入门困惑二】_pycharm创建的anaconda虚拟环境,如何进入虚拟环境

- 6winform GridControl 总结

- 7神经网络BP反向传播算法Error Backpropagation_神经网络反向传播算法论文原文

- 8OpenHarmony应用编译 - 如何在源码中编译复杂应用(4.0-Release)

- 9php 用webhook实现git同步服务器代码 2022.8.18_webhook php

- 10hadoop spark jupyterbook 打开过程_hadoop jupyter

深度学习之反向传播与梯度下降详解_深度学习模型利用梯度下降和反向传播算法进行训练,使用交叉验证 和超参数优化技术

赞

踩

一,前向传播与反向传播

1.1,神经网络训练过程

神经网络训练过程是:

- 先通过随机参数“猜“一个结果(模型前向传播过程),这里称为预测结果 a a a;

- 然后计算 a a a 与样本标签值 y y y 的差距(即损失函数的计算过程);

- 随后通过反向传播算法更新神经元参数,使用新的参数再试一次,这一次就不是“猜”了,而是有依据地向正确的方向靠近,毕竟参数的调整是有策略的(基于梯度下降策略)。

以上步骤如此反复多次,一直到预测结果和真实结果之间相差无几,亦即 ∣ a − y ∣ → 0 |a-y|\rightarrow 0 ∣a−y∣→0,则训练结束。

总结:所谓模型训练,其实就是通过如 SGD 优化算法指导模型参数更新的过程。

1.2,前向传播

前向传播(forward propagation 或 forward pass)指的是: 按顺序(从输入层到输出层)计算和存储神经网络中每层的结果。

为了更深入理解前向传播的计算过程,我们可以根据网络结构绘制网络的前向传播计算图。下图是简单网络与对应的计算图示例:

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-J8GitLOJ-1691805706216)(../images/bp/网络结构与前向计算图.png)]](https://img-blog.csdnimg.cn/e7bf04705bd04ba68c3df3ef15a088b3.png)

其中正方形表示变量,圆圈表示操作符。数据流的方向是从左到右依次计算。

1.3,反向传播

反向传播(backward propagation,简称 BP)指的是计算神经网络参数梯度的方法。其原理是基于微积分中的链式规则,按相反的顺序从输出层到输入层遍历网络,依次计算每个中间变量和参数的梯度。

梯度的自动计算(自动微分)大大简化了深度学习算法的实现。

注意,反向传播算法会重复利用前向传播中存储的中间值,以避免重复计算,因此,需要保留前向传播的中间结果,这也会导致模型训练比单纯的预测需要更多的内存(显存)。同时这些中间结果占用内存(显存)大小与网络层的数量和批量(batch_size)大小成正比,因此使用大 batch_size 训练更深层次的网络更容易导致内存不足(out of memory)的错误!

1.4,总结

- 前向传播在神经网络定义的计算图中按顺序计算和存储中间变量,它的顺序是从输入层到输出层。

- 反向传播按相反的顺序(从输出层到输入层)计算和存储神经网络的中间变量和参数的梯度。

- 在训练神经网络时,在初始化模型参数后,我们交替使用前向传播和反向传播,基于反向传播计算得到的梯度,结合随机梯度下降优化算法(或者

Adam等其他优化算法)来更新模型参数。 - 深度学习模型训练比预测需要更多的内存。

二,梯度下降

2.1,深度学习中的优化

大多数深度学习算法都涉及某种形式的优化。优化器的目的是更新网络权重参数,使得我们平滑地到达损失面中损失值的最小点。

深度学习优化存在许多挑战。其中一些最令人烦恼的是局部最小值、鞍点和梯度消失。

- 局部最小值(

local minimum): 对于任何目标函数 f ( x ) f(x) f(x),如果在 x x x 处对应的 f ( x ) f(x) f(x) 值小于在 x x x 附近任何其他点的 f ( x ) f(x) f(x) 值,那么 f ( x ) f(x) f(x) 可能是局部最小值。如果 f ( x ) f(x) f(x) 在 x x x 处的值是整个域上目标函数的最小值,那么 f ( x ) f(x) f(x) 是全局最小值。 - 鞍点(

saddle point): 指函数的所有梯度都消失但既不是全局最小值也不是局部最小值的任何位置。 - 梯度消失(

vanishing gradient): 因为某些原因导致目标函数 f f f 的梯度接近零(即梯度消失问题),是在引入ReLU激活函数和ResNet之前训练深度学习模型相当棘手的原因之一。

在深度学习中,大多数目标函数都很复杂,没有解析解,因此,我们需使用数值优化算法,本文中的优化算法: SGD 和 Adam 都属于此类别。

2.2,如何理解梯度下降法

梯度下降(gradient descent, GD)算法是神经网络模型训练中最为常见的优化器。尽管梯度下降(gradient descent)很少直接用于深度学习,但理解它是理解随机梯度下降和小批量随机梯度下降算法的基础。

大多数文章都是以“一个人被困在山上,需要迅速下到谷底”来举例理解梯度下降法,但这并不完全准确。在自然界中,梯度下降的最好例子,就是泉水下山的过程:

- 水受重力影响,会在当前位置,沿着最陡峭的方向流动,有时会形成瀑布(梯度的反方向为函数值下降最快的方向);

- 水流下山的路径不是唯一的,在同一个地点,有可能有多个位置具有同样的陡峭程度,而造成了分流(可以得到多个解);

- 遇到坑洼地区,有可能形成湖泊,而终止下山过程(不能得到全局最优解,而是局部最优解)。

示例参考 AI-EDU: 梯度下降。

2.3,梯度下降原理

梯度下降的数学公式:

θ n + 1 = θ n − η ⋅ ∇ J ( θ ) (1) \theta_{n+1} = \theta_{n} - \eta \cdot \nabla J(\theta) \tag{1} θn+1=θn−η⋅∇J(θ)(1)

其中:

- θ n + 1 \theta_{n+1} θn+1:下一个值(神经网络中参数更新后的值);

- θ n \theta_n θn:当前值(当前网络参数值);

- − - −:减号,梯度的反向(梯度的反方向为函数值下降最快的方向);

- η \eta η:学习率或步长,控制每一步走的距离,不要太快以免错过了最佳景点,不要太慢以免时间太长(需要手动调整的超参数);

- ∇ \nabla ∇:梯度,,表示函数当前位置的最快上升点(梯度向量指向上坡,负梯度向量指向下坡);

- J ( θ ) J(\theta) J(θ):函数(等待优化的目标函数)。

下图展示了梯度下降法的步骤。梯度下降的目的就是使得 x x x 值向极值点逼近。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-qYJB65oW-1691805706216)(../images/bp/gd_concept.png)]](https://img-blog.csdnimg.cn/e81142f50ee5477e8cbd8e8a6ac625d1.png)

下面我通过一个简单的双变量凸函数 J ( x , y ) = x 2 + 2 y 2 J(x, y) = x^2 + 2y^2 J(x,y)=x2+2y2 为例,来描述梯度下降的优化过程。

通过梯度下降法寻找函数的最小值,首先得计算其函数梯度:

∂ J ( x , y ) ∂ x = 2 x ∂ J ( x , y ) ∂ y = 4 y {\partial{J(x,y)} \over \partial{x}} = 2x \\ {\partial{J(x,y)} \over \partial{y}} = 4y ∂x∂J(x,y)=2x∂y∂J(x,y)=4y

设初始点为 ( x 0 , y 0 ) = ( − 3 , − 3 ) (x_0, y_0) = (-3, -3) (x0,y0)=(−3,−3),学习率 η = 0.1 \eta = 0.1 η=0.1,根据梯度下降公式(1),可得参数迭代过程的计算公式:

(

x

n

+

1

,

y

n

+

1

)

=

(

x

n

,

y

n

)

−

η

⋅

∇

J

(

x

,

y

)

=

(

x

n

,

y

n

)

−

η

⋅

(

2

x

,

4

y

)

这里手动计算下下一个迭代点的值:

(

x

1

,

y

1

)

=

(

−

3

,

−

3

)

−

0.1

∗

(

2

∗

−

3

,

4

∗

−

3

)

=

(

−

3

+

0.6

,

−

3

+

1.2

)

=

(

−

2.4

,

−

1.8

)

根据上述公式 (2),假设终止条件为 J ( x , y ) J(x,y) J(x,y) < 0. 005,迭代过程如下表1所示。

表1 双变量函数梯度下降的迭代过程

| 迭代次数 | x x x | y y y | J ( x , y ) J(x,y) J(x,y) |

|---|---|---|---|

| 1 | -3 | -3 | 27 |

| 2 | -2.4 | y=-1.8 | 12.24 |

| … | … | … | … |

| 16 | -0.084442 | -0.000846 | 0.007132 |

| 17 | -0.067554 | y=-0.000508 | 0.004564 |

迭代 17 17 17 次后, J ( x , y ) J(x,y) J(x,y) 的值为 0.004564 0.004564 0.004564,满足小于 0.005 0.005 0.005 的条件,停止迭代。

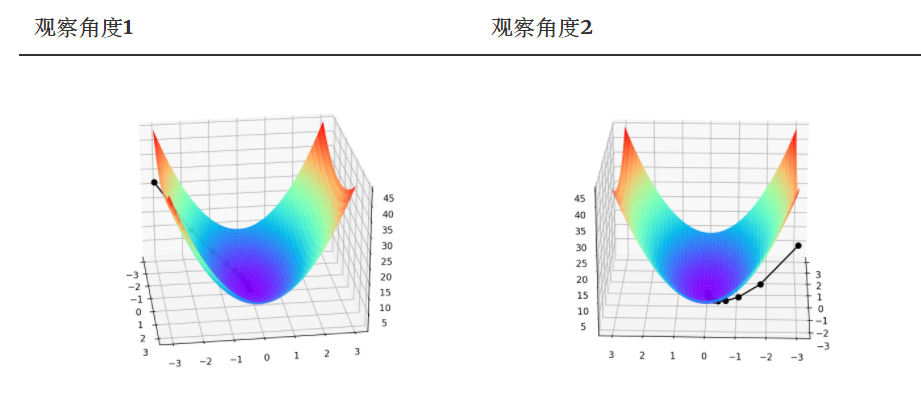

由于是双变量,所以梯度下降的迭代过程需要用三维图来解释。表2可视化了三维空间内的梯度下降过程。

图中间那条隐隐的黑色线,表示梯度下降的过程,从红色的高地一直沿着坡度向下走,直到蓝色的洼地。

双变量凸函数 J ( x , y ) = x 2 + 2 y 2 J(x, y) = x^2 + 2y^2 J(x,y)=x2+2y2 的梯度下降优化过程以及可视化代码如下所示:

# Copyright (c) Microsoft. All rights reserved.

# Licensed under the MIT license. See LICENSE file in the project root for full license information.

import numpy as np

import matplotlib.pyplot as plt

from mpl_toolkits.mplot3d import Axes3D

def target_function(x,y):

J = pow(x, 2) + 2*pow(y, 2)

return J

def derivative_function(theta):

x = theta[0]

y = theta[1]

return np.array([2*x, 4*y])

def show_3d_surface(x, y, z):

fig = plt.figure()

ax = Axes3D(fig)

u = np.linspace(-3, 3, 100)

v = np.linspace(-3, 3, 100)

X, Y = np.meshgrid(u, v)

R = np.zeros((len(u), len(v)))

for i in range(len(u)):

for j in range(len(v)):

R[i, j] = pow(X[i, j], 2)+ 4*pow(Y[i, j], 2)

ax.plot_surface(X, Y, R, cmap='rainbow')

plt.plot(x, y, z, c='black', linewidth=1.5, marker='o', linestyle='solid')

plt.show()

if __name__ == '__main__':

theta = np.array([-3, -3]) # 输入为双变量

eta = 0.1 # 学习率

error = 5e-3 # 迭代终止条件,目标函数值 < error

X = []

Y = []

Z = []

for i in range(50):

print(theta)

x = theta[0]

y = theta[1]

z = target_function(x,y)

X.append(x)

Y.append(y)

Z.append(z)

print("%d: x=%f, y=%f, z=%f" % (i,x,y,z))

d_theta = derivative_function(theta)

print(" ", d_theta)

theta = theta - eta * d_theta

if z < error:

break

show_3d_surface(X,Y,Z)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

注意!总结下,不同的步长 η \eta η ,随着迭代次数的增加,会导致被优化函数 J J J 的值有不同的变化:

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-b62fv8HW-1691805706217)(../images/bp/different_lr_loss.png)]](https://img-blog.csdnimg.cn/005ea22277d940ceb2b0fc95e6158ef7.png)

图片来源如何理解梯度下降法?。

三,随机梯度下降与小批量随机梯度下降

3.1,随机梯度下降

在深度学习中,目标函数通常是训练数据集中每个样本的损失函数的平均值。如果使用梯度下降法,则每个自变量迭代的计算代价为 O ( n ) O(n) O(n),它随 n n n(样本数目)线性增⻓。因此,当训练数据集较大时,每次迭代的梯度下降计算代价将较高。

随机梯度下降(SGD)可降低每次迭代时的计算代价。在随机梯度下降的每次迭代中,我们对数据样本随机均匀采样一个索引

i

i

i,其中

i

∈

1

,

.

.

.

,

n

i \in {1, . . . , n}

i∈1,...,n,并计算梯度

∇

J

(

θ

)

\nabla J(\theta)

∇J(θ) 以更新权重参数

θ

\theta

θ:

θ n + 1 = θ n − η ⋅ ∇ J i ( θ ) (3) \theta_{n+1} = \theta_{n} - \eta \cdot \nabla J_i(\theta) \tag{3} θn+1=θn−η⋅∇Ji(θ)(3)

每次迭代的计算代价从梯度下降的 O ( n ) O(n) O(n) 降至常数 O ( 1 ) O(1) O(1)。另外,值得强调的是,随机梯度 ∇ J i ( θ ) \nabla J_i(\theta) ∇Ji(θ) 是对完整梯度 ∇ J ( θ ) \nabla J(\theta) ∇J(θ) 的无偏估计。

无偏估计是用样本统计量来估计总体参数时的一种无偏推断。

在实际应用中,随机梯度下降 SGD 法必须和动态学习率方法结合起来使用,否则使用固定学习率 + SGD的组合会使得模型收敛过程变得更复杂。学习率的调整策略可参考我之前写的文章-深度学习炼丹-超参数设定和模型训练。

3.2,小批量随机梯度下降

前面讲的梯度下降(GD)和随机梯度下降(SGD)方法都过于极端,要么使用完整数据集来计算梯度并更新参数,要么一次只处理一个训练样本来更新参数。在实际项目中,会对两者取折中,即小批量随机梯度下降(minibatch stochastic gradient descent),其有以下优点:

-

首先,小批量损失的梯度是对训练集梯度的估计,其质量随着批量大小的增加而提高。

-

其次,由于现代计算平台提供的并行性,批量计算比单个示例的 m m m 计算效率更高。

小批量的所有样本数据元素都是从训练集中随机抽取的,假设样本数目个数为

m

m

m(batch_size = m),即迭代训练的每一步我们都考虑的是一个大小为

m

m

m 的小批量样本

x

1...

m

\mathbf{x_{1...m}}

x1...m。

θ n + 1 = θ n − η ⋅ 1 m ∇ ∑ i m J i ( x , θ ) (3) \theta_{n+1} = \theta_{n} - \eta \cdot \frac{1}{m}\nabla \sum_{i}^{m}J_i(\textrm{x},\theta) \tag{3} θn+1=θn−η⋅m1∇i∑mJi(x,θ)(3)

梯度计算符号也可用 ∂ ℓ ( x i , θ ) ∂ θ \frac{\partial \ell(\textrm{x}_{i}, \theta)}{\partial \theta} ∂θ∂ℓ(xi,θ)表示, x \textrm{x} x 表示训练集, θ \theta θ 表示网络参数, ℓ ( x i , θ ) \ell(\textrm{x}_{i}, \theta) ℓ(xi,θ) 表示待优化的目标函数。

另外,一般项目中使用 SGD 优化算法都默认会使用小批量随机梯度下降,即 batch_size > 1,除非显卡显存不够了,才会设置 batch_size = 1。

四,总结

虽然随机梯度下降法(SGD)简单有效,但它需要仔细调整模型超参数,特别是优化中使用的学习率,以及模型参数的初始值。 由于每一层的输入都受到前面所有层的参数的影响,因此训练变得很复杂。(因为随着网络变得更深,网络参数的微小变化会被累积和放大)

参考资料

- 如何理解梯度下降法?

- AI-EDU: 梯度下降

- 《动手学习深度学习11章-优化算法》