热门标签

热门文章

- 1被裁后入职拼多多,年薪50W,网友:感谢公司裁员之恩!

- 2爬虫框架 Selenium Pyppeteer Playwright Luna对比_playwright和selenium优缺点

- 3MAX30102 模块-心率血氧传感器_max30102传感器

- 4二分法问题

- 5Android 获取 usb 权限的两种方法_action_usb_permission

- 6给数组添加元素的6个方法_数组添加元素的方法

- 7相亲交友小程序,多端交付,支持二开,交友app小程序搭建陌生人交友私域聊天

- 82019年第十届蓝桥杯真题解析【Python】_蓝桥杯第10届国赛真题 python

- 9git版本回退_gitee版本回退

- 10ARP欺骗和DNS劫持以及Wireshark分析_arp劫持

当前位置: article > 正文

基于树莓派4B的NCNN部署YOLOv5-Lite(代码开源)_yolov5 lite源码

作者:笔触狂放9 | 2024-04-18 02:32:50

赞

踩

yolov5 lite源码

前言:本篇博客为《基于树莓派4B的YOLOv5-Lite目标检测的移植与部署》的后续博客,主旨为帮助大家实现 ONNX 模型到 NCNN 模型的转换,并且在树莓派4B进行成功部署!正常情况下,NCNN 模型是优于 ONNX 模型的,但是作者实际测试下来发现貌似 ONNX 模型的FPS和精度感觉都略优秀于 NCNN 模型,读者朋友可以根据自己时间情况去选择模型的使用!

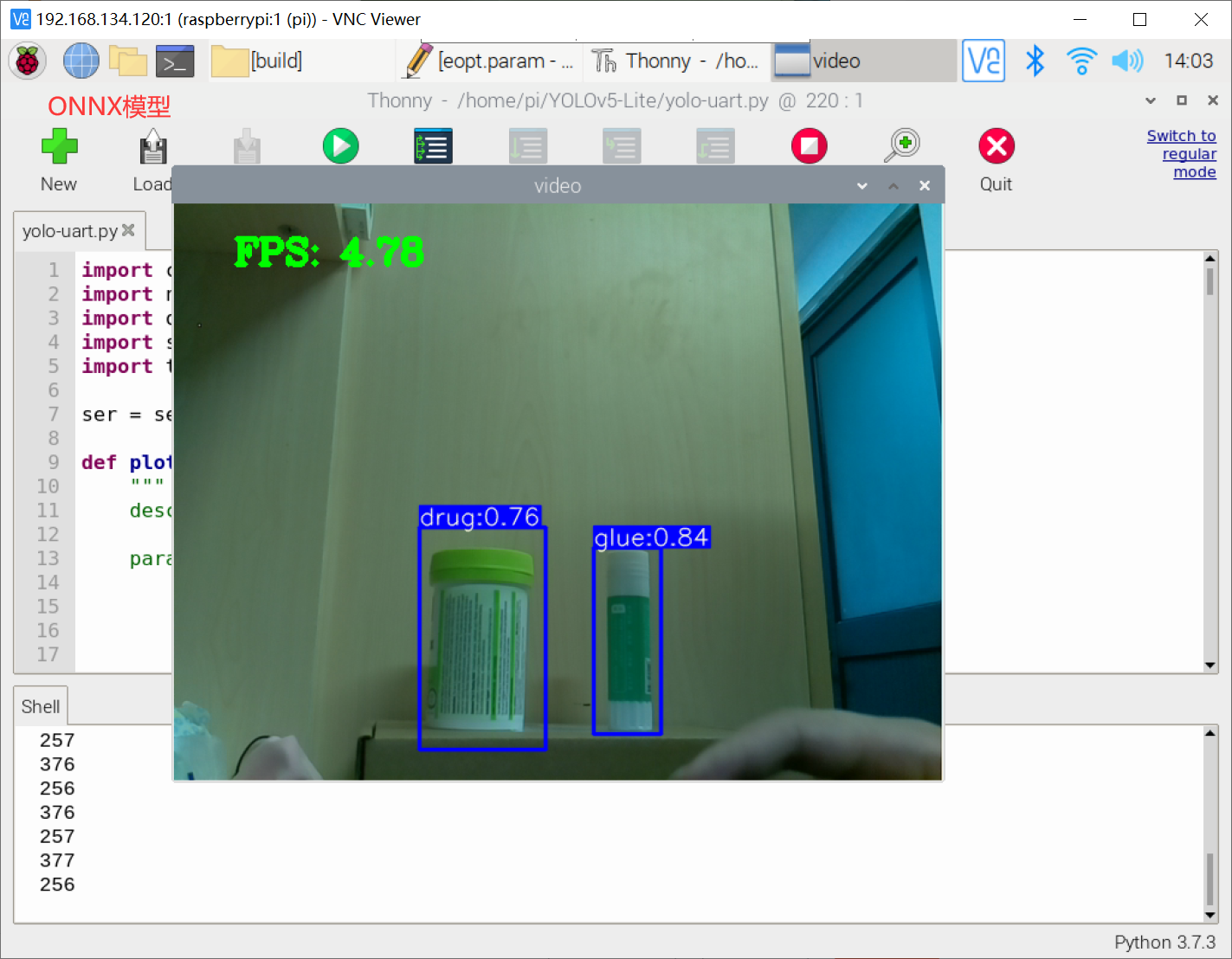

实验效果图:

YOLOv5-Lite的ONNX模型FPS:4.78

YOLOv5-Lite的NCNN模型FPS:3.77

按道理来说,NCNN 模型的推理速度是快于 ONNX 模型的,作者这边也不知道什么情况。

一、工程前瞻

NCNN 的网络模型通常需要使用简化后的 ONNX 模型来转换,ONNX 模型依赖于原始的训练权重 Weight 的存在,故此我们需要使用自己的训练集于神经网络模型进行训练!

这部分的详解教程可以借鉴:http://t.csdn.cn/msjCZ

推荐阅读

相关标签