- 1Description Resource Path Location TypeCannot change version of project facet Dynamic Web Module to_descriptionresourcepathlocationtype cannot change

- 2postgresql 使用之 存储架构 触摸真实数据的存储结构以及组织形式,存入数据库的数据原来在这里_postgresql 数据存在哪个文件

- 3uni-app - 使用 npm 安装第三方包_uniapp使用npm安装的第三方依赖

- 4gdip-yolo项目解读:gdip模块 |mdgip模块 |GDIP regularizer模块的使用分析|生成带雾图像|生成低亮度图片

- 5wps教育版支持latex公式啦_wps怎么识别latex

- 6PS的滤镜效果_ps滤镜效果

- 7ZooKeeper集群安装后显示ZooKeeper JMX enabled by defaultUsing config: /opt/app/zookeeper-3.4.13/bin/../conf

- 8深度|中国SaaS蜕变:从管理工具到商业化工具_saas产品商业化方案

- 9Python从小白到高手实现系列一百二十:用Fabric 进行自动化部署_python fabric 部署

- 10HAL库STM32C8T6最小系统板用串口做应声虫

如何看待阿里巴巴最新开源的第1.5代千问大模型Qwen-1.5系列?

赞

踩

击上方关注 “终端研发部”

设为“星标”,和你一起掌握更多数据库知识1.5代千问大模型系列的发布,预示着AI之战已打响!

通义千问是什么?

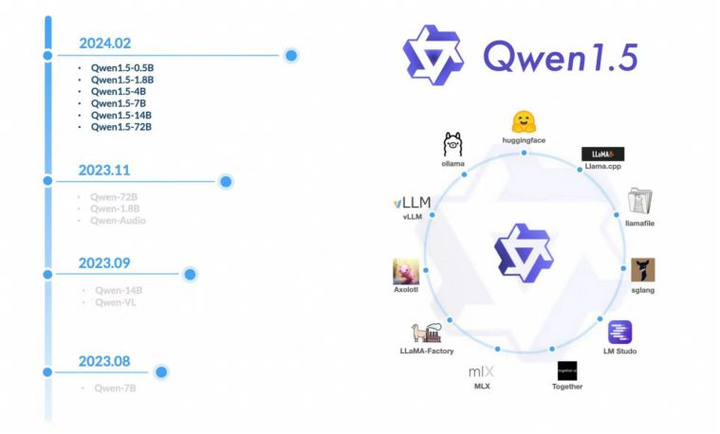

通义千问是阿里云研发的通义千问大模型系列,基于Transformer的大语言模型, 在超大规模的预训练数据上进行训练得到。预训练数据类型多样,覆盖广泛,包括大量网络文本、专业书籍、代码等。截止到目前为止,QWen支持1.8B、7B、14B、72B、VL等多种参数规模的模型!

本次发布的升级有几个亮点:

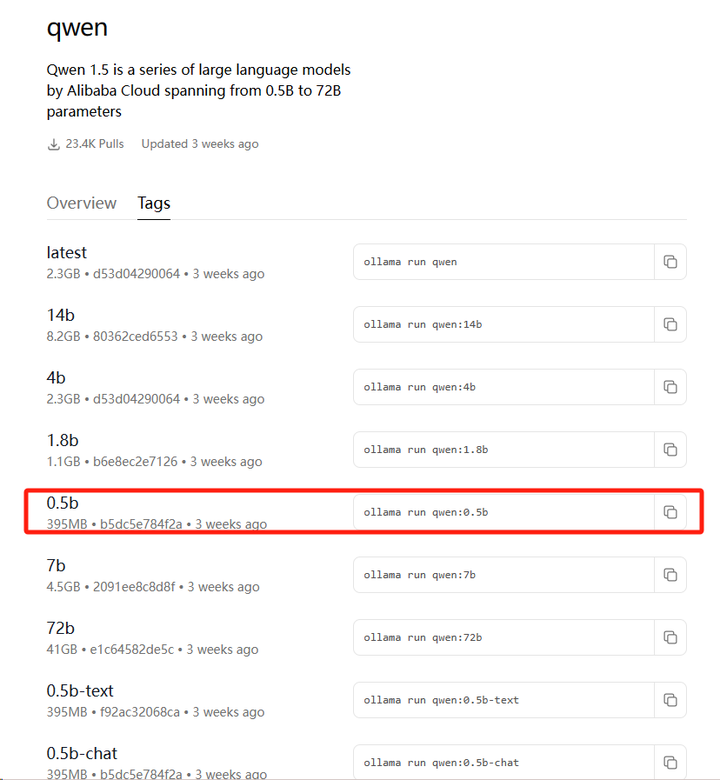

1、提供6种不同参数规模的型号:0.5B、1.8B、4B、7B、14B直至顶级配置的72B,旨在满足多样化的应用场景需求。

2、与Hugging Face Transformers等主流框架的紧密结合,简化了开发过程。

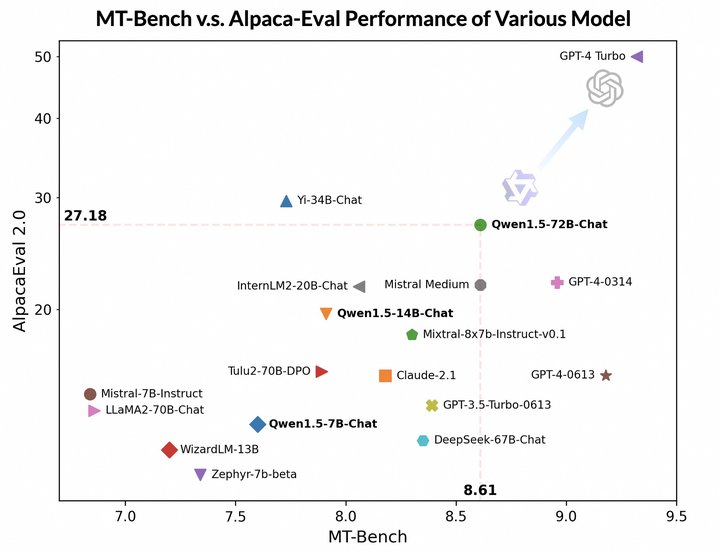

3、聊天模型性能的大幅提升,以及在MT-Bench等基准测试中的优秀表现。

4、全系列模型支持32K上下文长度、增强的多语言能力和统一的system prompt等特性。

5、在本地环境流畅运行,同时还发布了GPTQ Int-4 / Int8、AWQ以及GGUF权重等关键技术资源,进一步提升模型效率及性能表现

第1.5代千问大模型Qwen有什么样的能力?

基础能力

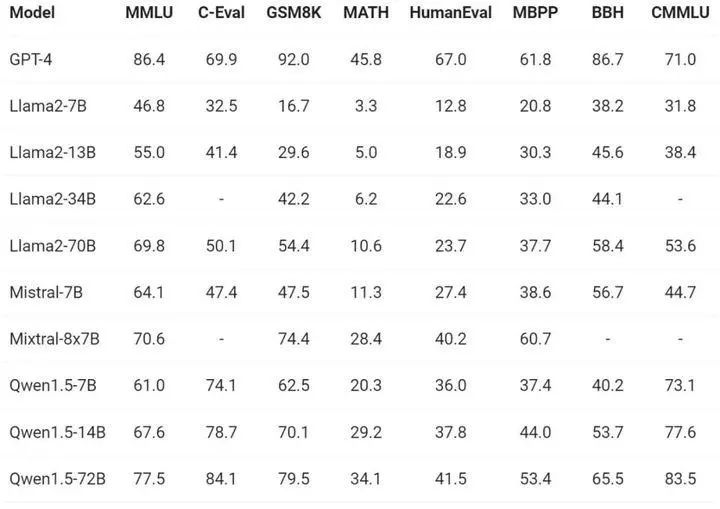

在不同模型尺寸下,团队也利用不同基准数据集对进行了评估,结果Qwen1.5 表现出强大了性能,72B 的版本在所有基准测试中都超越了 Llama2-70B,展示了其在语言理解、推理和数学方面的能力。

多语言能力

在来自欧洲、东亚和东南亚的 12 种不同语言上,通义千问团队评估了 Base 模型的多语言能力。从开源社区的公开数据集中,阿里研究者构建了如下表所示的评测集合,共涵盖四个不同的维度:考试、理解、翻译、数学。下表提供了每个测试集的详细信息,包括其评测配置、评价指标以及所涉及的具体语言种类。

Qwen1.5还与多个知名的第三方框架建立了合作关系,包括但不限于vLLM(面向各类大型语言模型的框架)、SGLang(专注于部署的框架)、AutoAWQ和AutoGPTQ(针对模型量化的工具)、Axolotl(专用于模型微调的框架)、LLaMA-Factory(提供定制化模型服务的平台)以及llama.cpp(专注于本地大型语言模型推理的库)其API服务不仅在DashScope平台上有所提供,还在Together.ai平台上推出,确保了其全球范围内的可访问性。

支持长图文生成

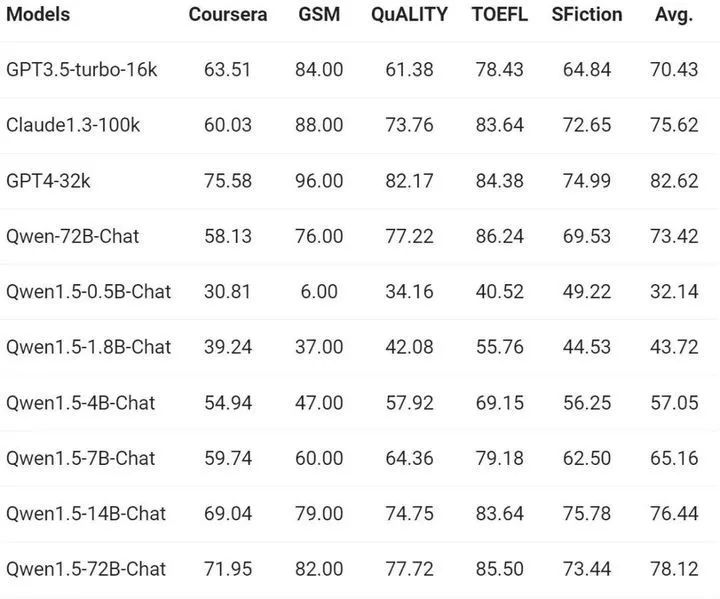

Qwen1.5模型的性能,该基准便能衡量模型根据长上下文生成响应的能力;

在发布的几个不同的几个模型中,既有大模型,又有小模型,应对了不同场景,小到完全可以移植到手机上跑,也就是移动端大模型,比如0.5B,1.8B,因为可以称其为AI手机模型

从上述结果来看,在不同模型尺寸下,Qwen1.5都在评估基准中表现出强劲的性能。特别是,Qwen1.5-72B 在所有基准测试中都远远超越了Llama2-70B,展示了其在语言理解、推理和数学方面的卓越能力。

支持那些应用场景

鉴于大模型不同大小的模型,满足你的各种需求。比如,在人设聊天方面,国外已经有人尝试通过大模型与说唱歌星进行聊天。

其他场景:

问答系统、文本生成、语言翻译、对话系统、语音识别和语音合成、语义理解和实体识别 、知识图谱构建。

大模型的相关产业还处在一个发展的阶段,对大家来说,现在还有很多机会。怎么抓住风口,找到契合自己的方向很重要,让自己在这次人工智能浪潮中获利。

小模型的的优势

阿里的AI文化是:用先进的策略优化技术,让Qwen1.5更贴合人类思维!

小模型往往专精一个方向的研究,贯彻“垂直专业”的思路,这样只需要极少的高质量数据,就能低成本、精细化地解决细分领域问题!

大的模型支持72B,在绝大多数的任务上都能表现的很强势,虽然相比起GPT49虽然有差距,但是还是可以控制的!

开源

我们可以通过PAI-QuickStart使用模型

体验地址:

https://modelscope.cn/studios/qwen/Qwen1.5-72B-Chat-Demo/summary

开发者可以在 PAI 控制台的“快速开始”入口,找到Qwen1.5系列模型,以Qwen1.5-7B-Chat为例,模型卡片如下图所示:

如何使用?

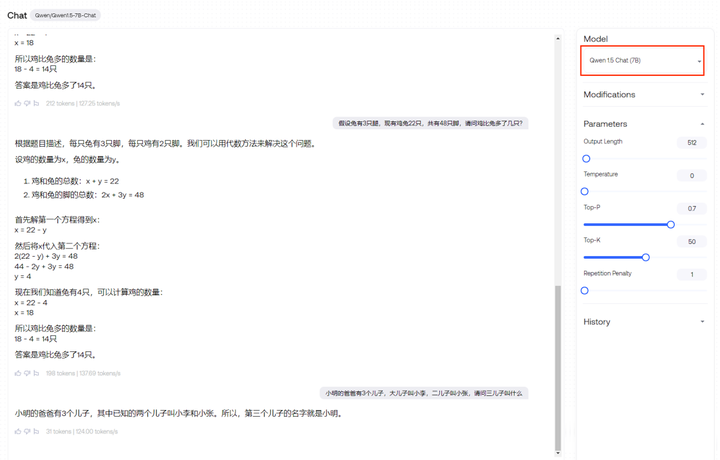

我尝试试通义千问的1.5提供的demo入口,这里给的是72B大小的模型,效果还挺不错的,关键是速度很快,代码小改下就能跑。

第一步:下载qwen1.5版本的模型

下载链接:

https://ollama.ai/library/qwen/tags

ollama run qwen:0.5b

一条命令,输入后回车搞定!

https://ollama.ai/library/qwen/tags

运行模型

可以在容器内运行类似 qwen1.5_0.5b 的模型。

docker exec -it ollama ollama run qwen:0.5b

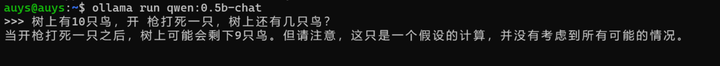

第三部分:启动推理!跑起来!

ollama run qwen:0.5b-chat

如果你下载完,会自动进入chat,退出后,也可以用它来启动!

个人的使用体验下来,14b系列模型用8bit qlora微调,qwen>qwen1.5>baichuan2,论是在语言理解、代码生成、推理能力,还是在多语言处理和人类偏好对齐等方面,Qwen1.5系列模型均表现出了强大的竞争力。

总之,这次Qwen1.5模型的闪亮登场,虽然在对齐上暂时没追上GPT-4-Turbo,但别小看它!在MT-Bench和Alpaca-Eval v2的测试中,Qwen1.5可是把Claude-2.1和GPT-3.5-Turbo-0613都甩在了身后!这就是开源的魔力,未来还有更多可能等待发掘。

回复 【idea激活】即可获得idea的激活方式

回复 【Java】获取java相关的视频教程和资料

回复 【SpringCloud】获取SpringCloud相关多的学习资料

回复 【python】获取全套0基础Python知识手册

回复 【2020】获取2020java相关面试题教程

回复 【加群】即可加入终端研发部相关的技术交流群

阅读更多

用 Spring 的 BeanUtils 前,建议你先了解这几个坑!

在华为鸿蒙 OS 上尝鲜,我的第一个“hello world”,起飞!

一款vue编写的功能强大的swagger-ui,有点秀(附开源地址)

相信自己,没有做不到的,只有想不到的

在这里获得的不仅仅是技术!

喜欢就给个“在看”