- 1【BERT-多标签文本分类实战】之三——多标签文本分类的方向与常用数据集介绍_文本分类学科数据集

- 2记一次 mysql curdate()函数/current_date()函数踩坑_mysql导入 curdate() 报错

- 3人工智能在农业领域的五个应用案例_人工智能在农业中的应用案例实训报告。

- 4IDEA import时不使用*_idea 引入包 不用*

- 5基于eNSP的ACL配置实验_ensp acl实验

- 6常见排序算法详解:插入,冒泡,希尔,选择,快速排序,归并,计数排序,堆排序(已完结)_100个数最快捷的排序方法

- 7搭建第一个区块链网络(Fisco-Bcos),启动并使用控制台

- 8大创项目推荐 深度学习YOLO安检管制物品识别与检测 - python opencv

- 9四元数法求解欧拉角_四元数转欧拉角

- 10STM32点灯大师(中断法)

华为计算开源总经理堵俊平:AI领域开源新趋势与思考_opendataology

赞

踩

2022年7月29日,在由开放原子开源基金会主办的“2022开放原子全球开源峰会”上,华为计算开源总经理、开放原子开源基金会TOC主席、LF AI & DATA基金会董事主席堵俊平分享了AI领域开源新趋势与思考。

AI领域产业发展趋势

AI构成的三要素是算力、算法和算据。

- 在算力方面。算力的水平和国民经济以及数字经济的水平发展完全匹配。世界经济发展最先进的国家,往往也是算力发展最先进的国家,这是正相关的关系。数据量和算力的关系是循环增强的,算力越强数据就越多,数据量增多也会促进算力需求拉升。从AI的角度来看,全球算力的增长点在AI。过去以及未来几年的发展,通用计算整体的算力增长大概10倍,但AI领域,AI计算会增长500倍。在整个计算领域里面,原来AI算力是一个小兄弟,未来它会成长为真正的巨人。

- 在算法方面。整个AI领域的算法进行了一次跳跃式的变革,从传统的机器学习到深度学习,从小模型走向大模型、超大模型、巨大模型。AI核心的价值在于应用,这些应用在不成熟的时候,是一个个小烟囱,在单领域、小场景需要用到小模型。但慢慢会发现需要用可以覆盖多个场景、能够突破限制、实现泛化能力的通用大模型,节省人类智力劳动的总成本。

- 在算据方面。数据大发展的时代已经开始了。包括IDC调研、Gartner都会做数据发展的调研。数据每年增长30%,同时在数据增长的过程中,非结构化数据占比越来越大。这意味着越来越多的数据成为AI算力生产的资料,能够产生更多有价值的东西。

这样的趋势反映在模型里面,从各种各样的模型慢慢会收敛成一些大模型,适应各种各样的场景。

AI开源发展新要求

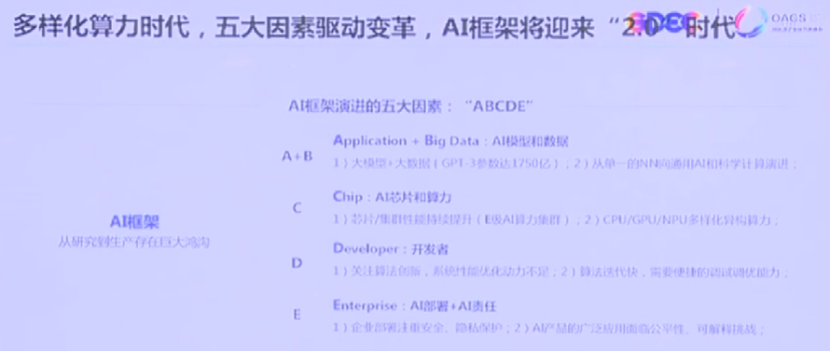

在算力、算法、算据都在飞速发展的时代,对于整体AI发展及开源发展的新要求参考AI框架演进五大因素,正好是A、B、C、D、E。

- 首先,“A”和“B”是AI模型和数据。所有的技术最后都是应用驱动或者价值驱动,技术背后的价值要通过应用落地产生。

- 其次,“C”作为生产力,AI的芯片和算力不断突破技术的制造工艺极限,这是重要的趋势。

- 再次,“D”代表开发者。好应用也离不开开发者的使用和喜好,所以AI框架一定要迎合或适配开发者实际工作的需求。

- 最后,“E”是对于AI部署、AI责任要满足企业的实际应用落地需求。从整体来说,AI框架既要满足研究界的需求,也要满足企业界的需求。因为研究界是AI整体科研进步及技术进步的重要推手;企业界是AI能够形成价值变现,持续投入资源最大的动力。

AI开源趋势与思考

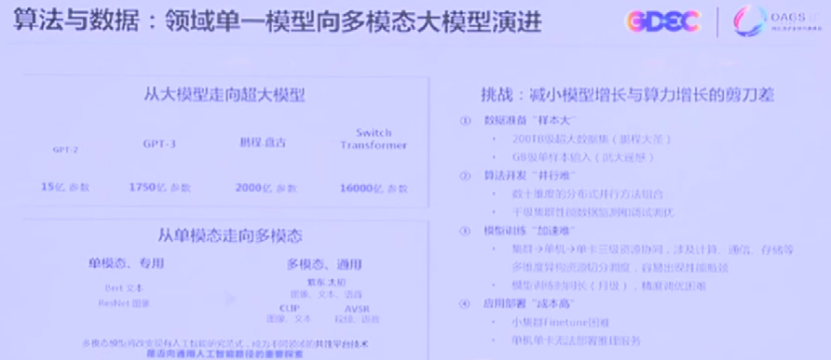

第一个趋势是对于算法和数据,数据层面的扩大使模型、算法也会从大模型走向超大模型,从单模态走向多模态。原来可能多场景都可以用一个大模型来搞定,但在当前趋势下有很多挑战:算法的并行开发难度越来越高,模型的训练加速越来越难,超大集群如何协同也很困难。

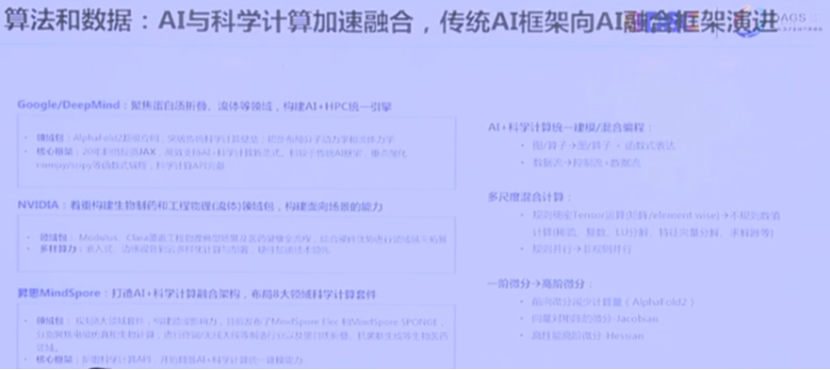

第二个趋势是AI和科学计算加速融合,AI的拟合计算代替了传统HPC,性能更高,代价更小,效果更好。很多通用计算的场景都慢慢通过AI计算的方式去展现。

Google、NVIDIA都在这个领域发力。同时华为昇思MindSpore,也在打造AI+科学计算融合的架构,在不同的领域加强了研发力量和投入,其核心是把这些面向场景与行业的价值真正带给行业和用户,降低开发者、行业、应用的门槛,这是核心的关键点。

当然,它背后还有很多相应的技术,从AI+科学计算统一建模,传统的数据流的驱动变成控制流+数据流,一阶微分到高阶微分的转化……这里面涉及到很多挑战,同时也能看到很多技术变革的机会。

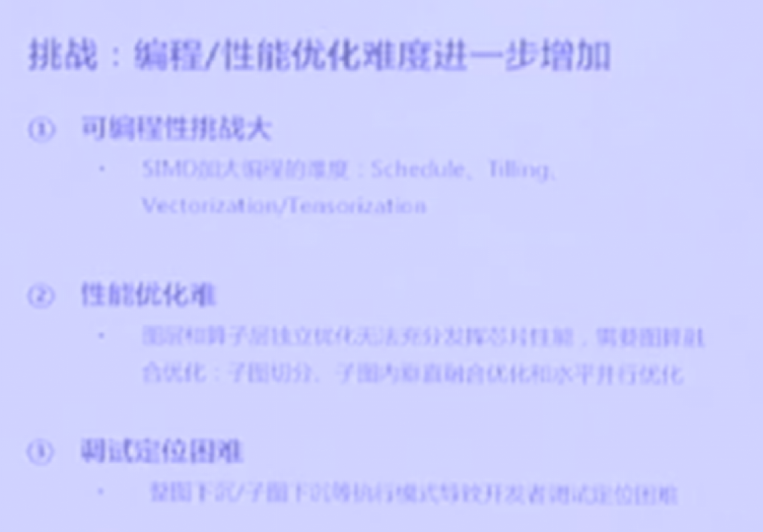

从AI和芯片的角度来说,DataFlow架构越来越主流,在这样芯片的架构趋势情况下,算力、带宽这些性能都很友好。但可编程能力难度进一步增加。在多机型的部署,从单卡走向单机,从单机走向集群,调优的方式方法不能像传统那样在单机上调优。

对于开发者,一定是得开发者得天下。Python成为AI领域首选的语言与它语言的特点分不开,非常容易上手使用,传统留存也积累了大量各种各样的算法、模型库等。但同时,Python的性能比较差,跨平台部署也比较困难。所以2017年Google推出的静态图,能够克服Python传统的劣势。但发展到一段时间之后,2018年Facebook推出PyTorch时,用了一些动态图,牺牲了一部分的性能,换取了灵活性,使开发工作的效能得到提升。

昇思实现动静态图的结合,既有静态图的性能优势,也有动态图开发者易编程的特点。从静态图出发,把不能识别的算子推到解释器延时执行;从动态图出发,提前缓存一些被编译优化的算法,边解释边执行。

从企业的角度来说,对于AI应用,一方面希望容易部署和管理,更重要的是整体的数据安全。数据准备阶段、模型训练阶段、模型部署应用阶段,都很关键,任何一个地方出现数据的泄露或者被篡改,最后的结果都要功亏一篑。为了阻止或者规避模型安全的问题,需要AI全流程安全的可信框架。

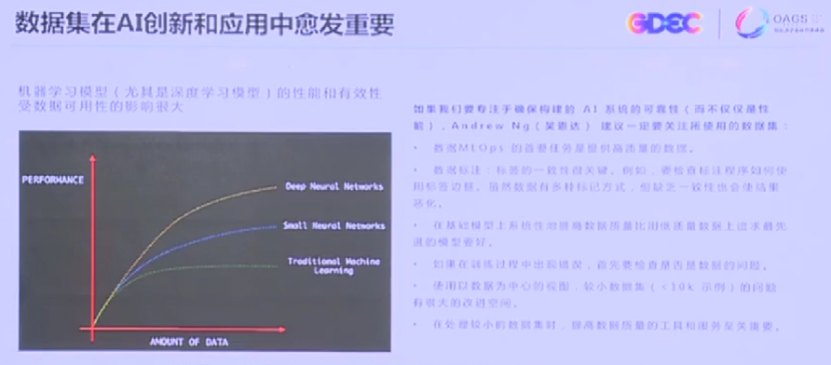

数据集在AI创新和应用中至关重要。早在机器学习发展初期,吴恩达便提出一定要关心数据集,不要认为拼命把算力或是算法提升就能够解决。尤其对于深度学习算法,数据越多,训练的模型精度、准确率越高。

对数据集而言,框架模型构建了整体开源AI全景图,底层的AI部署,包括AI框架、模型的创建训练、后面的推理以及数据的清洗、ETL等,都是在数据层面。每一层都有大量的开源项目大行其道,而且发展得越来越好。

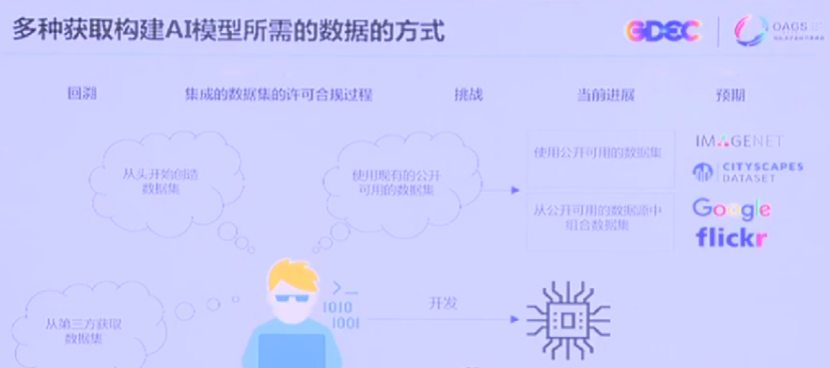

对于企业来说,数据集有三种来源:

- 从头开始收集、创造数据集;

- 通过第三方进行合法的交易,获取数据集;

- 把大量现有的公开可用数据集收集起来。

其中在使用公开可用数据集方面,还有很多合规的风险,比如对于商用不是太友好。如果作为科研去用没有问题,但放到商业市场,把它变成模型去推广,就会有各种各样的障碍,比如不允许训练模型的分发,最后模型作为产品的分发都有相应的限制。

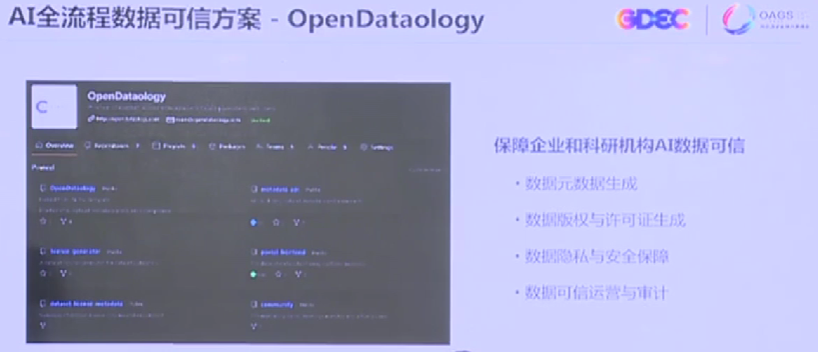

因此,对于AI领域数据集的合规,是业界越来越重要的命题。当前LF AI & DATA基金会OpenDataology方案,能够保证企业和科研机构的AI数据是可信的,包括涉及元数据的生成、数据版权许可证的生成、数据和隐私安全的保障、可信的运营和审计等。有了OpenDataology这个项目,可以不用担心数据集产生各种各样的问题,它会比人工审核更加有效率、更加稳妥。

我们现在看到AI从服务器从云侧开始发扬光大,但在端侧,尤其是在智能车崛起的时代,对未来AI的框架包括AI产品,一定会产生大量的“端边云”协同的需求。所以要求在模型上要自适应的生成,在模型从云到边到端的时候,能够有自动剪裁或者模型轻量化、小型化的处理。同时,除了端侧的推理之外,还要有一些轻量的学习和训练能力。可以私人定制的模型和更细微的超轻量级的框架,同时也在不断开发出来。

整个开源的趋势,多样化算力快速地指数级发展,数据领域到了数据发达时代。随着这些基础模型、大模型、预训练模型大行其道,AI领域模型的开源会是重要的趋势。因为模型有大量的价值有待发掘,可以被共享出来。

整个AI开源的趋势和AI框架的互操作性以及芯片生态的兼容性都在不断增强,AI的北向应用包括行业场景整合也在不断增强。同时,要降低AI开发者以及算法工程师的门槛,最后实现人人皆是AI工程师、面向未来的智能时代。

最后,数据集的开放是长期的趋势,越来越多的业界可用的数据集开源开放出来。就像开源一样,对商业更加友好的数据集以合规的形式慢慢开放出来。同时,类似于OpenDataology保障数据集安全合规自动化工具,也会是重要的趋势。