- 1GitHub爆赞,Java从基础到中高级核心知识全面解析,太强了_java学习 github

- 2weblogic反序列化之T3协议

- 3黑客和安全专业人员最重要的网络渗透测试工具_docker openvas

- 4axios配置多个请求地址(打包后可通过配置文件修改)_axios怎么更改请求地址端口

- 5vim使用教程图文教程(零基础超详细)_vim教程

- 6用xLang写Timer事件

- 7java vector迭代器_C++ STL vector容器迭代器用法详解

- 8朗致集团面试-Java架构师_朗致集团线上逻辑测试内容2024

- 9墨者学院——WSGI 漏洞复现(CVE-2018-7490)_mod_wsgi漏洞

- 10万能的微信小程序个人主页:商城系统个人主页、外卖系统个人主页、购票系统个人主页等等【全部源代码分享+页面效果展示+直接复制粘贴编译即可】_微信小程序个人中心开源代码

本地运行多种大语言模型:一行代码即可完成 | 开源日报 No.167

赞

踩

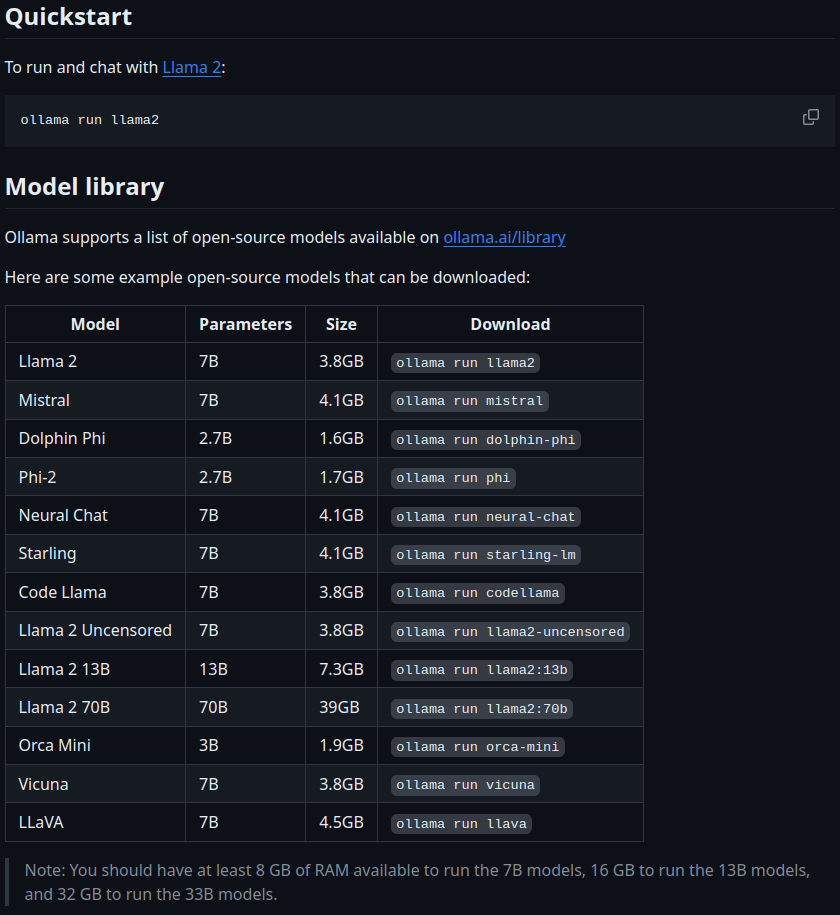

ollama/ollama

Stars: 33.5k License: MIT

ollama 是一个轻量级、可扩展的本地语言模型构建和运行框架。

- 提供简单的 API 用于创建、运行和管理模型

- 包含丰富的预构建模型库,方便在各种应用中使用

- 支持从 GGUF、PyTorch 或 Safetensors 导入自定义模型

- 可以通过命令行进行多种操作,如创建、拉取、删除和复制模型等

dair-ai/ML-YouTube-Courses

Stars: 12.6k License: CC0-1.0

ML-YouTube-Courses 是一个收集整理 YouTube 上最新的机器学习/AI 课程的项目。

该项目主要功能、关键特性、核心优势包括:

- 收集整理了一系列最新和优质的机器学习课程

- 涵盖了各种领域,如机器学习、深度学习、自然语言处理等

- 提供了丰富多样的教育资源,方便用户快速获取相关知识

ardanlabs/service

Stars: 3.2k License: Apache-2.0

service 是使用 Kubernetes 在 Go 中编写服务的起始工具包。

该项目旨在提供一个经过验证的起点,以减少将新项目投入生产所需的重复任务。它使用最小依赖关系,实现成熟代码,并遵循 Go 的最佳实践。该项目为工程师们逻辑地布置了一切,以尽量减少猜测,并使他们能够快速建立对项目的心智模型。

- 提供用于构建生产级可扩展网络服务应用程序的起始点

- 利用领域驱动、数据导向架构

- 可在 Kubernetes 上运行

- 使用最小依赖关系和符合惯例代码

- 遵循 Go 最佳实践

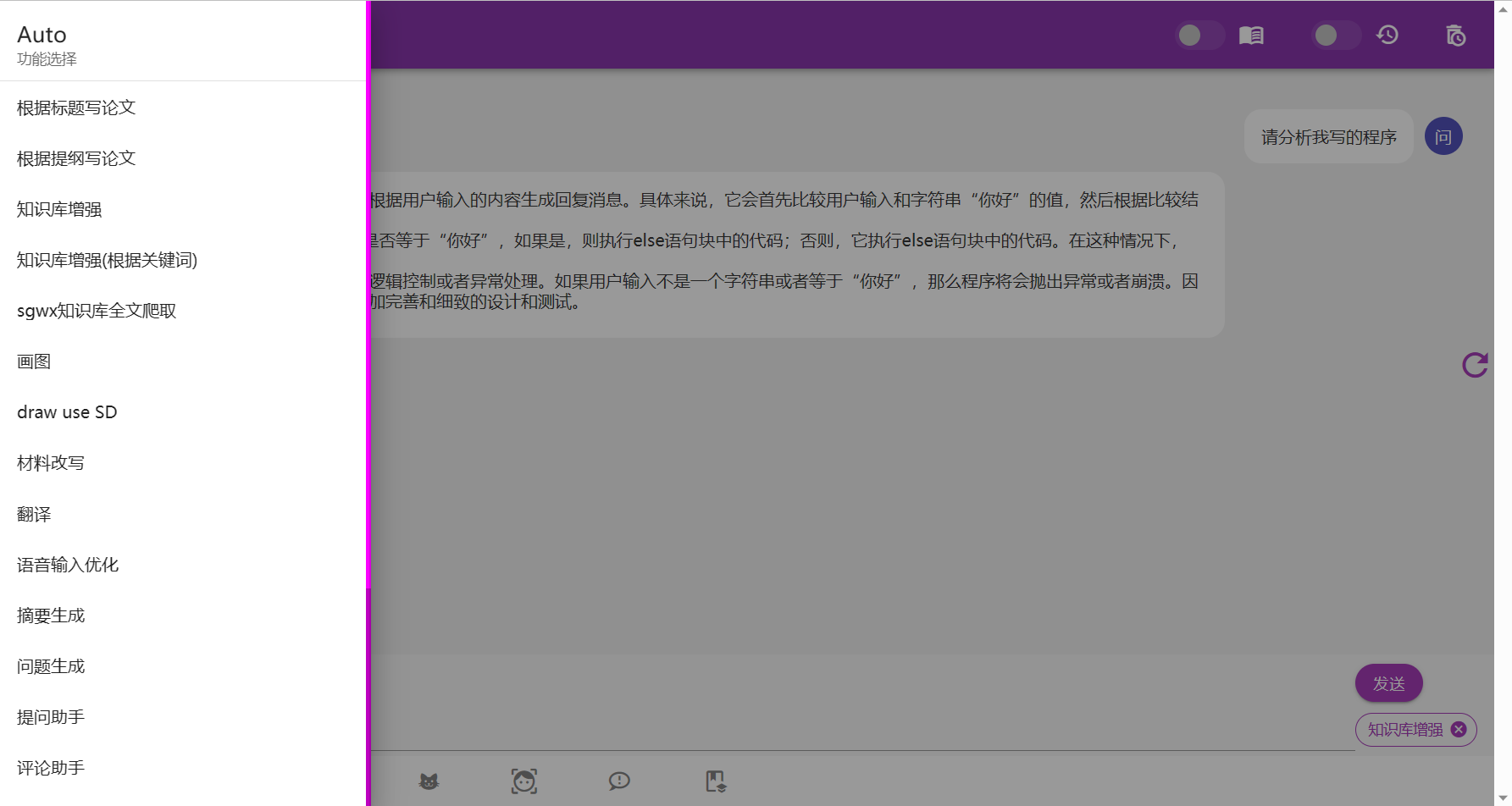

wenda-LLM/wenda

Stars: 5.9k License: AGPL-3.0

wenda 是一个 LLM 调用平台。

该项目旨在实现针对特定环境的高效内容生成,同时考虑个人和中小企业的计算资源局限性,以及知识安全和私密性问题。

其主要功能、关键特性、核心优势包括:

- 支持多种大语言模型

- 自动脚本功能

- 知识库支持

- 多用户并行使用等

hiyouga/ChatGLM-Efficient-Tuning

Stars: 3.4k License: Apache-2.0

ChatGLM Efficient Tuning 是一个基于 PEFT 的高效 ChatGLM 微调项目。该项目的主要功能是对 ChatGLM-6B 模型进行微调,使用了 PEFT (Prefix Encoding for Fine-Tuning) 方法。

以下是该开源项目的关键特性和核心优势:

- 支持 LoRA、P-Tuning V2、Freeze 和 Full Tuning 等多种细粒度微调方法。

- 提供丰富的数据集选择,包括 Stanford Alpaca、GPT-4 Generated Data 等等。

- 可以在单个 GPU 或分布式环境下进行训练,并支持强化学习与人类反馈 (RLHF) 训练方式。

- 具备评估模型质量和生成预测结果等功能。

通过这些特性和优势,ChatGLM Efficient Tuning 为用户提供了一套完整而灵活的工具来实现对 ChatGLM 模型进行高效微调。无论您是想尝试不同类型的微调方法还是需要根据自定义数据集完成任务,在这个开源项目中都能找到合适的解决方案。