热门标签

热门文章

- 1专访CMU邢波教授:机器学习与医疗大数据,及大规模机器学习系统的开发_cmu刑波

- 2MSBDN(Multi-Scale Boosted Dehazing Network with Dense Feature Fusion)具有密集特征融合的多尺度增强去雾网络阅读分析

- 3Java实现Tron(波场)区块链的开发实践(二)交易监控与转账_java 监听tron 转账

- 4利用Cloudfare worker反代github_cloudflare workers 反向代理

- 5表单设计器1 - 开源表单设计器选型_jeecg 表单设计器

- 6机器学习——特征预处理_机器学习特征预处理

- 7中断服务函数的过程_20160206_中断函数的执行过程

- 8CrossOver怎么安装软件 Mac电脑运行Windows程序_crossover24.1怎么安装delphi12

- 9(微图)移动gis软件开发工具---mattermap_mattermap是哪个公司的产品

- 10ELK+Filebeat+Kafka日志采集_filebeat kafka

当前位置: article > 正文

AI 的测试:模型评估的常用指标_ai效果指标效果一致性测试

作者:笔触狂放9 | 2024-05-06 09:18:41

赞

踩

ai效果指标效果一致性测试

模型评估的指标

模型是在大量的数据集上训练而来的,无论一个模型是从零训练的还是基于某一个模型,通过微调方法得到的,靠人工评价模型的效果都是异常困难的。那么要想客观的、自动化的评价一个LLM模型,就需要能够选择正确评估模型效果的指标或者基准测试,来客观和自动化的完成评价,从而正确的反馈模型的效果。

在测试AI系统中的模型训练和评估阶段,需要使用准备好的数据集对AI模型进行训练和评估。在训练过程中,应该对模型进行监控和调整,以确保模型的准确性和效果。在评估过程中,需要使用测试数据集对模型进行测试,以验证模型的准确性和效果。在评估过程中,需要使用各种度量方法来评估模型的准确性和效果,例如精度、召回率、F1分数等等。

精度是指模型正确预测的样本数占总样本数的比例,即:

其中,Precision是指精度,True Positive指分类器正确判断为正例的样本数,False Positive指分类器错误判断为正例的样本数。精度越高,说明模型的分类效果越好。

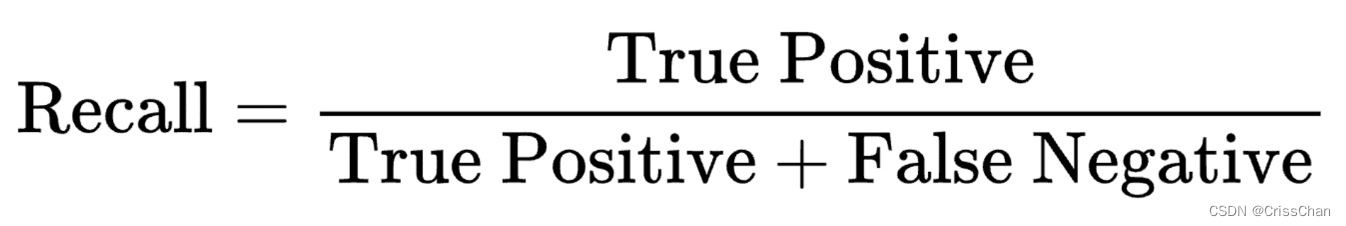

召回率是指模型正确预测的正样本数占所有正样本数的比例,即:

其中,Recall是指召回率,False Negative指分类器错误判断为负例的样本数。召回率越高,说明模型对正样本的覆盖率越高。

F1分数是精度和召回率的调和平均值&

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/笔触狂放9/article/detail/543541

推荐阅读

相关标签