- 12020 年前端技术发展盘点_前端前沿思潮和技术

- 2leetcode:1. 两数之和

- 3蓝桥杯总结及经验教训_蓝桥杯心得体会

- 4Three.js——tween动画、光线投射拾取、加载.obj/.mtl外部文件、使用相机控制器_three.js 加载obj文件并计算投影

- 5六款Linux常用远程连接工具介绍,看看哪一款最适合你_linux远程工具_linux连接工具

- 6华为OD机试算法D卷:二叉树的广度优先遍历_二叉树的广度优先遍历 - 华为od统一考试(d卷)

- 7毕业设计:基于机器学习的课堂学生表情识别系统 人工智能 python 目标检测_智能在线学习系统,上课表情识别毕设

- 8打造个人技术博客:程序员的全面设计手册_程序员搭建自己的博客需要具备哪些技术

- 9《Scikit-Learn与TensorFlow机器学习实用指南》 第02章 一个完整的机器学习项目(上)...

- 10android CancellationException 了解

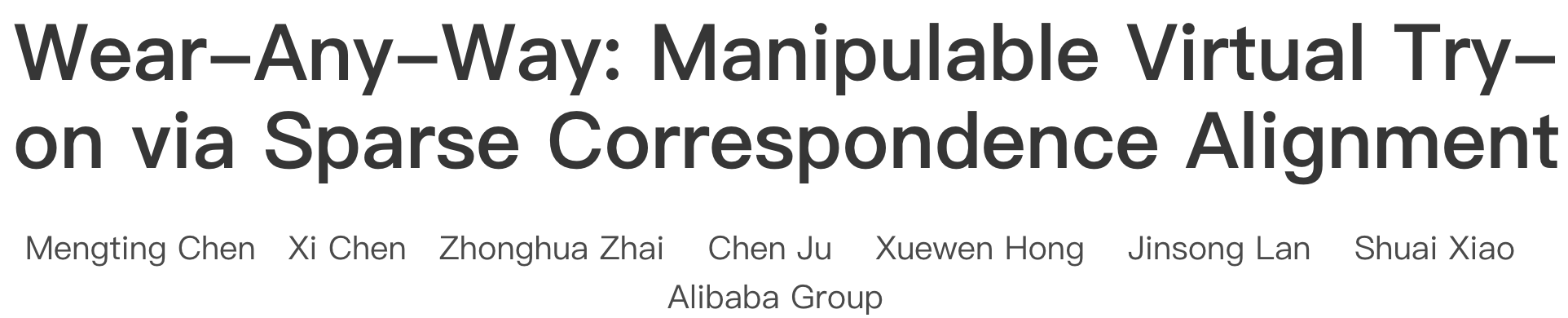

阿里推出Wear-Any-Way:可控虚拟试衣最新方案,支持一键自由定制试穿,穿着方式由你定!_阿里巴巴ai虚拟试衣

赞

踩

之前已经向大家介绍了很多关于虚拟试穿的项目,如谷歌的Tryon Diffusion, 阿里的Outfit Anyone, 亚马的Diffuse to Choose、东京大学的OOTDiffusion虚拟服装试穿工具以及oms-Diffusion。基于扩散模型的技术基本已经成为现在主流应用的基石。感兴趣的小伙伴可以点点击下面链接阅读~

电商模特危机!谷歌最新模型Tryon Diffusion一键试衣,线上购物被革命

AI一键换衣,阿里Outfit Anyone来了,电商人的福音!

亚马逊虚拟试衣终于来了,Diffuse to Choose:为网购客户提供身临其境的虚拟试穿服务

OOTDiffusion:一个可控的虚拟服装试穿工具,已开源,效果接近商用!

oms-Diffusion:用户可上传服装图片与参考姿势图进行试穿,解决服装行业高昂成本问题

今天向大家介绍阿里最新推出的虚拟试衣方法Wear-Any-Way,Wear-Any-Way 是一种可定制的解决方案。除了生成高保真结果外,还支持用户精确操纵试穿风格。不仅可以试穿衣服,还可以根据需要改变衣服的样式(比如卷起袖子,打开/拖动外套等)。

论文阅读

相关链接

项目地址:https://mengtingchen.github.io/wear-any-way-page/

论文地址:https://arxiv.org/abs/2403.12965

机构单位:阿里巴巴 拍立淘团队

摘要

本文介绍了一种新颖的虚拟试穿框架,称为“Wear-Any-Way”。与以往的方法不同,Wear-Any-Way 是一种可定制的解决方案。除了生成高保真结果外,我们的方法还支持用户精确操纵试穿风格。为了实现这一目标,我们首先构建了强大的标准虚拟试穿管道,支持复杂场景下的单件/多件试穿以及模特到模特的设置。为了使其可操作,我们提出稀疏对应对齐,其中涉及基于点的控制来指导特定位置的生成。通过这种设计,Wear-Any-Way在标准设置下获得了最先进的性能,并为定制佩戴风格提供了新颖的交互形式。比如支持用户拖动袖子卷起、拖动外套打开、通过点击控制褶子的款式等。Wear- Any -Way让着装表达更加自由灵活,对时尚界有着深远的影响。

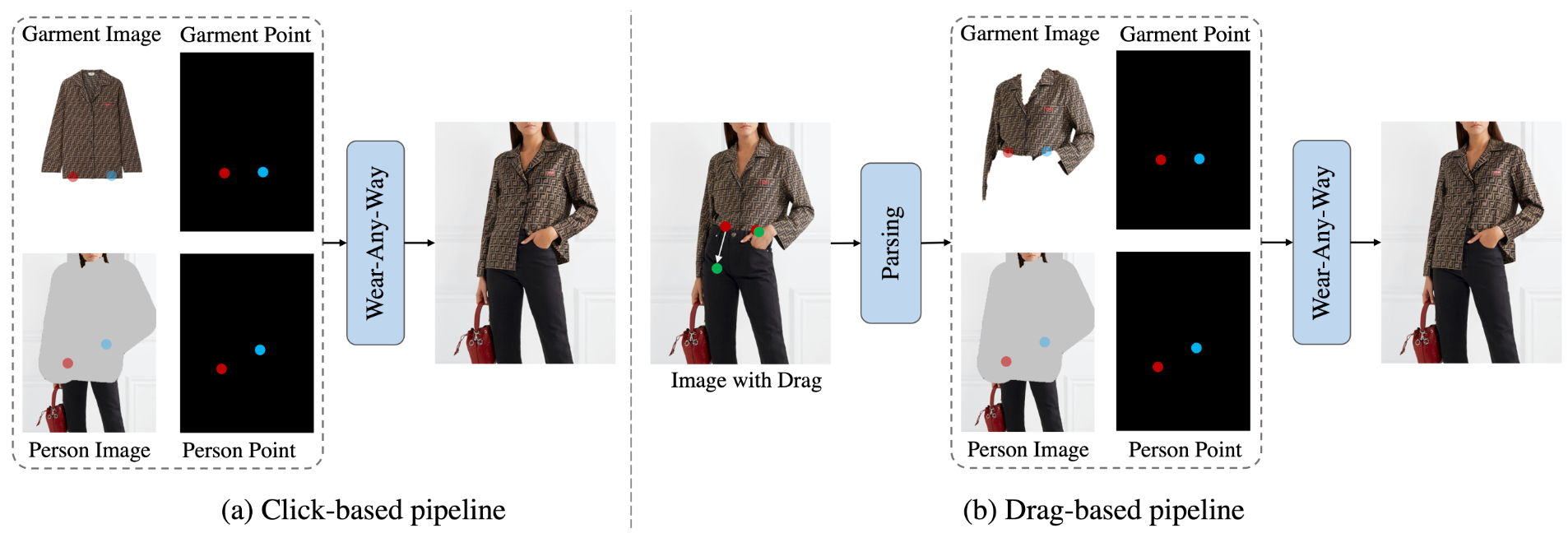

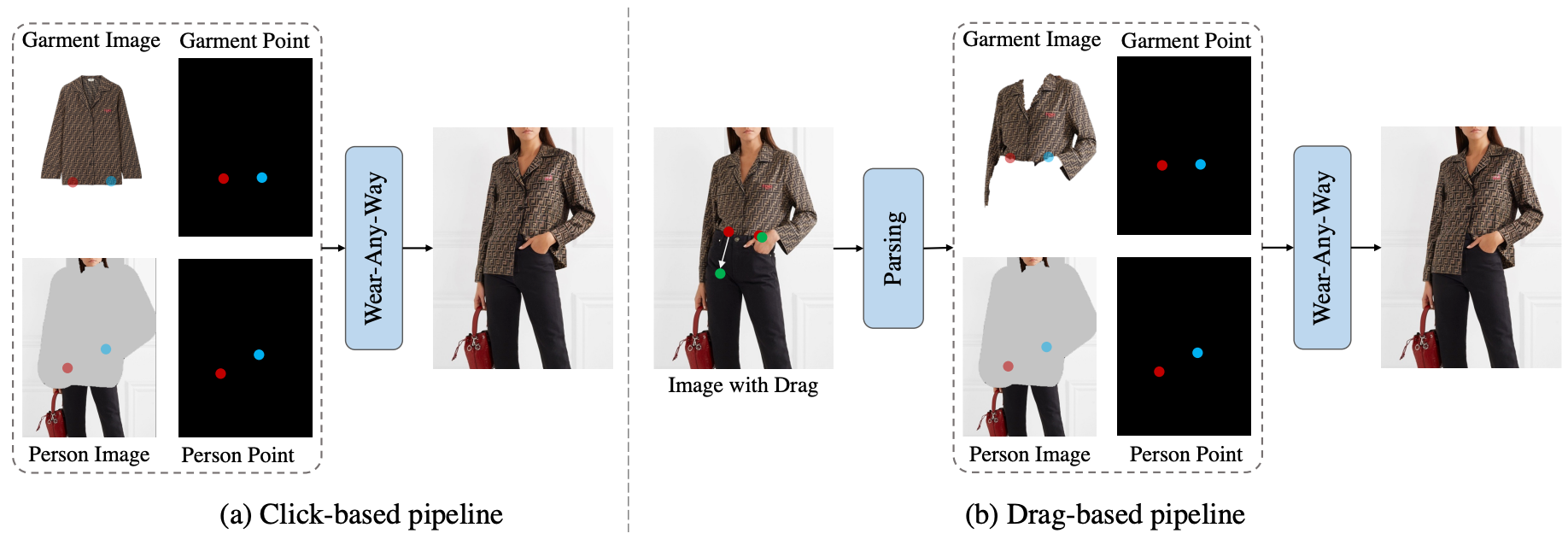

通过点击进行操作

Wear-Any-Way 支持用户在服装和人物图像上分配任意数量的控制点来定制生成,为现实世界的应用带来多样化的潜力。

拖动操作

对于基于点击的控制,用户提供服装图像、人物图像和点对来定制生成。当用户拖动图像时,起点和终点将被转换为服装点和人物点。而解析出的衣服则被视为服装图像。因此,拖动可以转换为基于点击的设置。

通过自动方法进行操作

可以通过结合骨架图和密集姿势来计算控制点。因此可以通过设置不同的超参数来控制穿着风格。

单件试穿

Wear-Any-Way 支持各种输入类型,包括商店到模特、模特到模特、商店到街道、模特到街道、街道到街道等。

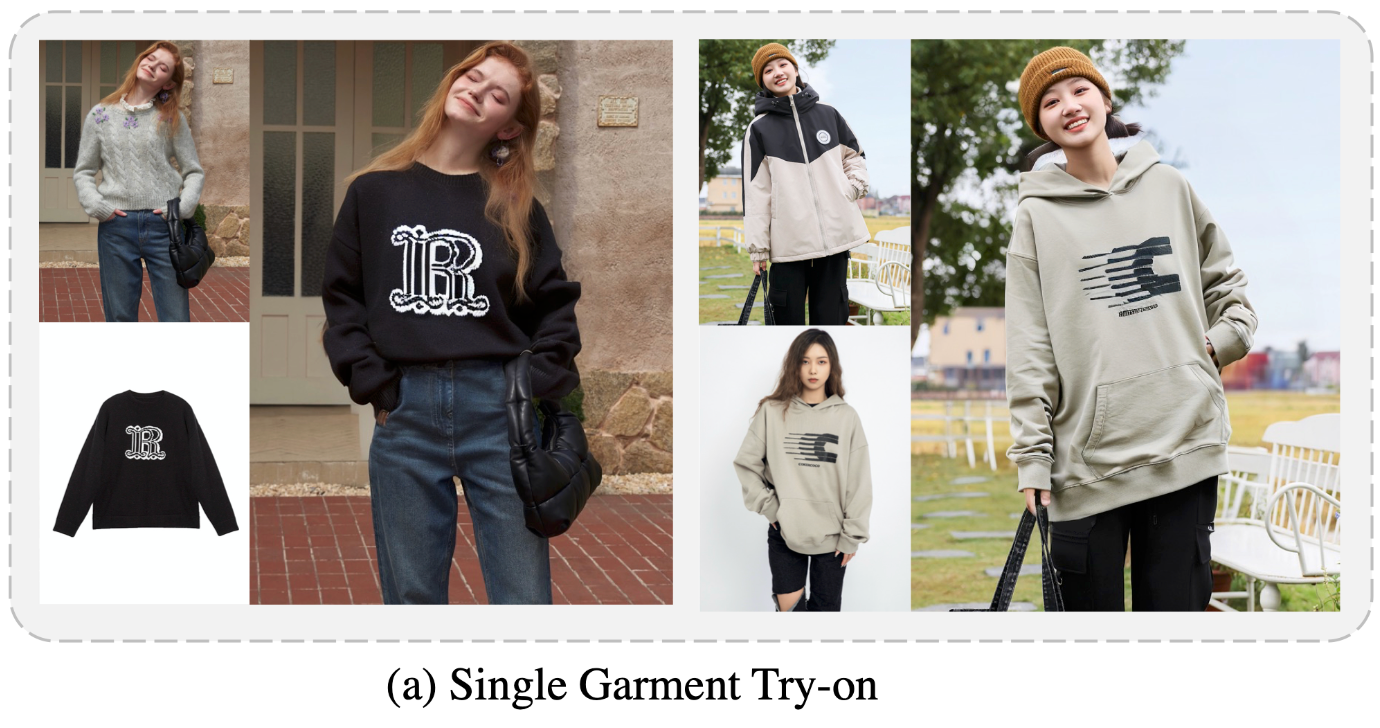

多种服装试穿

Wear-Any-Way 使用户能够同时提供上衣和下衣,并一次性生成试穿结果。

方法

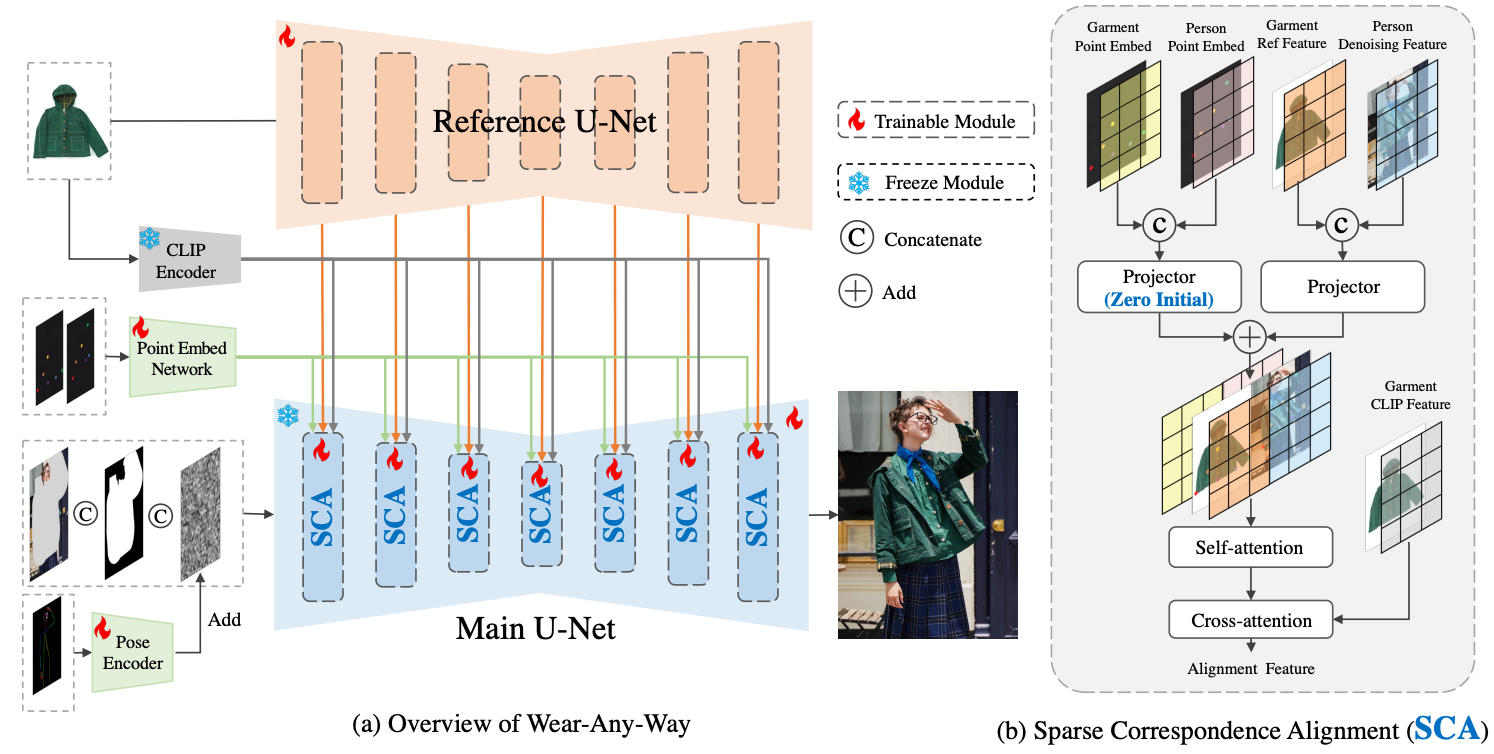

Wear-Any-Way的pipeline

整个框架由两个U-Nets组成。

-

Rreference U-Net以服装图像为输入提取细粒度特性。

-

Main U-Net负责生成试穿结果。它需要人物图像(蒙面),服装蒙面,和潜在噪声作为输入。由姿态控制通过一个额外的姿态编码器。

基于点的控制由一个点嵌入网络和稀疏对应对齐模块。详细的结构在右侧显示。火焰和雪花的符号表示可训练参数和冻结参数。

收集训练点对的流程

如左边所示,将人和服装图像送入相同的稳定扩散中提取特性。计算两个特征映射之间的余弦相似度来得到点对。一些密集采样的点对显示在右边。

Wear-Any-Way的推理流程

对于基于点击的控件,用户提供服装形象、人物形象、点对等定制生成。当用户拖动图像时,起始点和结束点被转换为衣与人分。而解析后的衣服则被视为服装的形象。因此,可以将拖动转换为基于单击的设置。

总结

这项工作提出了一种新的可操作虚拟试穿框架-Wear-Any-Way。除了在经典的虚拟试穿任务上达到最先进的性能,还可以使用户可以自定义穿着的风格。

模型基于双U-Net设计。引入了一个稀疏对应对齐模块使得模型可定制。Wear-Any-Way作为电子商务的实用工具,提供了新颖的功能对未来虚拟试戴研究的启示。

感谢你看到这里,也欢迎点击关注下方公众号,一个有趣有AI的AIGC公众号:关注AI、深度学习、计算机视觉、AIGC、Stable Diffusion、Sora等相关技术,欢迎一起交流学习

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。