- 1spark[2]: 关于partition的相关操作(帮助理解RDD)_spark partition by

- 2SQL查询语句(全网最详细教学)

- 3Mac运行已安装软件提示“XXX 已损坏,打不开。移到废纸篓/推出磁盘映像。”解决方法_已损坏,无法打开。 你应该推出磁盘映像。

- 4开源AlphaFold3来啦!快来亲自尝试预测蛋白质结构!_alphafold3怎么用

- 5iVX低代码平台系列详解 -- 系统架构_低代码平台技术架构_低代码平台前后端传输对象结构

- 6【无人机】基于PID控制的无人机巡航仿真(Matlab代码实现)_matlab pid无人机仿真

- 7git常用命令(github中的token)(.gitignore)_git token

- 8请使用python生成一段LDA主题模型代码

- 9SOLIDWORKS PDM—数据库的备份_pdm 必须让文件库数据库脱机,然后才能在 solservermanagement studio 中

- 10【Sql Server】随机查询一条表记录,并重重温回顾下自定义函数的封装和使用_sql server 创建函数

AI写真教程:Stable Diffusion 之 IPAdapter-FaceId_stable diffusion ip-adapter-faceid

赞

踩

自Stable Diffusion发布以来,AI写真一直是AIGC界的热门话题。

AI写真为摄影师和艺术家提供了全新的创作工具。通过AI技术,艺术家可以轻松实现复杂的图像效果,如风格迁移、图像合成等,AI写真能够在短时间内完成传统摄影师和设计师需要耗费大量时间和精力才能实现的效果。

从这篇文章开始,我将陆续介绍使用Stable Diffusion进行AI写真的方式方法,用到的工具包括 Stable Diffusion WebUI 和 ComfyUI,感兴趣的同学请及时关注,以免错过重要信息。

本文介绍使用 IP-Adapter-FaceId 进行AI写真创作的方法。这种方法使用来自面部识别模型的面孔ID嵌入,而不是CLIP图像嵌入;另外,这种方法还使用LoRA来提高ID一致性。IP-Adapter-FaceID仅凭文本提示就可以根据一张面孔生成各种风格的图像。

效果演示

像不像先不说,我们先来看看好不好看(大家猜猜她是谁?):

实现原理

AI写真是利用人工智能技术生成或增强的照片。这种技术结合了计算机视觉、深度学习和图像处理等先进的算法,使得机器能够自动生成、修复、增强或编辑照片。

具体来说,目前AI写真的实现方式大概有如下几种:

- 使用ControlNet:ControlNet为Stable Diffusion提供了一些精细控制能力,它可以从参考图片中提取一些特征信息,比如人脸、姿势、色彩、线稿等等,然后在生成的图片中应用这些信息,从而在AI写真中达到精细的人物形象控制效果。

- 结合换脸技术:先使用SD、Midjourney等AI绘画工具生成若干符合场景或风格要求的人物图片,然后再使用AI换脸技术更换图片中的人物面部形象,从而实现AI写真的目的。

- 训练LoRA模型:LoRA本身一种模型微调技术,可以让模型在某方面的生成能力得到大幅增强。对于AI写真,我们先准备若干张目标人物或者风格的图片,然后使用工具训练出特定人物的LoRA模型,最后使用这个LoRA模型即可生成目标人物在各种场景、各种风格下的逼真图像。

为了更好的艺术效果,我们还可以使用专用的摄影模型、风格模型,搭配精细的提示词,实现特定的艺术效果。

使用 IP-Adapter-FaceId

这里以 Stable Diffusion WebUI 为例,ComfyUI 的使用示例见下文。

因为 IP-Adapter-FaceId 在 SDXL算法中的效果不太好,所以本文将使用 SD 1.5 模型进行演示。

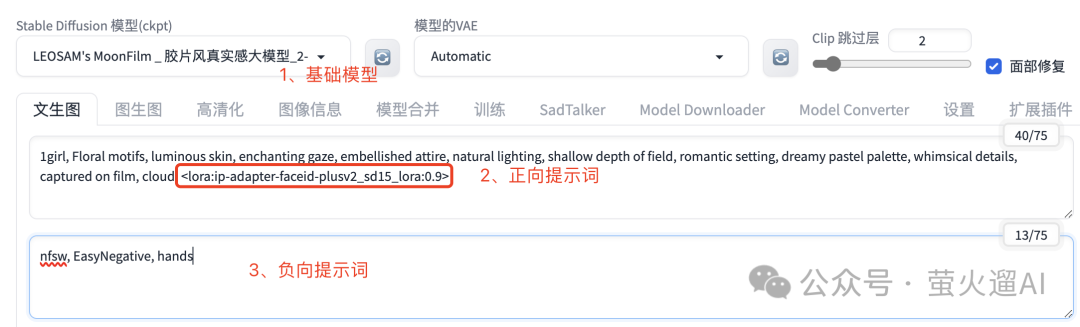

打开“文生图”页面,首先我们需要选择SD基础模型、设置提示词和负向提示。模型下载方式见文末资源下载。

这几个参数我介绍下注意事项:

- SD基础模型:建议选择真实风格、摄影风格的模型,以更加贴近现实;

- 正向提示词:你想要的画面内容,我们可以使用 IP-Adapter-FaceId 的LoRA模型 ,加强图像生成对人物面部特征的识别。

- 反向提示词:不想要的画面内容,因为AI绘画中的人手经常画不好,所以我在这里写一个 hands,让生成的图片中尽量不要出现人手。

然后我们需要设置一些采样参数,采样器大家选择自己常用的即可,这里我使用的是 DPM++ 2M,调度器选择的是 Karras,采样步数 27,这个搭配比较适合细节优化。

其它参数也介绍下:

- 图片的宽度和高度根据自己的需要设置,不要设置的太大,图片越大,生成的越慢。如果特别需要大图,可以在生成完毕之后,再到高清化中进行放大。

- 生成次数:使用当前的参数生成几次。

- 每次数量:每次生成时,同时生成几张图片。显存小不要修改,显存大的同学可以设置的大点。

上边已经把 Stable Diffusion 的基础参数设置完了,下边开始设置 IP-Adapter-FaceId 的参数。在 Stable Diffusion WebUI 中,IP-Adapter-FaceId 基于 ControlNet 提供面部特征提取和生成控制。

在“文生图”页面下方,启用一个 ControlNet单元,上传一张参考图片(现在你应该知道效果图中是谁了),如下图所示:

建议每次都勾选“完美匹配像素”,这样可以让ControlNet提取的图片特征更符合生成参数中设置的图片宽度和高度。

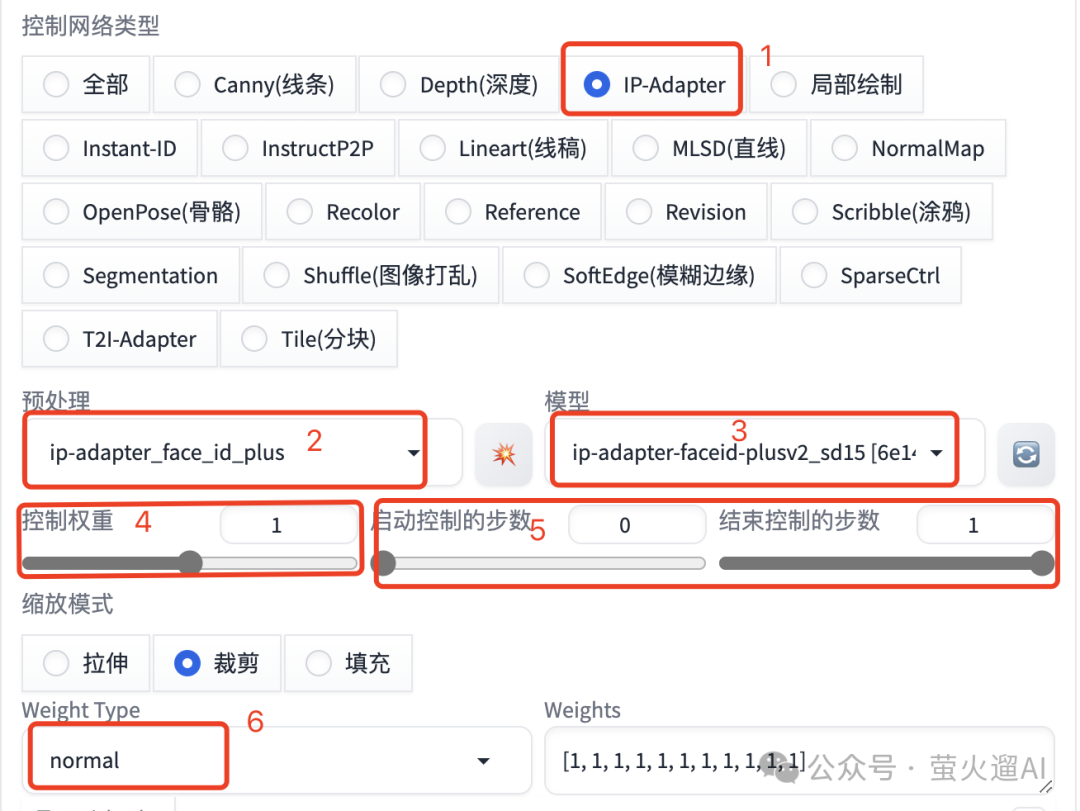

接着我们设置 IP-Adapter 的更多参数,如下图所示:

- 控制网络类型:勾选“IP-Adapter”

- 预处理器:选择“ip-adapter_face_id_plus”,如果没有这个预处理器,请更新ControlNet插件到最新版本。预处理器模型需要下载,下载方式见文末。

- 模型:选择“ip-adapter-faceid-plusv2_sd15”,模型需要下载,下载方式见文末。

- 控制权重:ControlNet对生成图片的影响力,值越大生成图片越遵从ControlNet的控制,用于精细控制,一般默认即可。

- 控制步数:在生成图片的第几步介入和退出ControlNet控制,用于精细控制,一般默认即可。

- Weight Type:高级权重参数,可以控制图片的风格和构图迁移效果,比如只迁移构图,或者只迁移风格。因为我们主要参考面部特征,所以这里使用默认的 normal 即可。

最后,我们只要点击“生成”,静待写真图生成就好了。

使用 ComfyUI 工作流

在 ComfyUI 中使用 IP-Adapter-FaceId 时,需要安装一些插件,主要就是这个:https://github.com/cubiq/ComfyUI_IPAdapter_plus,不方便访问外网的同学可以到文末下载我整理的资源。

文章编写不易,AI写真的 ComfyUI 工作流目前仅发布在我的AI绘画小册,有兴趣的同学可以点击链接或下方扫码进入:

后续优质内容、错误修正、操作或工作流优化,也会优先发布在这个小册,快人一步,及早加入。

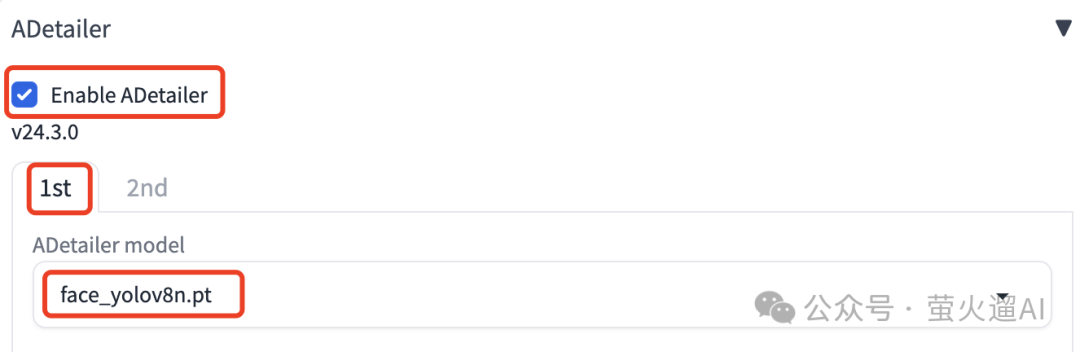

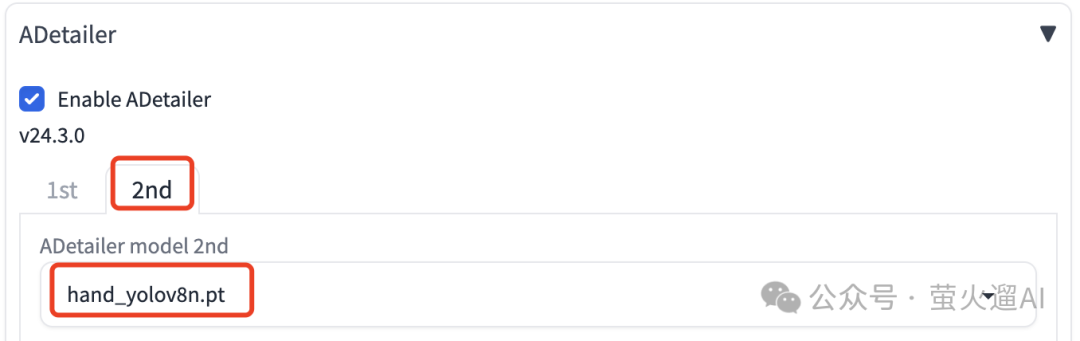

修脸修手

AI绘画生成人物图片有个常见的问题,那就是经常处理不好手部信息,有时候面部也会轻微变形。这里给大家推荐一个插件:ADetailer,可以对面部和手部进行一定的修复,虽然结果也不能做到完美,但是还是有一定的效果。

插件地址:https://github.com/Bing-su/adetailer,可以在 Stable Diffusion WebUI 的插件管理中直接安装,也可以下载后放到插件目录手动安装。不方便访问Github的同学可以到文末下载。

安装后可以在“文生图”和“图生图”页面找到 ADetailer,点击右侧按钮展开设置,我们可以同时设置两个模型,一个用来修脸,一个用来修手,如下图所示:

资源下载

AI写真用到的大模型、LoRA模型、修脸修手模型、ControlNet插件和模型,以及生成的图片(可提取提示词等生成参数),我都已经整理到了网盘中。

关于AI绘画技术储备

学好 AI绘画 不论是就业还是做副业赚钱都不错,但要学会 AI绘画 还是要有一个学习规划。最后大家分享一份全套的 AI绘画 学习资料,给那些想学习 AI绘画 的小伙伴们一点帮助!

感兴趣的小伙伴,赠送全套AIGC学习资料和安装工具,包含AI绘画、AI人工智能等前沿科技教程,模型插件,具体看下方。

一、AIGC所有方向的学习路线

AIGC所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照下面的知识点去找对应的学习资源,保证自己学得较为全面。

二、AIGC必备工具

工具都帮大家整理好了,安装就可直接上手!

三、最新AIGC学习笔记

当我学到一定基础,有自己的理解能力的时候,会去阅读一些前辈整理的书籍或者手写的笔记资料,这些笔记详细记载了他们对一些技术点的理解,这些理解是比较独到,可以学到不一样的思路。

四、AIGC视频教程合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

五、实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

这份完整版的学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】