- 1【面经】顺丰科技HR面(软件开发)_顺丰科技hr面试刷人吗

- 2前端面试准备(一)_前端面试需要做什么准备

- 3各种机器学习算法的应用场景分别是什么(比如朴素贝叶斯、决策树、K 近邻、SVM、逻辑回归最大熵模型)?...

- 4Vue.js框架+Axios发送异步请求+elementui前端布局框架

- 5Android开发如何学习,鸿洋推荐,必属精品!(1)

- 6Spark on YARN部署模式保姆级教程_yarn模式进行spark的部署原理图

- 7AWS云服务器的竞争优势

- 8导出域控的ntds.dit文件_域控数据文件

- 9Python(应用)网页爬虫之BS4(Beautiful Soup)用法及案例_bs4案例

- 10大神们分享STM32的学习方法_stm32完全学习教程

AI算力“卖水人”系列专题:2024年互联网AI资本开支持续提升

赞

踩

今天分享的是AI算力系列深度研究报告:《AI算力“卖水人”系列专题:2024年互联网AI资本开支持续提升》。

(报告出品方:国海证券)

报告共计:17页

来源:人工智能学派

互联网资本开支投向软硬件、云计算等,算力是主要组成

互联网资本开支(Internet Capital Expenditure)指互联网企业在互联网和信 息技术基础设施上的支出,包括公司投资于硬件、软件、网络设备、数据中心、 云计算服务等方面的支出,旨在建设、维护和升级与互联网相关的基础设施、提高服务质量与效率。互联网资本开支是企业为了支持其在线业务、网络服务和数字化转型而进行的重要投资。

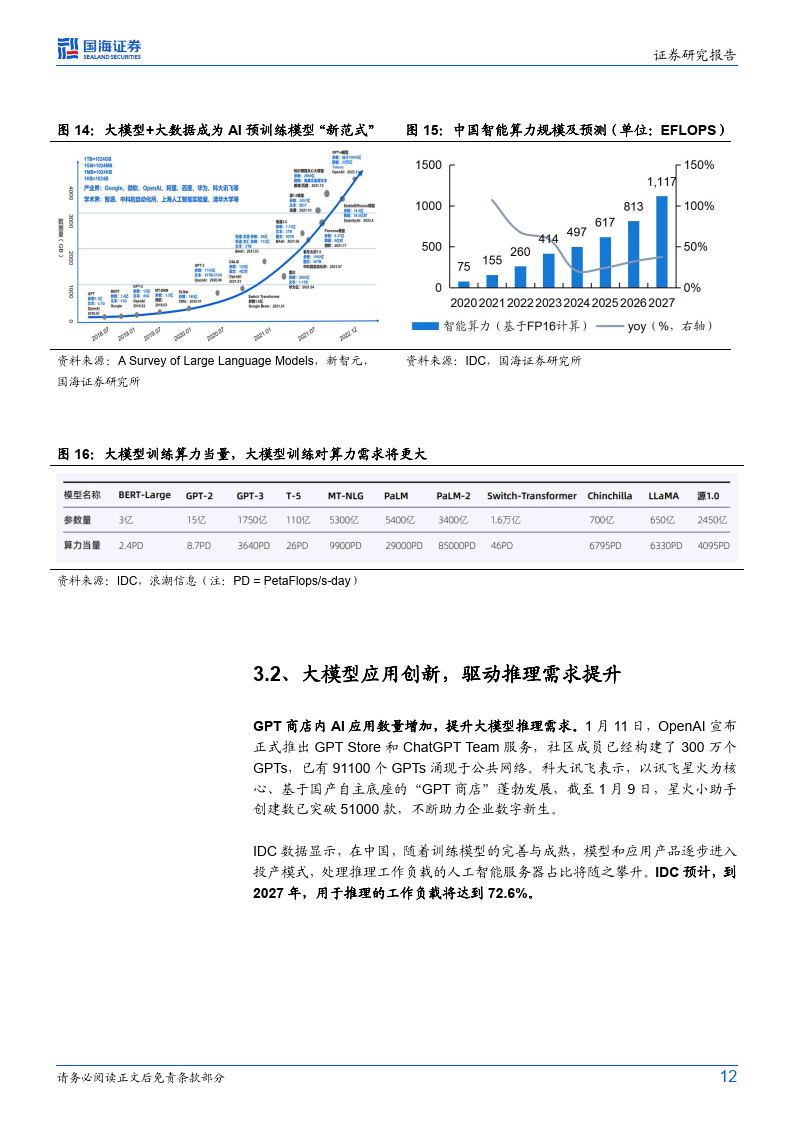

全球 IT 资本支出持续增长,预期 AI 服务器采购量将进一步提升。根据 Gartner 的最新预测,2024年全球IT支出预计将达5.1万亿美元,同比+8%。根据Dell’Oro Group,2022 年,十大云服务商(阿里巴巴/亚马逊/苹果等)在数据中心基础设 施共投入 1140 亿美元,占云服务商支出最大份额。Dell'Oro Group 预期到 2027 年,人工智能基础设施支出将推动数据中心资本支出超过 5000 亿美元,全球数 据中心资本支出预计将增长 15%,超过 20%的全球服务器可能会加快部署。

需求提升:AI 芯片性能提升可降 GPT4 训推成本

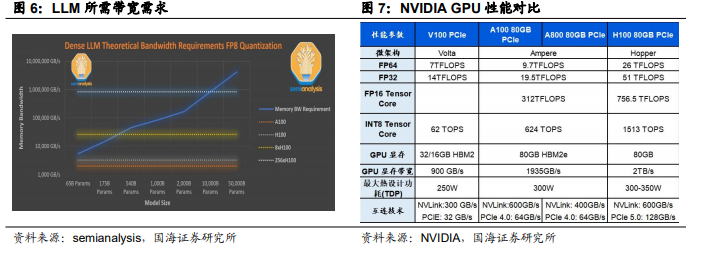

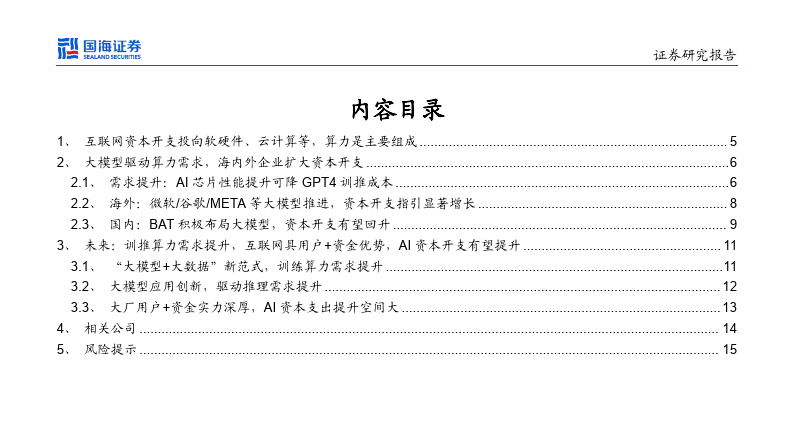

GPT4 的参数规模过万亿,带动 AI 芯片需求提升。根据 Semianalysis,ChatGPT4 在 120 层中总共包含了 1.8 万亿参数,而 GPT-3 仅约 1750 亿参数。GPT-4 的 参数规模或是 GPT-3 的 10 倍以上,与 175B 参数的 Davinchi 模型相比,GPT-4 的成本是其 3 倍,这表明参数量提升可带动 AI 芯片需求。

1)训练:根据 Semianalysis,OpenAI 训练 GPT-4 时,在约 25000 个 A100 上 训练了 90-100 天,1 美元/每 A100 小时,训练成本约 6300 万美元;但在 2 美 元/每 H100 小时,预训练在大约 8192 个 H100 进行,只需 55 天,费用为 2150 万美元。

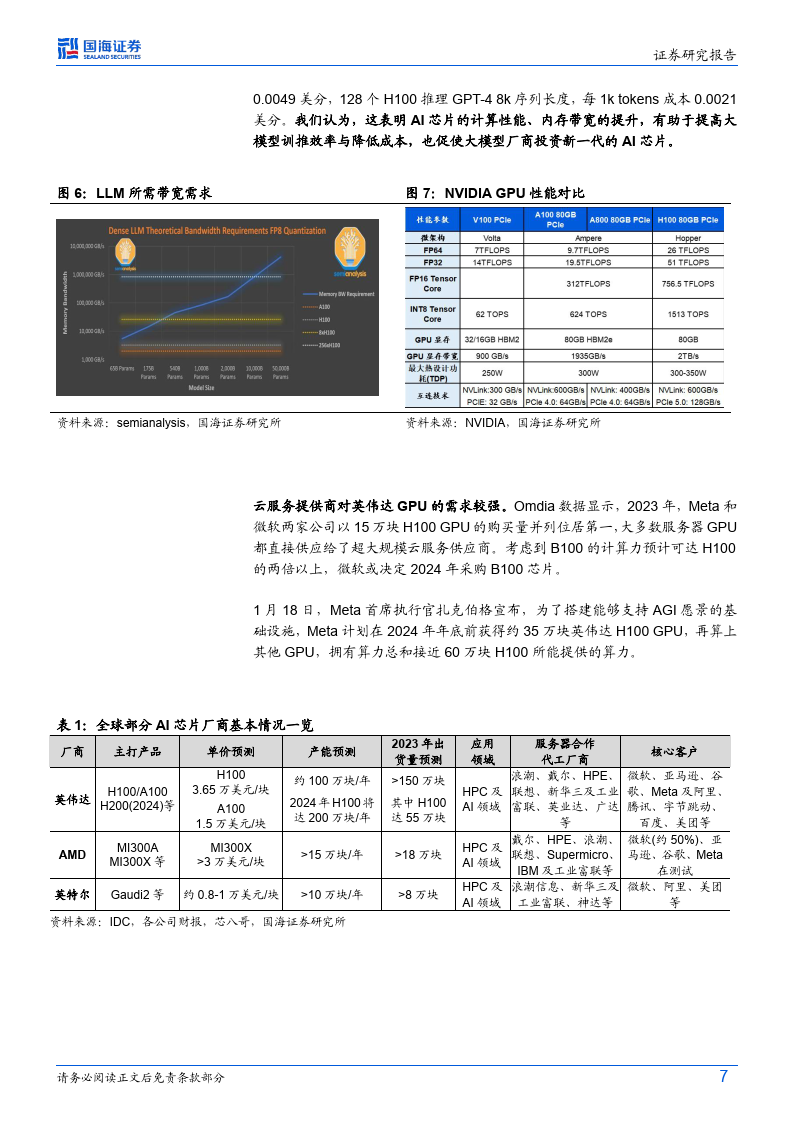

2)推理:128 个 A100 来推理 GPT-4 8k 序列长度,每 1k tokens 成本0.0049 美分,128 个 H100 推理 GPT-4 8k 序列长度,每 1k tokens 成本 0.0021 美分。我们认为,这表明 AI 芯片的计算性能、内存带宽的提升,有助于提高大 模型训推效率与降低成本,也促使大模型厂商投资新一代的 AI 芯片。

云服务提供商对英伟达 GPU 的需求较强。Omdia 数据显示,2023 年,Meta 和 微软两家公司以 15 万块 H100 GPU 的购买量并列位居第一,大多数服务器 GPU 都直接供应给了超大规模云服务供应商。考虑到 B100 的计算力预计可达 H100 的两倍以上,微软或决定 2024 年采购 B100 芯片。

1 月 18 日,Meta 首席执行官扎克伯格宣布,为了搭建能够支持 AGI 愿景的基 础设施,Meta 计划在 2024 年年底前获得约 35 万块英伟达 H100 GPU,再算上 其他 GPU,拥有算力总和接近 60 万块 H100 所能提供的算力。

海外:微软/谷歌/META 等大模型推进,资本开支指引显著增长

复盘海外代表厂商发展脉络,技术形态上大模型围绕多模态和 AI Agent 两大方 向升级迭代。以 OpenAI 为例,陆续发布多模态预训练大模型 GPT-4V 以及 AI Agent 初级形态产品 GPTs。大语言模型(LLM)在 2023 年为逼近通用人工智 能(AGI)提供了一个可能路径。1 月 11 日,OpenAI 宣布,GPT Store 正式上 线,已有超 300 万自定义版本 ChatGPT 应用。2024 年,随着技术的迭代进步 和大模型的深度普及,AGI 时代或即将到来。

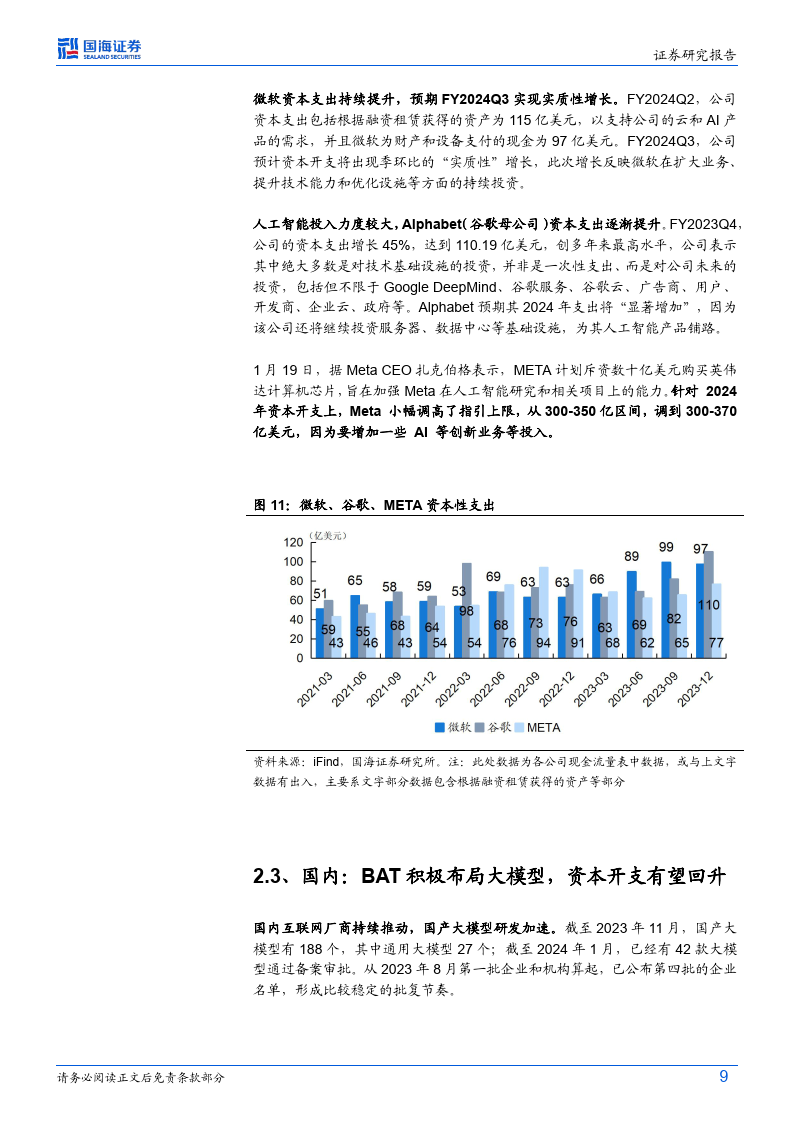

微软资本支出持续提升,预期 FY2024Q3 实现实质性增长。FY2024Q2,公司 资本支出包括根据融资租赁获得的资产为 115 亿美元,以支持公司的云和 AI 产 品的需求,并且微软为财产和设备支付的现金为 97 亿美元。FY2024Q3,公司 预计资本开支将出现季环比的“实质性”增长,此次增长反映微软在扩大业务、 提升技术能力和优化设施等方面的持续投资。

人工智能投入力度较大,Alphabe(t 谷歌母公司)资本支出逐渐提升。FY2023Q4, 公司的资本支出增长 45%,达到 110.19 亿美元,创多年来最高水平,公司表示 其中绝大多数是对技术基础设施的投资,并非是一次性支出、而是对公司未来的 投资,包括但不限于 Google DeepMind、谷歌服务、谷歌云、广告商、用户、 开发商、企业云、政府等。Alphabet 预期其 2024 年支出将“显著增加”,因为 该公司还将继续投资服务器、数据中心等基础设施,为其人工智能产品铺路。

1 月 19 日,据 Meta CEO 扎克伯格表示,META 计划斥资数十亿美元购买英伟 达计算机芯片,旨在加强 Meta 在人工智能研究和相关项目上的能力。针对 2024 年资本开支上,Meta 小幅调高了指引上限,从 300-350 亿区间,调到 300-370 亿美元,因为要增加一些 AI 等创新业务等投入。

国内:BAT 积极布局大模型,资本开支有望回升

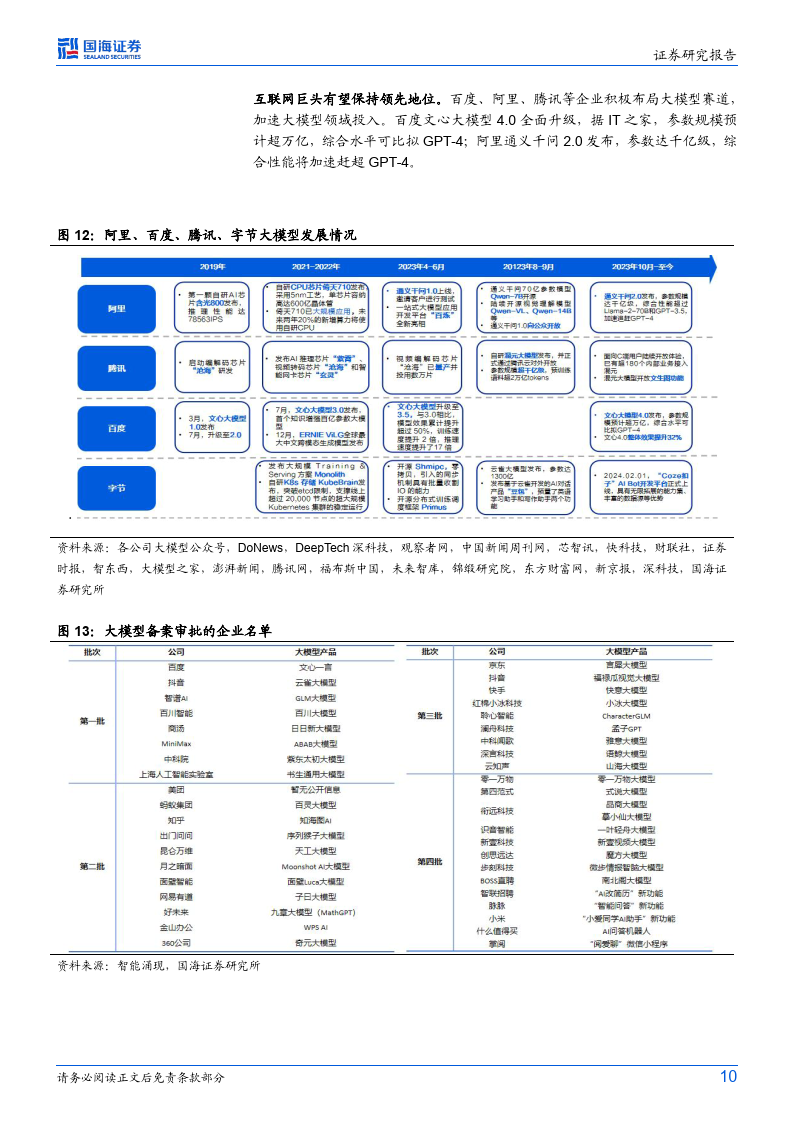

国内互联网厂商持续推动,国产大模型研发加速。截至 2023 年 11 月,国产大 模型有 188 个,其中通用大模型 27 个;截至 2024 年 1 月,已经有 42 款大模型通过备案审批。从 2023 年 8 月第一批企业和机构算起,已公布第四批的企业名单,形成比较稳定的批复节奏。

互联网巨头有望保持领先地位。百度、阿里、腾讯等企业积极布局大模型赛道, 加速大模型领域投入。百度文心大模型 4.0 全面升级,据 IT 之家,参数规模预计超万亿,综合水平可比拟 GPT-4;阿里通义千问 2.0 发布,参数达千亿级,综 合性能将加速赶超 GPT-4。

大模型规划下,互联网厂商资本开支有望回升。百度、阿里、腾讯等公司密集 发布大模型,2023Q3,BAT 均表示将持续加大人工智能投入,并表示不仅陆续 将 AI 大模型赋能主营业务,还表示将持续加大人工智能模型的投入。其中,阿里巴巴集团首席执行官吴泳铭表示,阿里明确战略重心和优先级方向,抓住 AI 科技变革带来的全新机会,创造更多的客户价值。

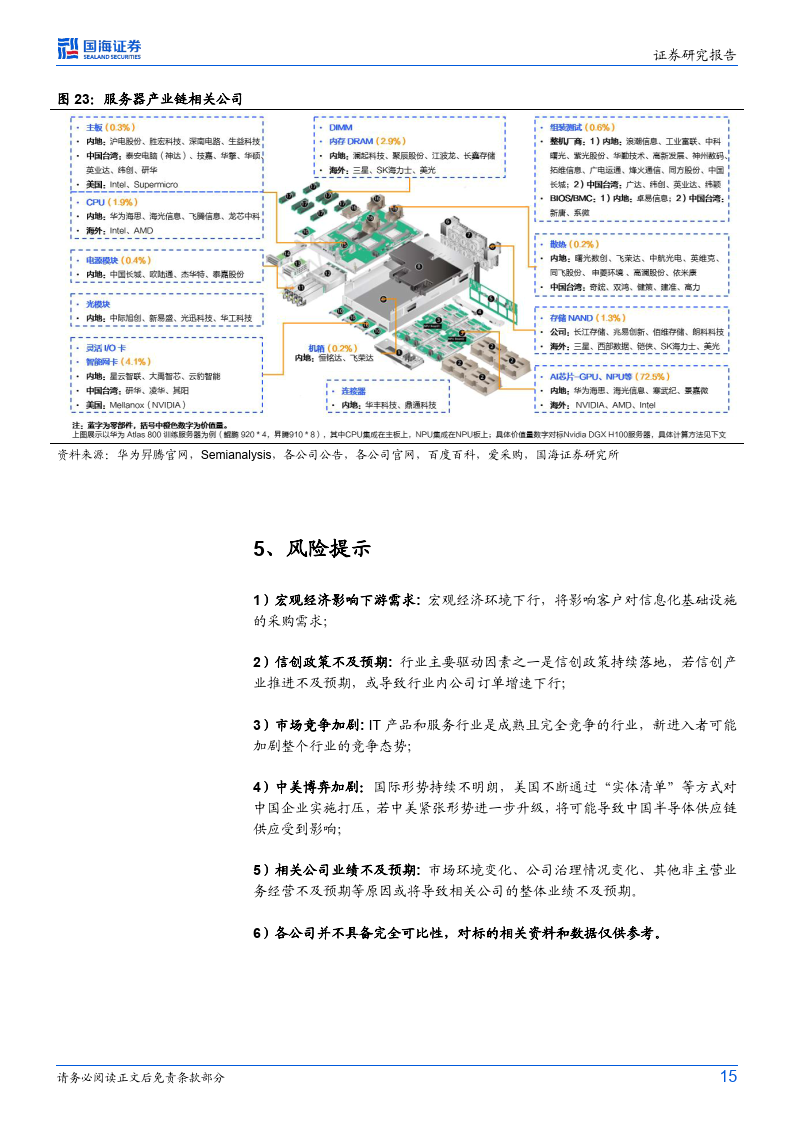

国内算力供应链逐渐改善。根据路透社等,2 月,英伟达已开始接受经销商对中 国特供版 AI 芯片 H20 的预订,每块卡 12000-15000 美元(8.6 -10.77 万元人民 币),产品形态包括计算卡和搭载 8 张 H20 计算卡的服务器,华为 910B 的售 价约为 12 万元人民币。我们认为,后续需关注英伟达 H20 性价比及国内大模型 厂商对其需求情况,以及华为昇腾 910B 等版本的供给与适配进展。

报告共计:17页

来源:人工智能学派

- java安装 ...

赞

踩