热门标签

热门文章

- 1快速体验 Llama3 的 4 种方式,本地部署,800 tokens/s 的推理速度真的太快了!_llama3 8b token

- 2【2019秋招刷题】华为0911笔试题_华为9.11笔试

- 3单元测试的心法分享

- 4Error while loading conda entry point: conda-libmamba-solver (libarchive.so.19: cannot open shared o

- 5HDMI接口协议_hdmi协商过程

- 6【AWS基础】AWS服务介绍与基本使用

- 7oracle sql经典面试题,经典SQL面试题2

- 8git 默认使用vim编辑器命令_git中的vim命令

- 9vue代码提交时忽略./history和node_modules文件修改_vscode 提交git 忽略.history文件

- 10如何在Macbook上安装MySQL

当前位置: article > 正文

基于xinference推理引擎 + glm4-9b-chat模型的本地化部署探索_xinference使用glm4-chat-1m

作者:笔触狂放9 | 2024-08-13 06:05:13

赞

踩

xinference使用glm4-chat-1m

【备注】从langchain-chatchat v0.3开始,所有的模型配置,均由推理模型(如:xinference )进行加载和启动。

xinference 中配置并启动模型

1、启动xinference服务

xinference-local查看支持的模型

xinference registrations --model-type LLM2、执行transformer推理

xinference launch --model-name custom-glm4-chat --model-format pytorch --model-engine Transformers【备注】可以用-u自定模型的uid名字

xinference launch --model-name custom-glm4-chat -u glm4-chat --model-format pytorch --model-engine Transformers4、启动xinference 的命令行方式对话

xinference chat --model-uid glm4-chat3、配置embedding

执行如下命令加载并执行embedding模型

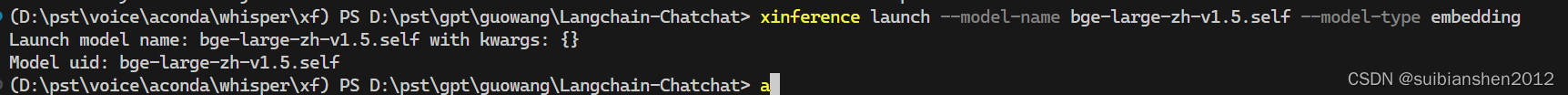

xinference launch --model-name bge-large-zh-v1.5 --model-type embeddingxf配置参考: bge-large-zh-v1.5 — Xinference

embedding模型下载:bge-large-zh-v1.5 · 模型库 (modelscope.cn)

出现如下提示,表示执行成功

【备注】可以用-u指定模型的uid名字

xinference launch --model-name bge-large-zh-v1.5.self -u bge-large-zh-v1.5 --model-type embedding声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/笔触狂放9/article/detail/973535?site

推荐阅读

相关标签