- 1微信小程序自定义弹窗组件

- 2python简易使用rabbitmq_python 是否可以像springboot一样使用rabbitmq

- 3轻快好用的Docker版云桌面(不到300M、运行快、省流量).md_docker 云桌面

- 4python库--pipreqs_python pipreqs ./

- 5word2vec实现训练自己的词向量及其参数详解_word2vec参数设置

- 6遥感数据集+YOLOV5_yolov5_obb

- 7chatgpt赋能python:爬取电影数据的Python代码_爬取chatgpt的回答

- 8最新SparkAI创作系统ChatGPT程序源码+详细图文搭建教程/支持GPT-4/支持AI绘画/Prompt应用_gpt4 prompt 绘画

- 9分类预测 | MATLAB实现基于Isomap降维算法与改进蜜獾算法IHBA的Adaboost-SVM集成多输入分类预测_matlab isomap

- 10中文译英文 模型_helsinki-nlp 中英文互译

“GPT-4时代来临:为何这一代AI模型让GPT-3.5相形见绌?“_gpt3.5和4在ai绘图上有区别吗

赞

踩

这个东西太强大了,GPT-4不同于ChatGPT先前的模型GPT-3.5,它不仅可以接收文字,同时还可以接受图片,但是图片还未开放给大众,从OpenAI的官方视频可以看到一段非常厉害的片段。

这个人用笔在本子上随便画了个自己网站的草图

然后用手机把这个草图拍下来

发送给GPT-4

它识别出了这是一个网站的草图

然后顺便生成了要建成这个网页的代码

好了,你的网站建好了

相比之下,这是原始的图

它强就强在可以接受图片为输入,并且能准确理解图片中的含义。

全文重点摘要

简短版:GPT-4是一个多模态的模型,可以接受文字和图片输入,并且输出文字。现在只开放了文字输入的功能,图片输入功能还在加紧开发中。

- OpenAI发布了GPT-4,这是一个大型多模态模型,能够接受图像和文本输入,并输出文本。

- 虽然在某些情况下它不如人类,但在各种专业和学术考试中表现出了与人类水平相当的性能(human-level performance)。

- GPT-4的训练稳定性是史无前例的(unprecedentedly stable),这得益于对抗性测试计划(dversarial testing program)和来自于ChatGPT的经验教训。

- 在过去的两年里,OpenAI重建了整个深度学习堆栈,并与Azure共同设计了一台超级计算机以便于应付他们的工作负载。

- OpenAI首先发布了GPT-4的文本输入功能,图像输入功能敬请期待。

- OpenAI还开源了OpenAI Evals,这是他们的自动化评估AI模型性能的框架,任何人都可以提交他们模型的缺陷以帮助改进。

Logo的变化

图片的变化,前者是GPT-4,后者是ChatGPT的模型GPT-3.5可以看到,后者更整齐,更格式化;但新出的GPT-4给人的感觉反而显得杂乱。

其实背后的原因我觉得是GPT-4是个多模态()的模型,不同于GPT-3.5只能接受文字作为输入,GPT-4还可以接受一张图片作为输入,比如一份高考数学卷子,然后你可以根据这份卷子问一些问题,这就一定程度上解决了图片的变化。

性能的变化

简短版:比GPT-3.5,GPT-4更加可靠、有创造力,并能够处理更加微妙的指令。

详细版:跟GPT-3.5,也就是chatgpt在随意的交谈中,他们的区别可能不是很大。但是一旦任务的复杂性达到足够高的时候,差异就会显示出来。

为了了解这两种模型之间的区别,OpenAI在各种基准测试中进行了测试,比如这两种Olympiads and AP free response questions。并且值得注意的是,他们并没有针对性的拿着两种考试进行训练,意思是他们这个模型并没有针对特定的问题进行微调。

可以可以看到,GPT-4(绿色)大体上要比GPT3.5好,并且展现出类似于人类的水平。其中值得注意的是,GPT-4在这项律师考试(Uniform Bar Examination)中获得了前10%的高分。

下面是具体的得分,在很多项都是很靠前的得分。

在benchmark基准数据集上的表现优异

GPT-4在下面的这几个经常用来比较模型性能的数据集上做了测试,展现出了很高的性能,比如第一个MMLU数据集,GPT-4达到了86.4%的准确度,而SOTA也就是最高性能的才75.2%。OpenAI提到了,这些模型都是针对于特定任务经过精心调整的,然而,GPT-4可以说是爆杀了。

在其中语言上的比较

大多数的测试数据都是英文,为了测试GPT-4在其他语言上的性能,他们用Azure的翻译功能,将MMLU这个数据集翻译成了26种语言。在其中的24种语言上,GPT-4比GPT-3.5和其他的大语言模型,这里他们比较了Chinchilla, PaLM。

其中随机猜测的准确率是25%,符合多选题的概率。

Chinchilla- 67%,PaLM-69.3%和GPT-3.5 – 70.1%,

从图中可以看到,最差的两个是Marathi和Telugu,经过查证,这是俩印度的官方语言,大概率是使用人数虽然多,但是在互联网上以文字存在的分量并不多。

可以看到中文的性能也很好,只比英文差一点。

视觉输入性能

简短版:还在研究阶段,不公开。

详细版:GPT-4可以接受文本和图像输入,并且这两个是可以掺杂着用,它允许你用跟之前文本一样的使用方式。

一共有7个例子,总结起来,它可以识别搞笑图片,可以做复杂的物理化学之类的题目,可以做看图题,可以读论文,可以识别meme图片,总之,非常的强,可惜还不能开放使用。

第一个图

可以看到,它非常准确的认出了每幅图,并能理解为什么这幅图的搞笑之处。

第二幅图

这是一个对于普通人非常简单的看图题,但是对于之前的机器学习,这是很难做到的,GPT-4不仅可以读懂问题,还能非常完整的回答对。

第三幅图

这已经是一道有点儿复杂的像是物理的问题了,回答的准确无误。

第四幅图:

还是找异常点,准确。

第五幅图

读论文并总结,好像ChatPDF要完蛋了。

https://github.com/openai/evals我也是想了几秒钟后才察觉这是一个由鸡块构成的地球,GPT-4的回答非常精准。

第七幅图

解释了统计机器学习和深度学习的异同点,前者取消降低过拟合,后者需要增大网络层数,其实是一个比较专业性的搞笑图片。

但是结论是完全没问题的。

视觉数据集上的表现

还是没有经过微调,部分超过SOTA,部分跟SOTA持平,总之,很强。

操纵性(Steerability)

可以更好的规定你想要的回答风格,比如说你想要一位苏格拉底式的导师。特点是从不直接给学生答案,但会用启发式的形式教导学生,让学生学会独立思考。

莎士比亚风格的海盗(英译中很差,不如直接上英文)

让GPT-4保持Json的回答形式

局限性

跟之前的ChatGPT一样,它还是有可能会输出不可靠的内容,但是经过几个月的调整,性能提升很大。

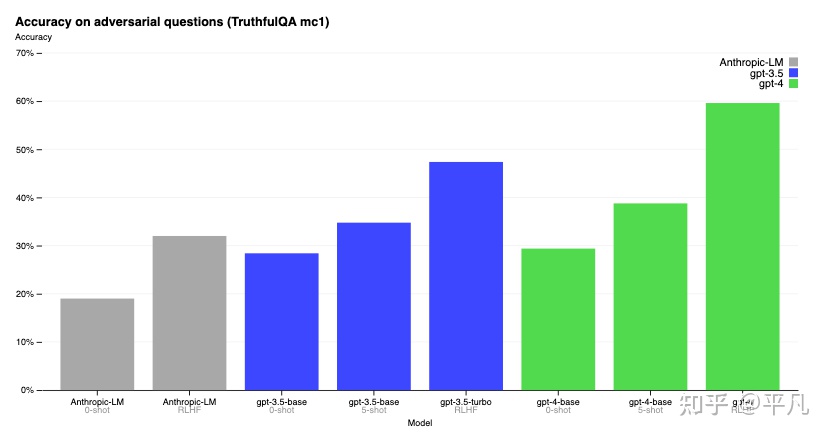

比如在对抗性的问题TruthfulQA上,GPT-4性能提升具有统计意义的显著性。

至于数据问题的时间问题,还是一样,2021年之后的数据就不知道了,并且还是会随机的生成一些错误的内容,但是经过校准之后,这样的错误大大的减少了。

风险和应对措施

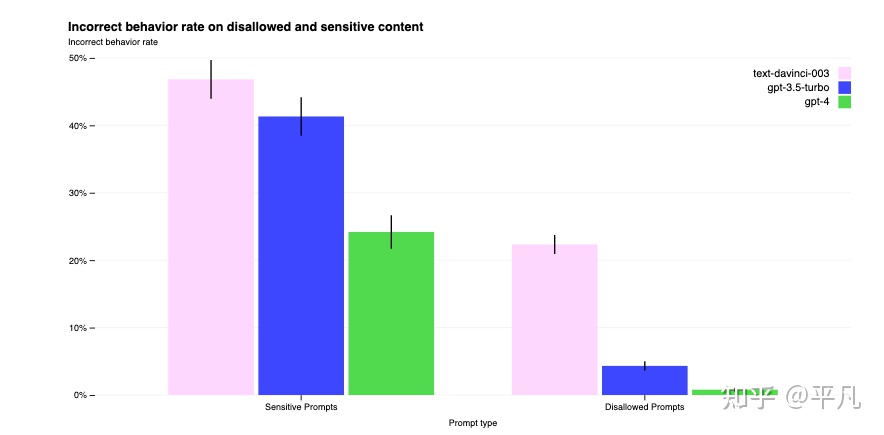

- OpenAI一直在对GPT-4进行迭代,以使其更加安全。

- GPT-4与以前的模型一样具有风险,但由于其额外的能力,从而会导致新的风险。

- 邀请了50多名专家对模型进行对抗测试,以提高模型的安全性能。

- GPT-4在RLHF训练过程中加入了额外的安全奖励信号,以减少有害输出。

- 为了防止模型拒绝有效请求,收集了多样化的数据集,并在允许和不允许的类别上应用安全奖励信号。

- 缓解措施显著提高了GPT-4的安全性能,例如将模型对于不允许内容请求的响应率降低了82%。

分别对于两个问题的回应

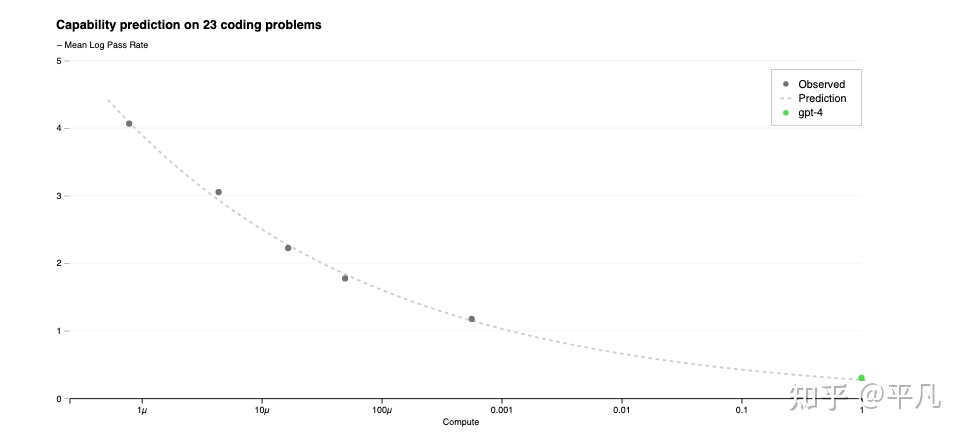

可以预测的扩展

OpenAI的GPT-4项目致力于构建一个可预测扩展的深度学习堆栈,以便在非常大的训练运行中不需要进行广泛的模型特定调整。他们开发了基础设施和优化,使得在多个规模上具有可预测的行为。现在,OpenAI能够准确预测训练期间他们优化的度量(损失),并开始开发预测更可解释的度量的方法。

他们认为,准确预测未来的机器学习能力是安全的一个重要部分,但是相对于其潜在影响,它并没有得到足够的关注。