- 1数学建模大师手册:全国大学生数学建模竞赛模板(附Word模版)_大学数学建模模板

- 2【大数据】Flink 内存管理(一):设置 Flink 进程内存_配置 flink 进程的内存

- 3faceswap深度学习AI实现视频换脸详解

- 4常见八大排序(附动图及W字详解)(C语言)《数据结构与算法》_内外排序的概念和特点

- 5北京理工大学计算机调剂非全,北京理工大学自动化学院2019年非全日制考生调剂信息...

- 6clickhouse的libkafka配置

- 7git 用 diff 来检查改动

- 8uniapp 之 uniapp 开发微信小程序 报错 : socket 合法域名校验出错 wss://wshz.getui.net:5223 不在以下 socket 合法域名列表中_socket合法域名

- 9win10环境实现yolov5 TensorRT加速试验(环境配置+训练+推理)_tensorrt 10 加速yolov5

- 10KAN: Kolmogorov–Arnold Networks 文章理解

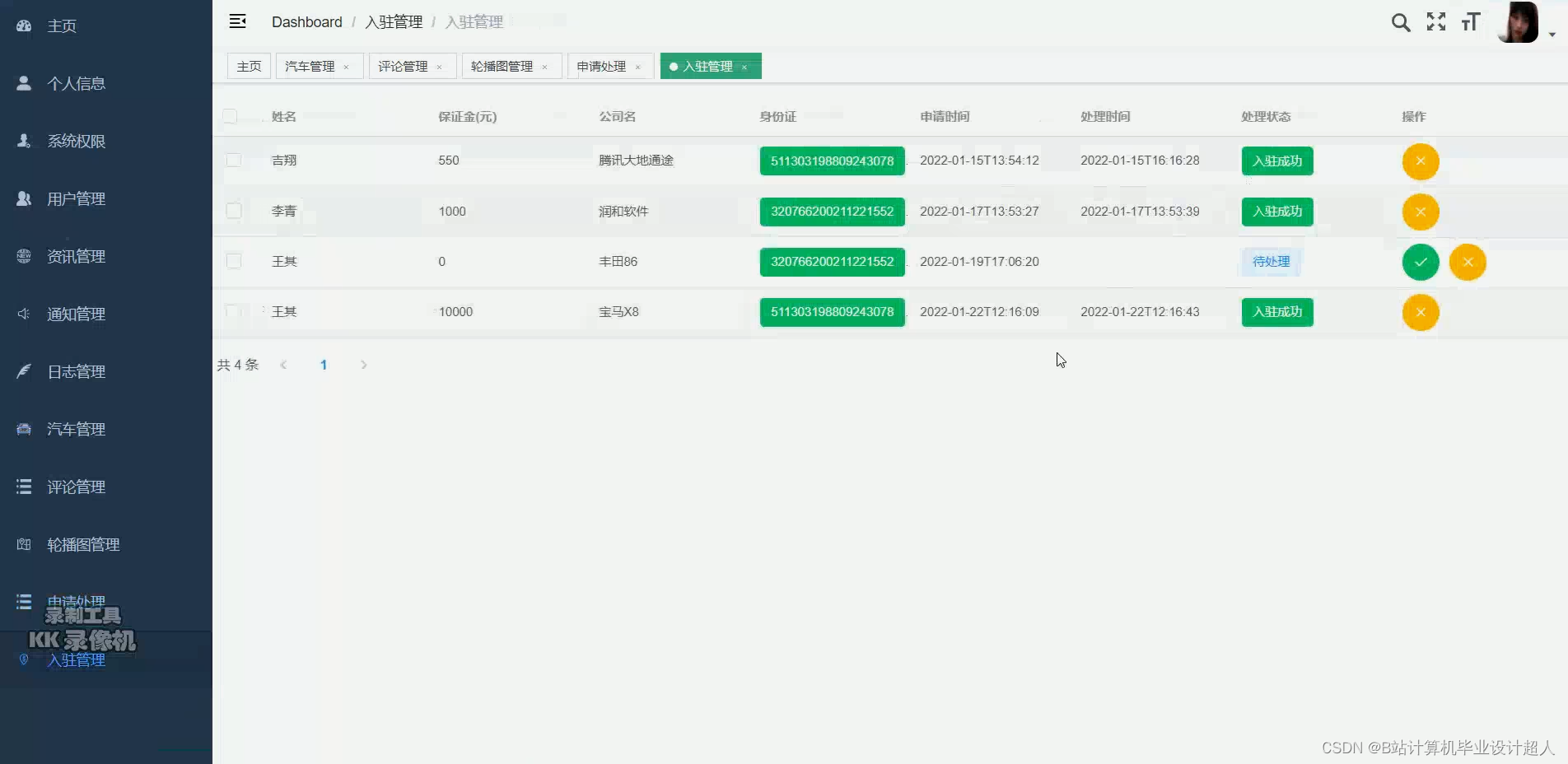

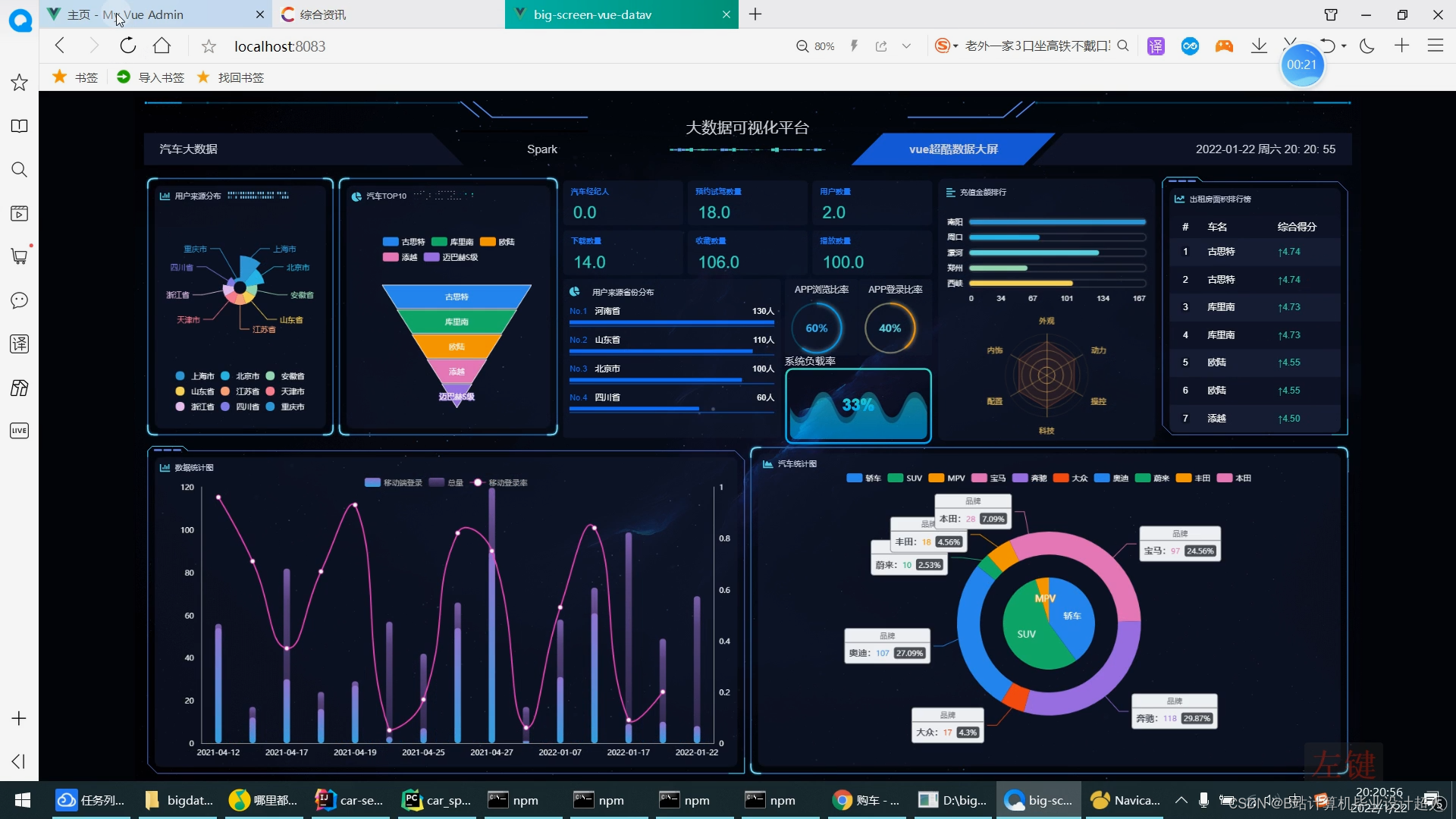

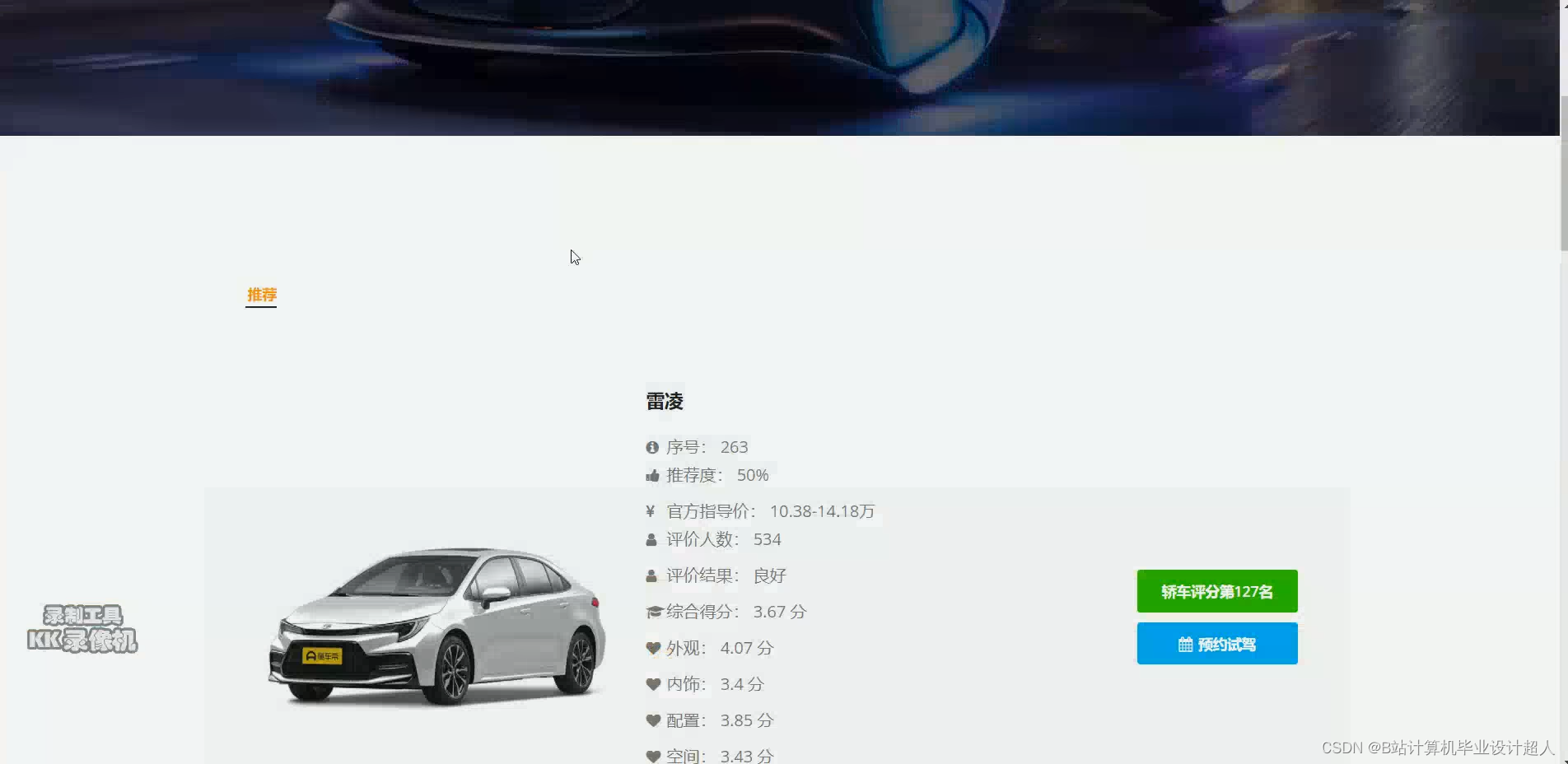

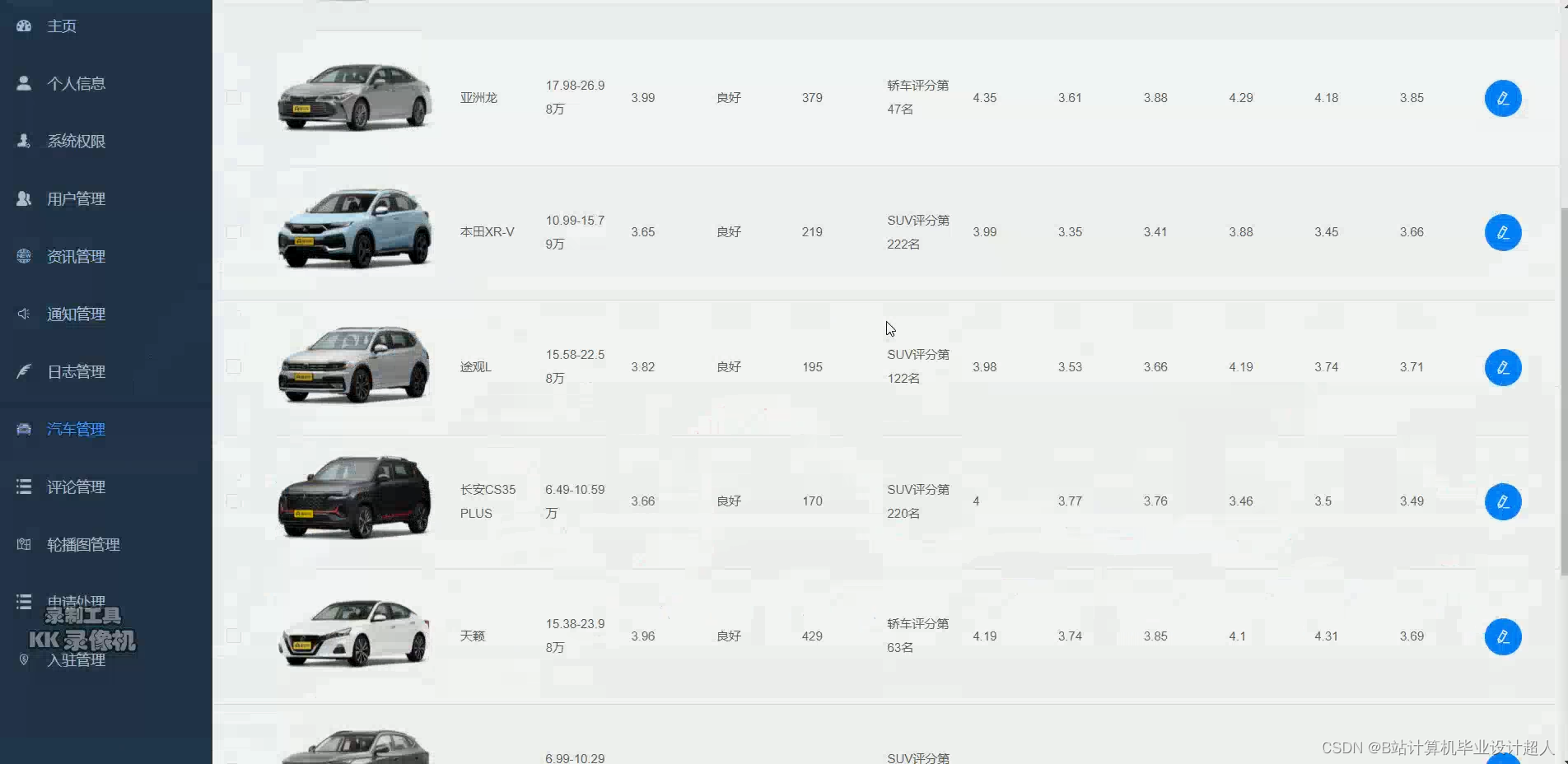

大数据毕业设计hadoop+spark+hive知识图谱新能源汽车数据分析可视化大屏 汽车推荐系统 新能源汽车推荐系统 汽车爬虫 汽车大数据 机器学习 人工智能 计算机毕业设计 Python毕业设计_基于hive的新能源汽车数据分析

赞

踩

(一)课题研究的背景

新能源汽车作为汽车电动化、低碳化的重要发展方向,对于提高产业竞争力、改善未来能源结构、发展低碳交通具有深远意义。全球主要发达国家都将新能源汽车作为未来发展的未来发展的重要战略方向并加快产业布局川。相较于传统燃油汽车,新能源汽车具有能耗较低、对环境污染小等优点,是传统燃油汽车所不及的,因此,新能源汽车将会是未来汽车产业发展的主要趋势。我国也大力支持新能源汽车产业的快速发展,频繁出台相关政策,全方位鼓励和扶持新能源汽车产业。一方面政府鼓励及补贴新能源汽车企业提升新能源汽车生产规模,积极研究和创新相关技术,提升新能源汽车品质;另一方面国家发放资金补贴,降低消费者购买新能源汽车的成本及并根据新能源车辆行驶里程对消费者进行资金补贴等政策(112),降低了消费者购买新能源汽车的难度,引导消费者选择新能源汽车,进而推动了新能源汽车普及率。

在全球化、信息化的时代,一些有关大数据信息的处理、分析技术已经取得了很大的进步,众多数据分析系统被广泛地应用,为了让消费者对新能源汽车更加的了解以便选出自己喜欢的汽车类型,销售分析平台就是能很好解决这一需求的技术。

(二)课题研究的内容

课题研究的内容主要有三部分,即数据获取、数据分析、数据可视化。

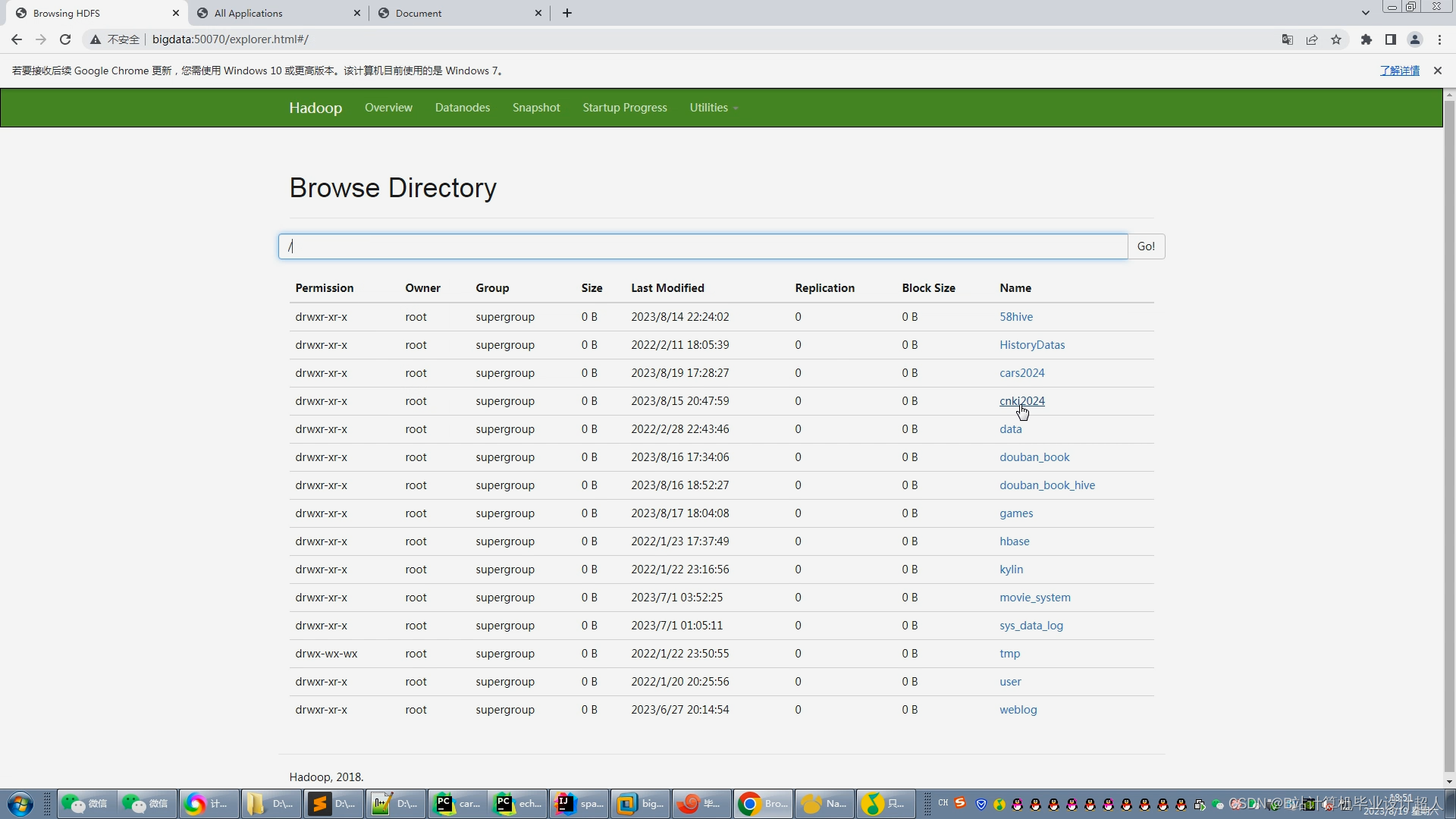

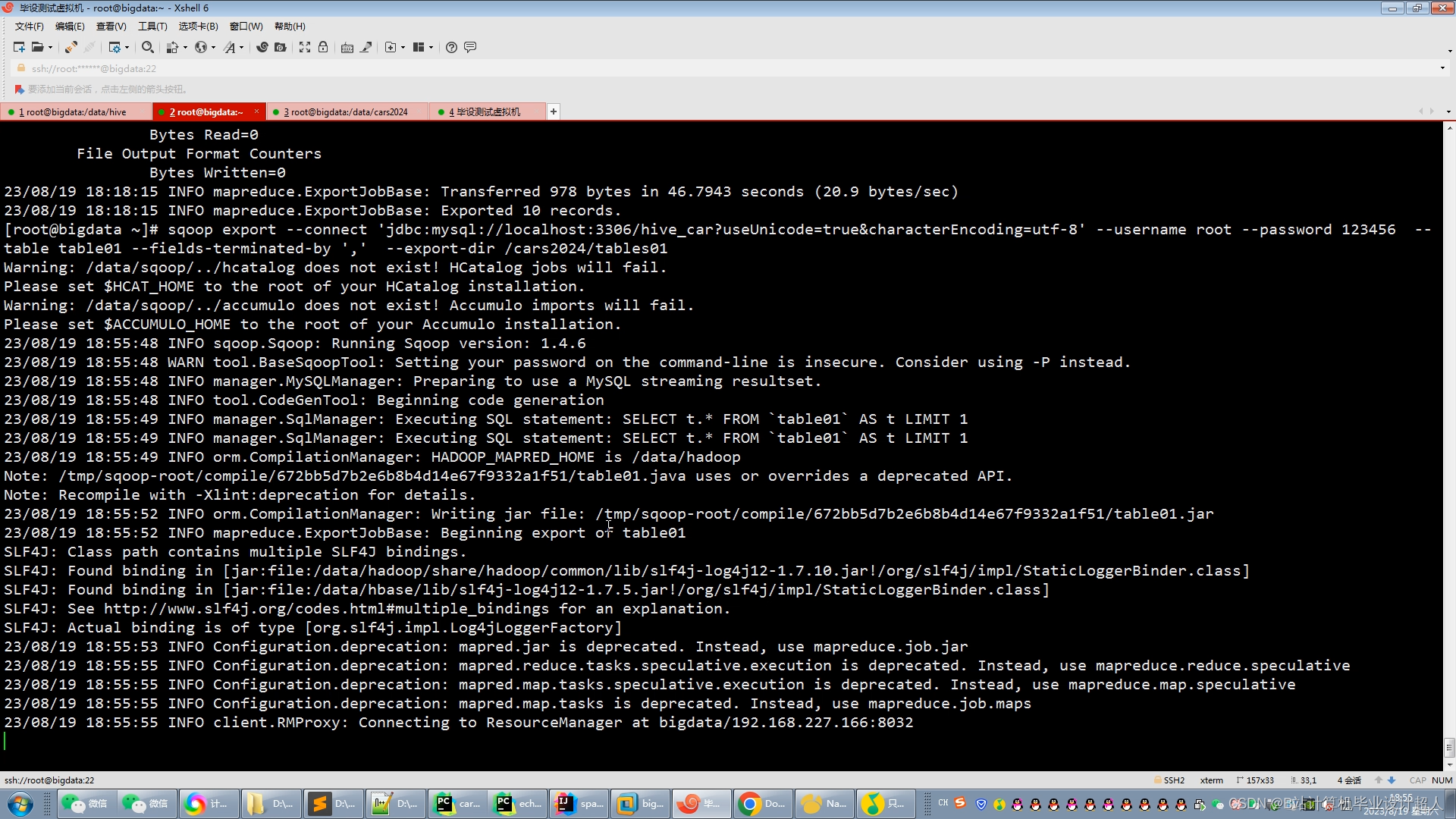

数据获取:基于python爬取新能源汽车相关销售数据:销量,评价,品牌价格,性能介绍等并存储到hadoop分布式系统中。

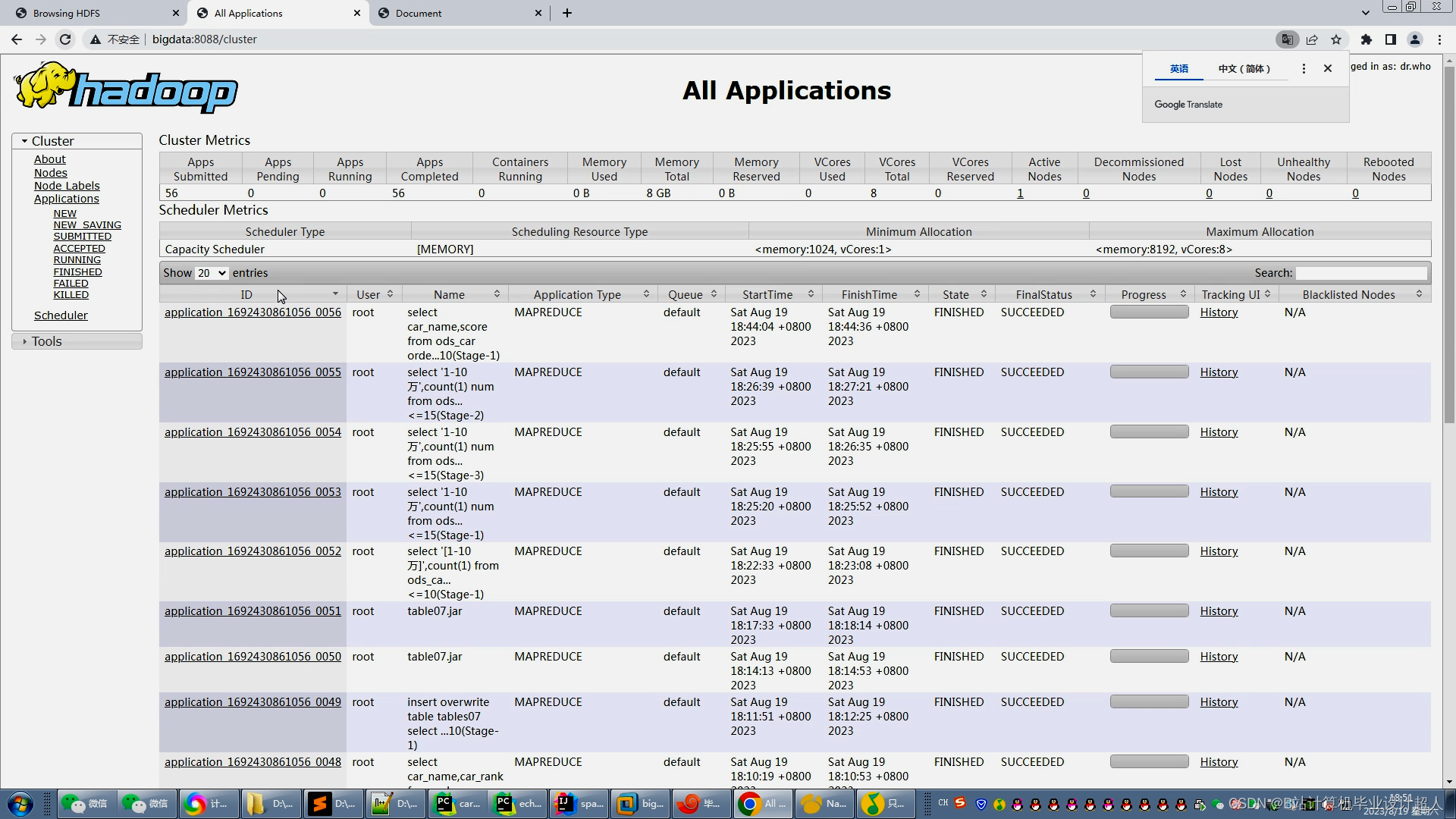

清洗分析数据:采用基于内存计算的spark计算框架结合高吞吐的HDFS分布式文件系统,对车辆销售数据进行计算和分析。

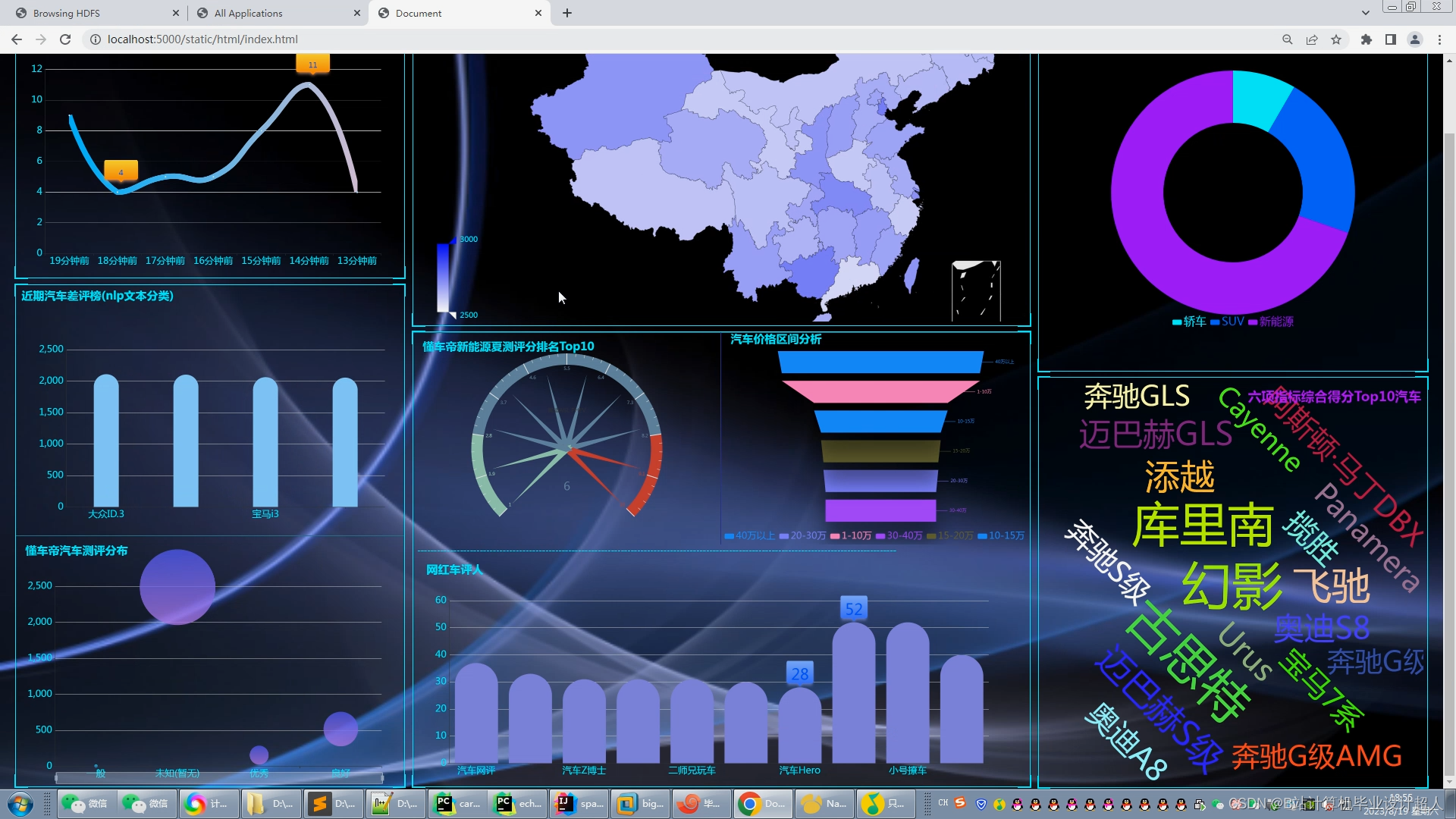

数据可视化 :对分析出来的结果集进行可视化展示是大数据分析流程中很重要的一个层面。对于用户来说,单纯的数字展现在其面前是没有任何效果的。所以,我们需要利用数据可视化技术,将Hadoop数据分析平台计算分析的结果集以曲线图、柱状图等表格的形式进行可视化展示,使得分析出来的数据更加清晰明了。

(三)课题研究的意义

新能源汽车销售分析平台研究的意义在于帮助企业更好地了解市场和消费者需求,提高销售效率和客户满意度。具体来说,它可以帮助企业了解市场趋势和竞争对手情况,从而制定更加精准的销售策略。可以通过数据分析,了解消费者的需求和偏好,为其推荐适合的车型和配置,提高销售转化率。实现对新能源汽车供应链和售后服务的实时管理和监控,提高供应链效率和售后服务质量。通过与客户关系管理系统的集成,建立和维护客户关系,提高客户满意度和忠诚度。总之,新能源汽车销售分析平台的研究对于企业提高市场竞争力、提高销售效率和客户满意度都具有重要意义。

(四)国内外研究现状

1.国外研究现状

在国外新能源汽车销售分析平台的研究领域,目前主要的方法是基于大数据和人工智能技术来构建一个智能化、个性化的销售分析平台。这种方法的原理是通过收集和分析海量的新能源汽车销售数据,运用大数据技术和人工智能技术,实现智能化和个性化的销售预测、市场分析、客户画像等功能,从而提高销售效率和客户满意度。这种方法的优点在于,它可以实现对海量数据的快速处理和分析,从而更好地了解市场和客户需求,提高销售效率和客户满意度。同时,它还可以通过智能化和个性化的推荐,帮助销售人员更好地了解客户,提高销售业绩。

2.国内研究现状

新能源汽车销售分析平台在国内的研究现状相对较好。随着新能源汽车市场的不断扩大,越来越多的企业开始关注新能源汽车销售分析平台的建设和应用。目前,国内已经有一些知名的汽车销售分析平台,例如易车、汽车之家等,它们通过大数据分析和人工智能技术,为汽车厂商和经销商提供销售数据分析和决策支持。这些平台不仅可以实时监测销售数据,还可以通过用户行为分析来优化营销策略和提升用户体验。此外,一些新兴的汽车销售分析平台也在不断涌现,例如懂车帝、车好多等。这些平台通过提供个性化的推荐服务、在线咨询服务等,帮助用户更好地了解和购买新能源汽车。然而,尽管新能源汽车销售分析平台的研究现状相对较好,但在实际应用中还存在一些问题和挑战。例如,如何提高平台的智能化水平、如何更好地整合线上线下资源、如何保障用户隐私和数据安全等问题都需要进一步研究和解决。总的来说,新能源汽车销售分析平台在国内的研究现状已经取得了一定的进展,但仍需不断探索和创新,以更好地服务于新能源汽车市场的发展。

(五)设计方案选型分析

收集数据:收集和查找相关的资料,理解新能源汽车销售数据,对新能源汽车销售数据有一定的认识,浏览汽车销售网站,明确数据的来源。确定数据采集的方法,收集和学习利用python网络爬虫实现数据爬取的案例。

存储数据:将数据存入hadoop分布式系统中。

数据分析:采用基于内存计算的spark计算框架结合高吞吐的HDFS分布式文件系统,对车辆销售数据进行计算和分析

数据展示:将Hadoop数据分析平台计算分析的结果集以曲线图、柱状图等表格的形式进行可视化展示,使得分析出来的数据更加清晰明了

二、课题任务、重点研究内容及实现途径

(一)课题任务

课题任务的内容主要有三部分,即数据获取、数据分析、数据可视化。

数据获取:基于python爬取新能源汽车相关销售数据:销量,评价,品牌价格,性能介绍等并存储到hadoop分布式系统中。

清洗分析数据:采用基于内存计算的spark计算框架结合高吞吐的HDFS分布式文件系统,对车辆销售数据进行计算和分析。

数据可视化 :对分析出来的结果集进行可视化展示是大数据分析流程中很重要的一个层面。对于用户来说,单纯的数字展现在其面前是没有任何效果的。所以,我们需要利用数据可视化技术,将Hadoop数据分析平台计算分析的结果集以曲线图、柱状图等表格的形式进行可视化展示,使得分析出来的数据更加清晰明了。

(二)重点研究内容

本文重点研究的内容是使用Hadoop分析和存储。Apache 组织借鉴Google 的 Big Table、GFS和 MapReduce,提出了开源项目 Hadoop。Hadoop数据分析平台是具有分布式系统的框架,是目前最为广泛使用的云计算平台。

本项目需爬取不少于20页的数据,并基于Hadoop大数据平台对上传的车辆数据经过初步分析后,存储到hadoop分布式系统中,同时采用spark技术作为系统的大数据计算模型,计算结果根据不同场景需要,存储到Hbase和Mysql中供数据可视化使用,运用echarts,mysqpl等技术构建可视化大屏,将分析结果以可视化图表的形式进行展示。

(三)实现途径

- 入门硬件配置

客户端电脑,基本配置为:四核、2.5GHZ以上的64位处理器,16G以上内存,硬盘剩余空间50G以上,显示器要求1024*768以上。

- 和其他软件配合使用

操作系统 Ubuntu ,VMware,Hadoop,hbase,spark,MySQL,pycharm,echarts等。

三、进度计划

| 序号 | 起止周次 | 工作内容 |

| 1 | 1周至2周 | 确定毕业选题 |

| 2 | 3周至5周 | 撰写开题报告 |

| 3 | 6周至7周 | 根据开题报告完成毕业设计实践任务 前期软件环境准备阶段 |

| 4 | 8周至9周 | 分析可视化实现阶段 |

| 5 | 9周至10周 | 提交源文件和可视化效果展示 |

| 6 | 11周至14周 | 确定论文结构 撰写毕业设计论文 |

| 7 | 15周至16周 | 提交毕业设计论文初稿 |

| 8 | 17周至18周 | 修改毕业设计论文 提交毕业设计查重稿 |

| 9 | 18周至19周 | 修改毕业设计论文 提交毕业设计答辩稿 |

| 10 | 20周至21周 | 答辩准备 |

核心算法代码分享如下:

- import scrapy

- from scrapytest.items import CarItem

-

- class CarSpider(scrapy.Spider):

- name = 'car_anhui'

- pvareaid=102179#currengpostion']

- #

- pvareaid=102179#currengpostion'

- # page_num = 2

- # 重写start_requests()方法,把所有URL地址都交给调度器

- def start_requests(self):

- for i in range(1,101,1):

- url = f'XXXX'

- yield scrapy.Request(url=url,callback=self.parse)

-

- def parse(self, response):

- car_list = response.xpath('//*[@id="goodStartSolrQuotePriceCore0"]/ul/li')

-

- for car_list_i in car_list:

- item = CarItem()

- name = car_list_i.xpath('./a/div[2]/h4/text()').get()

- price = car_list_i.xpath('./a/div[2]/div[1]/span[1]/em/text()').get()

- newprice = car_list_i.xpath('./a/div[2]/div[1]/s/text()').get()

- if newprice != None:

- newprice = newprice.replace('万','')

- else:

- newprice = newprice

-

-

-

- item['name'] = name

- item['price'] = price

- item['newprice'] = newprice

-

-

- href = car_list_i.xpath('./a/@href').get()

- if href[0:16] == 'XXXXX':

- url_1 = 'https:' + href

- # print(url_1)

- yield scrapy.Request(url=url_1,meta={'item':item},callback=self.parse_detail)

- else:

- url_2 = 'XXXXX' + href

- # print(url_2)

- yield scrapy.Request(url=url_2,meta={'item':item},callback=self.parse_detail)

-

-

- # if self.page_num <= 100:

- # print(self.page_num)

- # new_url = format(self.url%self.page_num)

- # self.page_num += 1

- # print('+++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++')

- # yield scrapy.Request(url=new_url,callback=self.parse)

-

-

- def parse_detail(self, response):

- item = response.meta['item']

- cartype = response.xpath('//*[@id="nav1"]/div[1]/ul[3]/li[2]/text()').get()

- engine = response.xpath('//*[@id="nav1"]/div[1]/ul[3]/li[1]/text()').get()

- Driving = response.xpath('//*[@id="nav1"]/div[1]/ul[3]/li[5]/text()').get()

- transfer = response.xpath('//*[@id="nav1"]/div[1]/ul[2]/li[5]/text()').get()

- gearbox = response.xpath('//*[@id="nav1"]/div[1]/ul[1]/li[3]/text()').get()

- mileage = response.xpath('/html/body/div[5]/div[2]/ul/li[1]/h4/text()').get()

- if mileage != None:

- mileage = mileage.replace('万公里','')

- else:

- mileage = mileage

-

- time = response.xpath('/html/body/div[5]/div[2]/ul/li[2]/h4/text()').get()

- local = response.xpath('/html/body/div[5]/div[2]/ul/li[4]/h4/text()').get()

-

-

-

-

- item['mileage'] = mileage

- item['time'] = time

- item['local'] = local

- item['cartype'] = cartype

- item['engine'] = engine

- item['Driving'] = Driving

- item['transfer'] = transfer

- item['gearbox'] = gearbox

-

- # print(item)

| 课题 名称 | 基于Hive的新能源汽车数据仓库管理系统的设计与实现 | ||||||

| 课题 来源 | 学校课题及自选课题 | 课题 类型 | 工程实践 | 指导 教师 | 付接递 | 职称/学位 | 硕士 |

| 学生 姓名 | 徐东升 | 学号 | 2020105410243 | 专业 | 信息与计算机科学(智能信息处理方向) | 班级 | 2班 |

| 一、调研资料准备 对企业进行实地调研,做好需求分析;走访相关企业了解企业的需求以及应用场景,与相关负责人沟通存在的问题,针对于问题做好合理的规划与设计;通过查阅相关资料信息如万方数据等学术网站相关论文内容,分析与研究新能源汽车数据仓库管理系统的功能,并且查阅相关系统开发知识,与指导教师沟通系统设计思路与功能。 二、设计的目的、要求、思路与预期成果 (1)设计目的 本次设计一个基于Hive的新能源汽车数据仓管理系统。企业管理员登录系统后可以在汽车保养时,根据这些汽车内置传感器传回的数据分析其故障原因,以便维修人员更加及时准确处理相关的故障问题。或者对这些数据分析之后向车主进行预警提示车主注意保养汽车,以提高汽车行驶的安全系数。 (2)设计要求 利用Flume进行分布式的日志数据采集,Kafka实现高吞吐量的数据传输,DateX进行数据清洗、转换和整合,MySQL存储结构化数据,HDFS存储大规模原始日志数据,Hive进行数据仓库查询和分析,Spark进行分布式数据计算,Dolphinscheduler进行全流程调度管理,帆软BI工具实现可视化大屏展示。实现数据采集、传输、清洗、存储、查询、计算、调度和展示全流程功能。提供监控、数据质量管理、多维度数据分析等功能。 (3)设计思路 新能源汽车数据仓库管理系统,主要服务于新能源汽车车主,企业负责本系统的登录维护,在进行工作流调度时设置Admin用户进行环境管理或环境创建,设置普通用户权限进行项目工作流的创建和任务节点的配置,在FineBI中设置管理员账号进行环境的搭建以及对数据进行处理展示,使管理人员能够更加直观的获取想要的数据,企业根据系统中的数据为车主提供相关服务。其设计思路着重于多方位的数据处理,涵盖了全面数据采集、数据清洗和质量保障、大规模数据存储、高效数据管理、数据分析与挖掘、可扩展性与灵活性、用户友好的数据查询与报告、高性能与低延迟等多个方面。整体设计思路旨在打造一套高效、安全、可靠的大数据处理平台,为新能源汽车行业提供全面的数据支持,助力业务决策并确保系统在未来的发展中具备良好的可扩展性和适应性。 (4)预期成果 毕业设计1套(包含项目软件和数据库等)和毕业论文1份(符合学校查重要求的毕业论文)。 三、任务完成的阶段内容及时间安排 2023年11月06日前查看相关资料、技术,准备技术文档,做好需求分析,下发任务书; 2023年12月31日前制定软件开发计划,设计软件部分功能,完成开题报告; 2024年01月06日前进行开题答辩; 2024年03月15日前完成系统开发与测试,进行中期检查; 2024年04月22日前撰写论文初稿、完成后和指导老师沟通修改论文、定稿、进行查重检测; 2024年05月19日前完成所有毕设材料、参加答辩。

(1)硬件方面:Windows10操作系统电脑一台 (2)软件方面:Linux虚拟机、MySQL数据库、帆软BI。 指导教师签名: 日期:

| |||||||