热门标签

热门文章

- 1【机器学习】第5章 朴素贝叶斯分类器

- 22024年网络安全最新网络安全方面 关于渗透 可以选择那些书?_渗透测试书籍(3),2024年最新2024年网络安全面试心得_渗透测试相关书籍

- 3一款开源免费图床聚合平台 ImageHosting

- 4【jenkins】教你jenkins设置为中文_jenkins 中文插件,2024年最新这操作真香_jenkins设置中文

- 5NullPointerException: println needs a message_permission revoked nullpointerexception: println n

- 6基于SpringBoot的校园闲置物品交易系统

- 7数据同步工具Sqoop_sqoop hcatalog更新数据

- 8识局者生,破局者存,掌局者赢

- 9Python图像边缘检测:边缘检算法原理及实现过程_python 边缘检测

- 10html插入视频的方法_html怎么插入视频

当前位置: article > 正文

深度学习笔记(九):神经网络剪枝(Neural Network Pruning)详细介绍

作者:繁依Fanyi0 | 2024-06-21 22:25:03

赞

踩

神经网络剪枝

1:What is pruning

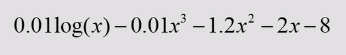

剪枝是一种模型压缩的方法,这种方法可以有效的裁剪模型参数且最小化精度的损失。由于深度学习模型可以看作是一个复杂树状结构,如果能减去一些对结果没什么影响的旁枝,也就是修剪神经网络中不重要的权重,就可以实现模型的减小。比如说看下图

我们通过观察这个函数发现有些项对应的系数是很小的,也就是说对于拟合的贡献不是很大,如果我们把系数小的去掉得到-1.2x^2-2x-8的式子,得到下图

这时候我们可以观察到这时候拟合出来的效果它的泛化能力更好,更加不会过拟合。这也是剪枝的最基本的原理,总而言之就是把不重要的参数去掉。

2:Pruning in MLP(多层感知机)

在多层感知机中,剪枝也就是减去不重要的权重,也就是近似为0的权重。

拿到最初的权重矩阵之后,在生成一个叫掩码的矩阵,也就是说如果原来的权重比较接近于0,我们就把它的掩码置为0,最后在通过原来的权重矩阵乘以掩码矩阵就可以得到新的矩阵。新的参数矩阵对应的就是上面这个连接图,没有连的就相当于被置0了。

2.2 How to make mask

numpy里面的这个函数相当方便,percentile:一组n个观测值从小到大排序,处于p%位置的值称第p百分位数。

也就是说通过np.abs()求完绝对值后,在通过np.percentile(,50)减去50%没必要的权重,后面得到的0.6意思是小于0.6的权重将被剪掉,被置为0.

3.Pruning in CNN(卷积神经网络)

中间是4个卷积核,左边是输入的特征图,右边是输出的特征图,输入的特征图对每个卷积核都进行一个卷积,中间黑色的部分是我们观察到这个卷积核的参数特别的小,置为0之后将会对output产生影响,也就是有1/4的部分都为0.和上面一样也需要设置一个mask,然后去计算每个卷积核的L2范数,如果小的话直接去掉,去掉的话就是直接乘以mask

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/繁依Fanyi0/article/detail/744430

推荐阅读

相关标签