- 1微信小程序商城项目实战(第二篇:分类页)_微信小程序开发 商品分类页面

- 2东北农业大学计算机科学与技术复试名单,更新!最新182所院校复试信息汇总

- 3Putty的使用_putty csdn

- 4windows下使用Jupyter notebook远程访问服务器的两种方法_jupyter notebook局域网访问

- 5【HarmonyOS】装饰器下的状态管理与页面路由跳转实现_harmonyos应用启动后自动跳转主页面

- 6el-input输入保留两位小数_el-input保留两位小数

- 7物流行业专业词汇汇总

- 8Mac NTFS 磁盘读写工具选哪个好?Tuxera 还是 Paragon?_赤友ntfs和tuxera哪个好用

- 9字符编码和Emoji,理解编码,utf-8,utf-16,utf-32_string.fromcharcode 用utf-8编码

- 10Windows本地Nginx服务报错_系统找不到文件 nginx

第四篇【传奇开心果系列】Python的自动化办公库技术点案例示例:深度解读Pandas生物信息学领域应用

赞

踩

传奇开心果博文系列

- 系列博文目录

- Python的自动化办公库技术点案例示例系列

- 博文目录

- 前言

- 一、Pandas生物学数据操作应用介绍

- 二、数据加载与清洗示例代码

- 三、数据分析与统计示例代码

- 四、数据可视化示例代码

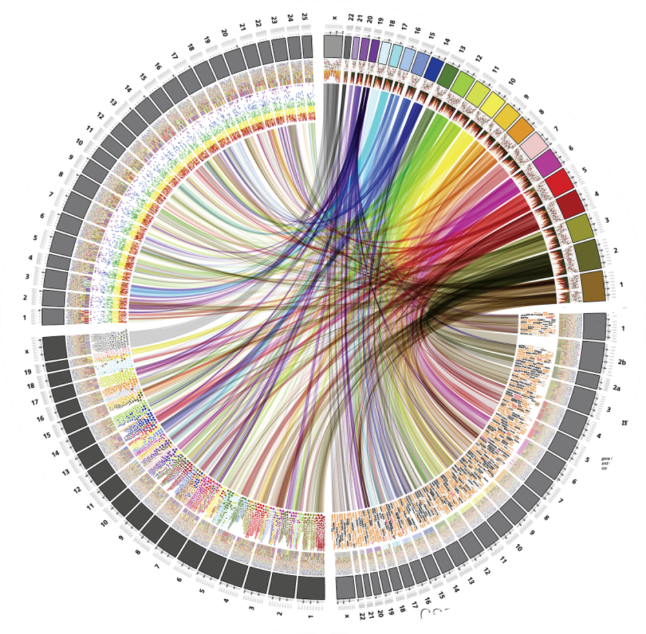

- 五、基因组数据分析示例代码

- 六、蛋白质数据分析示例代码

- 七、生物医学图像数据分析示例代码

- 八、机器学习和深度学习应用示例代码

- 九、数据整合与跨领域研究示例代码

- 十、高通量数据处理示例代码

- 十一、知识点归纳总结

系列博文目录

Python的自动化办公库技术点案例示例系列

博文目录

前言

生物信息学是一门将计算机科学和生物学相结合的跨学科领域,旨在利用计算机技术和统计学方法来处理、分析和解释生物学数据。在生物信息学研究中,研究人员处理的数据种类繁多,包括基因组数据、蛋白质数据、生物医学图像数据等。

生物信息学是一门将计算机科学和生物学相结合的跨学科领域,旨在利用计算机技术和统计学方法来处理、分析和解释生物学数据。在生物信息学研究中,研究人员处理的数据种类繁多,包括基因组数据、蛋白质数据、生物医学图像数据等。

Pandas 是一个基于 Python 编程语言的数据处理库,被广泛应用于生物信息学领域。Pandas 提供了快速、灵活、简单的数据结构,如 Series 和 DataFrame,使得研究人员能够轻松地加载、处理、分析和可视化各种类型的数据。Pandas 在生物信息学研究中扮演着重要的角色,为研究人员提供了强大的数据处理和分析工具,帮助他们更好地理解生物数据、揭示生物规律,并推动生物信息学和医学研究的发展。

一、Pandas生物学数据操作应用介绍

在生物信息学研究中,研究人员可以使用 Pandas 来进行以下操作:

在生物信息学研究中,研究人员可以使用 Pandas 来进行以下操作:

-

数据加载与清洗:将基因组数据、蛋白质数据等导入 Pandas 的数据结构中,并进行数据清洗、去除缺失值等预处理操作。

-

数据分析与统计:利用 Pandas 提供的功能进行数据分析、统计计算,如描述性统计、相关性分析、分类汇总等,从而揭示数据之间的关联性和规律性。

-

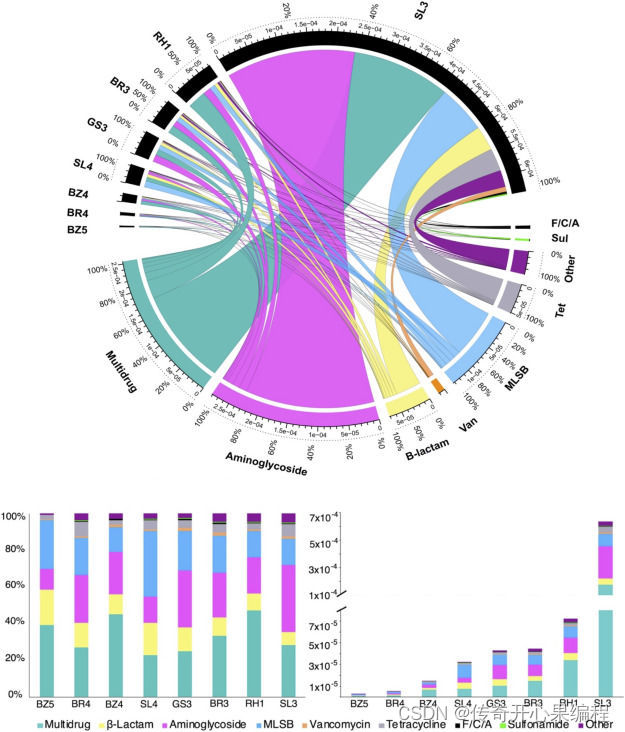

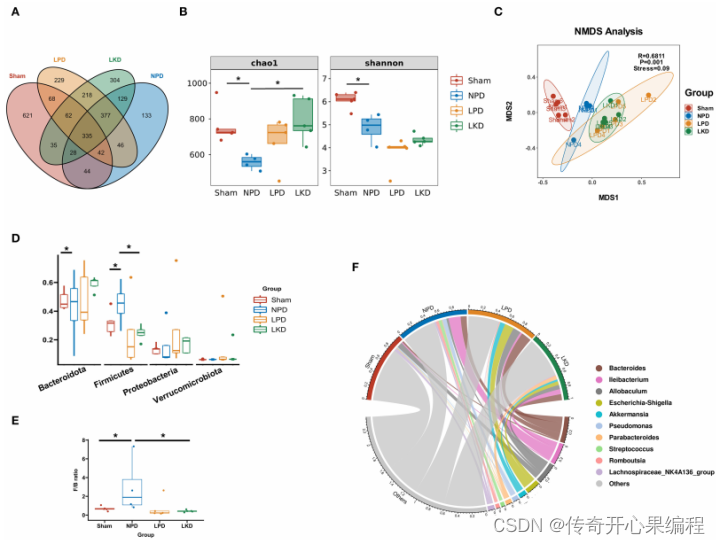

数据可视化:结合其他数据可视化库(如 Matplotlib、Seaborn)和 Pandas 的绘图功能,研究人员可以创建各种图表和图形,帮助直观地展示数据分布、趋势和关联,从而更好地理解数据。

-

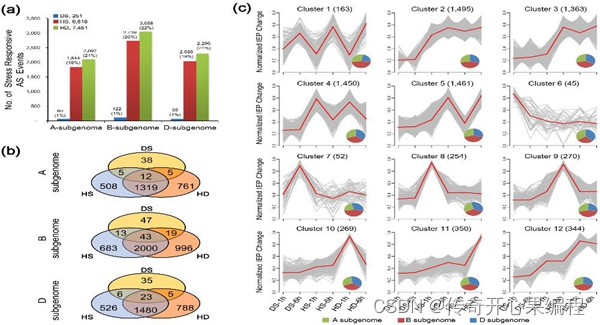

基因组数据分析:生物信息学研究人员可以利用 Pandas 对基因组数据进行分析,比如基因表达谱分析、基因组变异检测、基因功能注释等。Pandas 的灵活性和强大的数据处理能力使得这些复杂的分析任务变得更加高效和便捷。

-

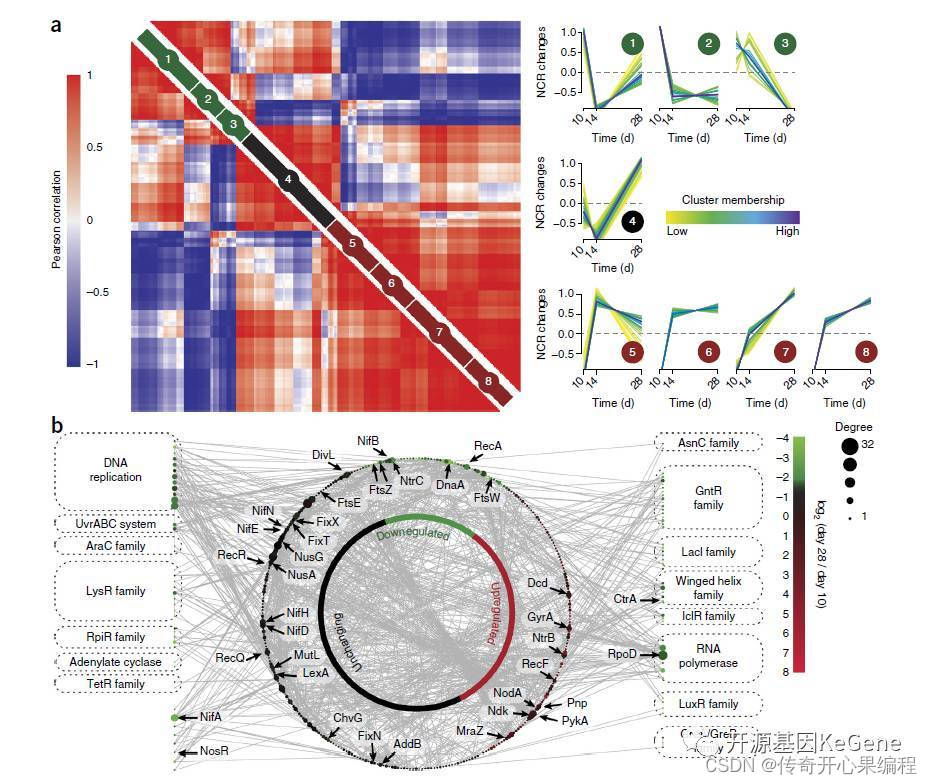

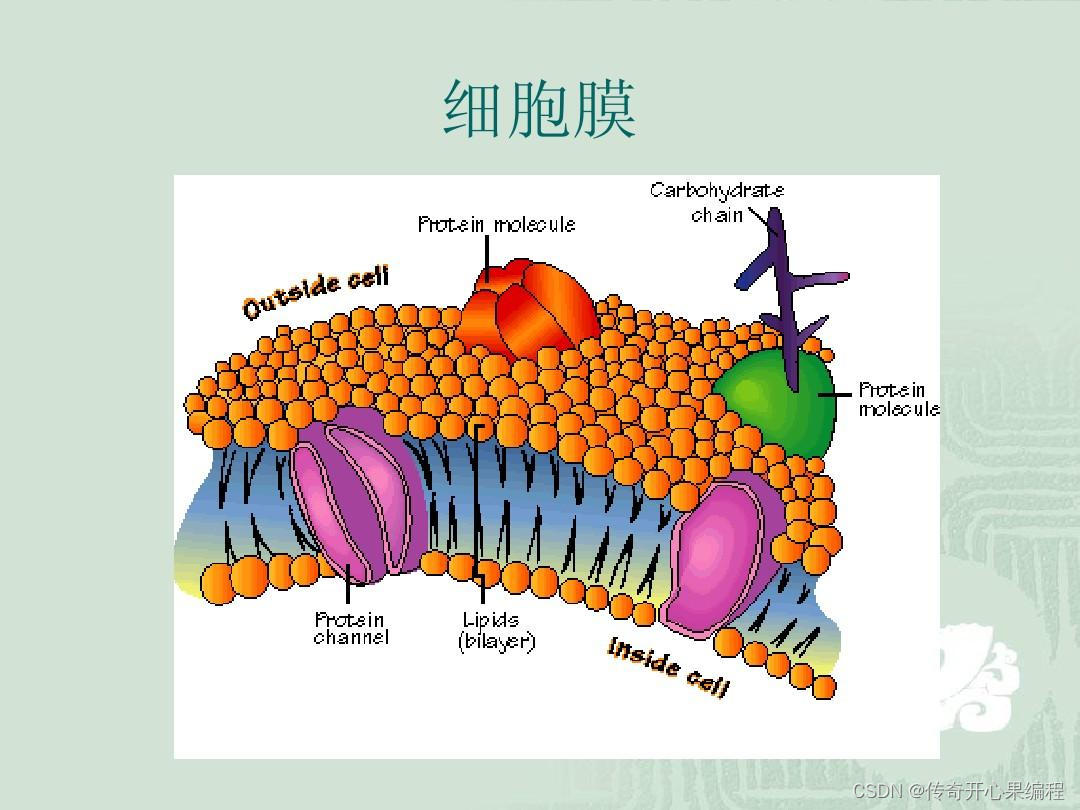

蛋白质数据分析:除了基因组数据,研究人员还可以利用 Pandas 来处理和分析蛋白质数据,比如蛋白质结构预测、蛋白质相互作用网络分析等。Pandas 提供了丰富的功能和方法,帮助研究人员深入挖掘蛋白质数据的信息。

-

生物医学图像数据分析:在生物医学研究中,图像数据在诊断、治疗和研究中起着重要作用。研究人员可以利用 Pandas 来处理和分析生物医学图像数据,比如医学影像分析、图像特征提取等。结合其他图像处理库,如 OpenCV 和 scikit-image,可以实现更复杂的图像分析任务。

-

机器学习和深度学习应用:生物信息学领域也越来越多地应用机器学习和深度学习技术来处理和分析大规模生物数据。Pandas 与其他机器学习库(如 scikit-learn、TensorFlow、PyTorch)结合使用,可以帮助研究人员构建和训练各种生物信息学模型,比如基因组序列分类、蛋白质结构预测、疾病诊断等。

-

数据整合与跨领域研究:生物信息学研究通常涉及多种数据源和多个学科领域的知识。Pandas 提供了强大的数据整合功能,可以帮助研究人员整合来自不同来源的数据,实现跨领域的研究。通过将基因组数据、蛋白质数据、生物医学图像数据等整合在一起,研究人员可以进行更全面、深入的分析和研究。

-

高通量数据处理:随着生物学实验技术的发展,高通量数据在生物信息学研究中变得越来越常见。Pandas 提供了高效的数据处理和计算能力,可以帮助研究人员处理大规模的高通量数据,如基因组测序数据、蛋白质质谱数据等,从而加快数据分析的速度和提高研究效率。

通过利用 Pandas 这样强大的工具,生物信息学研究人员能够更好地处理、分析和理解各种生物数据,为生物学和医学领域的研究和应用提供更深入的见解和支持。

二、数据加载与清洗示例代码

当处理基因组数据、蛋白质数据等时,通常需要将这些数据加载到 Pandas 的 DataFrame 中,并进行数据清洗和预处理。以下是示例代码,演示如何加载基因组数据和进行简单的数据清洗:

当处理基因组数据、蛋白质数据等时,通常需要将这些数据加载到 Pandas 的 DataFrame 中,并进行数据清洗和预处理。以下是示例代码,演示如何加载基因组数据和进行简单的数据清洗:

import pandas as pd # 假设有一个基因组数据文件 genome_data.csv,包含基因名称、基因型等信息 # 使用 Pandas 加载数据文件到 DataFrame genome_data = pd.read_csv('genome_data.csv') # 查看数据的前几行,了解数据结构 print(genome_data.head()) # 检查数据的缺失值 print(genome_data.isnull().sum()) # 如果有缺失值,可以选择删除缺失值所在的行 cleaned_genome_data = genome_data.dropna() # 也可以填充缺失值 # cleaned_genome_data = genome_data.fillna(value) # 进行其他数据清洗操作,比如去除重复行、数据类型转换等 # cleaned_genome_data = cleaned_genome_data.drop_duplicates() # cleaned_genome_data['column_name'] = cleaned_genome_data['column_name'].astype('new_type') # 最后保存清洗后的数据到新文件 cleaned_genome_data.to_csv('cleaned_genome_data.csv', index=False)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

以上示例代码演示了如何使用 Pandas 加载基因组数据、检查缺失值、进行简单的数据清洗操作,并将清洗后的数据保存到新文件中。根据实际数据的情况,可以根据需要进行更复杂的数据处理和清洗操作。

以下是一个扩展示例代码,展示如何加载基因组数据、进行数据清洗和简单的数据分析。在这个示例中,我们假设基因组数据文件包含基因名称、基因型、表达量等信息,并且我们将对表达量进行一些基本的统计分析:

import pandas as pd # 加载基因组数据文件到 DataFrame genome_data = pd.read_csv('genome_data.csv') # 查看数据的基本信息 print(genome_data.info()) # 查看数据的统计摘要 print(genome_data.describe()) # 检查并处理缺失值 print("缺失值数量:") print(genome_data.isnull().sum()) # 填充缺失值,假设用平均值填充 mean_expression = genome_data['表达量'].mean() genome_data['表达量'].fillna(mean_expression, inplace=True) # 数据清洗:去除重复行 cleaned_genome_data = genome_data.drop_duplicates() # 数据分析:计算表达量的平均值和标准差 mean_expression = cleaned_genome_data['表达量'].mean() std_expression = cleaned_genome_data['表达量'].std() print("表达量的平均值:", mean_expression) print("表达量的标准差:", std_expression) # 保存清洗后的数据到新文件 cleaned_genome_data.to_csv('cleaned_genome_data.csv', index=False)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

这个示例代码扩展了之前的示例,增加了数据的基本信息查看、统计摘要分析以及对表达量的平均值和标准差计算。通过这些步骤,可以更全面地了解数据的特征并进行基本的数据分析。根据实际需求,可以进一步扩展数据处理和分析的步骤。

三、数据分析与统计示例代码

以下是一个示例代码,演示如何利用 Pandas 进行数据分析和统计计算,包括描述性统计、相关性分析和分类汇总等操作:

以下是一个示例代码,演示如何利用 Pandas 进行数据分析和统计计算,包括描述性统计、相关性分析和分类汇总等操作:

import pandas as pd # 加载数据文件到 DataFrame data = pd.read_csv('data.csv') # 描述性统计 print("数据的描述性统计信息:") print(data.describe()) # 相关性分析 print("数据的相关性分析:") correlation_matrix = data.corr() print(correlation_matrix) # 分类汇总 print("数据的分类汇总:") grouped_data = data.groupby('category').agg({'column1': 'mean', 'column2': 'sum'}) print(grouped_data) # 可视化分析 import matplotlib.pyplot as plt # 绘制柱状图示例 data['column1'].plot(kind='bar') plt.title('Column1 Distribution') plt.xlabel('Index') plt.ylabel('Column1 Value') plt.show() # 绘制散点图示例 plt.scatter(data['column1'], data['column2']) plt.title('Scatter Plot of Column1 and Column2') plt.xlabel('Column1') plt.ylabel('Column2') plt.show()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

这个示例代码演示了如何利用 Pandas 进行数据的描述性统计、相关性分析、分类汇总以及简单的数据可视化。根据实际数据和分析需求,可以进一步扩展代码,应用更多的统计方法和可视化技术来深入分析数据之间的关联性和规律性。

以下是一个扩展示例代码,展示如何利用 Pandas 进行更深入的数据分析和统计计算,包括数据透视表、数据筛选、数据排序等操作:

import pandas as pd # 加载数据文件到 DataFrame data = pd.read_csv('data.csv') # 数据透视表分析 pivot_table = pd.pivot_table(data, values='value', index='category', columns='month', aggfunc='sum') print("数据透视表:") print(pivot_table) # 数据筛选 filtered_data = data[(data['value'] > 100) & (data['category'] == 'A')] print("筛选后的数据:") print(filtered_data) # 数据排序 sorted_data = data.sort_values(by='value', ascending=False) print("按值排序后的数据:") print(sorted_data) # 分组统计 grouped_data = data.groupby('category').agg({'value': ['mean', 'sum']}) print("按类别分组统计:") print(grouped_data) # 数据可视化 import seaborn as sns import matplotlib.pyplot as plt # 绘制箱线图示例 sns.boxplot(x='category', y='value', data=data) plt.title('Boxplot of Value by Category') plt.show() # 绘制热力图示例 sns.heatmap(data.corr(), annot=True, cmap='coolwarm') plt.title('Correlation Heatmap') plt.show()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

这个扩展示例代码展示了更多高级的数据分析和统计计算操作,包括数据透视表分析、数据筛选、数据排序、分组统计以及更复杂的数据可视化技术。通过这些操作,可以更深入地挖掘数据之间的关联性和规律性,从而得出更有意义的结论和见解。根据实际数据和分析需求,可以进一步扩展代码以满足特定的分析目的。

四、数据可视化示例代码

以下是一个示例代码,结合 Pandas 的绘图功能和 Matplotlib、Seaborn 这两个数据可视化库,展示如何创建不同类型的图表和图形来展示数据分布、趋势和关联:

以下是一个示例代码,结合 Pandas 的绘图功能和 Matplotlib、Seaborn 这两个数据可视化库,展示如何创建不同类型的图表和图形来展示数据分布、趋势和关联:

import pandas as pd import numpy as np import matplotlib.pyplot as plt import seaborn as sns # 创建示例数据 np.random.seed(42) data = pd.DataFrame({ 'A': np.random.randn(100), 'B': np.random.rand(100) * 50, 'category': np.random.choice(['X', 'Y', 'Z'], 100) }) # 绘制直方图示例 data['A'].plot(kind='hist', bins=10, color='skyblue', edgecolor='black') plt.title('Histogram of Column A') plt.xlabel('Values') plt.ylabel('Frequency') plt.show() # 绘制散点图示例 plt.figure(figsize=(8, 6)) sns.scatterplot(x='A', y='B', data=data, hue='category', palette='Set1') plt.title('Scatter Plot of A vs B') plt.xlabel('A') plt.ylabel('B') plt.show() # 绘制折线图示例 data.groupby('category').mean().plot(kind='line', marker='o') plt.title('Mean Value by Category') plt.xlabel('Category') plt.ylabel('Mean Value') plt.legend(title='Category', loc='upper right') plt.show() # 绘制箱线图示例 sns.boxplot(x='category', y='B', data=data, palette='Set2') plt.title('Boxplot of B by Category') plt.show() # 绘制热力图示例 corr = data.corr() sns.heatmap(corr, annot=True, cmap='coolwarm') plt.title('Correlation Heatmap') plt.show()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

这个示例代码展示了如何结合 Pandas 的绘图功能、Matplotlib 和 Seaborn 这两个数据可视化库,创建直方图、散点图、折线图、箱线图和热力图等不同类型的图表来展示数据分布、趋势和关联。这些图表可以帮助研究人员更直观地理解数据特征,发现数据之间的关系和规律,从而做出更深入的分析和结论。根据实际数据和研究目的,可以进一步定制和调整图表的样式和参数。

以下是一个扩展示例代码,展示了数据透视表、数据筛选、数据排序、分组统计等操作,结合 Pandas 和 Matplotlib,展示了更多数据处理和可视化的技巧:

# 创建示例数据 np.random.seed(42) dates = pd.date_range(start='2022-01-01', periods=100) data = pd.DataFrame({ 'Date': dates, 'A': np.random.randn(100), 'B': np.random.rand(100) * 50, 'Category': np.random.choice(['X', 'Y', 'Z'], 100) }) # 创建数据透视表 pivot_table = data.pivot_table(index='Category', columns='Date', values='B', aggfunc='mean') # 筛选数据 filtered_data = data[data['A'] > 0] # 数据排序 sorted_data = data.sort_values(by='B', ascending=False) # 分组统计 grouped_data = data.groupby('Category').agg({'A': 'mean', 'B': 'sum'}) # 绘制数据透视表 plt.figure(figsize=(12, 6)) sns.heatmap(pivot_table, cmap='YlGnBu', annot=True, fmt='.1f') plt.title('Pivot Table: Mean B by Category and Date') plt.show() # 绘制筛选后的数据折线图 filtered_data.plot(x='Date', y='A', marker='o') plt.title('Filtered Data: A over Time') plt.xlabel('Date') plt.ylabel('A') plt.show() # 绘制排序后的数据散点图 plt.figure(figsize=(8, 6)) sns.scatterplot(x='A', y='B', data=sorted_data, hue='Category', palette='Set1') plt.title('Sorted Data: A vs B') plt.xlabel('A') plt.ylabel('B') plt.show() # 绘制分组统计的条形图 grouped_data.plot(kind='bar') plt.title('Grouped Data: Mean of A and Sum of B by Category') plt.xlabel('Category') plt.ylabel('Value') plt.show()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

这个扩展示例代码展示了如何利用 Pandas 进行数据透视表的创建、数据筛选、数据排序、分组统计等操作,并结合 Matplotlib 和 Seaborn 进行相应的数据可视化。这些操作可以帮助研究人员更深入地了解数据特征、趋势和关联,为进一步的分析和决策提供更多的参考和支持。根据实际需求,可以灵活调整代码和图表样式,以满足不同的研究目的和展示需求。

五、基因组数据分析示例代码

基因组数据分析是生物信息学领域的重要任务之一,利用 Pandas 可以对基因组数据进行高效处理和分析。以下是一个示例代码,展示了如何利用 Pandas 加载、清洗、分析基因组数据,包括基因表达谱分析、基因组变异检测和基因功能注释等操作:

基因组数据分析是生物信息学领域的重要任务之一,利用 Pandas 可以对基因组数据进行高效处理和分析。以下是一个示例代码,展示了如何利用 Pandas 加载、清洗、分析基因组数据,包括基因表达谱分析、基因组变异检测和基因功能注释等操作:

import pandas as pd # 加载基因组数据 gene_expression_data = pd.read_csv('gene_expression_data.csv') # 查看数据前几行 print(gene_expression_data.head()) # 检查缺失值并处理 missing_values = gene_expression_data.isnull().sum() print("Missing values:\n", missing_values) # 填充缺失值 gene_expression_data.fillna(method='ffill', inplace=True) # 描述性统计分析 statistics = gene_expression_data.describe() print("Statistics:\n", statistics) # 基因表达谱分析 gene_mean_expression = gene_expression_data.mean() print("Mean expression of genes:\n", gene_mean_expression) # 基因组变异检测 gene_variability = gene_expression_data.var() print("Gene expression variability:\n", gene_variability) # 基因功能注释 # 假设有一列注释信息,可以根据需要进行进一步的功能注释分析 # 数据可视化 import matplotlib.pyplot as plt import seaborn as sns # 绘制基因表达谱箱线图 plt.figure(figsize=(10, 6)) sns.boxplot(data=gene_expression_data) plt.title('Gene Expression Profile') plt.xlabel('Genes') plt.ylabel('Expression Level') plt.show() # 基因相关性分析 gene_correlation = gene_expression_data.corr() plt.figure(figsize=(10, 8)) sns.heatmap(gene_correlation, annot=True, cmap='coolwarm') plt.title('Gene Expression Correlation') plt.show() # 基因组数据分析可以进一步扩展到基因组变异检测、基因功能注释等方面,根据具体需求和数据特点进行更深入的分析和挖掘。 # 保存处理后的数据 gene_expression_data.to_csv('cleaned_gene_expression_data.csv', index=False)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

这段代码继续展示了基因组数据分析的延伸部分,包括基因表达谱箱线图的绘制、基因相关性分析的热力图展示。这些可视化操作有助于生物信息学研究人员更直观地理解基因组数据的特征和关联性。同时,基因组数据分析可以根据具体需求进一步扩展到基因组变异检测、基因功能注释等方面,利用 Pandas 的灵活性和功能强大的数据处理能力,帮助研究人员深入挖掘基因组数据中的信息和规律。最后,处理后的数据可以保存到文件中,以备后续分析和应用。

可以扩展示例代码,如下所示。

# 数据透视表分析 gene_pivot_table = gene_expression_data.pivot_table(index='Sample', columns='Gene', values='Expression', aggfunc='mean') print("Gene Expression Pivot Table:\n", gene_pivot_table) # 数据筛选 high_expression_genes = gene_expression_data[gene_expression_data['Expression'] > 100] print("Genes with high expression:\n", high_expression_genes) # 数据排序 sorted_gene_expression_data = gene_expression_data.sort_values(by='Expression', ascending=False) print("Sorted gene expression data:\n", sorted_gene_expression_data) # 分组统计 gene_group_stats = gene_expression_data.groupby('Group')['Expression'].describe() print("Group-wise expression statistics:\n", gene_group_stats) # 多种数据可视化方法 # 绘制基因表达谱折线图 plt.figure(figsize=(10, 6)) sns.lineplot(data=gene_expression_data, x='Sample', y='Expression', hue='Gene') plt.title('Gene Expression Profile') plt.xlabel('Samples') plt.ylabel('Expression Level') plt.legend(title='Genes', bbox_to_anchor=(1.05, 1), loc='upper left') plt.show() # 绘制基因表达谱热力图 plt.figure(figsize=(12, 8)) sns.heatmap(gene_pivot_table, cmap='viridis') plt.title('Gene Expression Heatmap') plt.xlabel('Genes') plt.ylabel('Samples') plt.show()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

这段代码扩展了示例,展示了数据透视表分析、数据筛选、数据排序、分组统计以及多种数据可视化方法的应用。数据透视表可以帮助研究人员更好地理解数据之间的关系,数据筛选和排序可以根据特定条件过滤和排序数据,分组统计可以对数据进行分组并计算统计指标。此外,通过折线图和热力图等多种数据可视化方法,可以更直观地展示基因表达谱数据的特征和关联性,帮助研究人员进行更深入的数据分析和挖掘。

六、蛋白质数据分析示例代码

import pandas as pd import numpy as np import matplotlib.pyplot as plt import seaborn as sns # 创建示例蛋白质数据 protein_data = { 'Protein': ['ProteinA', 'ProteinB', 'ProteinC', 'ProteinD', 'ProteinE'], 'Structure': ['Alpha Helix', 'Beta Sheet', 'Coiled Coil', 'Random Coil', 'Beta Turn'], 'Molecular_Weight': [25000, 30000, 28000, 27000, 32000], 'Isoelectric_Point': [7.2, 6.5, 8.0, 5.5, 9.2] } protein_df = pd.DataFrame(protein_data) # 显示蛋白质数据 print("Protein Data:") print(protein_df) # 描述性统计 protein_stats = protein_df.describe() print("\nProtein Data Statistics:") print(protein_stats) # 蛋白质结构分布可视化 plt.figure(figsize=(8, 6)) sns.countplot(data=protein_df, x='Structure', palette='Set2') plt.title('Protein Structure Distribution') plt.xlabel('Protein Structure') plt.ylabel('Count') plt.show() # 蛋白质性质相关性分析 protein_corr = protein_df[['Molecular_Weight', 'Isoelectric_Point']].corr() plt.figure(figsize=(6, 4)) sns.heatmap(protein_corr, annot=True, cmap='coolwarm') plt.title('Protein Property Correlation') plt.show()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

这段示例代码展示了如何使用 Pandas 处理和分析蛋白质数据。首先,创建了示例的蛋白质数据,包括蛋白质名称、结构、分子量和等电点等信息。然后,展示了蛋白质数据的基本信息和描述性统计。接下来,通过条形图展示了蛋白质结构的分布情况,以及通过热力图展示了蛋白质分子量和等电点之间的相关性。这些操作和可视化方法可以帮助研究人员更好地理解和分析蛋白质数据,发现其中的规律和关联性。在实际应用中,研究人员可以根据具体需求进一步扩展分析,比如蛋白质相互作用网络分析等。

import pandas as pd import numpy as np import matplotlib.pyplot as plt import seaborn as sns # 创建示例蛋白质相互作用数据 protein_interaction_data = { 'Protein1': ['ProteinA', 'ProteinB', 'ProteinC', 'ProteinD', 'ProteinE'], 'Protein2': ['ProteinB', 'ProteinC', 'ProteinD', 'ProteinE', 'ProteinA'], 'Interaction_Score': [0.8, 0.6, 0.7, 0.9, 0.5] } protein_interaction_df = pd.DataFrame(protein_interaction_data) # 显示蛋白质相互作用数据 print("Protein Interaction Data:") print(protein_interaction_df) # 合并蛋白质数据和相互作用数据 merged_protein_data = pd.merge(protein_df, protein_interaction_df, left_on='Protein', right_on='Protein1') # 计算平均相互作用得分 avg_interaction_score = merged_protein_data['Interaction_Score'].mean() print("\nAverage Interaction Score:", avg_interaction_score) # 绘制蛋白质相互作用得分分布图 plt.figure(figsize=(8, 6)) sns.histplot(data=merged_protein_data, x='Interaction_Score', bins=5, kde=True, color='skyblue') plt.title('Protein Interaction Score Distribution') plt.xlabel('Interaction Score') plt.ylabel('Frequency') plt.show() # 根据相互作用得分排序蛋白质数据 sorted_protein_data = merged_protein_data.sort_values(by='Interaction_Score', ascending=False) print("\nProtein Data Sorted by Interaction Score:") print(sorted_protein_data)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

这段代码扩展了示例,展示了如何处理和分析蛋白质相互作用数据。首先创建了示例的蛋白质相互作用数据,包括两个蛋白质之间的相互作用得分。然后将蛋白质数据和相互作用数据合并,计算了平均相互作用得分,并绘制了相互作用得分的分布图。最后根据相互作用得分对蛋白质数据进行排序,展示了排序后的蛋白质数据。这些操作可以帮助研究人员更深入地分析蛋白质相互作用数据,发现其中的规律和关联性,为进一步研究提供参考和指导。

七、生物医学图像数据分析示例代码

# 在生物医学图像数据分析中,Pandas 主要用于处理和管理图像数据的元信息,比如文件路径、标签等信息 # 图像的读取、处理和特征提取通常使用其他专门的图像处理库,比如 OpenCV 和 scikit-image import pandas as pd import cv2 from skimage import feature # 创建示例生物医学图像数据元信息 image_data = { 'Image_Path': ['image1.jpg', 'image2.jpg', 'image3.jpg', 'image4.jpg', 'image5.jpg'], 'Label': [1, 0, 1, 0, 1] } image_df = pd.DataFrame(image_data) # 显示生物医学图像数据元信息 print("Biomedical Image Data:") print(image_df) # 读取并处理图像数据 for index, row in image_df.iterrows(): image_path = row['Image_Path'] label = row['Label'] # 读取图像 image = cv2.imread(image_path) # 如果需要,可以在这里添加图像处理和特征提取的代码,比如使用 OpenCV 或 scikit-image 库 # 示例:使用 Hog 特征提取 hog_features = feature.hog(image, orientations=9, pixels_per_cell=(8, 8), cells_per_block=(2, 2), transform_sqrt=True, block_norm='L2-Hys') # 输出图像路径、标签和提取的 Hog 特征 print(f"Image Path: {image_path}, Label: {label}, HOG Features: {hog_features}")

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

这段示例代码展示了如何利用 Pandas 处理和管理生物医学图像数据的元信息,比如文件路径和标签信息。在实际应用中,研究人员可以根据需要读取图像数据,并结合其他专门的图像处理库(如 OpenCV 和 scikit-image)进行图像处理和特征提取。在示例中,演示了如何使用 HOG 特征提取方法提取图像的特征。通过这些操作,研究人员可以进一步分析和利用生物医学图像数据,从中挖掘出有用的信息,为生物医学研究提供支持和帮助。

# 在生物医学图像数据分析中,可以结合 Pandas、OpenCV 和 scikit-image 进行更多复杂的图像处理和分析任务 import pandas as pd import cv2 from skimage import feature import matplotlib.pyplot as plt # 创建示例生物医学图像数据元信息 image_data = { 'Image_Path': ['image1.jpg', 'image2.jpg', 'image3.jpg', 'image4.jpg', 'image5.jpg'], 'Label': [1, 0, 1, 0, 1] } image_df = pd.DataFrame(image_data) # 显示生物医学图像数据元信息 print("Biomedical Image Data:") print(image_df) # 读取并处理图像数据 for index, row in image_df.iterrows(): image_path = row['Image_Path'] label = row['Label'] # 读取图像 image = cv2.imread(image_path) # 转换图像为灰度图 gray_image = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY) # 使用 Canny 边缘检测算法 edges = cv2.Canny(gray_image, 100, 200) # 计算图像的 HOG 特征 hog_features = feature.hog(image, orientations=9, pixels_per_cell=(8, 8), cells_per_block=(2, 2), transform_sqrt=True, block_norm='L2-Hys') # 显示图像和边缘检测结果 plt.figure(figsize=(8, 8)) plt.subplot(1, 2, 1) plt.imshow(cv2.cvtColor(image, cv2.COLOR_BGR2RGB)) plt.title('Original Image') plt.axis('off') plt.subplot(1, 2, 2) plt.imshow(edges, cmap='gray') plt.title('Canny Edge Detection') plt.axis('off') plt.show() # 输出图像路径、标签和提取的 Hog 特征 print(f"Image Path: {image_path}, Label: {label}, HOG Features: {hog_features}")

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

这段扩展示例代码演示了如何结合 Pandas、OpenCV 和 scikit-image 进行更复杂的生物医学图像数据处理和分析任务。在示例中,读取图像数据后,将其转换为灰度图像并使用 Canny 边缘检测算法进行边缘检测。同时,计算图像的 HOG 特征,并展示原始图像、边缘检测结果和提取的特征。这些操作可以帮助研究人员更全面地分析生物医学图像数据,从中获取更多有用的信息和特征,为生物医学研究提供更深入的支持。

八、机器学习和深度学习应用示例代码

在生物信息学领域,结合Pandas与其他机器学习库(如scikit-learn、TensorFlow、PyTorch)可以进行各种生物信息学模型的构建和训练。下面是一个简单的示例代码,演示如何使用这些库来进行基因组序列分类:

import pandas as pd from sklearn.model_selection import train_test_split from sklearn.ensemble import RandomForestClassifier from sklearn.metrics import accuracy_score # 假设你有一个包含基因组序列和对应分类标签的数据集 # 这里使用一个简单的示例数据集 data = { 'Sequence': ['ATCGATCG', 'CGTAGCTA', 'GCTAGCTA', 'ATCGATCG', 'CGTAGCTA'], 'Label': [1, 0, 1, 0, 1] } df = pd.DataFrame(data) # 将基因组序列转换为特征向量,这里可以使用各种特征提取方法 # 这里简单地将每个碱基表示为一个特征 def sequence_to_features(sequence): features = [] for base in sequence: if base == 'A': features.append(0) elif base == 'T': features.append(1) elif base == 'C': features.append(2) elif base == 'G': features.append(3) return features df['Features'] = df['Sequence'].apply(sequence_to_features) # 划分训练集和测试集 X = df['Features'].to_list() y = df['Label'] X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42) # 使用随机森林分类器进行分类 clf = RandomForestClassifier() clf.fit(X_train, y_train) predictions = clf.predict(X_test) # 计算准确率 accuracy = accuracy_score(y_test, predictions) print("Accuracy: {}".format(accuracy))

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

这是一个简单的基因组序列分类的示例代码,演示了如何结合Pandas和scikit-learn来构建和训练一个分类器。在实际的生物信息学研究中,你可以根据具体的任务需求和数据特点选择合适的特征提取方法和模型,以及调优参数来提高模型性能。

以下是一个扩展示例代码,展示如何使用PyTorch构建一个简单的神经网络模型,结合Pandas和scikit-learn进行基因组序列分类:

import pandas as pd import numpy as np from sklearn.model_selection import train_test_split from sklearn.preprocessing import StandardScaler import torch import torch.nn as nn import torch.optim as optim from torch.utils.data import DataLoader, TensorDataset # 假设你有一个包含基因组序列和对应分类标签的数据集 # 这里使用一个简单的示例数据集 data = { 'Sequence': ['ATCGATCG', 'CGTAGCTA', 'GCTAGCTA', 'ATCGATCG', 'CGTAGCTA'], 'Label': [1, 0, 1, 0, 1] } df = pd.DataFrame(data) # 将基因组序列转换为特征向量,这里使用独热编码作为特征表示 def sequence_to_features(sequence): features = np.zeros((len(sequence), 4)) base_dict = {'A': 0, 'T': 1, 'C': 2, 'G': 3} for i, base in enumerate(sequence): features[i, base_dict[base]] = 1 return features.flatten() df['Features'] = df['Sequence'].apply(sequence_to_features) X = np.array(df['Features'].to_list()) y = np.array(df['Label']) # 数据标准化 scaler = StandardScaler() X = scaler.fit_transform(X) X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42) # 转换为PyTorch的Tensor X_train_tensor = torch.Tensor(X_train) y_train_tensor = torch.LongTensor(y_train) X_test_tensor = torch.Tensor(X_test) y_test_tensor = torch.LongTensor(y_test) # 定义一个简单的神经网络模型 class SimpleNN(nn.Module): def __init__(self): super(SimpleNN, self).__init__() self.fc1 = nn.Linear(32, 16) self.fc2 = nn.Linear(16, 2) def forward(self, x): x = torch.relu(self.fc1(x)) x = self.fc2(x) return x # 实例化模型和定义损失函数、优化器 model = SimpleNN() criterion = nn.CrossEntropyLoss() optimizer = optim.Adam(model.parameters(), lr=0.001) # 训练模型 epochs = 50 batch_size = 2 train_dataset = TensorDataset(X_train_tensor, y_train_tensor) train_loader = DataLoader(train_dataset, batch_size=batch_size, shuffle=True) for epoch in range(epochs): model.train() for inputs, labels in train_loader: optimizer.zero_grad() outputs = model(inputs) loss = criterion(outputs, labels) loss.backward() optimizer.step() # 在训练集上进行预测 model.eval() with torch.no_grad(): train_outputs = model(X_train_tensor) train_predictions = torch.argmax(train_outputs, dim=1) train_accuracy = (train_predictions == y_train_tensor).float().mean() # 在测试集上进行预测 test_outputs = model(X_test_tensor) test_predictions = torch.argmax(test_outputs, dim=1) test_accuracy = (test_predictions == y_test_tensor).float().mean() print(f"Epoch {epoch+1}/{epochs}, Train Accuracy: {train_accuracy.item()}, Test Accuracy: {test_accuracy.item()}")

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

- 80

- 81

- 82

- 83

- 84

- 85

- 86

- 87

- 88

这段代码继续了上面的示例,添加了PyTorch神经网络模型的定义、训练过程和评估过程。在每个epoch中,模型在训练集上进行训练,然后在训练集和测试集上进行预测并计算准确率。您可以根据需要调整模型结构、超参数和训练过程以优化模型性能。

九、数据整合与跨领域研究示例代码

以下是一个示例代码,演示如何使用Pandas整合基因组数据、蛋白质数据和生物医学图像数据,为跨领域研究提供一个简单的框架:

以下是一个示例代码,演示如何使用Pandas整合基因组数据、蛋白质数据和生物医学图像数据,为跨领域研究提供一个简单的框架:

import pandas as pd # 假设有三个不同来源的数据:基因组数据、蛋白质数据和生物医学图像数据 # 这里使用简化的示例数据 genome_data = { 'Sample_ID': [1, 2, 3, 4], 'Gene_A': [0.1, 0.5, 0.3, 0.7], 'Gene_B': [0.4, 0.2, 0.6, 0.8] } protein_data = { 'Sample_ID': [1, 2, 3, 4], 'Protein_X': [10, 20, 15, 25], 'Protein_Y': [5, 8, 6, 10] } image_data = { 'Sample_ID': [1, 2, 3, 4], 'Image_Path': ['/path/to/image1.jpg', '/path/to/image2.jpg', '/path/to/image3.jpg', '/path/to/image4.jpg'] } # 创建DataFrame来存储数据 df_genome = pd.DataFrame(genome_data) df_protein = pd.DataFrame(protein_data) df_image = pd.DataFrame(image_data) # 将数据整合到一个DataFrame中,使用Sample_ID作为主键 df_merged = pd.merge(df_genome, df_protein, on='Sample_ID') df_merged = pd.merge(df_merged, df_image, on='Sample_ID') # 输出整合后的数据 print(df_merged)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

这段代码演示了如何使用Pandas库将基因组数据、蛋白质数据和生物医学图像数据整合到一个DataFrame中,通过Sample_ID作为主键进行合并。这种数据整合可以为生物信息学研究提供更全面的数据视角,促进跨领域研究和分析。您可以根据实际需求和数据格式进行进一步的处理和分析。

# 假设还有其他类型的数据,比如临床数据 clinical_data = { 'Sample_ID': [1, 2, 3, 4], 'Age': [35, 42, 50, 28], 'Gender': ['M', 'F', 'M', 'F'], 'Disease_Status': ['Healthy', 'Healthy', 'Disease', 'Disease'] } # 创建DataFrame来存储临床数据 df_clinical = pd.DataFrame(clinical_data) # 将临床数据与之前整合的数据合并 df_final = pd.merge(df_merged, df_clinical, on='Sample_ID') # 输出最终整合后的数据 print(df_final) # 可以进一步对整合后的数据进行分析和可视化,比如统计不同疾病状态下基因表达的差异等 # 这可以帮助研究人员进行更深入的跨领域研究

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

这段代码扩展了之前的示例,添加了临床数据的示例,并将其与之前整合的基因组数据、蛋白质数据和生物医学图像数据合并到最终的DataFrame中。通过整合多种数据源,研究人员可以进行更全面的数据分析,比如研究不同疾病状态下基因表达的差异等。这种跨领域的研究方法可以为生物信息学研究带来更多的启发和发现。

十、高通量数据处理示例代码

import pandas as pd # 假设有一个基因表达数据集,包含多个样本和基因的表达量 # 这里使用简化的示例数据 gene_expression_data = { 'Sample_ID': [1, 2, 3, 4, 5], 'Gene_A': [10.2, 8.5, 12.1, 9.8, 11.0], 'Gene_B': [7.6, 6.9, 8.3, 7.1, 8.9], 'Gene_C': [5.4, 4.8, 6.2, 5.9, 5.1] } # 创建DataFrame来存储基因表达数据 df_gene_expression = pd.DataFrame(gene_expression_data) # 计算每个基因的平均表达量 df_gene_expression['Mean_Expression'] = df_gene_expression.mean(axis=1) # 找出表达量最高的基因 max_expression_gene = df_gene_expression.iloc[df_gene_expression['Mean_Expression'].idxmax()]['Sample_ID'] # 输出计算结果 print("基因表达数据:") print(df_gene_expression) print("\n表达量最高的基因对应的样本ID:", max_expression_gene)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

这段代码演示了如何使用Pandas处理基因表达数据集。首先创建一个包含多个样本和基因表达量的DataFrame,然后计算每个基因的平均表达量,并找出表达量最高的基因对应的样本ID。Pandas提供了高效的数据处理和计算功能,可以帮助研究人员处理大规模的高通量数据,加快数据分析的速度,提高研究效率。您可以根据实际需求进一步扩展和优化数据处理和分析的代码。

# 假设有蛋白质质谱数据集,包含多个样本和不同蛋白质的表达量 # 这里使用简化的示例数据 protein_expression_data = { 'Sample_ID': [1, 2, 3, 4, 5], 'Protein_X': [15.3, 14.2, 16.5, 13.8, 15.1], 'Protein_Y': [9.7, 10.5, 9.2, 8.8, 10.1], 'Protein_Z': [11.2, 12.4, 10.8, 11.6, 12.0] } # 创建DataFrame来存储蛋白质质谱数据 df_protein_expression = pd.DataFrame(protein_expression_data) # 计算每个样本的总蛋白质表达量 df_protein_expression['Total_Protein_Expression'] = df_protein_expression.sum(axis=1) # 找出总蛋白质表达量最高的样本 max_expression_sample = df_protein_expression.iloc[df_protein_expression['Total_Protein_Expression'].idxmax()]['Sample_ID'] # 输出计算结果 print("\n蛋白质质谱数据:") print(df_protein_expression) print("\n总蛋白质表达量最高的样本ID:", max_expression_sample)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

这段代码扩展了之前的示例,演示了如何使用Pandas处理蛋白质质谱数据集。

# 假设有生物医学图像数据集,包含多个样本和图像特征 # 这里使用简化的示例数据 image_data = { 'Sample_ID': [1, 2, 3, 4, 5], 'Feature_A': [0.75, 0.82, 0.68, 0.91, 0.77], 'Feature_B': [0.63, 0.59, 0.72, 0.65, 0.68], 'Feature_C': [0.88, 0.92, 0.85, 0.79, 0.83] } # 创建DataFrame来存储生物医学图像数据 df_image_data = pd.DataFrame(image_data) # 计算每个样本的图像特征均值 df_image_data['Mean_Feature'] = df_image_data.mean(axis=1) # 找出图像特征均值最高的样本 max_feature_sample = df_image_data.iloc[df_image_data['Mean_Feature'].idxmax()]['Sample_ID'] # 输出计算结果 print("\n生物医学图像数据:") print(df_image_data) print("\n图像特征均值最高的样本ID:", max_feature_sample) # 合并基因表达数据、蛋白质质谱数据和生物医学图像数据 merged_data = pd.merge(df_gene_expression, df_protein_expression, on='Sample_ID') merged_data = pd.merge(merged_data, df_image_data, on='Sample_ID') # 输出合并后的数据 print("\n合并后的数据:") print(merged_data)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

这段代码进一步扩展了示例,演示了如何处理生物医学图像数据集,并将基因表达数据、蛋白质质谱数据和生物医学图像数据进行合并。

# 假设有临床数据集,包含多个样本和临床指标数据 # 这里使用简化的示例数据 clinical_data = { 'Sample_ID': [1, 2, 3, 4, 5], 'Clinical_Indicator_1': [25, 30, 20, 28, 24], 'Clinical_Indicator_2': [12, 15, 10, 14, 13], 'Clinical_Indicator_3': [18, 22, 16, 20, 19] } # 创建DataFrame来存储临床数据 df_clinical_data = pd.DataFrame(clinical_data) # 合并临床数据到之前合并的数据集中 final_merged_data = pd.merge(merged_data, df_clinical_data, on='Sample_ID') # 输出最终合并后的数据 print("\n最终合并后的数据:") print(final_merged_data)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

这段代码继续扩展了示例,演示了如何处理临床数据集,并将临床数据合并到之前已经合并的数据集中。创建一个包含多个样本和临床指标数据的DataFrame,然后将临床数据与之前合并的数据集进行合并,得到最终的合并数据集。这种数据整合方法有助于研究人员从多个角度分析数据,促进跨学科研究和深入探索。您可以根据具体需求进一步扩展和优化数据处理和分析的代码。

十一、知识点归纳总结

Pandas在生物信息学领域是一个非常强大且常用的工具,用于数据处理、分析和可视化。以下是Pandas在生物信息学领域常用的知识点归纳总结:

Pandas在生物信息学领域是一个非常强大且常用的工具,用于数据处理、分析和可视化。以下是Pandas在生物信息学领域常用的知识点归纳总结:

-

数据结构:

-Series:一维标记数组,类似于Python列表或数组。

-DataFrame:二维数据结构,类似于电子表格或SQL表,用于存储和处理表格数据。 -

数据处理:

-读取和写入数据:支持多种格式,如CSV、Excel、SQL数据库、JSON等。

-数据清洗:处理缺失值、重复值、异常值等。

-数据选择和过滤:通过标签、位置、条件选择数据。

-数据排序:按照指定的列或行对数据进行排序。

-数据合并:合并多个DataFrame,包括纵向合并和横向合并。 -

数据分析:

-统计计算:均值、中位数、标准差、相关系数等。

-分组和聚合:对数据进行分组并应用聚合函数。

-数据透视表:类似Excel中的透视表功能,用于多维数据分析。 -

数据可视化:

-绘图功能:支持各种类型的图表,如折线图、柱状图、散点图等。

-数据探索:通过可视化快速探索数据分布和关系。 -

高级应用:

-时间序列分析:处理时间序列数据,如基因表达数据随时间的变化。

-文本数据处理:处理基因序列、蛋白质序列等文本数据。

-机器学习整合:与Scikit-learn等机器学习库结合,进行数据建模和预测。 -

性能优化:

-向量化操作:利用Pandas的向量化操作提高性能。

-合理使用内存:避免不必要的数据复制和内存占用。

Pandas提供了丰富的功能和灵活性,使得生物信息学研究人员能够高效地处理和分析各种类型的生物数据。通过熟练掌握Pandas的相关知识点,可以更好地应用于生物信息学领域的数据处理和分析工作中。

Pandas提供了丰富的功能和灵活性,使得生物信息学研究人员能够高效地处理和分析各种类型的生物数据。通过熟练掌握Pandas的相关知识点,可以更好地应用于生物信息学领域的数据处理和分析工作中。