- 1OpenHarmony关系型数据库[1]_import relationalstore from '@ohos.data.relational

- 2利用java继承机制创建Figure、CloseFigure、Line、Polygon、Triangle、Rectangle类、并通过throws进行违规数据的异常处理。_figure closedfigure 继承关系图

- 3C语言创建二叉树_二叉树创建c语言实现

- 4【图神经网络】图拉普拉斯滤波器如何实现全通、低通、高通滤波_拉普拉斯滤波效果

- 5【Git】常用指令整理

- 6无需GPU,一键搭建本地大语言模型(LLM)服务,提供 OpenAI 接口 | 附 C#/Python 代码_是不是所有的llm模型都是调用的openai接口

- 7Odoo 15开发手册第四章 模块继承_odoo继承后group

- 8JavaEE面试题

- 9移动端常见的开发布局方式_移动端布局

- 102 事务

哈工大刘挺:自然语言处理中的可解释性问题

赞

踩

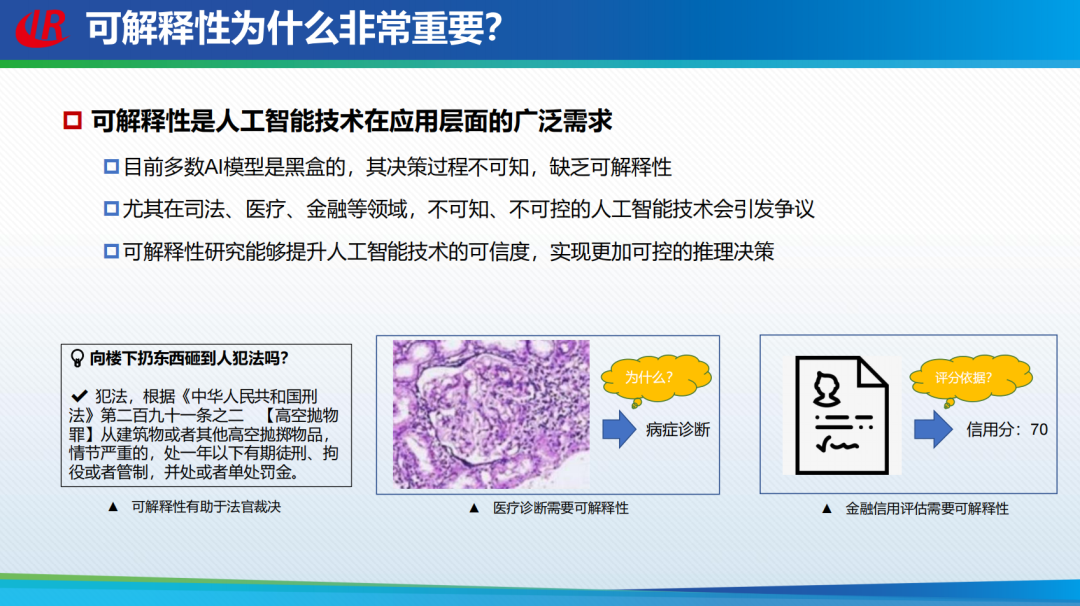

“知其然,亦知其所以然”是现代计算机科学家针对神经网络可解释性问题追逐努力的方向和梦想。针对自然语言处理中的可解释性问题,哈尔滨工业大学刘挺教授在近期的报告中做了详尽的解读。首先介绍了自然语言处理中的可解释性概念,分类及研究可解释性的必要性,重点介绍了可解释自然语言处理中的三种方法,包括白盒透明模型的设计、黑盒事后解释方法以及灰盒融合可解释要素方法。最后,刘挺教授提出了可解释性的白盒模型设计以及可解释性评估等未来发展的挑战和研究方向。(注:本文由第三方整理,未经本人审阅)

刘挺,哈尔滨工业大学教授,哈工大计算学部主任兼计算机学院院长、自然语言处理研究所所长

国家“万人计划”科技创新领军人才,“十四五”国家重点研发计划“先进计算与新兴软件”、“社会治理与智慧社会科技支撑”两个重点专项的指南专家、教育部人工智能科技创新专家组专家。中国计算机学会会士、理事,中国中文信息学会副理事长、社会媒体处理专委会(SMP)主任,黑龙江省中文信息处理重点实验室主任,黑龙江省“人工智能”头雁团队带头人。曾任国际顶级会议ACL、EMNLP领域主席。主要研究方向为人工智能、自然语言处理、社会计算和智慧医疗等,是国家重点研发项目“人机融合会诊”的首席科学家。主持研制“语言技术平台LTP”、“大词林”等科研成果被业界广泛使用。曾获国家科技进步二等奖、省科技进步一等奖、钱伟长中文信息处理科学技术一等奖等。

整理:路啸秋

NLP中的可解释性

可解释的人工智能(Explainable AI,XAI),是一种以人类可理解的方式解释人工智能系统输出结果的能力。可解释性的成功不仅取决于算法,同时还要借鉴哲学、认知心理学、人机交互等多学科的思想,令使用者及开发者更好地理解人工智能背后的决策和推理机制。

如今,大多数端到端的深度学习模型都是黑盒。开发者很难得知AI系统做出某个决策的依据,难以辨析影响方法成败的关键因素。因而,开发者难以进行针对性的调整,修改神经网络的架构,从而使决策过程更加准确。而可解释的AI可以在做出决策的同事给出相应的依据,明确AI方法的适用场景,使决策结果是可控可反馈的,增强用户对人工智能系统的信赖度。

深度学习已经取得了巨大成功,但深度学习的进一步应用遇到了伦理、用户信任以及纠错等方面的挑战,尽管黑盒系统因其优越的性能得到广泛应用,但也因为其决策难以被理解所以在应用中受到限制。

可解释性是衡量人工智能系统性能的重要指标。在司法、医疗、金融等重要领域中,不可知、不可控的人工智能技术会引发争议。可解释性的研究能够提升人工智能技术的可信度,实现更加可控的推理决策。

可解释AI在国际上受到了越来越大的关注,越来越多的国际相关组织机构将可解释性AI作为重要的技术发展战略。例如,美国DARPA在2017年开展了可解释人工智能计划,2019年谷歌发布了《可解释人工智能白皮书》等。在我国,《新一代人工智能发展规划》提到了可解释人工智能的研究。今年5月16号,国家自然科学基金委也提出了「可解释、通用的下一代人工智能方案」重