- 1【算法刷题】链表笔试题解析(1)

- 2python解决No module named ‘XXX‘问题_no module 'xformers'. proceeding without it.

- 3我的2022年终总结_csdn2022年终总结嘛在哪看

- 4Python 全栈系列229 构造镜像chatglm3

- 5GitHub上13个高赞Java项目推荐,会一个就能跟面试官谈笑风生_java比较好的项目

- 6『NLP学习笔记』工业级自然语言处理spaCy开源库的使用

- 7解决Error:Kotlin:Module was compiled with an incompatible version of Kotlin.The binary 。。。报错_error:kotlin: module was compiled with an incompat

- 8【Dolphinscheduler3.2.0+DATAX】同步数据(mysql,pgsql,oracle,sqlserver)到clickhouse_datax_launcher

- 9简历之编写_动宾+产出结构

- 102020年牛客网校招编程笔试题相关问题_牛客网 判题得分

Stable Diffusion AnimateDiff | 最火文本生成视频插件_animatediff模型下载

赞

踩

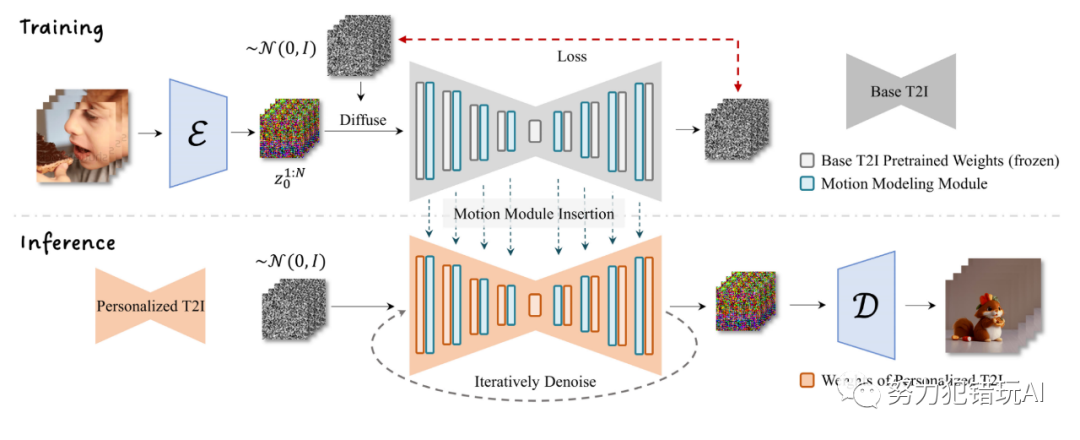

AnimateDiff介绍

AnimateDiff采用控制模块来影响Stable Diffusion模型,通过大量短视频剪辑的训练,它能够调整图像生成过程,生成一系列与训练视频剪辑相似的图像。简言之,AnimateDiff通过训练大量短视频来优化图像之间的过渡,确保视频帧的流畅性。

与传统的SD模型训练方式不同,AnimateDiff通过大量短视频的训练来提高图像之间的连续性,使得生成的每一张图像都能经过AnimateDiff微调,最终拼接成高质量短视频。

官方视频效果

安装

使用 AnimateDiff 需要安装 SD 插件和 AnimateDiff 模型。

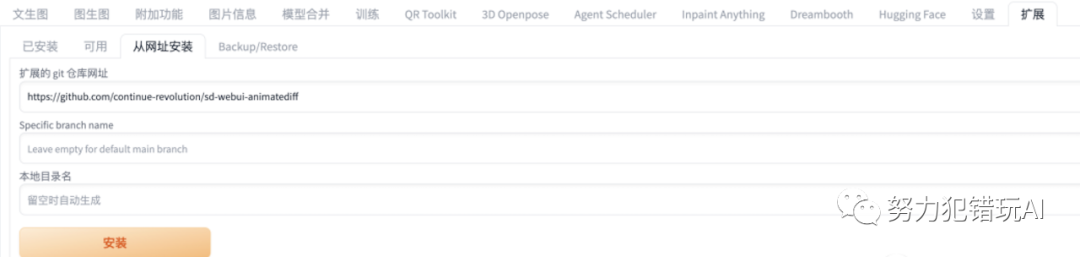

SD插件安装

如果能科学上网,可以直接在扩展->从网址安装中填入

https://github.com/continue-revolution/sd-webui-animatediff.git

如果没办法通过网站安装,见下文参考资料获取下载地址。

模型下载

安装好插件之后,将 AnimateDiff 模型下载放到 stable-diffusion-webui/extensions/sd-webui-animatediff/model/

下载链接:https://huggingface.co/guoyww/animatediff

如果无法下载,见下文参考资料获取下载地址,找到 mm_sd_v15_v2.ckpt 放到本地的目录中即可。

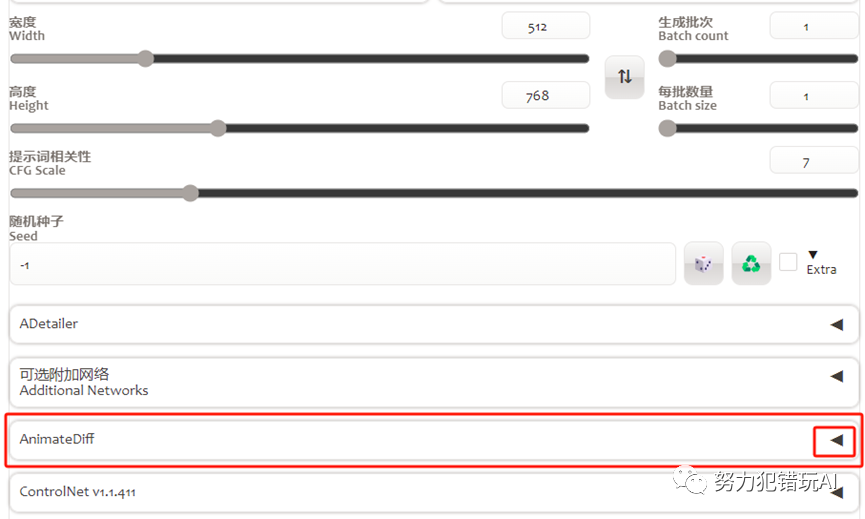

安装成功之后,重启 Stable Diffusion,在文生图页面可以看到 AnimateDiff 插件配置。

参考资料

github

https://github.com/guoyww/animatediff/

论文

https://arxiv.org/pdf/2307.04725.pdf

sdwebui官方

https://github.com/continue-revolution/sd-webui-animatediff

SD插件、模型国内下载

https://aifasthub.com/models/guoyww