热门标签

热门文章

- 1Python 约瑟夫生者死者小游戏_约瑟夫生死游戏流程图python

- 2使用Java+SSM(Spring+SpringMVC+Mybatis)开发个性化电影推荐系统 基于用户的协同过滤推荐算法 爬虫 可视化数据分析 人工智能 机器学习 在线电影、影视、视频推荐系统_机器学习算法个性化推荐 java

- 3Linux之bpfjit(2)使用分析和mini-tcpdump实现

- 4PostgreSQL 数据库日志与日常巡检_postgresql 巡检

- 5git——使用ssh连接远程仓库_git ssh

- 6Android apk安装包反编译——apktool工具_apktool反编译apk

- 7【AIGC调研系列】rerank3是什么

- 8蓝队--Linux基线安全检查_linux基线检查

- 9AI艺术的背后:详解文本生成图像模型【基于GAN】_基于gan的文本到图像生成模型的设计

- 10基于Flink CDC实时同步数据(MySQL到MySQL)_flinkcdc mysql同步

当前位置: article > 正文

qwen1.8B 通义千问大模型本地整合包 应该是全网唯一_阿里出品法律大模型本地整合包下载

作者:羊村懒王 | 2024-04-19 23:30:15

赞

踩

阿里出品法律大模型本地整合包下载

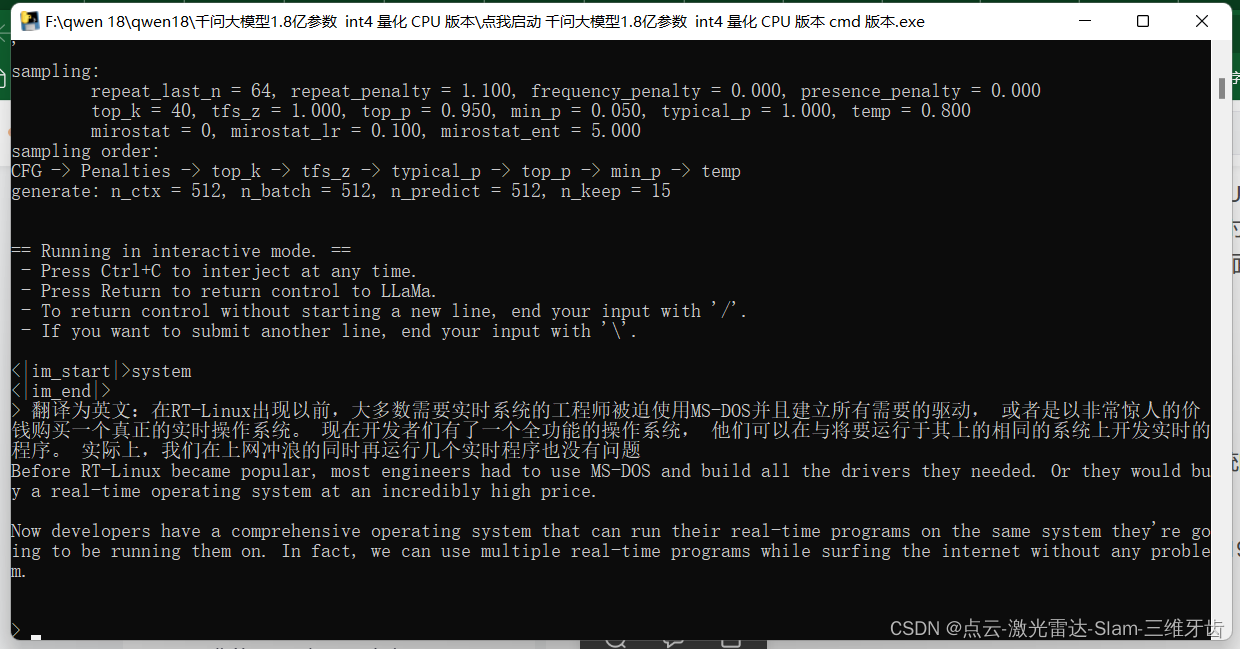

阿里在12月1日进一步开源了 Qwen 的系列LMM大模型。其中体积最小的为 Qwen1.8亿 参数的模型。算是中文领域3B以下最强的大模型之一了。 关键是,之前我6G显存的电脑跑很多大模型本地都跑不起来,甚至很多6B的模型都报错显存溢出,这应该是对没有显存或者显存小于8G的用户最友好的中文本地大模型了,所以我通过 llama.cpp 量化部署然后把模型打包成了一个可以本地离线单独使用的整合包,

量化后q5_k_m.gguf 模型大小为1.31GB,加载后基础内存占用也在1.3GB,在i5-12600K CPU上4线程可以达到14-15token/s,对终端设备非常友好。 我自己测试了一下它的对话能力,基本ok, 比起以往的小参数大模型效果好蛮多。

打开软件后会自动打开一个黑色的窗口,在最下方有一个箭头的地方可以输入和大模型的对话内容,然后输入回车 确认 就可以开始对话了,玩起来吧~

链接:https://pan.baidu.com/s/1WQQ8kaDilaagjoK5IrYZzA

提取码:1111

声明:本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:【wpsshop博客】

推荐阅读

相关标签