热门标签

热门文章

- 1flutter 拍照、选择相机image_picker_ios 使用 flutter camerawesom

- 2Microsoft Edge离线安装包下载_edge离线版下载

- 3ASP.NET 企业物流管理系统的设计与实现(论文+源码)_Nueve

- 4uView(Tabbar 底部导航栏)_uview 底部导航栏如何使用

- 5Dart 异步编程详解_dart语言 异步

- 6Spark SQL数据源-基本操作_sparksql操作

- 7Git clone远程分支_git clone 远程分支

- 8由于找不到iUtils.dll,无法继续执行代码。重新安装程序可能会解决此问题。_由于找不到iutils.dll重新安装程序可能会解决此问题

- 9探秘Web3科技:科技变革的下一个风口

- 10(附源码)计算机毕业设计ssm高校本科毕业及资料存档管理系统_资料存储管理系统的设计

当前位置: article > 正文

Firefly调参Baichuan13B_peft lora微调baichuan-13b

作者:羊村懒王 | 2024-05-14 08:02:41

赞

踩

peft lora微调baichuan-13b

Qlora微调

1.在/Firefly/train_args/qlora中修改baichuan-13b-sft-qlora.json

2.在/Firefly/script修改merge_lora.py

3.权重合并

如果使用LoRA或者QLoRA进行训练,本项目仅保存adapter的权重和配置文件,需要将adapter权重与base model进行合并。脚本见script/merge_lora.py,

在script文件下执行python merge_lora.py

4.指定卡训练(我用的单卡)

CUDA_VISIBLE_DEVICES=0 torchrun --nproc_per_node=1 train_qlora.py --train_args_file train_args/qlora/baichuan-13b-sft-qlora.json

5.在Firefly/script/chat执行py文件

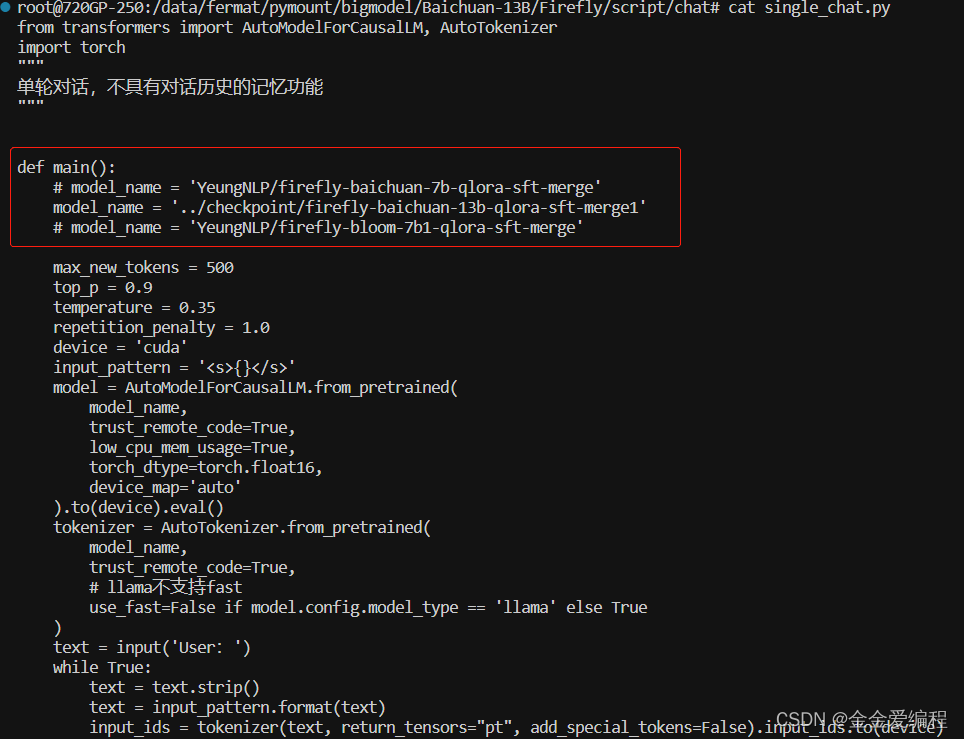

首先修改Firefly/script/chat/中的single_chat.py文件

运行single_chat.py文件

CUDA_VISIBLE_DEVICES=0 python single_chat.py

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/羊村懒王/article/detail/568055

推荐阅读

相关标签