- 1科普:你该认识的四种常见开源许可证

- 2windows下pygame的安装_collecting pygame

- 3C++程序员如何做好职业规划,我分享了10点看法_c++职业规划

- 4Mybatis中的SqlSession与mapper的动态代理的事务提交方式_mybatis mapper执行完立刻提交事务

- 5Linux下定位内存踩踏问题的一种方法

- 6Ubuntu服务器端口放行没有用_ubuntu端口开放后不通

- 7【node】nodejs原生搭建后端服务_nodejs写后端

- 8使用Matplotlib绘制各种炫酷的散点图_matplotlib 酷炫图

- 9在ubuntu上安装tar.gz包报错_[error] the distro "ubuntubak20230602.tar.gz" alre

- 10jaVa编译成js_Java中使用JavaScript脚本

谢赛宁紧急辟谣:Sora跟我一点关系没有,他们996搞一年了

赞

踩

梦晨 衡宇 发自 凹非寺

量子位 | 公众号 QbitAI

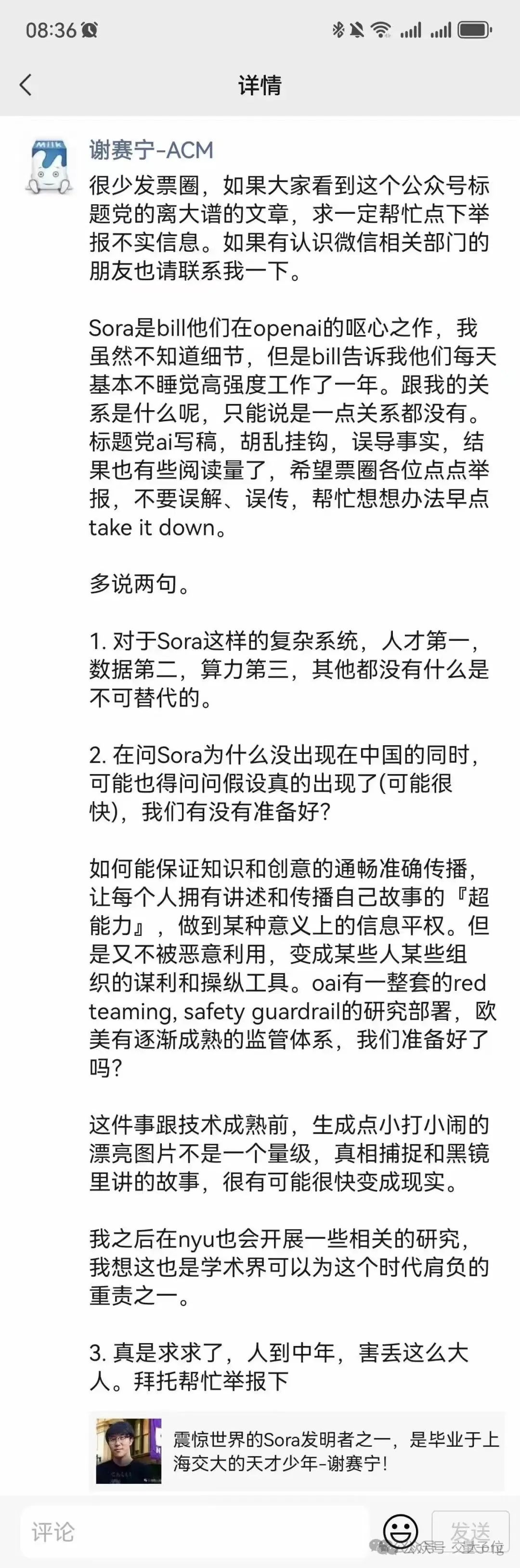

误会了误会了,被传为“Sora作者之一”的上交大校友谢赛宁,本人紧急辟谣。

他的声明发在其朋友圈,以及“交大校友荟”账号交大org上,主要说了几点:

Sora完全是OpenAI的工作,和谢赛宁本人一点关系没有。

但他后面将在纽约大学开展相关研究

要开发Sora这样的成果,人才第一, 数据第二,算力第三。

《黑镜》等科幻作品里的部分故事可能很快成为现实,需要准备好对应的监督体系。

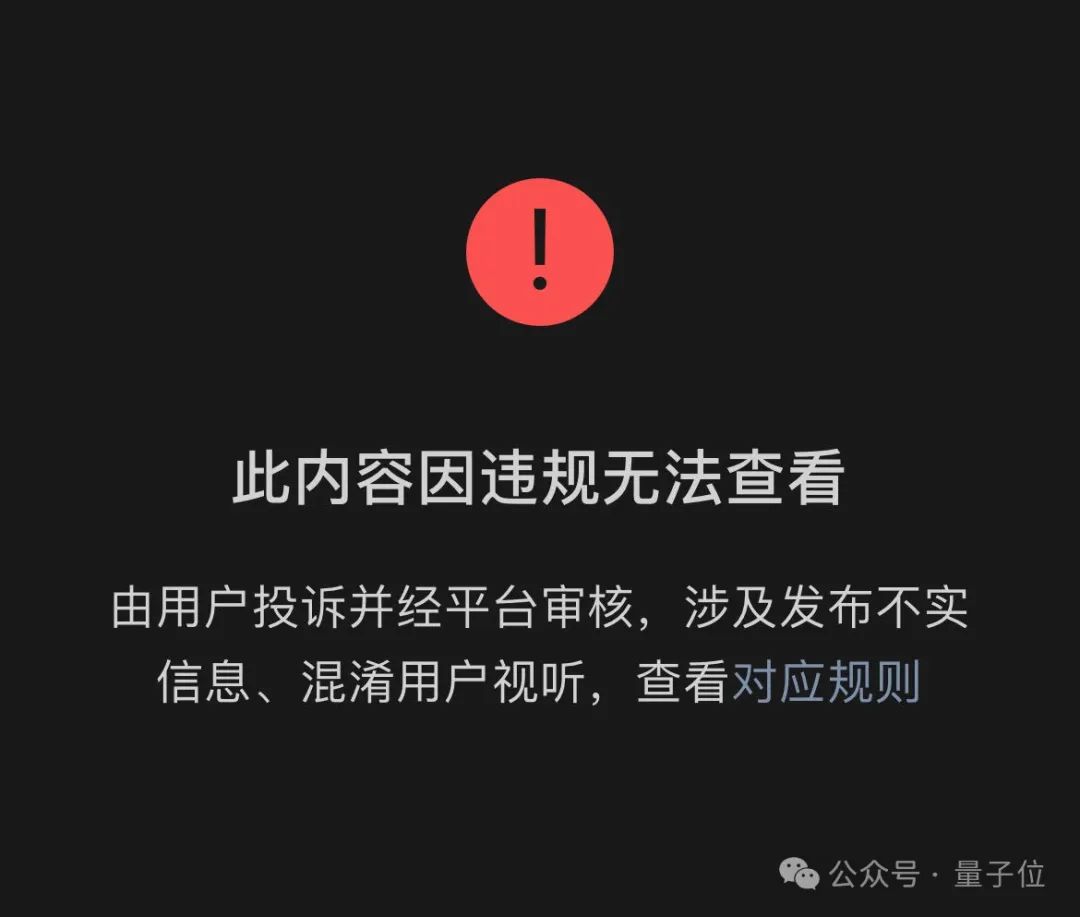

传播不实信息的原文章也在大家帮忙举报后被平台下架了。

这番误会终于算是告一段落。

不过谢赛宁透露的信息中还有一些细节值得关注,相熟的Sora开发领队Bill Peebles说团队基本不睡觉高强度工作了近一年。

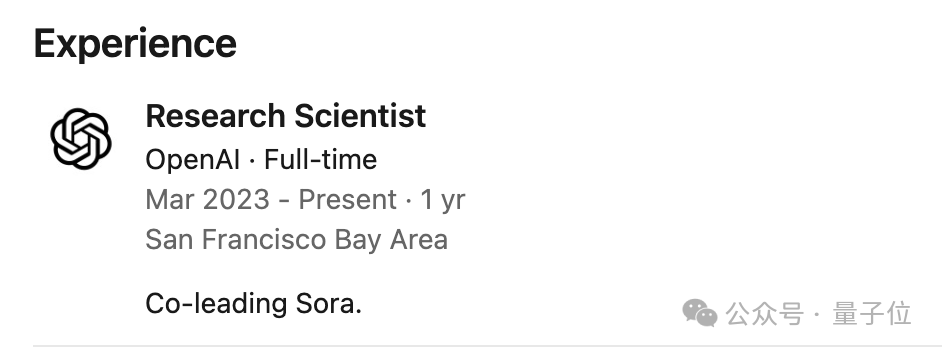

而Bill Peebles在2023年3月入职OpenAI,距今刚好不到一年。

也从侧面否定了之前传闻中的“Sora早就开发完成,只是一直没发”。

至于为什么会有这个离谱的误会,还要从谢赛宁与Peebles合作的一篇论文说起。

为什么会有这个误会?

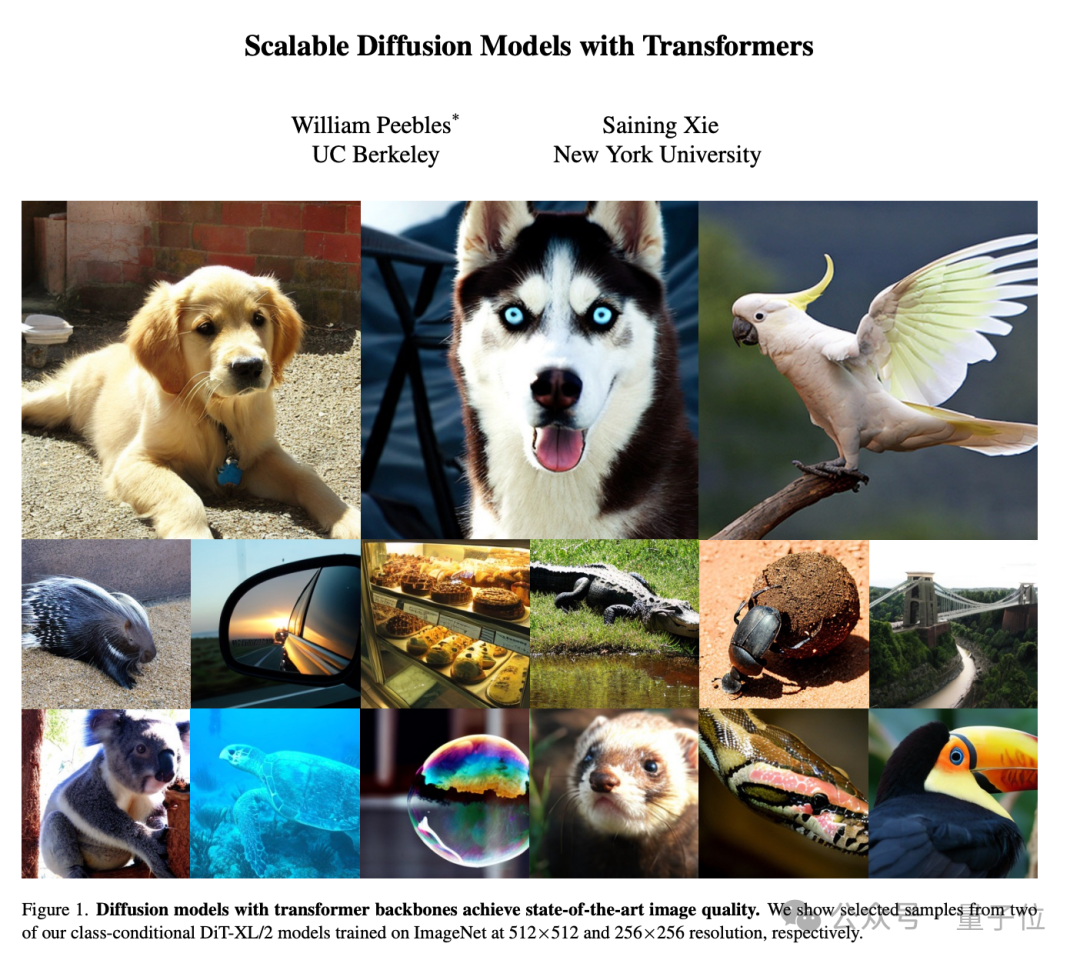

Sora技术报告引用的一项研究成果DiT模型,正是谢赛宁与Peebles合著。

那时Peebles博士在读期间到Meta实习,谢赛宁也还没完全离开FAIR。

DiT首次将Transformer与扩散模型结合到了一起,相关论文被ICCV 2023录用为Oral论文。

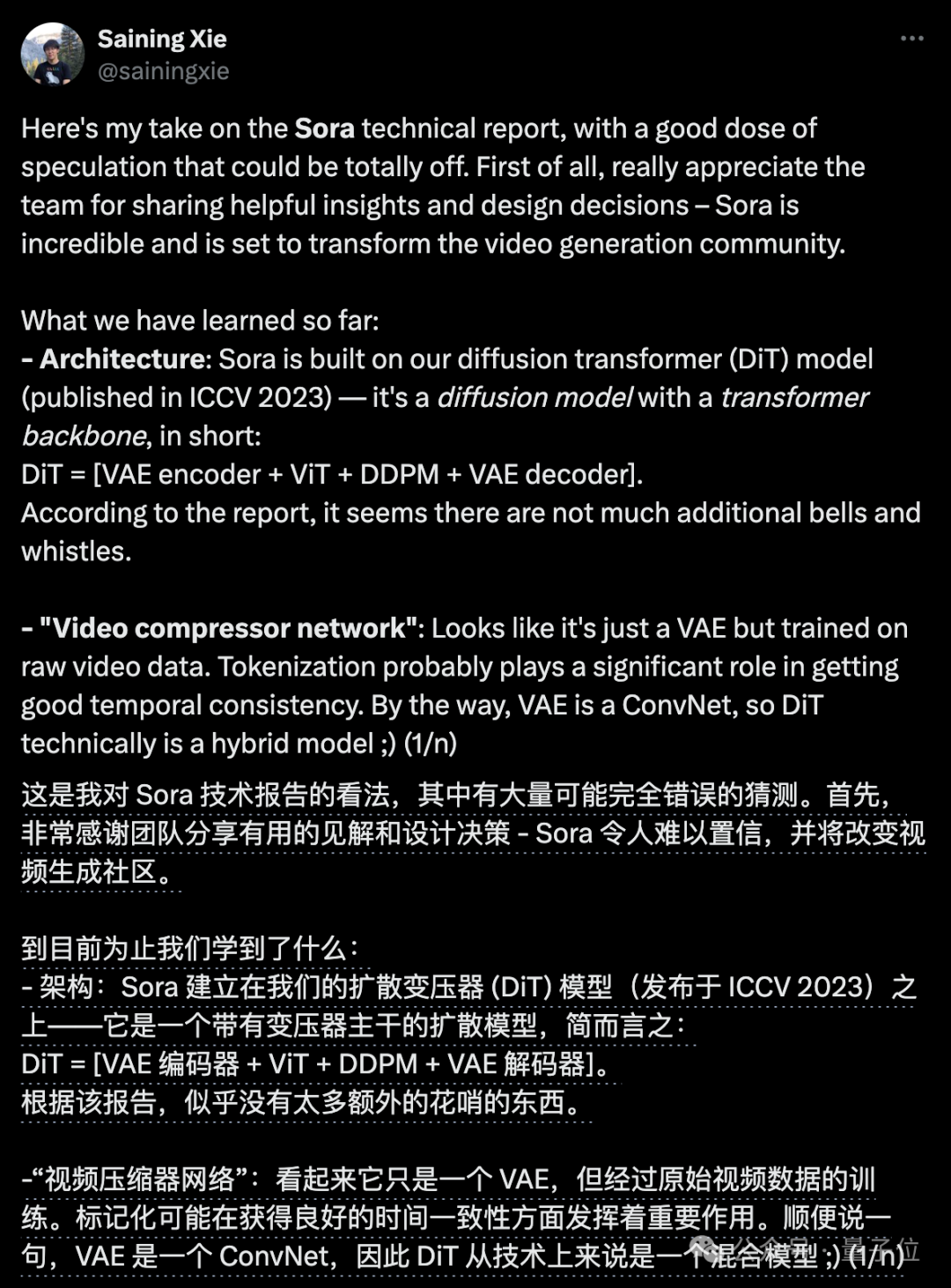

虽然Sora模型具体架构细节没有公布,但谢赛宁此前从Sora技术报告中分析出出,很可能就是建立在DiT的基础之上。

除此之外,Sora还参考借鉴了许多其他学术界成果。

如把训练数据编码成Patch的方法,引用了谷歌DeepMind的Patch n’ Pack等。

博采众长,同时坚定在Scaling Law指引下力大砖飞,才造了令人惊叹的Sora成果。

大神确实也是大神

排除掉这个误会,谢赛宁确实也是AI研究领域的一位大神,目前在纽约大学任助理教授。

他本科毕业于上海交通大学ACM班,18年博士毕业于加州大学圣迭戈分校。

毕业后谢赛宁加入Facebook AI Research(FAIR),曾与何恺明合作提出ResNeXt。

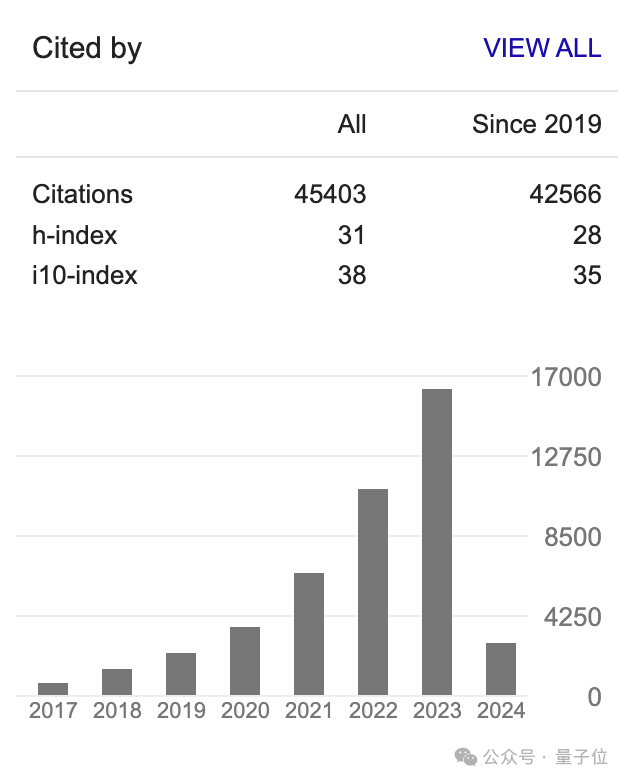

目前他在谷歌学术总被引用数达到4万5,h-index也高达31。

就在Sora发布不久前,他还领导纽约大学团队对DiT模型来了个大升级,新模型称为SiT。

SiT与DiT拥有相同的骨干网络,但质量、速度灵活性都更好。

谢赛宁认为,跟进Sora相关研究是学术界可以为这个时代肩负的重责之一。

让我们一起期待他的新成果吧。

参考链接:

[1]https://mp.weixin.qq.com/s/4ox9ITnd8TE2_Sior3eaEA

— 完 —

点这里

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。