- 1【ChatGPT】 Microsoft Edge 浏览器扩展使用 GPT_edge插件使用gpt

- 2本地运行Llama3极简中文傻瓜手把手教程,超越GPT4?能力如何?|文末赠2024AI工程师完整视频教程+源码资料_ollama3

- 3[AcWing]802. 区间和(C++实现)区间和模板题_c++区间怎么表示

- 4linux内核解析设备树节点_xilinx ethernet device tree

- 5基于Flask的上市公司数据分析与可视化系统设计与实现开题报告_完成本课题所需工作条件(如工具书、计算机、实验、调研等)及解决办法

- 6怎么在网上赚钱?7种方法总有一种适合你!

- 7机器学习 Christopher Bishop PRML_bishop 机器学习

- 8【Java】时间格式化注解_java 时间字段格式化注解

- 9python爬取人脸识别图片数据集_python 怎么把捕捉到的人脸数据放到数据库中

- 10Flink基础系列-DataSet广播变量_flink中广播流 建议缓存多少数据呀

006-WSL-Ubuntu中Ollama轻松下载并运行本地大模型-【AI超车B计划】_查看ollama 端口

赞

踩

一、目标

-

了解什么是Ollama,为什么要用Ollama;

-

学会如何使用Ollama下载并运行;

-

下载大模型,如LLama3、Qwen,并运行;

二、路径

-

学习笔记中关于Ollama的简介,了解什么是Ollama,为什么使用Ollama;

-

在Ubuntu中安装ollama并运行;

-

通过ollama下载LLaMA3、Gemma、Qwen大模型并运行;

三、笔记

1、安装Ollama

①什么是Ollama?

Ollama是一个开源的大型语言模型服务工具,它帮助用户快速在本地运行大模型,通过简单的安装指令,可以让用户执行一条命令就在本地运行开源大型语言模型,例如 Llama2。这个框架简化了在Docker容器内部署和管理LLM的过程,使得用户能够快速地在本地运行大型语言模型。

②Ollama官网:Ollama

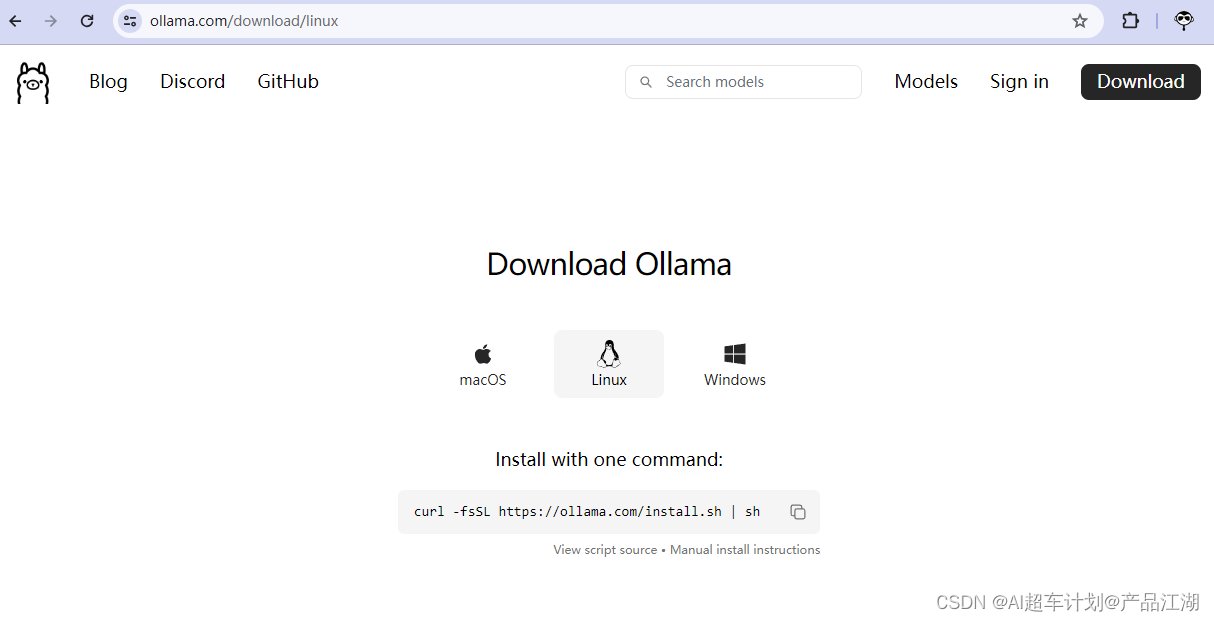

点击 Download 然后,点击 Linux,复制命令,粘贴进去Terminal:

点击 Download 然后,点击 Linux,复制命令,粘贴进去Terminal:

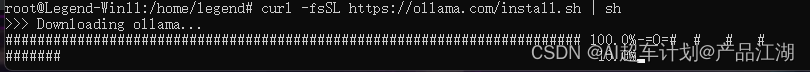

curl -fsSL https://ollama.com/install.sh | sh ③下载过程:

③下载过程:

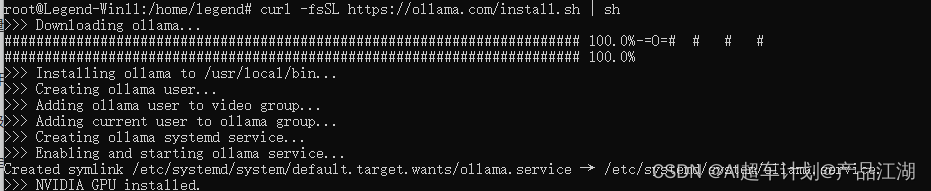

④下载完成,已自动安装好:

④下载完成,已自动安装好:

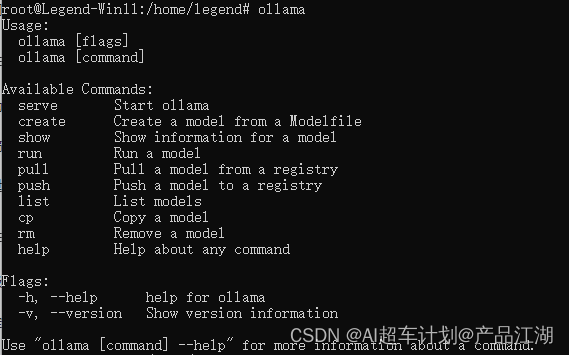

⑤验证ollama安装成功:

⑤验证ollama安装成功:

在Terminal中输入 ollama,如果出现如图输出即说明ollama已安装成功

ollama图中输出即是ollama常用命令:

2、下载、运行大模型在本地(以Qwen为例)

2、下载、运行大模型在本地(以Qwen为例)

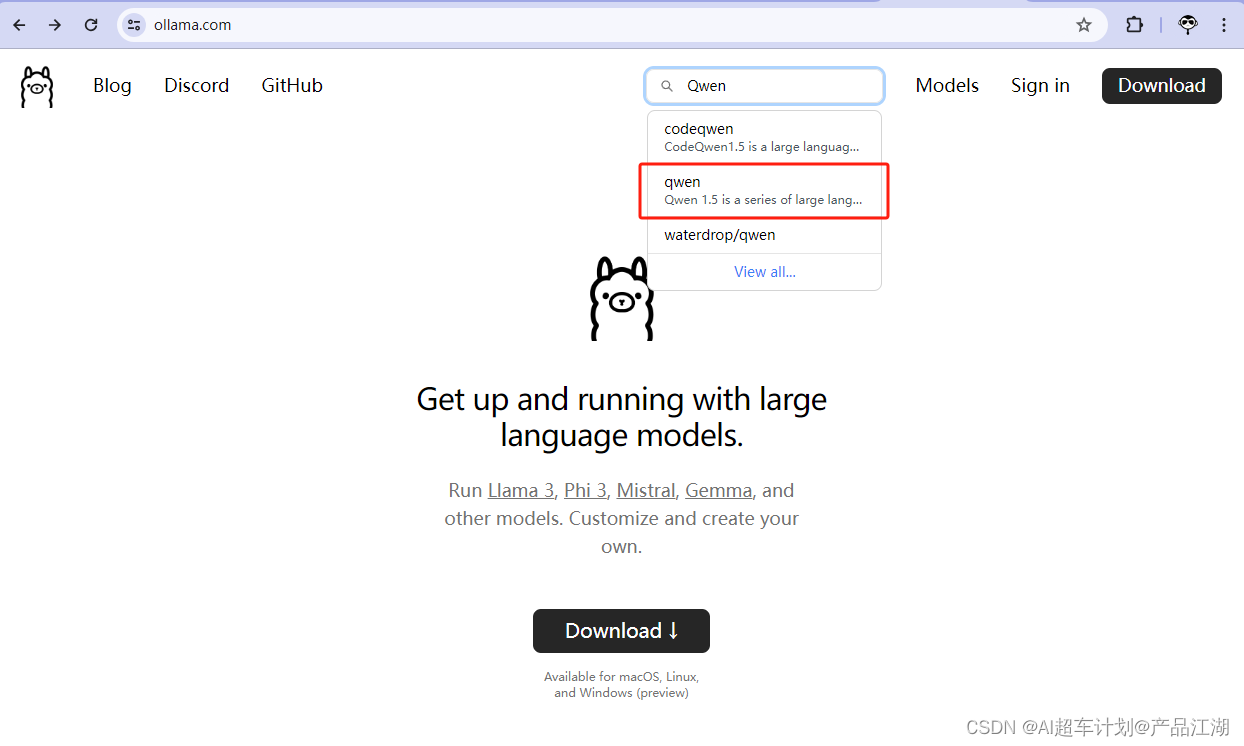

①搜索大模型名称

在搜索框中,搜索 Qwen,并点击图中红框内容

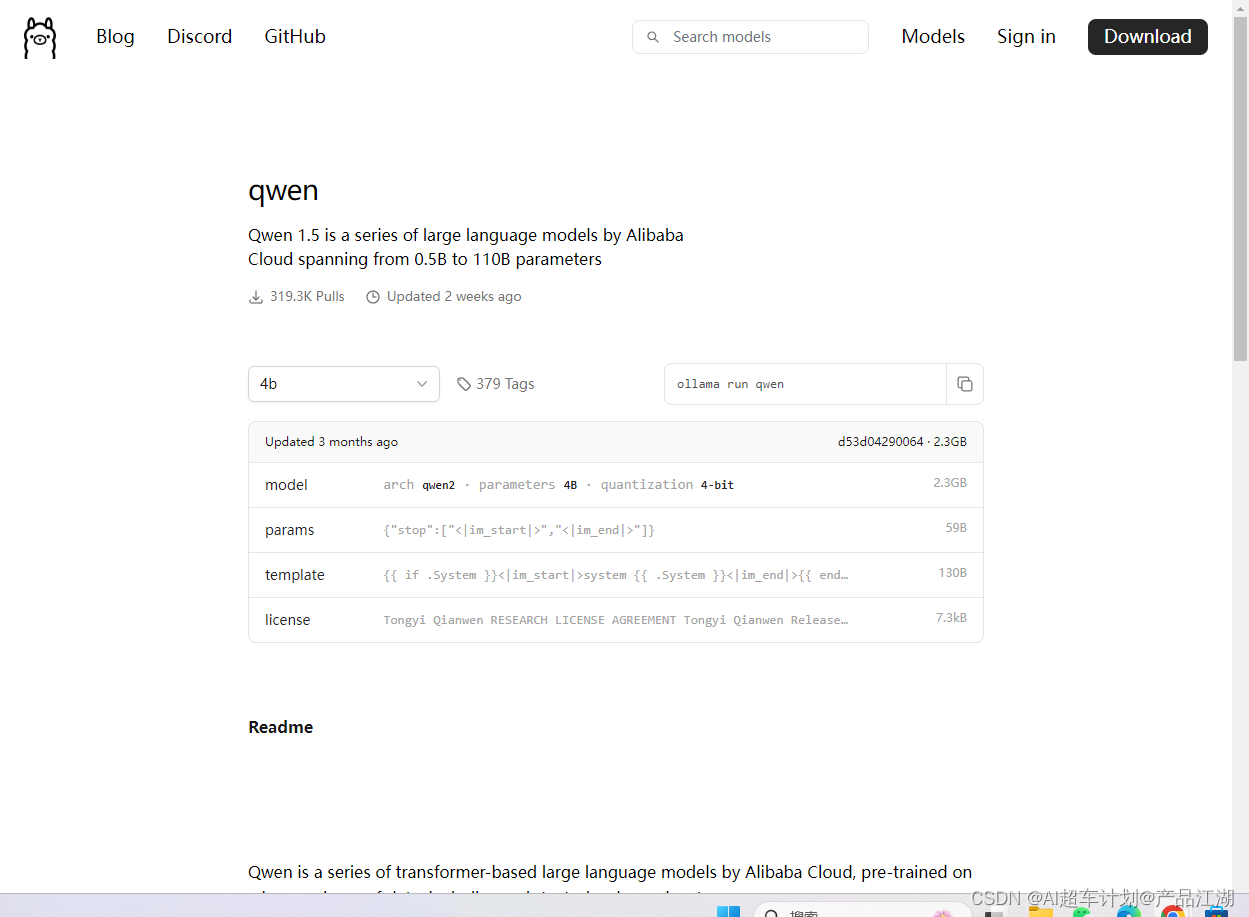

进入如图界面:

进入如图界面:

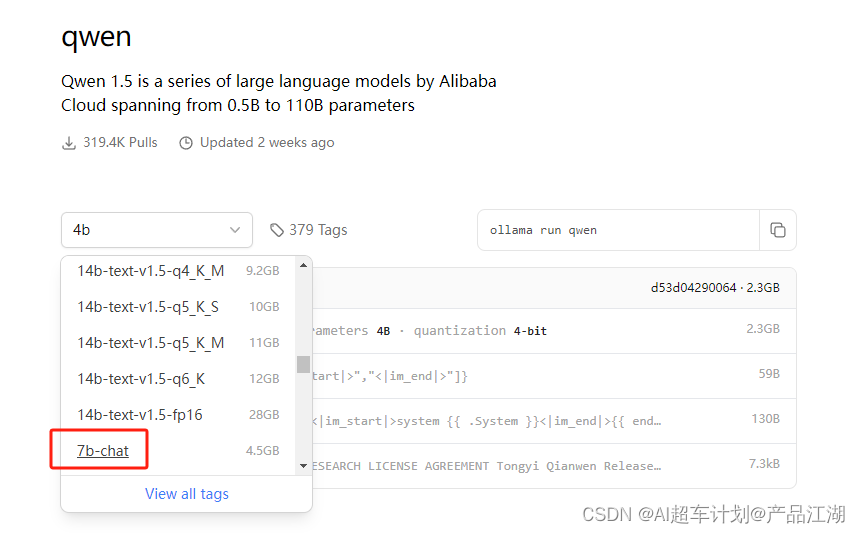

②根据需要选择参数:qwen:7b-chat

②根据需要选择参数:qwen:7b-chat

③选择7B-Chat并复制指令,粘贴进Terminal,回车:

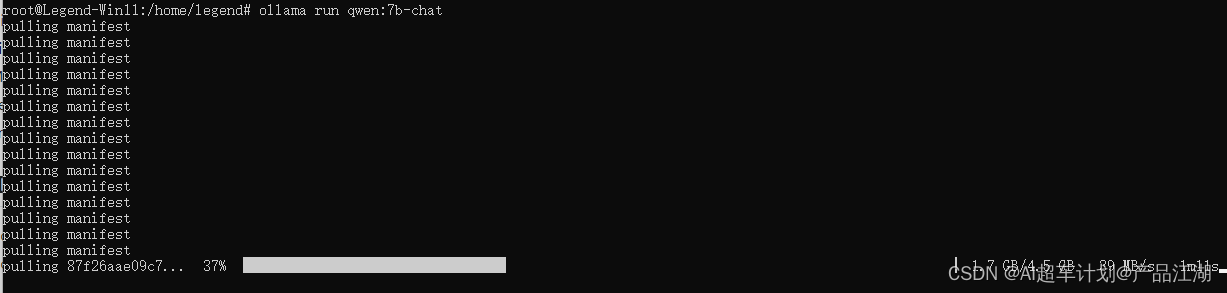

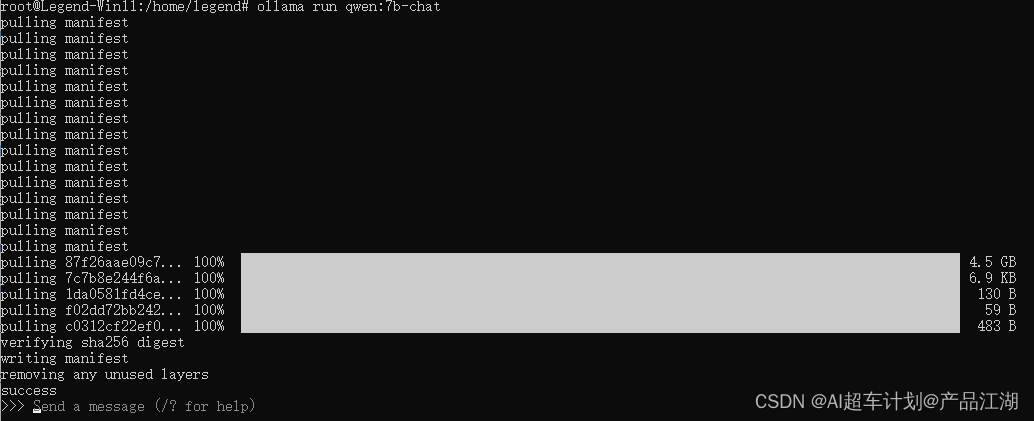

ollama run qwen:7b-chat开始下载,等待下载完成:

④下载完成后,可以直接与大模型进行对话:

④下载完成后,可以直接与大模型进行对话:

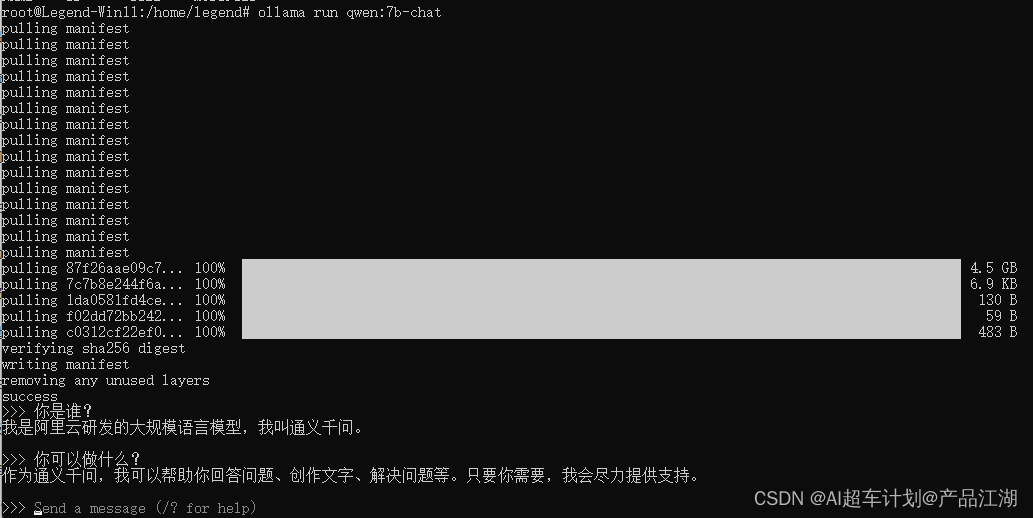

⑤对话验证:

⑤对话验证:

⑥退出对话模式:

⑥退出对话模式:

退出请按 ctrl + d

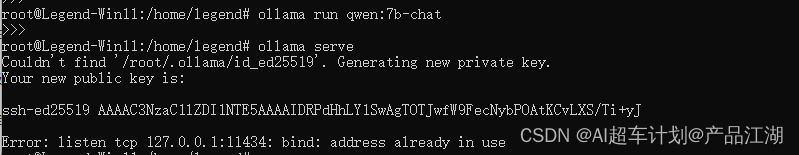

3、查看Ollama服务地址

Terminal中输入

ollama serve 出现图中输出,即说明ollama已经在运行中,且运行端口是 11434。

出现图中输出,即说明ollama已经在运行中,且运行端口是 11434。

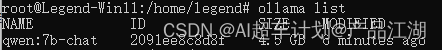

4、查看Ollama已下载好的模型

Terminal中输入

ollama list

注意:NAME字段是模型的名称;

什么是AI超车计划?

是“产品江湖”社区发起的AI学习计划,由沐逸@产品江湖(微信号:legend_pmdiss)老师主理,旨在帮助大家在AI时代找到自己的位置和价值。

计划包含:

A计划【不掉队】-- 快速了解各种AI应用的使用,如Kimi、各种GPT,让自己不掉队!

B计划【赶得上】-- 快速了解现有开源的AI开发工具,如dify、Coze,以了解如何迅速构建AI应用,让自己赶得上!

C计划【快超车】--通过低代码平台并借助AI辅助编程,从零到一打造大模型应用,让自己实现快速超车!

了解AI超车计划