- 1Element-UI可编辑表格的实现_el-table-column可编辑

- 2【Java集合类】HashMap(一)- 散列表基础知识_java散列函数

- 3openEuler 社区 2023 年 4 月运作报告_openeuler能适配中间件有哪些

- 4chatgpt赋能python:Python0–如何在SEO中获得更好的排名

- 5Linux排除某些文件,压缩所有文件【Linux、tar、exclude】_linux tar备份排除某类文件,某个文件夹

- 6【海贼王的数据航海】排序——概念|直接插入排序|希尔排序

- 7抓 https 报文新方案 -Magisk+LSPosed,来试试吧_trustmealeady模块

- 8NODE_npm设置国内源(淘宝镜像源)的几种方式,解决下载速度慢的问题_国内node元

- 9JVM实战:内存溢出的定位与分析_jvm内存溢出该如何定位解决

- 10微信小程序自动化测试——自定义测试(Minium)

论文目录3:大模型时代(2023+)

赞

踩

1 instruction tuning & in context learning

| 论文名称 | 来源 | 主要内容 |

| Finetuned Language Models Are Zero-Shot Learners | 2021 | 机器学习笔记:李宏毅ChatGPT Finetune VS Prompt_UQI-LIUWJ的博客-CSDN博客 早期做instruction tuning的work |

| MetaICL: Learning to Learn In Context | 2021 | 机器学习笔记:李宏毅ChatGPT Finetune VS Prompt_UQI-LIUWJ的博客-CSDN博客 in-context learning都是没有finetune过程,这里相当于finetune了一下 |

| Rethinking the Role of Demonstrations: What Makes In-Context Learning Work? | 2023 | 机器学习笔记:李宏毅ChatGPT Finetune VS Prompt_UQI-LIUWJ的博客-CSDN博客 在in-context learning的时候,故意给一些错误的例子、其他领域的返利,看看大模型的效果 ——>这篇论文的结论是,in-context learning只起到“唤醒”的作用,LLM本身就具备了所需要的功能。这里给LLM范例的作用只是提示LLM要做这个任务了 |

| Larger language models do in-context learning differently | 2023 | 机器学习笔记:李宏毅ChatGPT Finetune VS Prompt_UQI-LIUWJ的博客-CSDN博客 在更大的LLM中,in context learning 确实也起到了让模型学习的作用 |

2 Chain of Thought

| 论文名称 | 来源 | 主要内容 |

| Chain-of-Thought Prompting Elicits Reasoning in Large Language Models | 2022 |

|

| Large Language Models are Zero-Shot Reasoners | 2022 | 在进行CoT的时候,范例输完了,需要模型回答的问题说完了,加一行’Let's think step by step',可以获得更好的效果 |

3 others

| Is ChatGPT A Good Translator? A Preliminary Study | 2023 |

专项翻译任务上,ChatGPT不如一些专门做翻译的模型 |

| How Good Are GPT Models at Machine Translation? A Comprehensive Evaluation | 2023 |

专项翻译任务上,ChatGPT不如一些专门做翻译的模型 |

4 大模型+时间序列

| 论文名称 | 来源 | 主要内容 |

| 论文笔记: One Fits All:Power General Time Series Analysis by Pretrained LM_UQI-LIUWJ的博客-CSDN博客 | 2023 |

|

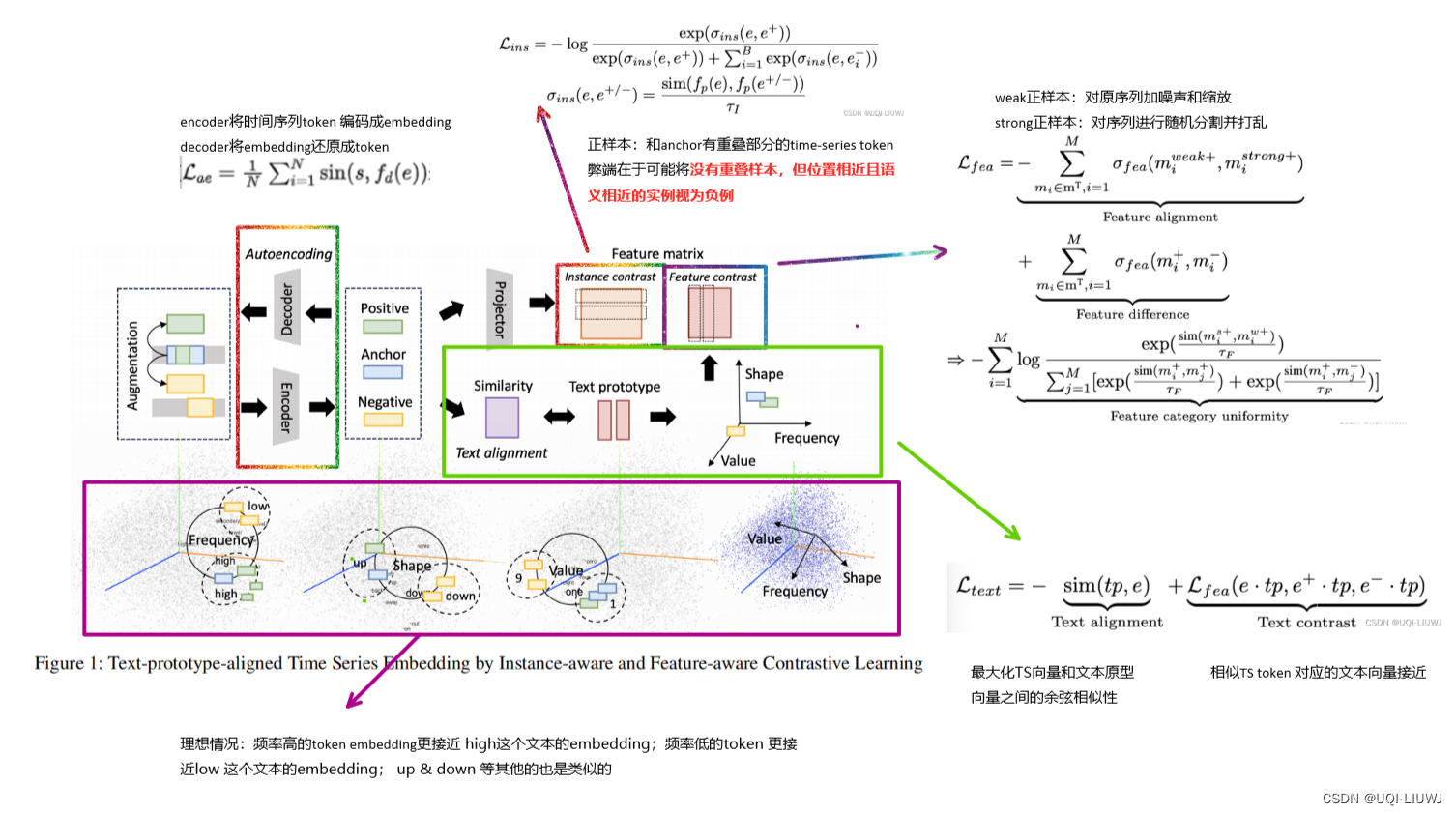

| 论文笔记:TEST: Text Prototype Aligned Embedding to ActivateLLM’s Ability for Time Series_UQI-LIUWJ的博客-CSDN博客 | 2023 |

对比学习学习时间序列token的embedding,然后将时间序列token的embedding和文本token的embedding进行对齐,并利用soft prompting进行后续大模型训练 |

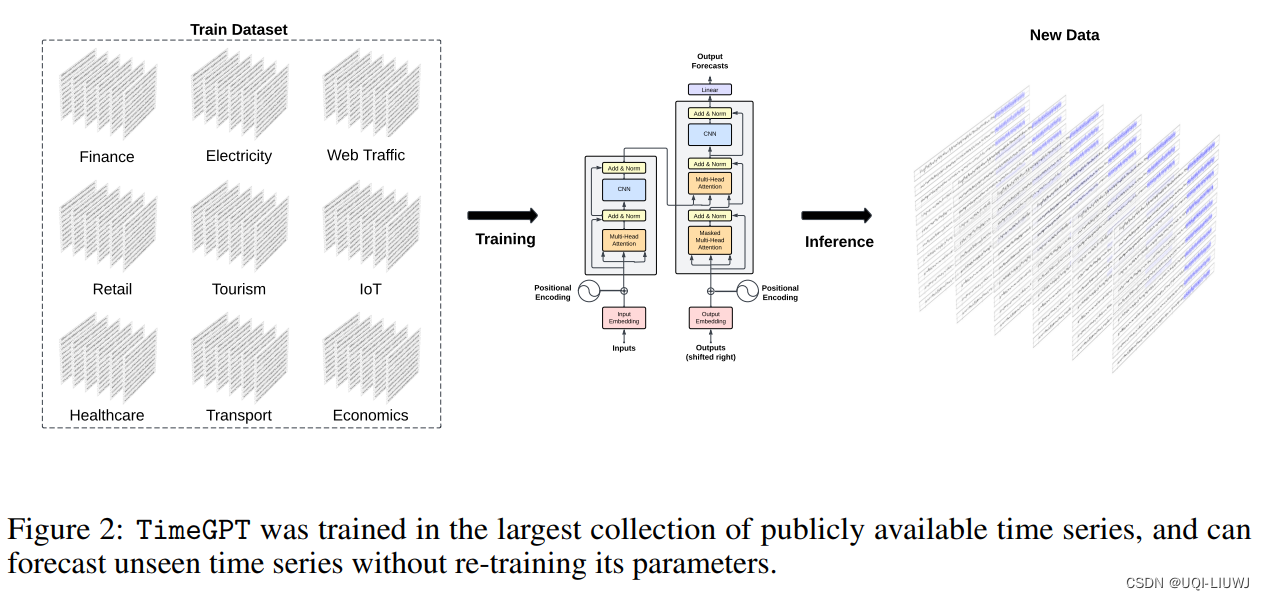

| 论文笔记:TimeGPT-1-CSDN博客 |

时间序列的第一个基础大模型 |

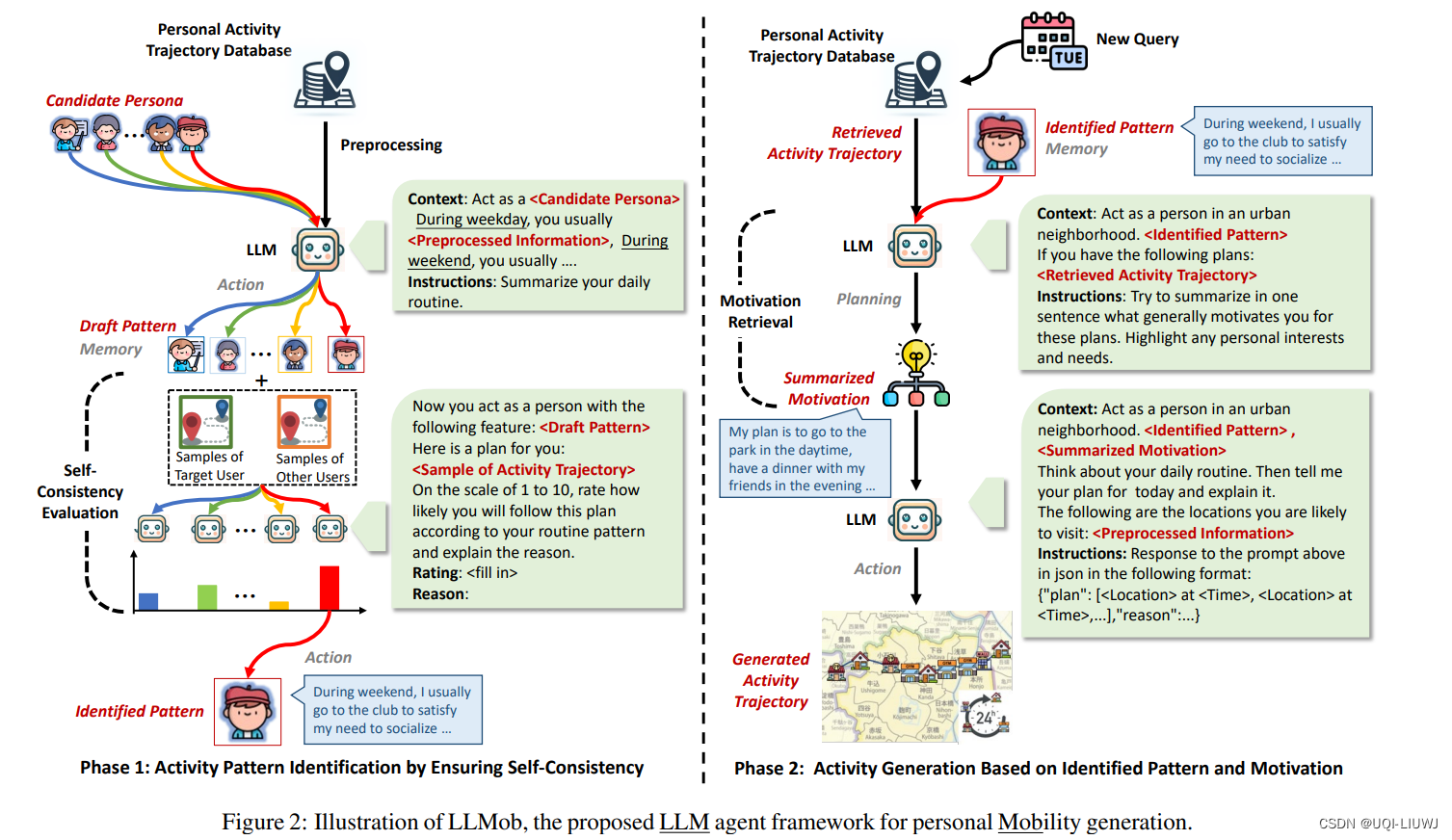

5 mobility+大模型

| 论文笔记:Large Language Models as Urban Residents:An LLM Agent Framework for Personal Mobility Generati-CSDN博客 | LLM+轨迹生成 li'yong 大模型(不train直接使用),得到用户在某一天的pattern(通用mobility)和motivation(短期的mobility),生成相应的轨迹 |