- 1C/C++中extern的作用_c++ extern有什么用

- 2Android科大讯飞TTS语音合成实例详细步骤_科大讯飞 tts文档

- 3OSG中几何体的绘制(二)_结果限定为构造几何结构对象,该对象可能将点与多个几何体共享。请检查结果。

- 4第二个鸿蒙入门应用页面跳转_鸿蒙3.0 应用跳转设置

- 5音视频--DTMF信号发送及检测_dtmf拨号判读 csdn

- 6vscode + vite + vue3 + typescript + eslint 项目配置_vscode 配置vue3和typescript环境

- 7Qt on Android:图文详解QT开发Andriod入门,Hello World全过程

- 8BigDecimal 的加减乘除运算以及除法保留两位小数_bigdecimal乘法

- 9Linux初级知识大全(一)

- 10SharedPreference使用的正确姿势_sharedpreference使用场景

昇思MindSpore技术公开课--GPT2学习心得_gpt学习心得

赞

踩

GPT2课程回顾

1. 学习总结

本节课主要围绕GPT-2展开,涵盖了以下主要概念和知识点:

-

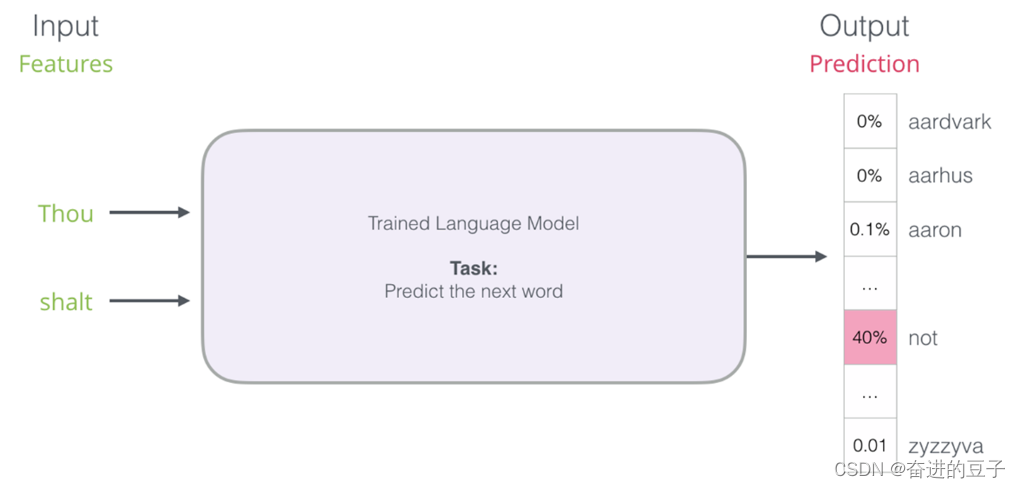

Language Model任务的再解读:课程重新强调了语言模型的任务,即预测下一个词汇或token。这一任务是自然语言处理中的基础,也是GPT-2的核心任务。

-

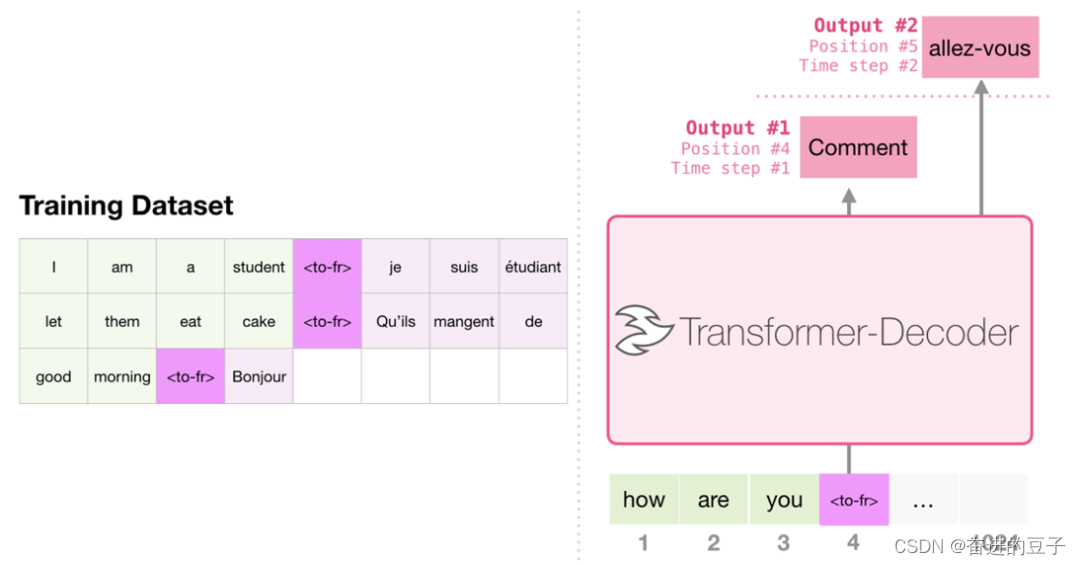

Task Conditioning:GPT-2的核心创新之一是Task Conditioning,它使得模型可以在预训练阶段针对不同任务进行预训练。这意味着我们可以通过提供任务指令来引导模型生成特定类型的文本,而无需进行有标注的微调。

-

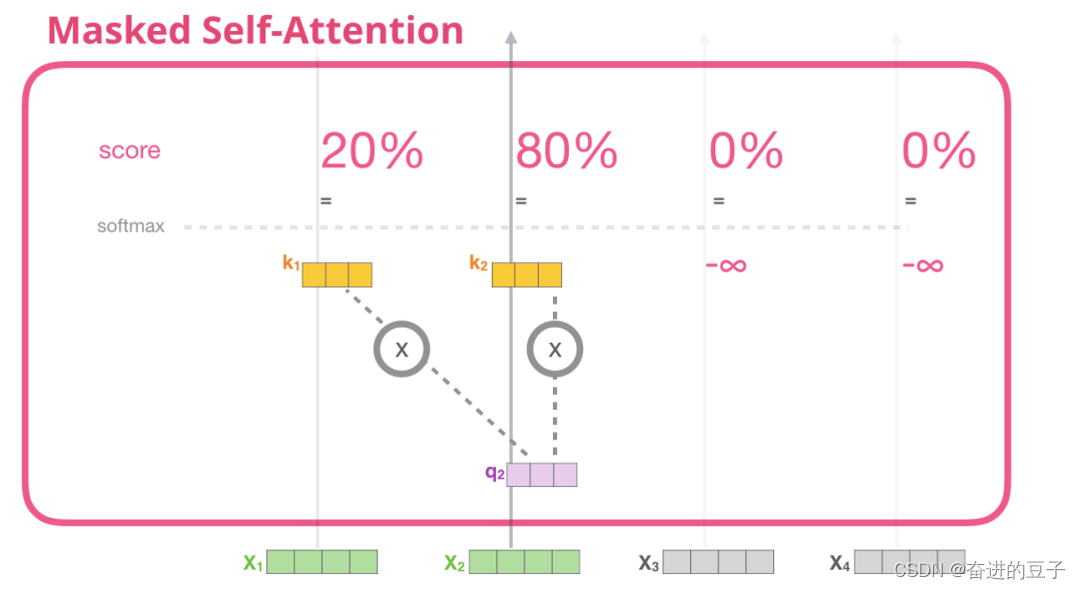

Masked Self-Attention的单步详解:课程详细解释了Transformer Decoder中的Masked Self-Attention,包括创建query、key、value,切分Attention heads,计算Attention Score,并使用Causal Mask来防止模型看到未来信息,然后合并Attention heads并进行一层Projection。

-

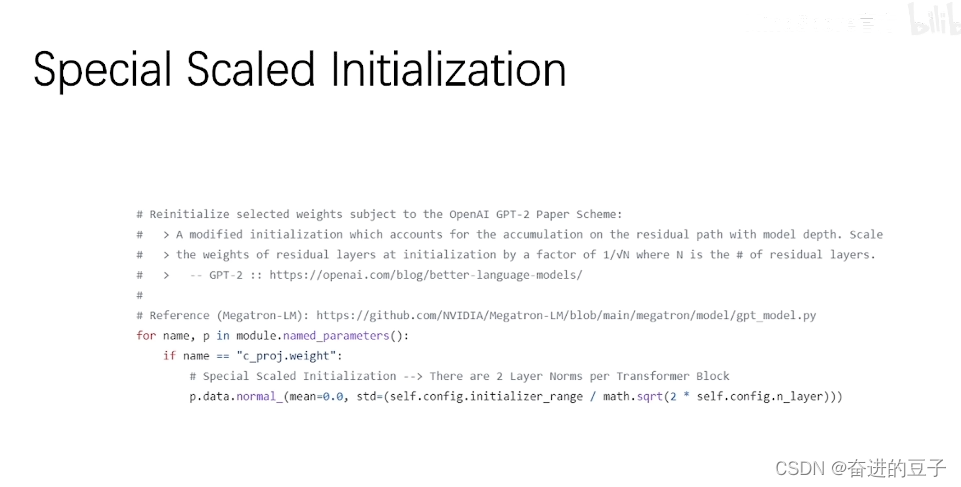

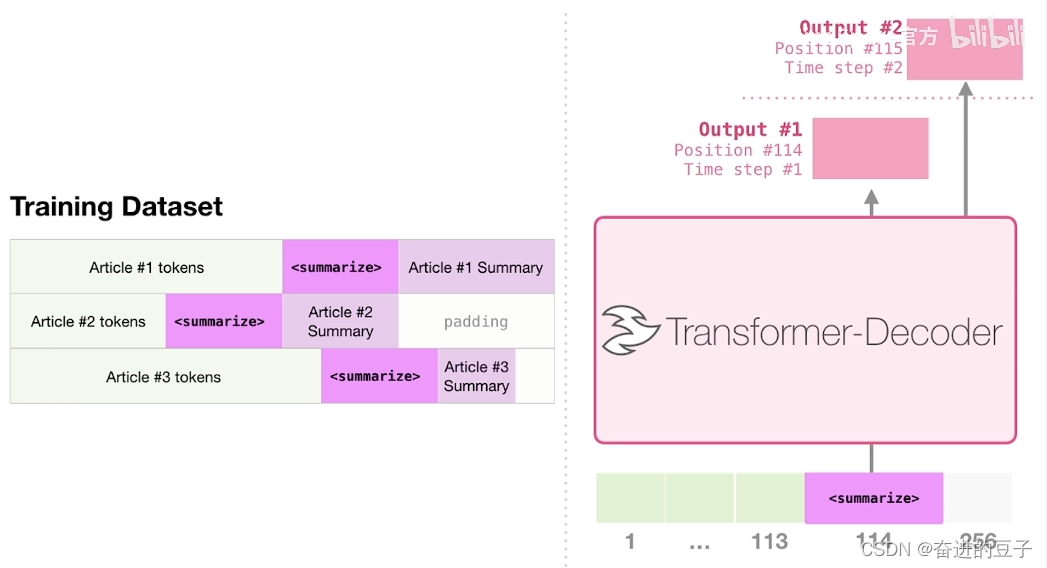

使用GPT-2训练文本摘要模型:课程实践部分展示了如何使用GPT-2来训练一个文本摘要模型,这是一个自回归预训练任务。其中包括文本长度处理、使用自动混合精度、处理输入和输出序列以进行文本生成预测。

2. 学习心得

通过这节课,我对GPT-2的核心概念和创新有了更深入的理解。最大的收获之一是了解到Task Conditioning的重要性,它使得GPT-2可以更加灵活地应用于不同任务,而无需进行繁重的微调工作。此外,对Masked Self-Attention的单步详解也帮助我理解了Transformer中的关键部分,并且对自回归文本生成任务的处理提供了实际的示例。

3. 经验分享

在学习和练习的过程中,我发现以下经验是值得分享的:

-

深入理解核心概念:在掌握具体细节之前,确保对核心概念有清晰的理解是关键。这有助于更好地理解模型的工作原理。

-

实际练习:课程提供了实际的练习,通过编写代码来应用所学知识。这对加深理解非常有帮助,建议充分利用。

-

任务导向:了解模型如何与任务相关,以及如何针对不同任务进行预训练,有助于更好地应用GPT-2。

4. 课程反馈

-

难度调整:课程整体难度适中,但可能需要更多的示例和实际操作来加深理解。

-

知识点扩展:可以考虑进一步扩展课程内容,包括更多的示例和应用场景。

-

练习环节:练习环节非常有用,但可以增加更多的挑战性练习,以适应不同水平的学生。

5. 未来展望

这节课学到的知识对我的学习、科研和实践活动都有很大的帮助。我期望能够进一步深入研究和应用GPT-2及其变种,探索更多的自然语言处理任务,并将其应用于实际项目中。我也对自然语言处理领域的发展和大模型的应用充满信心,认为它们将在未来产生更多令人振奋的成果。